�@�d�S�����Ȃ���̓���

�@�d�S�����Ȃ���̓����J�������C���f�b�N�X��

�O�̃y�[�W��

���W���Q����

�W���ɂȂ����̂ŐV�����y�[�W�ɂȂ����B

�ǂ���瑽���A�d�S�v�Z���ł����B

�����N���X�g������Ċ߃u���b�N���̏������f���������烁�����[�A���P�[�V�����G���[���p��������A���\���̌��_���������蓷�̑��������肷��̂Ŋp�x�̕������S���t�ɂȂ�����A�ł����[�Ǝv������e�r�̍Ō�̊߂̌v�Z�������ۂ蔲���Ă��܂��Ă�����Ƃ����~�X�������Ďv���̂ق���Ԃ��������Ă��܂����B

���̌X����ς��Ă����O�ɏK���ɂ��Ă��A���̏d�S�̍��ɉ����ĉ����g�������̂ł����邱�ƂȂ�������悤�ɂȂ����̂ł܂��A���܂������Ă�̂��낤�B

�ÓI�d�S�����v�Z���Ă��Ȃ��̂����A��͂胂�[�����g���v�Z�������������悤���B����̉ۑ�B

�����A�܂��㔼�g�Ɖ����g�̓���̘A�g�Ȃǂ������Ă��Ȃ��̂ŏd�S�v�Z�̔��f�ɂ��Ă͍l��������Ȃ��B���̂��߁A�̂��X�����肵�Ă��d�S�̂����⏞����͎̂��̃X�e�b�v�ɂȂ��Ă��܂��Ă���B�@���炩���ߌv�Z���āA�⏞�l������ł����Ȃ�����������̏d�S�v�Z�����������Ȃ��B���̂��߂ɂ͈�x�e�ߊp�x���v�Z���A�d�S�ʒu���v�Z���ĕ⏞�l�����߂�B���̕⏞�l���p���ɔ��f���Ċߊp�x�����߂�E�E�Ƃ����ӂ��ɂ��Ȃ���Ȃ�Ȃ��B�@�m�F�����5�炢�J��Ԃ��Ύ�������悤�����A�܂�2�����������������Ȃ����ȁ[�Ǝv���Ă�B

���W���S����

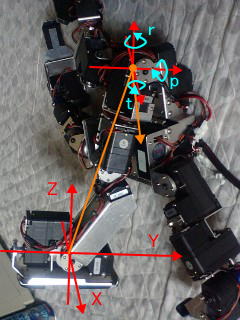

�d�S�v�Z���s�������ƂŁA�ȑO����C�ɂȂ��Ă������Ƃ��i�����̒��Łj�N���[�Y�A�b�v���Ă����B

����͊߂̃K�^���ł���B

�K�^���͋@�B����ł͂������ŁA���{�b�g�ɂ����Ă�����͓����悤�ɖ�肾�B�K�^���͐����́u�߂̍d���v�ɂȂ��Č����Ă���B�P���R�x�ɑ��ĂP�̃A�N�`���G�[�^�Ő��䂵�Ă���ꍇ�A�ǂꂾ���g���N�������Ă��K�^�����̓t���[�ł���A�g���N���������Ȃ����ƂɂȂ�B�i�K�^�������Z���X�ł����Ƃ��Ă�����ł��Ȃ��̂Ŕ��U���N����j��������������i�Ƃ��āA�߂��J�����̃A�N�`���G�[�^�ƕ��鑤�̃A�N�`���G�[�^��݂��A�o�����X�����Ȃ��琧�䂷��A�Ƃ������@���l������B�o���̃A�N�`���G�[�^���������荇���悤�ɂ���Ί߂́u�d���v�Ȃ�킯���B���ہA�l�ԂȂǂ̐����̊߂�2�ߓ�����U�̋ؓ��Ő��䂵�Ă���炵���A�����悤�ȓ�����������������ꂭ�炢�̐��̃A�N�`���G�[�^���g��Ȃ���Ȃ�Ȃ��炵���B�����܂ōs���Ȃ��Ă��A�Ҋ߂Ȃǂ̉d�̑傫�Ȋ߂�1���R�x������2�̃A�N�`���G�[�^�Ő��䂵�ăC���s�[�_���X�i�߂̍d���j�𐧌䂹�˂Ȃ�Ȃ��̂��낤�Ǝv������͂��Ă���B

���܁A���ɂ��Ă���̂͂����Ƃ����ƒ�x���ŁA�K�^���̂����Ŏw�������p���ɂȂ��Ă��Ȃ��Ƃ������Ƃ��B

�����Ă����ԂŊe�ߖ��Ɍ��Ă����Ɓi�G�Ȃ���Ԃ�����ł͂��邪�j�G�߂ɂ͏�ɉd���������Ă���B���̂��߁A�G�߂̎��p�x�͎w���p�x�Ƃ́u����v���������Ă��܂��B���̂���͓��̂̎p���p�x�ɉe�����A�w���ł͒������Ă���͂��̓��̂��A��̎����Łi�����x�Z���T�[�ŁA�����ǁj�T�x�X���Ă���B

����A�����Ƃ��ɂ́A������ƑO�̂߂�ɂȂ������������̂��ȂƑ̊��I�ɍl���Ă��āA�p���̎w���p�����[�^�ɂ��d�S�̃I�t�Z�b�g�ݒ肪�ł���悤�ɂ����肵�Ă���B�Ƃ��낪�A���{�b�g�̍\����ύX������ɓ����悤�ɕ������悤�Ƃ������A���̏d�S�I�t�Z�b�g�l�̒����ł͂ǂ��ɂ��������ł��Ȃ��̂��B�@������I�t�Z�b�g��傫�����A�O�̂߂�ȏd�S�ݒ�ɂ��Ă��A��������Ƌ����ɓ|��Ă��܂��B�ŁA�X�ɃI�t�Z�b�g�l��傫������ƁA�O�ɓ|��Ă��܂��A�����Ƃ��ł��Ȃ��Ȃ��Ă��܂��n�����B

�����ŁA���s���̊�{�p����ύX���A�������ނ������̐ݒ������ƃI�t�Z�b�g�l��傫�����Ȃ��ł����܂������悤�ɂȂ�B���ނ����������������Ă����ƁA���̂��Ƃ͂Ȃ��A���ۂ̎p���������Ȃ�����ƕ����炵���B

�v�͂������̂��߁A���ۂ̏d�S�ʒu�ƌv�Z��̏d�S�ʒu�ɂ��ꂪ�����Ă���A���ʂ̑傫�ȏ㔼�g�̌X���͒v���I�ȉe���������Ă���Ƃ������Ƃ炵���B�i�e���x�̌v�Z�܂ł͂��Ă��܂���B�j

RS601CR�͊ߊp�x�̎擾���ł���̂ŁA�v���O�����Ƃ��Ă͂��̂悤�Ȏd�g�݂���荞��ł͂���̂����A���Ԃ������邽�߁A����u�Ԃ̑S�T�[�{�̊p�x���擾���邱�Ƃ͂ł��Ȃ��̂��B���̂��߁A�����𐧌䂷�钆�Ŏ��ۂ̊p�x���t�B�[�h�o�b�N���邱�Ƃ͂ł��Ȃ��B�s�{�ӂȂ���d�S�v�Z�ɂ͎w���p�x���g���Ă���̂͂��������킯������̂��B�ł��A�����������ɂ��ă��{�b�g�������Ȃ����R�ɂ���킯�ɂ͍s���Ȃ��̂łȂɂ��l���Ȃ���Ȃ�Ȃ��B

���l���Ă���̂̓t�B�[�h�t�H���[�h�������A�����W���ēK�p�ł��Ȃ����ȁA�Ƃ������Ƃ��B�t�B�[�h�t�H���[�h�́A���̓��{�b�g����̑�����ʃ��C���[�ł���荞�܂Ȃ���Ȃ�Ȃ��l�����Ǝv���Ă��āA�w�K�f�[�^��\�����K�v�ƂȂ�B�����܂łł͂Ȃ��Ƃ��Î~���̎p������v�t�B�[�h�o�b�N�ʂ����肵�A����Ɏ�荞�ނƂ������Ƃ��炢�͂ł��Ȃ����Ȃƍl���Ă���B

�d�͂Ƃ����A�N�`���G�[�^�����_�ɑ��ē���������g���N�͌v�Z�ł���킯������A�K�^���ɂ�邸��ʂ����O�Ɍv�Z���邱�Ƃ��ł��邩���m��Ȃ��̂����A���[�[�[��B�B�B

�]�|����ɂ��Ă��A�d�S�v�Z�ɂ��Ă��A���Ă����ۂ��ł���Ă�Ƃ��ɂ��܂��s���Ă����Ƃ��A�����Ɍv�Z����Ƃ��܂��s���Ȃ��Ȃ�B�@�@�@�^�����B

�d�S�ʒu�́A�p���ւ̎�荞�݂̕��@�͂��ꂱ���t�B�[�h�t�H���[�h���Ȃ���Ύ����܂ł̎��ԁi�v�Z�ʂ��A�j���������Ă��܂��B�����A���s����Ȃǂ̓R�}���萧��Ȃ̂Ō��p������ڕW�p���܂ł̏d�S�̈ړ��ʂ͏������B���̂��߁A���ɂ��Ă��鍷���͔������ɂ����킯���B

���ɂȂ�̂͌��ݎp�����͂����肵�Ȃ��Ƃ��ɍs����Ύp���ւ̈ڍs�B�@�T�[�{�̋@�\���g���Ďw�莞�ԂŎw��p�x�ɂȂ�悤�Ɏw���𑗂邽�߁A�P���߂ŖړI�̎p���ɂȂ�B���̂��ߎp���ڍs�ʂ��傫���A�d�S�ʒu�̌덷���傫���B

�܂�A�Ώ����ׂ��͐�Ύp���ւ̈ڍs�̂݁A�ƍl���Ă���B������̕����R�}���萧��ɂ���Ύ�����̖��͂Ȃ��Ȃ邩�ȁA�ƁB

���W���T����

���낢��蔲�������A�d�S������Ȃ���̎p���ύX�i�P���ڍs�j���ł����B

�������ȒP�ɍl���Ă����̂����A�T�[�{�Ƀg���N����ꂽ���̕s���Ԃł͎p���p�����[�^���x�[�X�ɂ����ڍs���ł��Ȃ��̂ōl��������Ɋp�x�x�[�X�ňڍs����悤�ɂ��Ă��܂����B���ꂶ��d�S����ł��Ȃ����ċC�Â����̂͂����Ԃ�Ƃ��ƁB�B�Borz

���̂����A���x���̃T�[�{�t�@�[���̕ύX�ŁA�T�[�{�̃g���N����ꂽ�Ƃ��ɂ͖ڕW�p�x�����݊p�x�ɂȂ�悤�ɂȂ��Ă����̂�F�����Ă��Ȃ������B�@�m���A�ȑO�͌��݊p�x���擾���āA�w���p�x�Ƃ��ė^�����̂��Ƀg���N�����Ȃ��ƃT�[�{���т����蓮�삵�Ă��܂��Ă����͂��B�@�v���ʂ�ɓ����Ȃ��̂ł��̂�����̃\�[�X�߂Ă�����p�x���擾������ݒ肵���肷��L�q���܂������Ȃ��Ȃ��Ă����B���[��A�s�v�c���B�B

���ǁA���݂̖{���̎p���ƃf�[�^��̎p������v���Ă��邩�ǂ������s���ȏꍇ�͍��܂Œʂ�̃T�[�{�R�}���h�ňړ��B���̌�A�o���̃f�[�^����v���Ă��邱�Ƃ��m���ȏ�Ԃł͏d�S���܂荞�݂A�R�}����Ŏp�����ڍs����悤�ɂ����B�p���̈ڍs���e�p�����[�^����`�ڍs����悤�ɂ����̂ŁA�X�N���b�g�Ȃǂ��Y��ɓ����悤�ɂȂ����͂��B

���̓���͏㔼�g�̋p��-45�x����+45�x�܂ŕύX���Ă��邾���Ȃ̂����A����ɂ��d�S�̕ω���܂荞�݂��삵�Ă���̂ł��̑��̃p�����[�^�����Ȃ��ł����v���Ęb�ł��B���[�����g�܂ł͌v�Z���Ă��Ȃ��̂ő��x�������Ȃ�Ɣ����ł�����낤�ȁB

�l�Ԃł��A�Ǎۂɗ��Ƃ����V���ł��Ȃ��Ȃ�B�i���K���˂��o�ĕǂɂԂ���A�O�ɂ�̂߂��Ă��܂��j�@������Ƃ����l�Ԃɋ߂Â��������B�i*^_^*�j

����͂����Ƃ��āA���̊p�x�̌X���̌����ǂ̂悤�ɏ������邩�����ʂ̖��B

�߂̃K�^���̓T�[�{�̌��݊p�x���擾����ΔF���ł���̂��H�W���C���Ƃ̍��́H�@�Ƃ����_���m���߂邽�߂Ƀf�[�^�̎���B

�ڂŌ������A�w���p�x�������Ȏ��̓��̎p���͉����x�Z���T�[�̒l�ƈ�v���Ă���悤�Ɍ�����B�@�����O��Ƃ���A�w���p�x�Ɋւ�炸�A�K�^���ɂ��덷�͂T�x���x�B�ߊp�x��ǂݎ���Ă����̂̐^�̊p�x�ւ͍s�������Ȃ��炵���B�K�^���̓|�e���V�����[�^�̊O�����Ď����B�B�B

�]�|����Ɏg�p����p���͋p�ɂT�x�𑫂��āA�l���������悳�������B

�]�|����̌v�Z���ɋp��5�x�����Ă݂����ǂ��܂�ω��Ȃ��B�ӂނ��`�A����Ϗd�S�v�Z�̎���5�x����Ȃ��Ⴈ��������ȁB�A�z�ł����B�i���ŁA����͂���ĂȂ��j

�����͂�����Ə㔼�g�ɂ�����o�����B

�r��PS2�R���g���[���̃A�i���O�W���C�X�e�B�b�N�ŃR���g���[���ł���悤�ɂ�����y�������ȁA�Ǝv���Ă��傢�Ƃ���Ă݂��B�@���ǁA����ȁB�}�X�^�[�X���[�u�R���g���[���ł����Ȃ��Ƃ��܂��������Ȃ��B�P���ƃ\�t�g�̉��ǂłȂ�Ƃ��Ȃ邩�ȁ[�H�H�@�܁A�����R���̓e�X�g�p�Ȃ̂ŋÂ�C�͂��炳��Ȃ��̂ŏI���B

���Ă������A�r�������牺���g�̃o�����X�������I�Ɏ��悤�ɂ��Ă�납�Ǝv�������ǁA��������Ƃ��傿�傢�Ƒg�v���O�������ᖳ�����Ă��ƂɌ�ŋC���t�����B������瓯�����Ƃ��J��Ԃ��Ă銴���B�B�@�܂����̂����ɁA�A�Ƃ������ƂŁB

������r�����Ă�����A���Ȃ�������l���Ă���A�����オ��Ȃǂ̓�������[�V�������g�킸�ɂǂ�����đg�ݍ��ނ��Ƃ������ƂłS�����s���痧�ʂֈڍs����Ƃ�����𑁂���肽���Ȃ��Ă����B�w������ɂ������ʂ̂S�����s�Ƃ�������ɂ����S�����s�����Ȃ��ƂȂ��̂��ȁ[�Ƃ��B�����g�̎p���\���͂��ׂč��̉����g�p���ł�������Ȃ����ȂƂ��v���Ă����B�@���̂̎p�������āA���ۂ͍����Ă�Ƃ��Q�Ă���Ƃ��A�����Ƃ��f����������ȂƁB�@

�܁A����Ȃ���Ȃłӂ�ӂ�Ƃ��Ȃ���Ȃ̂����ǁA���T�͂Ȃ�Ƃ��Ă��摜�ɒ��肵���������̂ŁA���̗U�f�𑁁X�ɒf�����ĉ摜�ɒ���B

�Ȃ�Ƃ��A�L���v�`���[�`�b�v���o���Ă���YUV422�t�H�[�}�b�g�𗝉������Ƃ��܂ł͂ł����B����CDT�N���X�̐��������Ȃ��ƂˁB�ǂ�Ȃ�������������Y�ꂿ������Ȃ��B

�����Ȃ����܂ł̓��C�u��������RGB�ɕϊ����Ă���PC�ɑ����Ă����̂����A�����RPU-100�Ŏ�����RBG�ɕϊ��������́BCDT��YUV�f�[�^�����̂܂g���܂��B

���ł��A����͂��̊Ԉ�������4����1�̃f�[�^�ɂ����^�C�v�Ńv���O������i�߂邱�Ƃɂ��܂��B���ꂭ�炢��f�������������Ȃ����ȁ[�ƁA�ڂ�����������N���b�v����Ώ�̉摜�܂ł͊g��i�H�j�ł���B

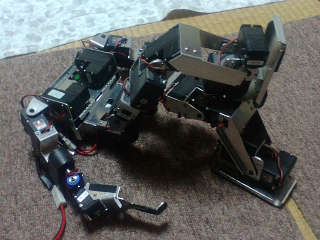

�摜�Ɏʂ��Ă���A�C�{�͔��N�Ɉ�x�̃o�b�e���[�[�d�ՁB�@���[�d�ŕۊǂ��Ă��������Ƃ̂��Ɓi�\�j�[���j�Ȃ̂ŁA�o�b�e���[�̉����̂��߂ɂ��܂ɏo���Ă���B

�A�C�{�̎����v���O��������肽���̂����A�����_�ƃA�C�{�������Ă̂͂������Ɏ��ԓI�ɖ����B�@�A�C�{�̓o�b�e���[�ЂƂ�1���Ԃ��炢��������{�C�ʼnƂ̒��Ő�����������B�S��������R�P�����Ƃ��قƂ�ǂȂ����A�Z���T�[���܂��\�������B�z���g�ɂ��炵�����i�������B�@�����A�\�t�g�͖l�ɂƂ��Ă͑S�R�_���Ń\�j�[���̃v���O�����œ����������Ƃ͂قƂ�ǂȂ������B�܂�A���{�b�g�Ƃ����@�B�i�f�ށH�j�Ƃ��ėD��Ă���Ƃ������ƁB�A�C�{�ɔ�ׂ�ƍ��̃��{�b�g���i�͂ǂ��������K���N�^���������Ⴉ���Ċ����B�O���Ă�Ȃ����Ďv�����ǁA���͖l���O��Ă邾���Ȃ̂����B(~o~)�@�@����ERS-7�͊����x���������Ă��ꂪ���̐���������Ă����Ȃ�ă\�j�[�͂܂��������������Ȃ����Ƃ�����Ǝv���B�@�ׂ���Ȃ����瑱���������ƓI�ɂׂ͖���Ȃ����Ă��ƂȂ낤���ǂ��B

���W���U����

CDT�̌��^���쐬�B

�z���g�Ɍ��^�Ȃ̂ł܂�1�`�����l�����������ĂȂ����ACDT�G�f�B�^���Ȃ����猟�o�F�����͒��}�j���A���B�e�[�u�������̔ώG��������܂�Ȃ̂ŁACDT�{�̂̃v���O��������ɃG�f�B�^�����Ȃ���Ȃ�Ȃ����Đ����ł��B

���̉摜��CDT�ŏ�������ƁA

����Ȋ����ŁA�s���N�{�[��������������悤�ɂȂ�B�e�[�u���������ł��Ă��Ȃ��̂ł��܂����ł����A�܂��A���삪����Ȃ��Ƃ��炢�͂킩��B

����CDT���Ďd�g�݂͎����E����قƂ�ǖ��ɗ����Ȃ��Ǝv���̂����ǁA���{�J�b�v�̃T�b�J�[�R�[�g�͐F�ŃR�[�g��{�[����F�������Ă���̂ő�ϗL���B�@�Ƃ������CDT��O��ɂ��Ă����Ȃ����Ǝv����BYUV�f�[�^��͈͂Ő蕪���邾�������A�摜�f�[�^���g���P�v���[����8�F�̃f�[�^�܂ŕێ��ł���B���{�J�b�v�ɂ͂���ŏ\�����Ǝv���܂��B���͋K��ł̓��{�b�g�̐F�͊e�����h�}�[�N�̐F�ȊO�ł��邱�ƁB���𐄏����Ă��邱�Ƃ��烍�{�b�g�ɑ���̃��{�b�g��F��������l�����܂��Ȃ����ƁB�r�u�X�Ƃ����b�y�����`���t���đ���̔F����������ׂ����Ǝv���̂����B

�ǂ����摜������ыC���ŐF���킩��Ȃ��\��������̂����A�J�����̃u���C�g�����Ƃ��ł��Ȃ��̂ō������B�摜�f�[�^�����H���Ă��Ӗ��Ȃ����Ȃ��B

���W���P�P����

CDT�ꉞ�����B

�J�������ƃG�f�B�^�[�͊����������ǁA�e�[�u���̕ҏW���@�ɂ�����H�v���肻���B�摜���璊�o�������F���s�b�N������@�����ł͂�����ƕҏW����ς����B�F�G���A���璲��������@�����p���ׂ����ȂƊ������B

UNDO�@�\���������ǁACLEAR��UNDO�ł��Ȃ��B�g���Ă݂��CLEAR�ɂ�UNDO�������悤�ɂ��Ȃ���Ȃ�Ȃ����A�\���摜�ƃe�[�u���ҏW�p�摜�����̂����܂����킩��ɂ����B�ҏW�\�t�g���ē���ȁB����������ƍH�v���Ă݂܂��B

���̕ӂ͉��ǂ��Ă����Ƃ��āA�J�����̔���т����B�@�Q�C�����������Ƃ��낾���ǁA�����J��������AGC���������Ăă}�j���A�������ł��Ȃ��B����������ƒ����@�\�����������J�����ɂ��Ȃ���Ȃ�Ȃ����B�@�������Ă����Ă�15000�~���x�����B�����Y���t�����ǂ����킩��Ȃ�����H�t���ɍs���āA���Ĕ���Ȃ���Ȃ�Ȃ����ȁB

���W���P�R����

�A�Ȑ��CDT�G�f�B�^�̋@�\�[���ɗ�ށB

�}�b�v�̕\���@�\�Ƃ��A�`�����l�����̃N���A�Ƃ���̎v�����Ƃ���͎����ł����B�{���]�|�ɂȂ����Ⴂ���Ȃ��̂Ŏg���₷���̒Nj��ɖv�����Ȃ��悤�ɋC�������B�@���Ƃ̓}�b�v�̃R�s�[�����肪�ł���悤�ɂȂ�قڊ������ȁB

�ł��A�����͌��\��ςȍ�ƁB���邳�̈Ⴂ�ŐF�̋�͐����ƕς���Ă��܂��B���{�J�b�v�݂����ȕ���ꂽ���Ȃ炱��ł�������������Ȃ����ǁA�����E�ł͂�͂�g���Ȃ��ƍĔF�������B�F�ŕ������Ă��A���̐F���ă��j�[�N����Ȃ����猋�ǂ͗̈攻������Ȃ���Ȃ�Ȃ��B�@���A�����蔒��і��̕����ł����ȁB��͂葁�X�ɏH�t���ɂ����ăJ�����F���˂B

���āA�A���������Ԃ����邩��A�����͏㔼�g�p���̃��f�������ł����悤���ȁ[�B���̂��~�x�ݒ���4�����s�ł���悤�ɂ������ȁB����Ɨ����オ��Ƃ����ł���悤�ɂȂ�I

���W���P�S����

CDT�G�f�B�^�[�͊����B

���Ƃ͎g������ɍ��킹�ď��X�ɉ��ǂ��Ă����Ηǂ����Ǝv���B

���ۂ̕ҏW�̓L���v�`���[�_�C�A���O���ōs���B�����̃J���t���ȐF�}�b�v���P�x�`�����l�����̐F�}�b�v�B�}�b�v���̎l�p�`���F���o�͈́B�����ĐF�}�b�v���ɂ���߂�ꂽ���_�݂����Ȃ̂��摜���̐F���z�ƂȂ�B���o�͈͂ɉ���������f���N���b�N���邱�ƂŕҏW����B�@�N���b�N����̂͏㑤�̃L���v�`���[�摜�ł������̐F�}�b�v�ł��\�B�@�͈͂����߂邱�Ƃ��ł��Ȃ��̂ŁA���o�F�͈͂��L�������ꍇ�͋P�x�����W�N���A(BR CLEAR)�Œ��o�F�͈͂��N���A���Ă���ݒ肵�Ȃ����B�@��̂���Ȋ������B����ł��A���{�J�b�v���ɍs���Ă���F��������̂͑�ςƎv����̂ŁA���炩���ߐF���o�f�[�^��p�ӂ��Ă����A���n�Ŕ���������Ƃ������������낤���B

���̉摜�����Ă��킩�邪�A�����̐F�ڂ̖�����f���قƂ�ǂ��B���Ԃ̌��ł͂��̂悤�ɂȂ��Ă��܂��B��̌u�����̂����Ȃ���������܂��ȐF���z�ɂȂ�͂��Ȃ̂����A���ꂶ��F���ʂɂ͎g���Ȃ��B

�A�C�{����ɊJ���������̔F���v���O�������P�x�����ł͂Ȃ��F�������킹�Ĕ��f�f�ނƂ��ĕ��̂����Ă����B��͂�J���������Ȃ�Ƃ����Ȃ���Ȃ�Ȃ��悤���B

���͓����j�b�g�̏ڍאv���������Ă��炸�A���̂̃g���b�L���O���������肷�邱�Ƃ��ł��Ȃ��B�����j�b�g�͂��������Ȃ���Ȃ�Ȃ����ǁA���ł��邱�Ƃ��킩���Ă邩��Ȃ���Ă������ʔ��݂������B�]�|����̂悤�Ȃ��܂��s���Ȃ��A�C�e���͖�X�Ƃ��ăt���X�g���[�V���������܂邯�ǁA�o���オ�������̒B�����i�J�����H�j�͋C���������BCDT�⓪���j�b�g�݂����ɂ��ł��邱�Ƃ��āA���`�x�[�V�������オ��Ȃ��č���B���Ȃ��čςނȂ炻��ł������A���Ȃ���Ȃ�Ȃ��̂͊m���Ȃ̂ł������Ƃ���ďI��点�Ă��܂��������ǂˁB��Ԃ͂���Ȃ�ɂ����邩����B

�����ł�����Ă����Ă����̔���яł͐F���g�����g���b�L���O�͂ł��Ȃ����A���L�p�ɂ������猩�����Ȃ����̂܂Ŏ���ɓ����Ă��Ă��܂��B���̕ӂ�̏������@���l���Ȃ��ƃg���b�L���O����͂ł��Ȃ��킯������A�u���ł���v���Č����̂͂�����Ƃ������܂����������B���{�b�g���K�V���K�V���������A�C�e���ɔ�ׂ�������n�����Ă��Ƃ��ȁB

�Ƃ͂����A�����j�b�g���ł��đS�g����̎d�g�݂��ł�����A�Ƃ��Ƃ��������삪�\�ɂȂ�B�]�|���̎g����Ƃ��A�܂��܂��ł��Ă��Ȃ��Ƃ��낪���邯�ǃ��N���N���Ă����ȁB

���W���P�U����

�A�Ȑ悩��߂��Ă��܂����B�@�@�ċx�݂͓y�������킹�Ă���4���i���������āj�c���Ă܂��B�ُ�Ȗҏ��̒������I

�J�����̔���і����������邽�߂�CCD�J�������j�b�g�F�B����ς��ꁫ�����Ȃ����Ǝv���̂����A�H�t���X�ɂ͒u���Ă��Ȃ��l�q�B�܂茩�Ĕ������Ƃ��ł��Ȃ��̂��B�₢���킹�̃��[���͑����Ă݂Ă͂��邪�ԓ����邩�ȁ[�B���������Ȃ̂ł����ɂł��������Ă��܂������B�Ƃ肠�����ߓ����ɏH�t���֔��o���ɍs���v��͌����肩�ȁB

������HP���J����CDT�G�f�B�^�[�̉摜���ڂɓ���̂ŁA�������肻�����ɃX�C�b�`�������Ă��܂��B�@���A���ꂩ��͏㔼�g�p���̃��f�����Ɠ������j�b�g�̍\���v�����C���B�T�u�Ƃ��ē]�|�����s���s���̂��B

�㔼�g�p�����l�����Ƃ��A�����g�p���ɂ��Ă��l�������Ȃ���Ȃ�Ȃ�����������B

�����_�̏ꍇ�A���Օ����̎p���@�i�����_�̏ꍇ�͗��Ҋ߂̒��_�����{�b�g���_�Ƃ��Ă���B���̌��_�̎p���̂��ƁB���_�̎p�����ĕς��ȁB�j�@�͗����̎p������o���オ����̂Ȃ̂ŁA�Ɨ����Ă��Ȃ��B���_�̎p��������Ƃ���ƁA���̎p���l���ς�邾���Ȃ̂����A���ʂōl����Ə��ʂ��_�l�B���͐����ʂɗ����Ă��邱�Ƃ����l���Ă���̂Ő����ʂɗ����Ă��鎞�̌��_�̎p�������Ղ̎p���Ƃ������ƂɂȂ�B

2���ŗ����Ă��鎞�́A���́u����p���v�����������Ղɏ㔼�g��������邽�߁A���̉e���Ō��̍��W����̍��W���O���[�o���Ɍ��肷��̂����A4���ŗ��i�Ƃ������l���j�̎��͈Ӗ��������قȂ�B���Ղ��猨�߂܂ł̊Ԃɂ͊߂��Ȃ����߁A�S���Ő����ʂɗ��������̓��̂̎p�����Ӗ��������ƂɂȂ�B����͑O�q�̍��Ղ̎p���Ƃ͈قȂ���̂ɂȂ邽�߁A���̒l������Ă��Ӗ����Ȃ��B

�ł��A�S����Ԃ̂��߂̉����g�p���A�܂��͂S����Ԃł̎p�����f�������̂̓C���Ȃ̂Ō���̉����g�p�����f�����p���������B�@�Ƃ������ƂŁA�S���p���̏ꍇ�ɂ͉����g�p�����f���̂����������p�ipan�j�ƂЂ˂�p�iroll�j�͑��̎p���l�Ɋ���߂��ϊ����s�����Ƃɂ���B

���łƌ�������Ȃ��A�����g�p���̋t�ϊ������������˂Ȃ�܂��B�g��Ȃ�������Ȃ��łق��Ƃ������ǁA�d������Ă���S�������i���{�b�g�̂��Ƃˁj�Ŏp�����Ǘ�����ƂȂ�ƁA�p�x����p�����Ȃ��Ⴂ����B

�E�E�E�t�ϊ��ȂȒP���B�ȑO�ɍ�낤�Ƃ����Ƃ��͉����g�p���̃p�����[�^�������Ə��Ȃ��āA���ׂĂ̎p���ɑΉ����Ă��Ȃ��������ǁA�ܐ旧�����s���T�|�[�g�������͂ǂ�Ȏp�����\���ł��邩�炷���ł���͂��B�@�Ǝv�����̂����A���́A�ܐ旧�����s���T�|�[�g�������ɁA�ڒn�ʒu�x�[�X�̎p���\�����[�h�Ƒ���߃x�[�X�̎p���\�����[�h���Ă̂�����Ă��āA����̏ꍇ�͑���߃x�[�X�ŕ\�����ׂ��Ȃ̂����A��������̏������l���Ă��Ȃ������B�B�B�@����߃x�[�X�̎p���\�����Ă̂́A��{�I�ɗV�r���A����̎��̓�����\�����₷���悤�ɍ�����̂ŁA����ȊO�̎g�������l���ĂȂ������B�@�l���Ȃ���ȁB

���W���P�V����

�ߊp�x����̎p���擾�ɓ�q�B

�Ƃ����̂��A��������A�l���ɂȂ�����Ƃ����p�����T�|�[�g����ƂȂ�ƁA�߂̊p�x���傫���Ȃ�A�����ȕϊ����ɕs����o��ꍇ��������B�O�p�����������Ȃ̂�90�x��180�x����ƈႤ�l�ł�����͐��藧���Ă��܂��A�ϊ������ƃ��{�b�g���т����蓮�삵�Ă��܂��̂��B

�����A�������������̂́A�A�A���̋t�^���w�v�Z�ŌҊ߂̎p�����Z�o����̂Ɂ@tan( )�@���g���̂����A���ꂪ��肾�����B tan( )�̓�/2 radian �����̎������Ȃ̂ŏɂ���/2radian���ꂽ�l���o���Ă��܂��̂��B�����ʂł���ΏC���ł���̂����A���܂����f�ł��Ȃ������̂łƂ肠�����A��x���^���v�Z�����Č������邱�Ƃɂ����B��������̂͊p�x����p�����擾�����������ɂ���Ζ��Ȃ����낤�B������Ƃ������������ǎd���Ȃ��B

�����ЂƂ͂����Ɩ��B����p�����Ƃ�ߊp�x�̑g�ݍ��킹�͗B��ł͂Ȃ��ꍇ������B���̏ꍇ�A�ߊp�x�ƍ��W�E�p���l�͑��ݕϊ��ł��Ȃ��B���Ƃ��A���̉摜�̑��̎p���͂ǂ���������l�����B�����A�Ҋߕ����̃T�[�{�̊p�x�͑S�R�Ⴄ�̂��B

���{�b�g��������n�߂��������̎p�����Ƃ��Ă����Ƃ���B�ߊp�x����p�����Z�o���A��������̓�����v�Z���鎞�ɉE���̊ߊp�x���Z�o���Ă��܂�����A����͂����A�Ƃ�ł��Ȃ��т����蓮������Ă��܂��̂��B

�@�@

���ɂ��G�߂��t�ɋȂ������肷��Ɠ�����肪�N����B�l�Ԃ��T�|�[�g����̂��O��ł���A���ɂȂ�Ȃ��̂����A�d�������Ă��炷�ׂă��{�b�g�ɔC����ƂȂ�Ɩ��B�@��肩���Ƃ��Ă͐��K�̎p���ɂȂ�܂ł͊ߊp�x�x�[�X�œ��삳���č��W�E�p���l�ł̐���ɐ�ւ���Ƃ����̂�����̂����A�d�������ċN���オ��l�q�ɂ�����肽���̂łȂ�i���l���˂Ȃ�Ȃ��B�@�܂���͈̔͂ł����B

�A�����삵�Ă����ԂȂ�ߊp�x���}���ɕω�����ꍇ�͑��̑g�ݍ��킹�������Ƃ����`�F�b�N�����邵���Ȃ����ȁ[�Ǝv���Ă�B

���������p�����Ă��肦��Ǝv���̂����ǁA���͂��̎p�����O�q�̖��ɂЂ��������Ă��܂��̂��B������Ă��ׂđ�ڂ̃��[�����������Ȃ̂��B�����Ă�ꍇ�͖��Ȃ����ǁA���������p���ɂȂ�Ƃ��̊ߌ`�Ԃ͎��R�x�������Ă��܂��B

���W���P�X����

�Ƃ��Ƃ��ċx�݂������܂ŁB

�A�Ȃ���߂��ĂS���̋x�݂����������A���̂������Ȃ��Ƃ��ہX�Q���͉����g�p���̋t�ϊ��ɔ�₵���B���A�ő����̌X����Ԃł̋t�^���v�Z�A���^���v�Z�͂Ƃ�ł��Ȃ��p�����܂߂ăJ���y�L�ɂȂ����B

�����A�ړI�̉����g�p���̋t�ϊ��͂Ƃ����ƁA�܂��_���B

���̎p�����牺���g�p�����\�z�������̂����A���g���Ă���t�^���w�v�Z�͑���߂����_�Ƃ������́B����߂͐��p�����Ƃ�A�Ҋ߂Ɏp���l�����悤�ɂ��Ă���B�����g�p�����\�z����ɂ͍��E�̑��̌Ҋߎp������v���Ȃ���Ȃ�Ȃ��̂ŁA�Ҋߎp���𑫎�ߎp���ɕϊ�����ϊ���������Ă����B

�Ƃ��낪�A���̂悤�ɂ��č\�z���������g�p���l�͑��ݕϊ������܂������Ȃ��̂��B�ǂ����A���p���̂����́u�H�ʂ̌X�Βl�v�������炵���B�@�@�@�ܐ旧�����s�̎��Ɂu�H�ʂ̌X�ɑ���p���v�ƌ������ƂŘH�ʌX�Βl��lj������̂����A���̕����̎������K���炵���A���܂������Ȃ������ɂȂ��Ă���炵���B

�Ƃ����̂��A�͂��߂͌Ҋ߂̎p���𑫎�̎p���ɕϊ����鎮������Ă����B�ǂ������M�����������̂ŁA�Ҋ߂����_�Ƃ������^���w�v�Z��������Č��Z���邱�Ƃɂ����B����ƁA�ϊ����ŕϊ��������p���l�Ə��^���w�v�Z���ō�������p���l�̓s�^���ƈ�v����B�ǂ����ϊ����͐������炵���B

����ƁA���������̂͑���ߌ��_�ƂȂ��Ă���t�^���w�v�Z���̕��ł���B�@�čl�̗]�n�A�����B

����͗��ʂł́A���悻�L�蓾�Ȃ��p�������A�l���◧���オ��r���p���Ȃ�\�����肦�鑫�p���B���Ȃ݂ɉE���̂��Ă��������B

����𑫎_�ŕ\������ƁA

x:43.0 y:25.2 z:205.1 r:-24.2 t:-159.2 p:3.4

�ƂȂ�̂����A�Ҋߌ��_�ŕ\������ƁA

x:-30.8 y:97.2 z:184.8 fr:-154.6 ft:-162.5 fp:168.1

�ƂȂ�B

r,t,p�͌Ҋ߂̎p���Afr,ft,fp�͑���߂̎p���ł���B

�킩��Ղ����邽�߂ɍ��W�����������ނƁA�܂����_�̏ꍇ

�@�Ҋ߂̎p����r-p-t�̏��B

�@�Ҋ߂̎p����r-p-t�̏��B

���ɌҊߌ��_�̏ꍇ�B

�@����̎p����r-t-p�̏��B

�@����̎p����r-t-p�̏��B

���_�̏ꍇ�͂܂������Ƃ��āA�Ҋߌ��_�̏ꍇ�̑���̎p����fr:-154.6 ft:-162.5 fp:168.1�Ƃ����̂͗������ɂ������A�����Ȃ��Ă���B

�����܂łł킩�����̂́A�܂�����ߌ��_�̏��^���w�v�Z�͐������悤�Ɍ�����B�@�����āA�Ҋߌ��_�̏��^���w�v�Z���ǂ���琳�����B�Ԉ���Ă��邩�Ǝv�������A�v�Z���ʂ̌������ԈႦ�Ă����B�@�����āA���݂̑��p���ɗp���Ă���X�Βl�Ƒ���߂̎p���͍l�������قȂ�B�@�i�Ƃ������A���m�ɂ͑��p���ɗp���Ă���X�Βl�̒�`�����������̂����B(~_~;)�@�j�@����Ə������ł����̂ŁA���ꂩ�狁�߂Ă���ϊ���������Ă݂����Ǝv���܂��B

��߂S���ԁB�ł������`�B�t�^���w�v�Z���̕��������Ȃ̂����A�܂��͈ꌏ�����B���̂��ƁA�����g���_�i�Ҋ߂̒��_�j�̃`���g�p������^�����p�x�ɂ��邽�߂̕ϊ����s��Ȃ���Ȃ�Ȃ��B�@���^���w�v�Z�ł���Ă��܂������A����p���l����̕ϊ��̕����֗��Ȃ̂ł�����������������B

��i�P�@����g��ŐQ���ׂ郉���_

right

x:-70.050 y:69.900 z:-151.400

r:-7.400 t:0.000 p:0.000

ft:-13.900 fp:24.500

left

x:-23.650 y:-82.500 z:-178.400

r:-2.200 t:0.000 p:-0.000

ft:-98.600 fp:3.200

width : -33.700 depth : 152.400 height : 178.400 hung : 27.000

tilt : 0.000 pan : 0.000 roll : 0.000

<right> roll : -7.400 tilt : -13.900 pan : 24.500

<left> roll : -2.200 tilt : -98.600 pan : 3.200

pivot: 0 pivot_pan_x: 0.000 gx: 0.000 gy: 7.000 gz: 200.000

��i�Q�@�����L���č��郉���_

right

x:80.000 y:157.450 z:-29.200

r:-29.300 t:0.000 p:0.000

ft:-10.000 fp:-7.000

left

x:70.200 y:172.750 z:-35.200

r:-23.000 t:0.000 p:-0.000

ft:-11.200 fp:-6.600

width : 210.200 depth : -15.300 height : 35.200 hung : 6.000

tilt : 0.000 pan : 0.000 roll : 0.000

<right> roll : -29.300 tilt : -10.000 pan : -7.000

<left> roll : -23.000 tilt : -11.200 pan : -6.600

pivot: 0 pivot_pan_x: 0.000 gx: 0.000 gy: 7.000 gz: 200.000

��i�R�@���K�����郉���_

right

x:28.550 y:42.700 z:118.500

r:153.600 t:0.000 p:0.000

ft:83.000 fp:32.200

left

x:7.150 y:43.100 z:112.600

r:140.300 t:0.000 p:-0.000

ft:78.800 fp:54.100

width : 95.700 depth : -0.400 height : -112.600 hung : 5.900

tilt : 0.000 pan : 0.000 roll : 0.000

<right> roll : 153.600 tilt : 83.000 pan : 32.200

<left> roll : 140.300 tilt : 78.800 pan : 54.100

pivot: 0 pivot_pan_x: 0.000 gx: 0.000 gy: 7.000 gz: 200.000

���A�\������p�����[�^���قǖY��Ă�B�@�܂��A���[��Ȏp���ł����l���ł��܂�����Ęb�����Ȃ̂ł悵�Ƃ��悤�B

�ߊp�x��ł͂Ȃ��A�p���l�ŕ\�����ƂŁA�v���O�����œ��������邱�Ƃ��ł���B�i���m�ɂ͔�r�I�ȒP�ɂł���j���g���Ă���p���l�͗����ĕ����ꍇ��z�肵�č�������̂Ȃ̂ŁA���̂悤�ȓ���Ȏp����\�����Ă��O�q�̈Ӗ������邩�ǂ������������A��������A�l���ɂȂ�����Ƃ������x�Ȃ�Ӗ��������낤�B���]����Ƃ��A���ނ���������ɂȂ�Ƃ����Ċ����̓����\������͓̂����������Ȃ��B

���ǁA���̘A�x�ɂS�����s�ǂ��납�㔼�g�p���ɂ�����ł��Ȃ��������A���Ȃ���Ȃ�Ȃ��̂ɑ�ς���������C�����Ȃ��Ǝv���Ă��������g�p���̋t�ϊ������������̂͑傫�Ȑ��ʂ��ȁB

���W���Q�P����

�����g�p�����t�Z����Ƃ��ɉ����g���_�̎p�����w��ł���悤�ɂ����B�@����ʼn����g�p���̋t�ϊ��ɂ��Ă͊��S�Ɋ����̂͂��B�@����ŃW���C������擾�������̎p����K�p���邱�Ƃ��ł��A���ۂ̎p���i�����Ă���悤�Ȏp�������A���ۂɂ͐Q�]��ł���Ƃ�������ԁj�𐳊m�Ƀf�[�^���ł��邱�ƂɂȂ����B

��x�ߊp�x��ɂ��Ȃ���Ȃ�Ȃ����A���ݎp������pan�p��0�ɂ����p���Ȃǂɕϊ��ł���悤�ɂȂ����B����ŁA���Ƃ͏㔼�g���f����A������ΑS�g�̃��f�����o���オ��B�i�A�^�}�͂܂��Ȃ����ǁB�j

�㔼�g�p���͎����W�ƕI�̈ʒu���Ǘ���������̂��A�����g�̂悤�ȕ��s���f������������������̂�������ƍU�߂����˂Ă���B�l��������̂����ʂ̖ڕW�����A�l���������ړI�ł͂Ȃ��̂ŁA��܂Ō����������f���ɂ������B�Ƃ͂����Ă��K�v�ɉ����ĉ��ǂ��Ă������ƂɂȂ�̂ōl�����Ɏ�������Ęb���낤�ȁB

���W���Q�Q����

�����x�Z���T�[���瓷�̎p����ǂݎ��A�����g���_�̎p���Ƃ��Ď�荞�߂�悤�ɂ����B

����͂ł����ł����Ɗ��ł������Apan�p�ɂ��Ă̌������Ă��Ȃ������B�Ă̒�o�O������A���̏C�����s�����B

�����͂Ƃ��Ƃ��㔼�g�p�����f���Ɖ����g�p�����f���̘A���܂ł�낤�Ǝv���Ă������A�����ȍ~�ɌJ��z���B�܂��Ȃ�ɂ���A�����������Ă������킩��Ȃ��\�z�i�K�����v���O�����������ăf�o�b�O�Ƃ����i�K�͉�����������̂����͂����肵�Ă���̂Ŋy�����Ƃ����Ίy�����B�فX�ƍ�Ƃł���̂��������������ȁB

���W���Q�S����

�{�[�h�J�������͂����I

���ʂ��猾���ƍ��̂Ƃ���I�[��OK�@(*^^)v�@�����L�p�����Y�̓M���M�������s���g���������A�F�������N�₩�ɏo�Ă���B���܂ł͏o�Ă��Ȃ������P�����������ɂ����Ղ�o�Ă���B�����Y�̒��S��CCD�̒��S�ł͂Ȃ��悤���B

������ƒ��ׂĂ݂��Ƃ���A�F��������̂̓I�[�g�z���C�g�o�����X�g���b�L���O�iAWT�j�������Ă��邩��炵���A�z���C�g�o�����X�����b�N�o��������炵���B�܂��͔�ʑ̂ɃO���[�n�̂��̂��ʂ��Ă���悢�炵���B�@���̃J�����̓g���b�L���O��邱�Ƃ��o����悤�Ȃ̂ł��̂�������ǂ��Ċm�F���Ă��������B

���ƁA���̃J�����̓Y�[���@�\������B���̉摜���Y�[���������̉摜�B�A���O���͂�����ƈႤ���A��̉摜�ƃJ�����ʒu�͂قړ����B

���̃Y�[���͂�����f�W�^���Y�[���ŁACCD�̎擾�G���A�����������Ă��邾�������A�����L�p�����Y������̂łƂĂ����肪�����@�\�B�Î�����Ƃ��̓Y�[���ŁI���̃J������CCD��40����f�B���ʂ̃{�[�h�J������25����f�������̂ł�����Ƃ��܂肪����摜���B���̃A�v���ł̉�ʂ��ƈႢ���킩��Ȃ����A19�C���`�f�B�X�v���C�ɉf������Ⴂ�������B��f���������̂ŃY�[�����Ă��\���ȉ𑜓x��������B�����Ƃ���͑��̂��f�J�C�E�d���E��������d�͂��傫���Ƃ������ƁB�����܂��T�[�{���͏���d�͂��͂邩�ɏ������̂ł����ł��傤�B�ǂ������̃o�b�e���[����10���`15�����炢���������Ȃ��^���Ȃ̂��B

�Y�[����ON/OFF������2�i�K�����A1�r�b�g�̓��͂Ő���o����̂Ń}�C�R�����Ȃ��Ő�ւ�����悤�ɂ��Ă���RPU-100���瑀��ł���BAWT�̃I���I�t������ōs������B

�f�W�^���o�͂炵���R�l�N�^���t���Ă���̂����A�d�l���킩��Ȃ��̂Ŏg���悤���Ȃ��Ȃ��B

���W���Q�U����

�㔼�g���f�����Ƃ肠�����o���ăv���O�����ɑg�ݍ��̂����A���܂������Ȃ��B

�r�̋t�^���w�v�Z���s���S�Ȃ悤���B���������Α��̋t�^���w������������Ɉꏏ�ɍ�����̂����A����m�F�����炨�����ȕ������������̂��v���o�����B���̎��͑����������Ƃł����������Ęb�ŁA��ɂ����̂������B

�����U���R�x�ɑ��Ęr�͂S���R�x�����A���\���G�ȓ���������B���͎��悪�Ȃ�����S���R�x�ōς�ł��邪�A�{�i�I�ɘr�̋@�\���������悤�Ƃ���Γ���̕��G���͑��̔�ł͂Ȃ��B

���Ȃ��Ƃ��I�̈ʒu�͐���ł��Ȃ���Ȃ�Ȃ����A���͈͂⑫�Ƃ̊��Ȃ��l���Ȃ���Ȃ�Ȃ��B�܂��܂�����ŃS�n�������t���H�ׂ���悤�ȕ���Ȃ̂��B

�Ƃ͂����A����낤�Ƃ��Ă���̂͒P�Ɂu����p���v�Łu������W�v�֎��������Ă����Ƃ������ƁB�����ē�����肶��Ȃ��B

�ł��A���̎��ƈꏏ�Ń����_�̘r�������͈͂��ׂĂɂ����āA���^���w�v�Z�Ƌt�^���w�v�Z�𑊌݂Ɍv�Z�ł���悤�Ɋ�������̂͌��\��ςȂ̂��B

�������̌��ʁA���ʂ̓����͑����v�ɂȂ����B�i�ȑO�ɍ�������͌��\�ԈႢ���������j�@�܂��A����Y���̊p�x��90�x�ȏ�J�����ꍇ�̘r�̈ʒu�����T�|�[�g�B�Z�o������̎p���p�x�����������ǂ������؏o���Ă��Ȃ��B

�㔼�g���f�������ɓ������āA�r�̐���ɂ��ď����l�������A��͂����B�r�ʼn������悤�Ƃ��Ă��邩�Ƃ������Ƃłǂ�����ē������ׂ��Ȃ̂����ς��B

�@�����g�Ɠ��������ɓ���

�A�O���[�o����Ԃ̍��W�ɑ��ē���

�B�����g�Ƌ������ē���

�@�͎����̑̂�G��ꍇ�ȂǁA�A�͎肷��ɂ��܂��ĕ����Ƃ��A�ו��������ĕ����Ƃ��A�B�͎l�����Ċ��������邯�ǁA���[�`���O�̕��������x�������傫�����ȁB

�y�j���ɏH�t���ɔ��o���ɍs���ė����B�ʔ̂ł��������ĂȂ��Ǝv���Ă��������{�[�h�J�����͏H�t���ɂ���܂����B�u�H�t���ɍs�����I�v���Č��ӂ���������������E�E�B�@RS302CD�Ɏg���Ă���R�l�N�^�͏H�t���̃q���Z�Ŏ�ɓ���܂����B�ʔ̂Ŕ���Ȃ��ł悩�����[�B�ł��A���ɂ��q���Z��JST�̃R�l�N�^��T���ɍs�����̂����nj�����Ȃ������BJST�̂͒ʔ̂Ŕ�����̂����A�q���Z�̂͂܂������Ă�̂�������Ȃ��B�v�����đ��̎�ɓ���₷���R�l�N�^�ɕς����Ⴄ�̂�������͂₢�����B

�ޗ���������̂œ������̐v�Ɛ���Ɏ��|����˂B�����������������_�炩�ɂȂ邾�낤���炿�傤�ǂ����B�������A�A�i���͂��������Ȃ��B����Ȃ̂ŗ��N�̂T���ɊԂɍ����̂��ȁH

���������A�ǂ����Łu���N�̃��{�J�b�v�q���[�}�m�C�h���[�O�͂RON�R�ɂȂ�\���������v���ď����Ă����̂��������A�R��ɂȂ������������グ���ȁB�o��͕s�\���B�����Ȃ�ƃ����_�̃f�r���[�悪�����Ȃ�Ȃ��B

���W���Q�V����

����Ǝ����̉ߋ��̏��Ƃ��������������Ƃ��ł��܂����B���łɉߋ��̉߂������Z���邱�Ƃ��ł��܂����B�����Ď��̒i�K�i�߂܂��B

���̘r�̎p���͏��^���w�v�Z�Ƌt�^���w�v�Z�ň�v�����邱�Ƃ��ł������A���̎��Ɠ��l�ꕔ�̎p���ł͂Q�p�^�[���ȏ�̑g�ݍ��킹������A�ꍇ�ɂ���Ă͂т����蓮������Ă��܂��B�ł��܂��A�Ƃ肠�����͑��Ɠ����x���ɂ͂Ȃ������Ǝv���B

�����ď㔼�g�p���Ƃ̕ϊ������v�������B�i���A�t�ϊ��̃e�X�g����ĂȂ���j

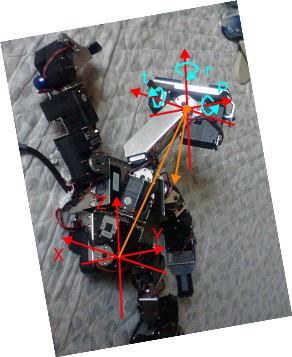

���r�̋t�^���w�v�Z�̃e�X�g�̗l�q�B�E�r�̊ߊp�x������W�Ǝp���ɕϊ����A�܂��ߊp�x�ɕϊ����č��r�����Ă���B�i�A�����삶��Ȃ��̂ŐÎ~���(^_^;)�@�j

�@�@

�@�@

���̎p���Ȃ炿���ƃg���[�X�ł��邪�A�E���̎p�����Ə�r���Ђ�����Ԃ����p���ɂȂ�B���̍��W�Ǝp���͎w���ʂ�B

���̎p���Ȃ炠�肦�����Ȃ��`�B

�𖾂������Ƃ��������Ƃ��Ȃ���Ȃ��B�����_�̃y�[�W�ɍڂ��Ă�r�̋t�^���w�v�Z�̃����͊Ԉ���Ƃ�܂��B�i�������{�l������s�\�̃����ł����B�B�B�j

���W���Q�W����

�r�̋t�^���w�v�Z�����������̂ŁA���t�������̓����ɂ��Č�������B

���Ƃ��Ƃ���Ƃ��̓����Ƃ��āA�e�p�����痧�ʂ֑J�ڂ��Ă��������g�ݗ��ĂĂ����B�@�e�p���ƑJ�ړ���𐔒l���ł���ǂ�Ȏp������ł������ōl���āi�l���Ă͂��Ȃ��ǁj�����オ�邱�Ƃ��ł���悤�ɂȂ�͂����B

�S����Ԃŏd�S���Q���̎x�����p�`�O�ɗL��Ƃ��͎�����Ă��Ȃ��Ɠ]�����Ă��܂��B���̉摜�̏�Ԃ��ƁA�����d�S�𑫑��Ɉړ����邱�Ƃ��ł��Ȃ��̂Řr�������`���`�ƕ������Ď��t���Ă���ʒu�𑫑��ɋ߂Â���K�v������B�i�Y���Y���ƒn�ʂ��C�铮���͋֎~���O��Ȃ̂Łj

�P���i�ǂ��炩�̎�j���グ�邽�߂ɂ͂R���œ]�Ȃ��悤�ɂ���K�v�����邽�߁A�d�S���u�グ���v�Ƌt�̕��ֈړ������Ȃ���Ȃ�Ȃ��B�����Ŗ��B��ڂ͂قڐ��������A���̂��قڐ����ɐQ�Ă����ԁB���ꂾ�ƌҊ߂�Y����]�̃T�[�{��Z����]�ɂȂ��Ă��܂��Ă��邽�߁A���̂����E�ɃV�t�g���铮�삪�ł��Ȃ��B�i�t�ɁA��̕��֏d�S���ړ����āA������ɋ߂Â���Ƃ�������Ȃ�ł��邩������Ȃ��ȁB�j

���Ƃ��Ή��̉摜�̂悤�ɑ�ڂ������ɂȂ�悤�Ȏp���̏ꍇ�͑�ڂ̂Ђ˂莲��Y����]����ƂȂ邽�߁A���̂����E�ɃV�t�g���铮�삪�ł���B�ł��A���̏�Ԃ��ƍ��E�ւ̏d�S�V�t�g���s��Ȃ��Ă��Ў���グ�邱�Ƃ��炢�͂ł���B

���ǂ̓����_�̑��\���͂S�����s�ɂ͌����Ă��Ȃ��\���Ƃ������Ƃ����A�Q�����s���{�b�g�͑S�̓I�ɂ��������X���ɂ��邾�낤�B�Q�����s���{�b�g�łS�����s���s���͈̂ӊO�ɓ�������B

�\�z�̒i�K�ł́A���삪���G�ɂȂ�̂ŏd�S�ړ��͍��E�V�t�g�ōs�����A�p���ɂ��Ă��p���Ƃ����[���͍l�����Ȃ��悤�ɂ��悤�ƍl���Ă������A�d�S�ړ������E�ւ̉�]�ōs���ƂȂ�ƁA���Ȃ��Ƃ��p���͍l���Ȃ���Ȃ�Ȃ����B�~���������Ȃ����B

�㔼�g�Ɖ����g�������B

�㔼�g�����Əd�S�̂�����v�Z���ĉ����g�����傢�Ɠ����B�ÓI�Ȍv�Z�Ȃ̂ő債�����Ƃ͂Ȃ��̂����A�r��U��グ�Ă����܂�o�����X������Ȃ��̂ł����������B

�r�̓�����F�X�ƍl���Ă���̂������ƈ���ėp�r�����l�Ȃ̂Ń��f��������͍̂���B���W��p�����Ǘ�����ɂ��Ă����[�J�����W�ŊǗ�����̂��K���Ȃ̂��O���[�o�����W�ŊǗ����ׂ����Y�ނƂ���B

�@�@

��̉摜�͎����W���O���[�o���Ȉʒu�ɌŒ肵���܂܉����g�̎p���������l�q�B���Ƃ��ΐ����������R�b�v���������܂ܕ����Ƃ��ȂǁA�������Ƃɂ���Ă���R�b�v�̓������L�����Z������悤�ɘr�������A���̊������B�������ȍ��x�Ȃ��Ƃ͂ł��Ȃ��ĒP�ɑ��̓���ɍ��킹�Ęr���W���v�Z���Ă��邾���B

���Ȃ݂ɏ�̂�-40�x���ނ��A20�x��������40�x������ԁB

��X�����Ă��鎞�̐������̂�r�̓����ŃL�����Z��������Ƃ������Ƃ���肽���Ǝv���Ă���B���������Ƃ��ɗL���ȍ��W�̊Ǘ����@�͉����낤�H�ƍl����ƂȂ��Ȃ�����Q���Ȃ��Ȃ�ۑ肾�B�{�[���𓊂���Ƃ��̂悤�ɏ㔼�g�Ɖ����g���������đ傫�ȓ�����Ƃ������Ƃ��l�������B���[�`���O�ɂ͂��̍l�����K�v�Ǝv���Ă���B

�܂��܂��v���O�����̂��肪���n�Ȃ̂Ŏp���l�Ȃǂ����K�ɐݒ肳���܂ŃT�[�{���т����蓮�삷��V�[������������B�܂��܂��܂��܂����B