仭俆寧侾俉擔仭

堷偒懕偒儔儀儕儞僌偟偨僨乕僞偱偺僩儔僢僉儞僌偵庢傝慻傫偱偄偨偺偩偑丄側偐側偐偆傑偔偄偐側偄丅丂傑偢堦偮偼儔儀儕儞僌偺惛搙丅丂帪乆暔懱傪尒棊偲偟偰偟傑偆丅偦傟偱拲帇暔懱偑愗傝懼傢偭偰偟傑偆偺偩丅丂懠偵傕丄拲帇懳徾暔懱偑侾偮偟偐側偄忬懺偐傜丄媫偵俀偮偵側偭偨応崌丄慜夞僼儗乕儉偱偺僨乕僞偑栶偵棫偨側偔側傞偲偄偆晄嬶崌偵婥晅偄偨丅

怓乆帋偟偰傒偨偑丄偙傟偩偲偄偆懳嶔偑側偄傑傑偩偑丄偙偺忬懺偱偙偺搚擔偑夁偓嫀偭偰偟傑偆偺偼杮堄偱偼側偄偺偱丄偙偺栤戣偼愊傒巆偟偱愭偵恑傓偙偲偵偡傞丅丂椙偔峫偊偨傜儘儃價儕儎乕僪偱偼儔儀儕儞僌偟偨僨乕僞傪偦偺傑傑嶲徠偡傞偭偰偙偲偼側偄偺偱丅丅丂(^^乁

師偵庤愭傪僇儊儔夋憸傪嶲徠偟側偑傜摦偐偡偭偰偺傪偡偡傔傞偙偲偵丅

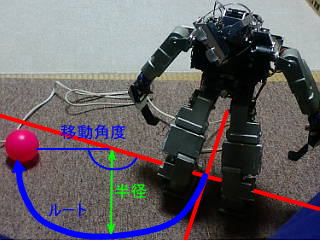

傑偢偼庤愭傪擣幆偱偒傞傛偆偵儅乕僉儞僌丅

丂丂僟乕僋僌儕乕儞偲愒偺慻傒崌傢偣偑塃庤丄僟乕僋僌儕乕儞偲惵偺慻傒崌傢偣偑嵍庤

偦偟偰偙偺庤傪儔儉僟偑尒傞偲丄

丂丂業弌偑偍偐偟偄側偀乣丅

師偵偙傟傪CDT亄儔儀儕儞僌偱愗傝弌偟

丂僟乕僋僌儕乕儞偺僑儈偑梊憐奜偵懡偐偭偨丅丂儀乕僗僇儔乕曄偊偨傎偆偑偄偄偐傕偟傟側偄丅

偝傜偵偙傟偐傜庤愭傪摿掕偡傞偲

傑丄偙傫側姶偠偱偡丅丂岝偺壛尭偱怓偺敾暿偑曄傢偭偰偔傞偺偱丄屵慜丄屵屻丄栭丂偲CDT梡偺僥乕僽儖傪嵞挷惍偟懕偗偰傑偡丅丂幚偼偙傟偑僀儎側傫偩偗偳丄僨乕僞検峫偊傞偲捠忢偺僇儔乕夋憸偼巊偊側偄偱偡丅

庤愭嵗昗偼傢偐傞偺偱丄僇儊儔偲庤愭偺嫍棧偼敾傞丅偙偺嫍棧傪巊偭偰丄庤愭傪僗僋儕乕儞暯柺撪偺擟堄偺埵抲偵摦偐偡偺偩偑丄僇儊儔巔惃抣偐傜媡嶼偟偰丄尰忬偺榬嵗昗偐傜偳偭偪偺曽岦偵偳傟偩偗摦偐偣偽偄偄偐傪寁嶼偡傞偺偩丅丂岆嵎偑偳傫側傆偆偵岠偄偰偔傞偐偑栤戣丅丂巚偄捠傝偺曽岦偵摦偄偰偔傟傞偐側乕丅丂乽儃乕儖傪偼偠偔乿偔傜偄側傜側傫偲偐側傞偐傕偟傟側偄偗偳丄乽儃乕儖傪偮偐傓乿偲偐偵側偭偨傜偒偭偲擄偟偄偩傠偆偹丅

仭俆寧侾俋擔仭

崱擔偼挬偐傜嫗搒傊弌挘丅丂寢峔憗偔婣偭偰偒偨偺偩偑丄堸傫偩偣偄偱儌僠儀乕僔儑儞偑忋偑傜側偄丅丂怴姴慄偱怮偨偐傜悓偄偼掱傛偔惲傔偰傞傫偩偗偳丄傕偲傕偲庰偵偼嫮偔側偄偺偱塭嬁戝側偺偩丅

丄丄偲偄偆傢偗偱丄堄枴偺偁傞嶌嬈偼偱偒側偐偭偨丅

丂

偙偙偺偲偙傠夋憸偲摦嶌傪楢実偝偣偰偄傞傢偗側偺偩偑丄RPU-100偱恑傔偰偄偔偙偲偑擄偟偄偺偐側偀偲峫偊弌偟偰偄傞丅丂CPU偺擻椡揑偵姰慡偵僆乕僶乕偟偰偄傞偺偐偲偄偆偲傑偩偦偆偄偆傢偗偱偼側偄偺偩傠偆偗偳丄僒乕儃傊偺僐儅儞僪偑帪娫捠傝偵憲傜傟側偄偙偲偑偁傞偲偄偆偺偼憡摉抳柦揑側偙偲偱丄戝偒側栤戣偩側偲巚偭偰偄傞丅

夋憸張棟偑崱傗偭偰偄傞偙偲偩偗偱廔傢傝偲偄偆偙偲傕側偔丄崱屻偳傫偳傫偲暋嶨壔偟偰偄偔偟丄壒惡崌惉偼傑偩偟傕壒惡擣幆傕憡摉側晧壸側偺偩丅CPU揑偵偼塣摦惂屼偑堦斣妝僠儞偭傐偄偺偩偑丄摦嶌偵僶僢僼傽偑側偄偨傔丄帪崗偳偍傝偵柦椷傪幚峴偡傞昁梫偑偁傝丄偦傟偑UNIX偵偼堦斣嬯庤側偺偩丅

僾儘僙僗偺偙偲傪怓乆偲峫偊側偑傜僾儘僌儔儉偡傞偺傕偪傚偭偲傔傫偳偔偝偄偟丄僴乕僪揑偵儅儖僠僾儘僙僢僒偵偟偨曽偑偄偄偺偐傕偟傟側偄側偀偲巚偭偰偒偰偄傞丅

偱偐偄CPU傪2偮搵嵹偡傞偲側傞偲丄儘儃僢僩偺戝宆壔偑昁恵側偺偩偗偳丄偪傚偭偲偦傟偼儕僗僋偑戝偒偄丅丂儘儃僢僩傪嶌傝捈偡偺偼傑偩憗偄丅丂偱傕丄摦偒傪儌乕僔儑儞壔偟偰偱偐偄CPU偐傜彫偝偄CPU偵儌乕僔儑儞婲摦傪偐偗傞偭偰偺偼儃僣丅崱傗偭偰偄傞僇儊儔夋憸偱庤傪摦偐偡側傫偰偙偲偑偱偒側偄傢偗側偺偱僟儊偱偡丅

栥乆偲峫偊偨寢壥丄丂懳嶔偺堦偮偲偟偰丄彫偝側CPU儃乕僪傪僒乕儃僐儅儞僪傊偺僶僢僼傽偲偟偰偮側偖埬偑偄偄偐側丅丂寁嶼偡傟偽丄20僒乕儃傊偺0.5昩暘偺僐儅儞僪偱1僉儘僶僀僩傎偳丅偙傟傪460800bps偱憲傞偲20ms偪傚偄偱憲傟傞丅20ms偲偄偭偰傕揱憲楬偱偺帪娫偺偙偲偱CPU偺愯桳帪娫偼偦傫側偵柍偄偼偢丅僶僢僼傽偑偁傞偼偢偩偐傜丅丅偨傇傫丅丅丂偱丄偪偭偙偄CPU懁偱僶僢僼傽傪帩偭偰帪娫捠傝偵憲傞偭偰姶偠側傜偱偒偦偆偐側偲丅丂偙傟側傜CPU懁偱摦嶌巜帵傕偱偒傞偟丄1曕暘偺僨乕僞傪憲傟偽1曕偛偲偱摦嶌偺僼傿乕僪僶僢僋傕偱偒傞丅丂僇儊儔巔惃惂屼偺僒乕儃偩偗偼僇儊儔偲摨偠CPU偐傜惂屼偟側偄偲僩儔僢僉儞僌偱偒側偄丅丂僕儍僀儘傪偪偭偙偄CPU懁偵偮傔偽僕儍僀儘僼傿乕僪僶僢僋傕偱偒傞偺偩偗偳丄僒乕儃扨埵偱偟偐偱偒側偄偺偑栤戣偐側丅丅丅丂僒乕儃偺寢壥傪IK儗儀儖偱偼斀塮偱偒側偄偺偼偮傜偄偐側丅丅丂偁偭偲丄崌媍惂偺摦嶌偭偰偺偼偱偒側偄偺偐丅丅丂偆偆傓丅丅僟儊偐傕丅丅

傕偆偪傚偭偲峫偊傑偡丅丅丂(>_<)

仭俆寧俀侾擔仭

夋憸張棟傪専摙偡傞忋偱慾奞偵側偭偰偄傞偺偑儌僯僞乕夋憸丅

帺棩儘儃僢僩偩偐傜恖娫偑夋憸傪儌僯僞乕偡傞昁梫偼側偄偺偩偗偳丄奐敪抜奒偱偼儌僯僞乕偑側偗傝傖壗偑偳偆側偭偰傞偐偝偭傁傝傢偐傜側偄丅丂偦傟偱僇儊儔夋憸傪柍慄LAN墇偟偵PC偱儌僯僞乕偡傞傛偆偵偟偰偄傞偺偩偗偳丄偙傟偑憡摉側晧扴丅

彫偝偄夋憸側傫偩偗偳丄YUV夋憸傪埑弅偣偢偵憲偭偰偄傞偺偱丄64800byte乮180*120僪僢僩丄曄懃YUV僼僅乕儅僢僩側偺偱拲堄乯丂CDT夋憸偩偲1僺僋僙儖1byte偩偐傜21600byte丂CDT夋憸偼傑偩偟傕YUV夋憸傪11b偱憲傞偲寢峔側帪娫偑偐偐偭偰偟傑偆丅夋憸張棟側偳傪傗偭偰傞帪娫傕彊乆偵戝偒偔側傝偮偮偁傞偺偩偗偳丄儌僯僞乕偱帪娫偲傜傟偰偪傖偁巇曽偑柍偄丅丂

偱丄夋憸偼儌僯僞乕偟偨偄偑帪娫傪怘偄偨偔側偄丄丄偭偰偙偲偱丄儌僯僞乕梡偺儌僲儔儖夋憸傪憲傟傞傛偆偵偟傑偟偨丅丂峏偵彫偝偄90*60僪僢僩丒儌僲儔儖丂1僼儗乕儉5400byte丅丂偙傟側傜儌僯僞乕僨乕僞偺憲怣帪娫偼悘暘偲彫偝偔側傞丅

丂YUV夋憸丂丂丂丂

丂CDT夋憸丂丂丂丂

丂儌僲僋儘夋憸

夋憸張棟僾儘僌儔儉偺嶌傝傕丄偮偓偼偓忬懺偩偭偨偐傜峔憿懱傪嶌偭偰惍棟偟偨傝丄廳暋偟偰偄傞張棟傪嶍彍偟偨傝偱惍撢偟偨傝偟偰偨丅

丒丒丒丂偮傑傝丄乽夋憸僨乕僞偵傛傞庤愭嵗昗偺僐儞僩儘乕儖乿偭偰偺傪恑傔偨偔側偄傫偱偡偹乕丅丂側乕傫偐僴儅傝偦偆側梊姶丅丂僂傿乕僋僨乕偺拞搑敿抂側帪娫偵恑傔偰偄偄傕偺偐偳偆偐丅丅丂丂偆偅丄丄偦傫側偙偲尵偭偰偪傖偄偐傫偱偡偹丅丂柧擔丄憗偔婣傟偨傜恑傔傑偟傚偆丅丄丄偒偭偲丅丅

偁偭偲丄丄彫偝偄儌僲僋儘夋憸偩偲丄僼儗乕儉儗乕僩偼憡摉崅偔側傞丅偨偩偟丄崱擔偺偲偙傠偼儔儀儕儞僌張棟側偳傪傗傜偣偰側偄偺偱幚梡忋偺嬶崌偼傢偐偭偰傑偣傫丅僼儗乕儉儗乕僩傕應掕偟偰側偄偺偱懱姶偩偗偱偺榖偱偡偗偳偹丅

丂

栥乆偲峫偊偰傞RPU-100偺懕偒偼丄傗偭傁傝彫宆偺CPU偱僶僢僼傽傪宍惉偡傞曽岦偱峫偊傛偆偲巚偄傑偡丅丂儊僀儞CPU偐傜僒僽CPU傊偺僐儅儞僪憲怣廃婜偼50ms偐傜100ms偔傜偄丅偱偒傟偽僒乕儃傊偺僐儅儞僪廃婜偼10ms偔傜偄偵偟偨偄乮崱偼25ms乯丂僶僢僼傽傪壗僼儗乕儉嶌傟偽傛偄偐丄2杮偺UART偺旕摨婜摦嶌偭偰偳傫側姶偠偐丄晄柧揰偑懡偄偺偩偗偳丄偦傫側姶偠偱偄偄傫偠傖側偄偐側乕偲巚偄傑偡丅丂RPU-11傪夵憿偡傟偽幚尡偱偒傞偼偢偩偗偳丄ATmega128偺儅僀僐儞儃乕僪攦偍偆偐側丅

仭俆寧俀俁擔仭

崱擔偙偦偼偭偰偙偲偱丄挘傝愗偭偰婣偭偰偒偰乽夋憸僨乕僞偵傛傞庤愭嵗昗偺僐儞僩儘乕儖乿傪恑傔傑偟偨丅

偙傟偑弶婜忬懺丅CDT夋憸偺壓偺曽偵椉庤愭偑幨偭偰傑偡丅

丂丂

塃庤傪夋柺偺拞墰偵摦偐偣両丂偲僐儅儞僪傪憲偭偨偲偙傠丄丄丄

丂丂

娭愡妏搙偐傜寁嶼偟偨庤愭嵗昗偲僇儊儔嵗昗偺嵎偱僇儊儔偲庤愭偺嫍棧傪嶼弌偟丄僗僋儕乕儞忋偺庤愭偺埵抲偐傜尰嵼偺庤愭埵抲傪夋柺拞墰偵堏摦偝偣傞検傪寁嶼偟傑偡丅丂偦偟偰丄僇儊儔巔惃偐傜榬偺嵗昗宯偱偺堏摦曽岦偲堏摦検傪寁嶼偟偰丄摦偐偟偨偲偙傠偱偡丅

堄奜偲惛搙偑弌偨偺偱偪傚偭偲埨怱丅偙傟傪壗夞偐儖乕僾傪夞偣偽拞墰偵廂懇偡傞偼偢丅

傑偩丄儅僯儏傾儖偱偺憖嶌側偺偱憖嶌偑寢峔傔傫偳偔偝偄丅側偺偱丄偪傖傫偲寁嶼偱偒偰偄傞偐偺専徹偑偱偒偰傑偣傫丅丂柧擔偼儅僂僗偱庤愭偺堏摦愭傪巜帵偟偨傝僇儊儔巔惃傪傕偭偲戝抇偵曄偊偨応崌偱傕偪傖傫偲摦偔偙偲傪妋擣偟傑偟傚偆丅

仭俆寧俀俆擔仭

儅僂僗偱巜帵偟偨夋柺埵抲偵庤愭傪摦偐偡傛偆偵偟偰傒傑偟偨丅

曅庤偱僇儊儔帩偪側偑傜偺憖嶌側偺偱尒嬯偟偄夋憸偱偡丅丂偁偲丄PC夋柺傪嶣塭偡傞偲儌傾儗偑傂偳偔偰偄偐傫偱偡偹丅僗僋儕乕儞傪僉儍僾僠儍乕偟偰摦夋偵偡傞僣乕儖偑偁偭偨傛偆側丅丅

幚嵺偵偼崢傪偐偑傔偨傝墶傪岦偄偨傝偄傠傫側巔惃傪庢傝傑偡偑丄庱娭愡偺妏搙偐傜僗僋儕乕儞偑嬻娫忋偺偳偺曽埵傪偳偆偄偆妏搙偱塮偟偰偄傞偺偐偑傢偐偭偰偄傞偺偱嵗昗曄姺偟偰偄傑偡丅丂

崱偺偲偙傠偱偼夋柺偵庤偑塮偭偰偄側偄偲埵抲傪攃埇偱偒側偄偺偱僐儞僩儘乕儖偱偒傑偣傫丅丂摦夋忋偱儔儉僟偺庤愭偑彽偒擫傒偨偄側摦偒傪偟偰偟傑偆偺偼尐娭愡偺摦嶌斖埻傪挻偊偰偟傑偭偰偄傞偲偒偵旾偩偗偑摦偄偰偄傞偨傔偵僋僀僋僀僢偭偰姶偠偱摦偄偰偟傑偭偰偄傑偡丅摦嶌斖埻傪挻偊傞応崌偼崢傪夞揮偝偣傞側偳傪偟偰儕乕僠傪怢偽偡傋偒側傫偱偡偑丄傑偩偦偙傑偱偼幚憰偱偒側偄側乕丅丂埲慜偵幚憰偟偨崌媍惂偺儕乕僠儞僌傕偟傖偑傒崬傒僆儞儕乕偟偐幚憰偟偰側偄偺偱傑偩巊偊側偄丅

嶐擔偼峏偵丄儔儉僟傪棫偨偣偰崢傪偐偑傔偝偣偰彴偵偁傞儃乕儖傪抏偔摦嶌傪傗傜偣偰偄偨傫偩偗偳丄丄傓偢偐偟偄丄丄丅丂傕偆偪傚偭偲庤傪挿偔偟側偒傖側傜側偝偦偆丅丂偦傟傛傝傕忋敿恎偺巔惃偺娗棟偑側傫偩偐傓偪傖偔偪傖偱丄嶐擔偼偦偭偪偺曽偺僨僶僢僌偱憡摉帪娫傪偲傜傟傑偟偨丅丂傑丄徻嵶巇條偑寛傑傜側偄傑傑偵恑傔偰傞偺偩偐傜巇曽側偄偲偙傠傕偁傞偺偩偑丄丄丄偪傚偭偲恑傔傞偨傃偵抜乆傾儔偑偲傟偰偄偗偽偦傟偱偄偄偺偐側乕丅

丂

乽偝傜偽垽偟偒儖僷儞乿偵弌偰偔傞儘儃僢僩乽儔儉僟乿丅丂懌偼傑偀儉儕偲偟偰傕偁偺儉僇僨偺傛偆側榬傪嶌傝偨偄傫偩偗偳側偀丅丅傾僋僠儏僄乕僞偄偔偮偁偭偰傕懌傝側偄偟丅丅丅

惢嶌幰偺崢捝偝傫偺僒僀僩偱惢嶌婰傪尒傑偟偨丅丂丒丒丒偟偐偟丄傑偀丄儌僨儔乕偺挦傝曽偭偰偺偼偡偛偄偱偡丅偟偽偟尒擖偭偰偟傑偭偨丅丅

仭俆寧俀俇擔仭

榬偺摦嶌斖埻傪挻偊偨応崌偺張棟傪捛壛偟偰丄忋敿恎惂屼晹暘偺僐乕僪傪夵憿丅丂彽偒擫偼偟側偔側偭偨傫偩偗偳丄棫偪忋偑傝儌乕僔儑儞偑弌棃側偔側偭偰偟傑偭偨両丠

擸傫偱擸傫偱丄丄寢嬊丄儕乕僠儞僌偺崌媍惂僐乕僪偵僶僌偑愽傫偱偄傞偺傪栺24帪娫屻偵敪尒偟傑偟偨丅丂弶婜挷嵏偱巚偄崬傒偵傛傞尒岆傝偑偁傝丄俀乣俁帪娫嬤偔偼柍堊偵夁偛偟偰偟傑偭偨(>_<)

傗偼傝忋敿恎惂屼偵偼杺暔偑惐傫偱偄傞丅偭偰偄偆偐丄峴偒摉偨傝偽偭偨傝偺僐乕僨傿儞僌偑杺傪屇傫偱偄傞偺偩偑丅丅

榬偺摦嶌斖埻傪挻偊傞巜帵偑偁傞偲偦偙偱摦嶌偑巭傑偭偪傖偆傛偆偵偼偟偨偺偩偗偳丄偳偆偵傕榬偺摦嶌斖埻偑嫹偄丅丂榬傕抁偔偰丄崢傪偐偑傔偰彴偵偁傞傕偺傪怗傟傛偆偲偡傞偲摢偑嬤偯偒偡偓偰塭傪嶌偭偰偟傑偭偰偆傑偔側偄丅丂榬怢偽偟偪傖偆偐偀乣丅丂偁偲丄尐娭愡偺捈岎幉傪傗傔傛偆偐側丅丂偪傚偭偲偟偨僆僼僙僢僩側傜寁嶼傕偦傟傎偳暋嶨偱偼側偄偟丅

丂丂

側偱尐偵側傞偗偳丄偦傫側偵偍偐偟偔偼側偄丒丒傛偹丅丂僆僼僙僢僩晅偗傛偆両偲寛堄偟偨偺偑嶐擔偺侾俇丗俁侽偩偭偨偺偱丄岺嶌拝庤偼掹傔傑偟偨丅棃廡偺廡枛偵側偭偪傖偆側偀丅

丒丒丒側傜偽丄庤愭晹暘傕偮偄偱偵嶌傞偐丠丂晹昳揰悢懡偔側傞側傜傾儖儈愗敳偒僒乕價僗偵棅傫偠傖偆偐丠丂偳傫偳傫帪娫偑偐偐傞曽偵僔僼僩偟偰偄偔丂(^丅^)

仭俆寧俁侾擔仭

栘梛擔乣嬥梛擔偼嬨廈傊弌挘丅丂偦偟偰搚梛擔偺拫夁偓偵婣偭偰偒傑偟偨丅丂奜夞傝偺巇帠偠傖側偄妱傝偵偟傚偭偪傘偆弌挘偵偼峴偭偰傞偺偩偗偳丄攽傑傝偺弌挘偼媣偟傇傝丅偦傟傕俀攽丅丂嬥梛擔偺栭偼惙戝偵堸傒曕偄偰崱擔偼椺偵傛偭偰擇擔悓偄丅(^^乁丂擇擔悓偄偱旘峴婡偵忔傞偺偼嫲傠偟偐偭偨傫偩偗偳丄惾偵拝偄偨搑抂偵敋悋偟偰偨偺偱戝忎晇偱偟偨丅丂擇擔悓偄偱偺旘峴婡偼埲慜偵拞崙弌挘偵峴偭偨帪丄楢傟偑拝棨偺梙傟偱変枬偱偒偢偵儕僶乕僗丅婡撪偼垻旲嫨姭偺塓偵丄丄丄偲偼側傜側偐偭偨傫偩偗偳悘暘側巚偄弌偑偁傝傑偟偨丅

偆偪偵婣傞崰偵偼暅妶偟偰偄偨傫偩偗偳丄摢擼楯摥偟傛偆偲偡傞偲柊婥偵廝傢傟傞偺偱岺嶌偟偰傑偟偨丅

尐娭愡偺僽儔働僢僩偺夵憿丅

丂側偱尐儔儉僟

側偱尐偵側偭偨丅

丂尐娭愡偺壜摦斖埻偼峀偑傝傑偟偨丅

埲慜偺榬偩偲尐娭愡偼乽慜偵曧偊乿傑偱偟偐嬋偑傜側偐偭偨偺偱悘暘偲榬傪巊偄傗偡偔側偭偨偼偢丅

壜摦斖埻偑峀偑偭偨偺偼偄偄傫偩偗偳丄娭愡偑捈岎幉偠傖側偔側偭偨偺偱媡塣摦妛寁嶼偑傗傗偙偟偔側傝傑偟偨丅丂崱傑偱偼捈岎幉偩偭偨偺偱媡塣摦妛寁嶼偼夝愅揑偵夝偔帠偑偱偒傑偟偨丅丂崱搙偺娭愡峔憿偱傕旾偺傂偹傝妏偑側偗傟偽夝愅揑偵夝偗傞偺偩偗偳丄傂偹傝傪壛偊傞偲夝偗傑偣傫丅丂儎僐價峴楍傪巊偭偰夝偐側偄偲偄偐傫丅丂偲傝偁偊偢丄夋柺僨乕僞偱偺榬偺僐儞僩儘乕儖傪傗傞斖埻偱偼傂偹傝妏偼巊偭偰側偄偺偱夝愅夝傪巊偊傞偐傜丄丄偄偄偐丅

榬偺奜憰傕偪傚偭偲夵椙偡傟偽峏偵壜摦斖埻偑峀偑傝偦偆丅丂偱傕丄偙傟偔傜偄偱偄偄偐側乕丅

柧擔偼僗乕僾僇儗乕偺夛偵嶲壛偟偰偔傞偺偱擔拞偺嶌嬈偼偱偒側偄偹丅

仭俇寧侾擔仭

僗乕僾僇儗乕偺夛偵嶲壛偟偰偒傑偟偨丅丂丒丒丒丒偱傕丄丄廤崌応強娫堘偄傑偟偰奆偝傫偵柪榝偐偗偪傖偄傑偟偰丄僗僀儅僙儞偱偟偨乣丅丂愇愳偝傫丄懸偭偰偰傕傜偭偰怽偟栿側偐偭偨偱偡乕丅丂幚偼丄悘暘慜偵傾僀儃偺僾儘僌儔儉傪傗偭偰傞偙傠丄Open-R僇儞僼傽儗儞僗偱抦傝崌偭偨丄偲偁傞曽柺偱偼柵朄桳柤側崱偼偲偁傞夛幮偺戙昞庢掲栶偵側偭偰偄傞曽偺僽儘僌偱乽媑徦帥偺僗乕僾僇儗乕乿偭偰偺偑弌偰偒傑偟偰丄壗傪姩堘偄偟偨偺偐丄嶶嵿偝傫偍姪傔偺儅僕僢僋僗僷僀僗偑偦偺揦偩偲彑庤偵擼撪偱寛傔晅偗偰偨傒偨偄偱丄壗偺媈偄傕柍偔丄媑徦帥偵崀傝棫偭偰偟傑偭偨傫偱偡丅(>_<)丂僗乕僾僇儗乕偍偄偟偐偭偨偱偡丅乽煾炏乿傪棅傫偩傫偩偗偳丄恏偝愭峴偠傖側偔偰枴傢偄偑偁偭偰偳傫偳傫怘傋偪傖偄傑偟偨丅嵟屻偺曽偼椻傔偰偒偨傝偟偰偪傚偭偲恏偝偑懌傝側偄偐丠偲偐巚偭偪傖偄傑偟偨偑丄偁傟偔傜偄偑偍偄偟偔怘傋傜傟傞尷奅偐側乕偲丅

丂僠僉儞偺煾炏偺儈乕僩儃乕儖偲枴嬍僩僢僺儞僌丅丂煾炏偺恏偝偑傢偐傜側偐偭偨偺偱丄僩僢僺儞僌偼旕擄梡偵儅僀儖僪側偺傪慖傃傑偟偨丅

僗乕僾僇儗乕偺夛偑廔傢偭偰丄奺帺嶶傝嶶傝偵側偭偨傫偱偡偑丄憪壛偺僱僕嵳丄峴偙偆偐偳偆偟傛偆偐柪偭偨偗偳僷僗丅丂怴廻傪傉傜偭偲偟偰婣偭偰偒傑偟偨丅

側偱尐偵側偭偨儔儉僟偺丄榬偺IK寁嶼偲DK寁嶼偺惍旛偱偡丅IK寁嶼偵偮偄偰偼係娭愡僼儖懳墳偭偰偺偼偪傚偭偲戝曄側偺偱俁娭愡懳墳偺娭悢傪嶌偭偰偲傝偁偊偢偼偙傟偱OK丅DK寁嶼偼巔惃嶼弌偼曄峏側偄偺偱嵗昗嶼弌偩偗偼丄尐娭愡偺僆僼僙僢僩傪峫椂偟偨寁嶼偵偟偰姰椆丅

儌乕僔儑儞傊偺塭嬁側偳傪妋擣偟偰側偄側偀丅丂偟側偒傖丅

丂側偱尐偵側偭偰丄峏偵僈僠儍僺儞偵帡偰偒偨傛偆側丅丅丂僈僠儍僺儞偭偰僠儑乕側偱尐偩偭偨傛偹丠

僷儞僣柍偄曽偑側傫偐偄偄姶偠偑偡傞側丅丅丂僷儞僣傗傔偰暊姫偵偟傛偆偐側丅

仭俇寧俈擔仭

堦廡娫傇傝偺擔帍峏怴偱偡丅

崱廡偼弌挘傗傜堸傒夛傗傜巇帠傗傜偱悘暘朲偟偔偰丄堸傫偱婣傜側偔偰傕婣傞偺偑抶偐偭偨傝偱儘儃僢僩娭楢偺嶌嬈偼偝偭傁傝偱偒傑偣傫偱偟偨丅

傑偀丄偦偆偠傖側偔偰傕尐偵僆僼僙僢僩傪偮偗偰媡塣摦寁嶼偑夝愅揑偵偼夝偗側偄偲傢偐偭偨乮夝偗側偄偲敾抐偟偨丄偭偰偺偑惓夝偱偡偑乯偺偱儎僐價峴楍傪嶼弌偟側偒傖側傜側偄偲偐偪傚偭偲懌摜傒忬懺偱偁傞偺傕偨偟偐丅

懌摜傒偟偰偰傕巇曽側偄偺偱儎僐價峴楍偺嶼弌傪傗偭偰傒傞丅

儔儉僟偺榬偼4帺桼搙側偺偱丄倃丆倄丆倅丆兤乮兤偼庤愭偺傂偹傝乯偺4僷儔儊乕僞傪J1乣J4偺娭愡偱昞尰偡傞偙偲偵側傞丅

傑偢丄偙偺4僷儔儊乕僞傪J1乣J4偱昞偡偲丄

x = -cos(J2)cos(J3)sin(J4)al2 - sin(J2)cos(J4)al2 - sin(J2)al1

y = -cos(J1)sin(J3)sin(J4)al2 - sin(J1)sin(J2)cos(J3)sin(J4)al2 + sin(J1)cos(J2)cos(J4)al2 + sin(J1)cos(J2)al1 + sin(J1)ao1

z = -sin(J1)sin(J3)sin(J4)al2 + cos(J1)sin(J2)cos(J3)sin(J4)al2 - cos(J1)cos(J2)cos(J4)al2 - cos(J1)cos(J2)al1 - cos(J1)ao1

兤 = atan(sin(J3)cos(J2) / (cos(asin(sin(J4)al1 / l) - J4)cos(J3)cos(J2)

+sin(asin(sin(J4)al1 / l) - J4)sin(J2)))

偙傟傪旝暘偡傞偲丄

x' = -(-J2'sin(J2)cos(J3)sin(J4) - J3'cos(J2)sin(J3)sin(J4) + J4'cos(J2)cos(J3)cos(J4))al2 - (J2'cos(J2)cos(J4) - J4'sin(J2)sin(J4))al2 - J2'cos(J2)al1

y' = -(-J1'sin(J1)sin(J3)sin(J4) + J3'cos(J1)cos(J3)sin(J4) + J4'cos(J1)sin(J3)cos(J4))al2

丂-(J1'cos(J1)sin(J2)cos(J3)sin(J4) + J2'sin(J1)cos(J2)cos(J3)sin(J4) -

J3'sin(J1)sin(J2)sin(J3)sin(J4) + J4'sin(J1)sin(J2)cos(J3)cos(J4))al2

丂+(J1'cos(J1)cos(J2)cos(J4) - J2'sin(J1)sin(J2)cos(J4) - J4'sin(J1)cos(J2)sin(J4))al2

丂+(J1'cos(J1)cos(J2) - J2'sin(J1)sin(J2))al1 + J1'cos(J1)ao1

z' = -(J1'cos(J1)sin(J3)sin(J4) + J3'sin(J1)cos(J3)sin(J4) + J4'sin(J1)sin(J3)cos(J4))al2

丂+(-J1'sin(J1)sin(J2)cos(J3)sin(J4) + J2'cos(J1)cos(J2)cos(J3)sin(J4) -

J3'cos(J1)sin(J2)sin(J3)sin(J4) + J4'cos(J1)sin(J2)cos(J3)cos(J4))al2

丂-(-J1'sin(J1)cos(J2)cos(J4) - J2'cos(J1)sin(J2)cos(J4) - J4'cos(J1)cos(J2)sin(J4))al2

丂-(-J1'sin(J1)cos(J2) - J2'cos(J1)sin(J2))al1-(-J1'sin(J1))ao1

兤'=

偊偉偉偲丄丄atan( )偲偐asin( )偭偰旝暘偡傞偲偳偆側傞傫偩偭偗丠丠兤偺幃拞偵l(僄儖)偭偰偺偑偁傞偑丄偙傟偼sqrt(x^2+y^2+z^2)偱偁傞傢偗偩偐傜丄丄丄丂側傫偐偲傫偱傕側偄崁悢偺幃偵側傝偦偆偩側丅

偙偺兤偺幃偼丄尐娭愡偲庤愭傪寢傇慄傪幉偲偟偨帪偺傂偹傝妏搙傪昞偟偰偄傞丅丂尐巔惃傪婎弨偲偟偨傂偹傝偭偰偺偼捈姶揑偱偼側偄側偀偲偄偆偙偲偱偙偺昞尰傪巊偭偰偄偨偺偩偑旝暘偡傞幃偠傖側偄側偀丅

偳偆偟傛偆丅丅

仭俇寧俉擔仭

崱擔偺儎僐價偝傫

兤偺嶼弌幃偑旝暘偟偵偔偐偭偨偺偱丄尒捈偟傑偟偰偙傫側晽偵側傝傑偟偨丅

兤 = atan( cos(J2)sin(J3) / (cos(J2)cos(J3)cos(J4) - sin(J2)sin(J4)) )

嶐擔偺幃偼庤愭傪尨揰偲偟偨傕偺偩偭偨偺偩偑丄崱擔偺偼尐娭愡傪尨揰偲偟偨傕偺丅摍壙偐偳偆偐傢偐傝傑偣傫丅偳偭偪偐偑娫堘偊偰偄傞偐傕丅(^^乁

偙傟傪旝暘偡傞偲丄

兤'= ( (-J2'sin(J2)sin(J3)cos(J2)cos(J3)cos(J4) + J3'cos(J2)cos(J3)cos(J2)cos(J3)cos(J4) + J2'sin(J2)sin(J3)sin(J2)sin(J4) - J3'cos(J2)cos(J3)sin(J2)sin(J4)) - (-J2'sin(J2)cos(J3)cos(J4)cos(J2)sin(J3) - J3'cos(J2)sin(J3)cos(J4)cos(J2)sin(J3) - J4'cos(J2)cos(J3)sin(J4)cos(J2)sin(J3) - (J2'cos(J2)sin(J4)cos(J2)sin(J3) + J4'sin(J2)cos(J4)cos(J2)sin(J3)))) / ( (cos(J2)cos(J3)cos(J4) - sin(J2)sin(J4))^2 + (cos(J2)cos(J3)cos(J4) - sin(J2)sin(J4))^4 )

偱丄偙傟傜傪J1'偐傜J4'偺崁偱傑偲傔傞偺偱惍棟偡傞偲丄

x' = J1'(0)

丂+ J2'(sin(J2)cos(J3)sin(J4)al2- cos(J2)cos(J4)al2 - cos(J2)al1)

丂+ J3'(cos(J2)sin(J3)sin(J4)al2)

丂+ J4'(-cos(J2)cos(J3)cos(J4)al2 + sin(J2)sin(J4)al2)

y' = J1'(sin(J1)sin(J3)sin(J4)al2 - cos(J1)sin(J2)cos(J3)sin(J4)al2 + cos(J1)cos(J2)cos(J4)al2)

+ cos(J1)cos(J2)al1 + cos(J1)ao1)

丂+ J2'(-sin(J1)cos(J2)cos(J3)sin(J4)al2- sin(J1)sin(J2)cos(J4)al2 - sin(J1)sin(J2)al1)

丂+ J3'(-cos(J1)cos(J3)sin(J4)al2+ sin(J1)sin(J2)sin(J3)sin(J4)al2)

丂+ J4'(-cos(J1)sin(J3)cos(J4)al2- sin(J1)sin(J2)cos(J3)cos(J4)al2 - sin(J1)cos(J2)sin(J4)al2)

z' = J1'(-cos(J1)sin(J3)sin(J4)al2 - sin(J1)sin(J2)cos(J3)sin(J4)al2 +

sin(J1)cos(J2)cos(J4)al2 + sin(J1)cos(J2)al1 + sin(J1)ao1)

丂+ J2'(cos(J1)cos(J2)cos(J3)sin(J4)al2 + cos(J1)sin(J2)cos(J4)al2 + cos(J1)sin(J2)al1)

丂+ J3'(-sin(J1)cos(J3)sin(J4)al2 - cos(J1)sin(J2)sin(J3)sin(J4)al2)

丂+ J4'(-sin(J1)sin(J3)cos(J4)al2 + cos(J1)sin(J2)cos(J3)cos(J4)al2 + cos(J1)cos(J2)sin(J4)al2)

兤' = J1'(0)

丂+ J2'(-sin(J2)sin(J3)cos(J2)cos(J3)cos(J4) + sin(J2)sin(J3)sin(J2)sin(J4) + sin(J2)cos(J3)cos(J4)cos(J2)sin(J3) + cos(J2)sin(J4)cos(J2)sin(J3)) / ( (cos(J2)cos(J3)cos(J4) - sin(J2)sin(J4))^2 + (cos(J2)cos(J3)cos(J4) - sin(J2)sin(J4))^4 )

丂+ J3'(cos(J2)cos(J3)cos(J2)cos(J3)cos(J4) - cos(J2)cos(J3)sin(J2)sin(J4)

+ cos(J2)sin(J3)cos(J4)cos(J2)sin(J3)) / ( (cos(J2)cos(J3)cos(J4) - sin(J2)sin(J4))^2

+ (cos(J2)cos(J3)cos(J4) - sin(J2)sin(J4))^4 )

丂+ J4'(cos(J2)cos(J3)sin(J4)cos(J2)sin(J3) + sin(J2)cos(J4)cos(J2)sin(J3))

/ ( (cos(J2)cos(J3)cos(J4) - sin(J2)sin(J4))^2 + (cos(J2)cos(J3)cos(J4)

- sin(J2)sin(J4))^4 )

崌偭偰傞偐偳偆偐抦傜側偄偗偳丄堦墳偙傟偱儎僐價峴楍偼嶼弌偱偒傑偟偨丅

崱擔偺儎僐價偝傫偼偙傟偔傜偄偵偟偰丄尐僽儔働僢僩偵僆僼僙僢僩傪偮偗偨偙偲偱棫偪忋偑傝儌乕僔儑儞偺尒捈偟偑昁梫偐偺妋擣傪偟傑偟偨丅

僆僼僙僢僩偆傫偸傫偠傖側偔偰丄夋憸僨乕僞偱庤愭偺僐儞僩儘乕儖傪傗傞偲偒偵娭愡偺壜摦斖埻偺妋擣傗傜側傫傗傜傪捛壛偟偨偺偑塭嬁偟偰儌乕僔儑儞偑偆傑偔摦嶌偟傑偣傫丅(>_<)

偱丄怓乆偲挷惍偟偨偲偙傠丄懌偺弴塣摦妛寁嶼偑偍偐偟偄傜偟偄偙偲偑敪妎丅丂弴塣摦妛偭偰偨偩偺峴楍寁嶼側傫偩偗偳丄懌棤偑晜偄偨忋懱傗傜屢娭愡偺巔惃傗傜傪僒億乕僩偟偰偄偰悘暘偲暋嶨側寁嶼偵側偭偰偄傞丅丂偄傑傑偱偆傑偔峴偭偰傞偲巚偭偰偄偨偺偩偑丄妋擣偑娒偐偭偨傜偟偄丅

傑偨丄夞揮峴楍偲偺奿摤偑奐巒偝傟傞偺偩傠偆偐偀乣丄丄丄丂擸傑偟偄丅丅丅

丂

仈廐梩尨偺捠傝杺帠審丄傃傃傝傑偟偨丅丂偦傟偵偟偰傕嵟嬤偙偺庤偺帠審偑懡夁偓傞丅丂暔憶側悽偺拞偵側偭偨傕傫偩丅

丂

丂

丒丒丒丒丒嶶乆擸傫偩寢壥丄寁嶼崌偭偰傑偟偨丅orz 丂乽偙偆偄偆寁嶼寢壥偵偼側傜側偄偼偢両乿偭偰巚偭偰偨偺偑娫堘偄偱偟偨丅丅丅丅丂柍懯側帪娫傪旓傗偟偰偟傑偭偨偀乣丅(>_<)

2008.6.14丂悢幃偺娫堘偄傪敪尒偟偨偺偱掶惓偟傑偟偨丅

仭俇寧侾侽擔仭

忋敿恎偺娗棟偺惍旛偵偰偙偢偭偰傑偡丅丂屻夞偟屻夞偟偵偟偰偒偨僣働偑岠偄偰偒偨偐丅(^^乁

偱傕丄彊乆偵惍旛偼偱偒偰偒偰丄傕偆偡偖偆偮暁偣偐傜偺棫偪忋偑傝偑偱偒偦偆偱偡丅

偆偮暁偣偐傜偺棫偪忋偑傝偼堄奜偵傕丄忋敿恎偺惂屼偺柺搢側晹暘偑偨偔偝傫娷傑傟偰偍傝傑偟偨丅

儔儉僟偼婄偑忎晇偠傖側偄偺偱棫偪忋偑傞偵偼庤愭偱忋敿恎傪巟偊偹偽側傝傑偣傫丅丂偦偺偨傔丄庤愭傪嫻尦偵擖傟偰榬棫偰暁偣偺乽暁偣乿忬懺偺傛偆側巔惃偵側傞昁梫偑偁傞偺偱偡偑丄偙偺榬偺摦偒偑寢峔僋僙儌僲丅丂忋榬偺傂偹傝傪廫暘偵妶梡偟側偗傟偽側傝傑偣傫丅丂崱夞丄偙傟偼娭愡妏搙巜掕偵傛傞忋敿恎巔惃巜帵偺僐儅儞僪傪婲偙偟傑偟偨丅丂偄傑傑偱偼嵗昗巜帵偱媡塣摦妛寁嶼偱娭愡妏搙傪弌偟偰偄偨偺偩偗偳丄儎僐價孨傕傑偩偟偭偐傝偟偰偄側偄偟丄忕挿帺桼搙傪廫暘偵妶梡偟偨榬偺摦偒傪峴傢偹偽側傜偢丄尰忬偺媡塣搙妛巜帵偩偗偱偼昞尰偱偒側偄忬懺偱偡丅丂巇曽偑側偄偺偱娭愡妏搙巜帵偱揔摉側僼儗乕儉傪婲偙偟偰嵶偐側巜帵傪偟傑偟偨丅

師偵榬棫偰偺乽棫偰乿忬懺偵帩偭偰偔傞偺偩偗偳丄榬偱晜偒忋偑偭偨偺偱壓敿恎巔惃偑曄傢偭偰偟傑偄傑偡丅丂偙傟傪壓敿恎巔惃偵庢傝崬傒丄峏偵偦偺壓敿恎巔惃傪忋敿恎巔惃偵庢傝崬傓偲偄偆昁梫偑偁傝傑偟偨丅

師偵庤愭偺嬻娫嵗昗屌掕儌乕僪偺妶梡偱偡丅丂旼傪嬋偘偰偍怟傪帩偪忋偘偰乽傊偨偙偄偨乣乿巔惃偵帩偭偰偄偔偺偩偗偳丄庤愭偺愙抧埵抲偼曄傢傜偢偵壓敿恎偺摦偒偵捛悘偟偰庤偑摦偒傑偡丅

師偵崢傪姰慡偵懌偵忔偣傞埵抲傑偱堏摦偝偣傞偺偩偗偳丄傕偆庤愭嵗昗傪屌掕偟偰偄偰偼壜摦斖埻傪挻偊偰偟傑偆偺偱丄壓敿恎偑摦偒側偑傜傕丄庤愭嵗昗傪栚揑嵗昗偵摦偐偡偲偄偆偺傪傗傝傑偡丅丂偙傟偼偪傚偭偲旝柇偱丄丂尰忬偱偼庤愭嵗昗偲偄偆偺偼屢娭愡尨揰乮椉屢娭愡偺拞揰乯傪尨揰偲偟偨嵗昗偵側偭偰傑偡丅丂偙傟偼儘儃僢僩尨揰乮屢娭愡尨揰傪彴柺偵搳塭偟偨揰丄偨偩偟丄僆僼僙僢僩側偳偑0偱偁傞慜採乯偵偡傋偒偐側偀偲巚偭偨傝偟偰柪偭偰傞偲偙傠偱偡丅丂偙傟偐傜嶌傞傾僾儕働乕僔儑儞偵傛偭偰偼儘儃僢僩尨揰偐傜偺嵗昗巜帵偵偟偨曽偑偄偄偐傕偟傟側偄丅

偦傫側偙傫側偱傕偆偪傚偭偲偱惍旛偝傟偨忋敿恎娗棟懱惂偱偆偮暁偣偐傜偺棫偪忋偑傝偑偱偒偦偆側姶偠偱偡丅

偪側傒偵庱偺僱僕僸儏乕僘偼偲傫偠傖偭偰庱偼僽儔僽儔忬懺偱偡丅(乕乕;)

仭俇寧侾侾擔仭

偍偐偘偝傑偱怴忋敿恎娗棟懱惂偺尦偱偆偮暁偣偐傜偺棫偪忋偑傝偑偱偒傞傛偆偵側傝傑偟偨丅丂傑偩婔偮偐晄枮偑偁偭偰丄偳偆傗偭偰夝徚偡傋偒偐峫偊拞偱偡丅

棫偪忋偑偭偨偺偱偡偑丄慁夞偐傜捈恑曕峴偵愗傝懼偊傞偲丄巔惃敾掕偑偆傑偔峴偐偢丄墑乆偲巔惃廋惓傪峴偍偆偲偟偰偟傑偄傑偡丅偙偺曈傝丄傑偩怴懱惂偵側偠傫偱偄側偄晹暘偑偁傞傛偆偱傑偩傑偩僨僶僢僌偼懕偒偦偆偱偡丅(>_<)

偝偰丄儎僐價孨偺懕偒偱偡偑丄儎僐價峴楍偑弌棃偨偺偱丄師偵偙傟傪巊偭偰媡塣摦妛寁嶼傪偡傞偨傔偵儎僐價峴楍偺媡峴楍傪寁嶼偟側偗傟偽側傝傑偣傫丅

n亊値峴楍偺媡峴楍偼妛峑偱廗偭偨偺偱娙扨偵寁嶼偱偒傞偺偩偗偳丄儎僐價峴楍偺奺崁傪揥奐偡傞偺偼嬸偲偄偊傞偱偟傚偆丅偙偙偐傜偼僾儘僌儔儉忋偱幚嵺偺抣傪戙擖偟偰寁嶼偡傞傋偒偐偲巚偄傑偡丅

偟偐偟丄丄丄丂偲偭偪傜偐偭偰偰壗傗偭偰傞偐敾傜側偔側偭偰偒偨側偀乣丅忋敿恎娗棟偺尒捈偟傗儎僐價峴楍偱偺媡塣摦妛偑偱偒偨傜壗偡傟偽偄偄傫偩偭偗丠丠丠

仭俇寧侾俀擔仭

係師偺惓曽峴楍偺媡峴楍丅丅丅

偵偮偄偰

偺偲偒A偺媡峴楍偑懚嵼偟偰

偨偩偟

娙扨偠傖乕側偄偹丅僾儘僌儔儉彂偄偪傑偆偐丅丂偄傗丄儀僞彂偒偱寁嶼偩側丅丂僄僋僙儖偱専徹偟傛偆偐偲巚偭偨偗偳丄捈愙儔儉僟偱傗偭偨曽偑偄偄偐側偀乣丅憹暘偺戝偒偝偲惛搙偺娭學傪尒偨偐偭偨偺偩偗偳丅丅

仭俇寧侾係擔仭

儎僐價峴楍傪巊偭偨媡塣摦妛寁嶼傪傗偭偰傒傑偟偨丅

僌儔僼拞偵彫暥帤偺x y z r 偲丄戝暥帤偺X Y Z R丂偲偁傝傑偡偑丄彫暥帤偑儎僐價峴楍偺媡峴楍傪巊偭偰寁嶼偟偨娭愡妏搙偐傜弴塣摦妛偱嶼弌偟偨嵗昗偲忋榬偺傂偹傝妏搙丅丂戝暥帤偑儎僐價峴楍偺媡峴楍偵梌偊偨庤愭嵗昗偲忋榬傂偹傝妏搙偱偡丅丂偙偺僌儔僼偩偲戝偒側岆嵎傕柍偔栚昗嵗昗傊堏峴偟偰偄傑偡丅

嵗昗偲忋榬傂偹傝妏搙傪曄偊傞偲丄丂搑拞傑偱偼弴挷側偺偩偑丄屻敿偱棎傟偑偱偰偟傑偆丅丂戝暥帤偺僌儔僼傕棎傟偰偄傞偺偼丄僗僥僢僾偛偲偵嵟怴偺娭愡妏搙偐傜嵗昗偲傂偹傝妏搙傪嵞愝掕偟偰偄傞偨傔丅丂偦偆偟側偄偲岆嵎偑戝偒偔側傝丄偆傑偔寁嶼偱偒側偔側偭偰偟傑偆丅

偆傑偔峴偔働乕僗偲偙偆偟偰棎傟偰偟傑偆働乕僗偑偁傞丅寁嶼夞悢傪憹傗偟偰嵎堎傪彫偝偔偟偰棎傟偑廂傑傞働乕僗傕偁傟偽丄忋偺働乕僗側偳偼夞悢傪憹傗偡偲棎傟偑戝偒偔側偭偰偟傑偭偨傝偡傞働乕僗傕偁傞丅丂偙偙傑偱偔傞偺偵儎僐價峴楍偺嶼弌幃偺娫堘偄傪偄偔偮偐傒偮偗偨偺偱丄傑偩悢幃忋偺儈僗偑偁傞偺偐傕偟傟側偄丅

堦墳偼堦捠傝悢幃偺尒捈偟傪偟偨偺偩偑丄傕偆娫堘偄偼尒偮偗傜傟側偐偭偨丅丂棎傟偰偟傑偆働乕僗偑偳偆偄偆応崌側偺偐偪傚偭偲傢偐傜側偄偺偱偙偺傑傑偱偼儔儉僟偵慻傒崬傓偙偲偑弌棃側偄偱偡偹丅

儎僐價峴楍傪巊偭偨媡塣摦妛寁嶼偺応崌丄偨偲偊偽偡偽傗偄摦嶌傪偝偣偨偔偰丄侾僗僥僢僾偱戝偒偔摦嶌偝偣偨偄応崌偱傕丄撪晹揑偵偼憡墳偺夞悢偺寁嶼傪偟側偗傟偽惓偟偄娭愡妏搙偼摼傜傟側偄乮偼偢乯丅丂庤懌偺傛偆偵巊偆偵偼傕偭偲専摙偑昁梫偱偡偹丅

偙偺寢壥傪尒偰丄傗偭傁娭愡偼捈岎幉偟偐側偄偐偀乣偲傕巚偭偨偑丄偙偺愭娭愡偑憹偊偰偄偗偽偳偆偟偨偭偰夝愅揑側夝朄偱媡塣摦妛寁嶼幃偑摼傜傟側偔側傞丅丂偦偺偲偒偺庤抜偑儎僐價峴楍側偺偐偳偆偐偼傢偐傜側偄偑丄側偵偐庤抜傪峫偊偹偽側傜側偄偺偩傠偆丅丂偮傑傝偼捈岎幉偵偙偩傢傞偺偑惓偟偄巔偱側側偄偺偩傠偆偲巚偄傑偡丅

偦傟偵偟偰傕儎僐價峴楍偼偡偽傜偟偄丅偄傑傑偱寁嶼傪娙扨偵偡傞偨傔偵儔儉僟偺娭愡峔憿偼捈岎幉偵偟偰偒偨丅傑丄偦偺偍堿偱儎僐價峴楍傪巊偭偨媡塣摦妛寁嶼傪傗偭偰傒偨偺偼崱夞偑弶傔偰偩偭偨偺偩偑丄嫵壢彂傪撉傓偩偗偠傖側偔偰墘廗偟偰傒傟偽偡偽傜偟偝偺姶偠曽傕堘偭偰偔傞偲偄偆傕偺丅

仾栚昗巔惃偵懳偟偰儕僯傾偵摦嶌偝偣偨応崌偺娭愡妏搙偼傕偪傠傫儕僯傾偵偼側傜側偄丅儎僐價峴楍傪巊偭偰嶼弌偟偨娭愡妏搙偺僌儔僼偑伀偙傟丅

僼傽儞僞僗僥傿僢僋偱偡丅

仭俇寧侾俆擔仭

儔儉僟偺崱偺庤愭偼壖偺巔偱丄嵟廔揑偵偼偪傖傫偲儌僲傪偮偐傔傞傛偆偵偟傛偆偲峫偊偰偄傑偡丅偱偒傟偽僸儏乕儅僲僀僪傜偟偄庤傪偮偗偨偄偺偩偗傟偳丄彴偺儌僲偑廍偄忋偘傜傟傞偺偑戞堦忦審丅丂偝傜偵偼偙偗偨帪偺庴恎偱庤傪拝偔偙偲傪峫偊傞偲傗傢側峔憿乮亖暋嶨側峔憿乯偼僟儊丅

彴偺儌僲偑廍偄忋偘傜傟傞偭偰偺偼偨偩廍偊傞偩偗偠傖側偔偰丄儔儉僟偺僇儊儔偱帇擣偟側偑傜廍偄忋偘傞摦嶌偑偱偒側偒傖僟儊偭偰偙偲側偺偱偪傚偭偲忦審偑尩偟偄丅

偦偆偄偆傢偗偱寛傔偁偖偹偰偄偨偺偩偑丄偲傝偁偊偢偼岓曗嘆偱嶌偭偰傒傞偙偲偵偟傑偟偨丅

僇僯庤偱偡丅丂庴恎偺偙偲傪峫偊偰摦偔偺偼慜懁偵偟傑偟偨丅偩偐傜僇僯偺偼偝傒偲偼媡偱偡丅乮偲彂偄偰偐傜乽儂儞僩偐側丠乿偲巚偭偰挷傋偨傜媡偠傖側偐偭偨丅乯掶惓丅奍偲堦弿偱偡丅儘儃僢僩偺儅僯僺儏儗乕僞偼晛捠偼恊巜偑摦偔姶偠偱丄夋憸偺忬懺偩偲嵍塃偵偼偝傒偑奐偔峔憿偑懡偄偱偡偑丄儔儉僟偼乮夋憸偺忬懺偱乯忋壓偵奐偔峔憿偵偟偰傒傑偟偨丅

偙傟偵偼棟桼偑偁偭偰丄彴偵偁傞儌僲傪廍偍偆偲偟偨偲偒丄忋懱傪偐偑傔偰庤傪嵎偟怢傋傞偺偩偑丄榬偼儌僲偵懳偟偰墶偐傜嵎偟崬傓傛偆側姶偠偱庤傪嬤偯偗偰偄偔偙偲偵側傞丅榬偺帺桼搙偑廫暘偱偼側偄儔儉僟偺榬偱儌僲偵懳偟偰傾僾儘乕僠偡傞偲偒丄庤愭偺巔惃偼尷傜傟傞丅丂奍庤偺奐暵曽岦偑嵍塃偩偲丄彴偺儌僲偺壓偵庤傪嵎偟崬傓傛偆偵偟側偗傟偽側傜偢丄廍偄忋偘傞偺偵幐攕偡傞妋棪偑崅偄偩傠偆丅傑偨丄奐偄偨庤傪嬤偯偗傞偲庤偱儌僲偑塀傟偰偟傑偆壜擻惈傕崅偔丄傗偼傝幐攕偟偦偆丅

杮摉偼僴僒儈偺傛偆偵偳偪傜偺巜傕摦偔傛偆偵偟偨偐偭偨偺偩偗偳丄揮搢帪偺庴恎偵懴偊傜傟傞嫮搙傪帩偨偣傞偵偼壜摦巜偠傖柍棟偭偰偙偲偱夋憸偺傛偆側峔憿偵偟傑偟偨丅

僒乕儃偼FUTABA偺RS301丅丂堦墳偼僩儖僋僐儞僩儘乕儖傕弌棃傞偟丄妏搙偺庢摼傕偱偒傞偐傜埑椡僙儞僒乕偲偐偮偗側偔偰傕儌僲傪偮偐傫偩偙偲傪姶抦偱偒傑偡丅

偙偺庤偺僒僀僘偠傖偀偮偐傔傞傕偺偼偨偐偑偟傟偰傑偡偗偳偹乕丅(^^乁

斅嬥偼UMIE偝傫偺傾儖儈愗敳偒僒乕價僗偵偍婅偄偟傑偟偨丅僒僀僘揑偵偼1僔乕僩偩偲偪傚偭偲懌傝側偔偰丄儘儃僩儅偺僒僀僘偑偄偄傫偩偗偳丄儘儃僩儅偼憲偭偰傕傜偊側偄偺偱巊偊傑偣傫偱偟偨丅偙偺晹昳偺嬋偘偭偰晛捠偺嬋偘婡偠傖嬋偑傜側偄偺偱丄晹昳庢傝偵峴偭偰婣偭偰偐傜嬋偘壛岺偭偰側偭偪傖偆偺偼偪偲恏偄丅

仭俇寧侾俈擔仭

巚偄婲偙偣偽儘儃價儕儎乕僪偱丄僞乕僎僢僩偵嬤偯偄偰丄僞乕僎僢僩傪庤偱挼偹旘偽偡摦嶌傪偝偣傛偆偲偟偰丄僇儊儔偱懆偊偨儌僲偵庤愭傪怢偽偡偭偰帠傪偝偣傛偆偲偟偨傜榬偺壜摦斖埻偑嫹偄傕傫偩偐傜丄尐偺僽儔働僢僩偵僆僼僙僢僩傪偮偗偨偲偙傠偑丄媡僉僱偑儎僐價峴楍傪巊傢側偔偪傖側傜側偔側偭偨傝丄棫偪忋偑傝儌乕僔儑儞偑偍偐偟偔側偭偨傝偟偰忋敿恎偺娗棟曽朄偺尒捈偟傗傜儎僐價峴楍偺専摙傗傜傪偟偰偄偨偺偩偭偨丅

婥偑偮偔偲儅僯僺儏儗乕僞偺峔憿愝寁偲偐傗偭偰偰丄丄丄婑傝摴偟偡偓偱偡丅(^^乁

崱擔丄儅僯僺儏儗乕僞偺僣儊偺奐暵偵巊偆RS302乮301偠傖側偔偰302偩偭偨乯偺斀懳幉偮偒儃僩儉働乕僗偲僼儕乕儂乕儞偑撏偒傑偟偨丅偁偲偼斅嬥偑愗傝敳偐傟偰撏偗偽儅僯僺儏儗乕僞偺惢嶌偵庢傝妡偐傟傑偡丅丂侾俀倁傪俈V偵棊偲偡儗僊儏儗乕僞傕嶌傜側偒傖側傜側偄偗偳丅丅丅

丂

僆僼僙僢僩晅偒尐僽儔働僢僩偱偺媡僉僱傕偱偒偰乮儎僐價偠傖側偄曽丅傂偹傝側偟丅乯丄棫偪忋偑傝儌乕僔儑儞傕偱偒偨偺偱媣偟傇傝偵儃乕儖傪捛偄偐偗偝偣偨傝庤愭傪夋憸僨乕僞偱摦偐偟偨傝偡傞僾儘僌儔儉傪摦偐偟偰傒偨傝偟傑偟偨丅丂庤愭傪夋憸僨乕僞偱偭偰曽偼側傫偩偐慜傛傝埵抲偺嵞尰惈偑偄偄姶偠丅丂側偤偩丠

傾僾儘乕僠摦嶌偼丄憡曄傜偢栚昗偑墶偵偦傟偨応崌偺摦嶌偑偆傑偔峴偭偨傝偄偐側偐偭偨傝丅丂側偤偑媡曽岦偵慁夞傪巒傔偨傝偡傞丠丠丂傕偪傠傫僾儘僌儔儉傪尒捈偟偰偄側偄偐傜偍偐偟偐偭偨晹暘偑捈偭偰傞偼偢偼側偄傫偩偗偳丄敾掕婎弨偭偰側傫偩偭偗丠朰傟偰偟傑偭偨丅(^丒^)

偁偲丄丄丄乮偩傫偩傫巚偄弌偟偰偒偨(^_^;)丂乯丂僞乕僎僢僩偵嬤偯偄偰崢傪偐偑傔偨忬懺偱庤愭傪尒幐偭偰偟傑偆傫偩偭偨丅丂偙傟偼僇儊儔偺儂儚僀僩僶儔儞僗偲偐CDT僥乕僽儖抣偺挷惍傪偟偰傒側偔偪傖側傜側偄丅丂奜岝偺嬶崌偱怓擣幆偵曄壔偑弌偰偟傑偆偺偼傑偢偄偱偡傛偹丅丂僆乕僩僠儏乕僯儞僌偱偒側偒傖側偀丅丂側傫偐偄偄曽朄側偄偩傠偆偐丅

仭俇寧侾俉擔仭

傾僾儘乕僠偺偨傔偺峴摦寛掕偵偮偄偰峫偊傑偡丅

傾僾儘乕僠偡傞偲偒丄僞乕僎僢僩偵懳偟偰曕偄偰嬤偯偔偺偐丄慁夞偟偰僞乕僎僢僩偺曽岦傪岦偔偺偐丄戝偒偔暘偗偰擇偮偺慖戰巿偑偁偭偰丄偳偪傜傪慖戰偡傋偒偐偲偄偆敾抐偑昁梫偱偡丅

娙扨偵峫偊傞偲丄儘儃僢僩偺惓柺傪拞怱偲偟偨嵍塃偺偁傞斖埻偺妏搙偵僞乕僎僢僩偑娷傑傟傟偽捈恑丄傑偨偼僇乕僽曕峴偱嬤偯偒丄偦傟傛傝傕妏搙偑戝偒偗傟偽慁夞偟偰僞乕僎僢僩偺曽妏傪岦偔偲偄偆偙偲偑峫偊傜傟傞丅

偱偡偑丄偙傟偩偲僞乕僎僢僩傑偱偺嫍棧偑嬤偄応崌丄敿宎偺彫偝側僇乕僽曕峴傪慖戰偟偰偟傑偄丄晄埨掕側曕峴偲側偭偰偟傑偆丅

側傜偽丄嫍棧偵墳偠偰敾掕偺妏搙傪曄偊傟偽偄偄偺偩偑丄嫍棧傪壗抜奒偵暘偗傟偽偄偄偺偐丠側偳偺栤戣偑弌偰偔傞丅傑丄偦傟偔傜偄偼挷惍偡傟偽偄偄榖側偺偩偑丄偳偆傕庯枴偵崌傢側偄丅

敿宎偑彫偝側僇乕僽曕峴傪慖戰偡傞偲偄偆偙偲偼丄僞乕僎僢僩偵岦偐偭偰戝偒偔夞傝崬傓儖乕僩傪慖戰偡傞偲偄偆偙偲偵側傞丅偱偼丄偦傟傪敾抐婎弨偵偟偰偼偳偆偐丠

僞乕僎僢僩傑偱偺嫍棧傗曽埵傪峫偊傞偺偱偼側偔丄僞乕僎僢僩偵岦偐偭偰僇乕僽曕峴傪峴偭偨応崌丄偳傟偔傜偄偺妏搙傪僇乕僽曕峴偱曕偔偙偲偵側傞偺偐丠偙傟偑偁傞抣傛傝傕戝偒偔側傞応崌偼慁夞傪慖戰偡傟偽偄偄傫偠傖側偄偐丅丂偙傟偩偲敾掕抣偼堦偮偵側偭偰偡偭偒傝偡傞丅

僞乕僎僢僩偑偛偔嬤偔偵偁傞応崌丄曽埵偱敾抐偡傞偲偆傑偔峴偐側偄偙偲偑懡偄傛偆側婥偑偡傞偺偱丄偙偺曽偑偄偄偐側乕偲巚偄傑偡丅丂崱擔帋偟偨偐偭偨偺偩偗偳丄僞僀儉傾僂僩偱帩偪墇偟丅丂柧擔偐傜偟偽傜偔偼儔儉僟偵娭傢傟側偄偐傕偟傟側偄偺偱偳偆偟偨傕傫偐側乕丅(乕乕;)

仭俇寧俀俁擔仭

娭搶慻儘儃僢僩楙廗夛偵峴偭偰偒傑偟偨丅

嶶嵿偝傫偲偙傠偱徯夘偝傟偰偄傞傫偱偡偑丄僔僌儅偱偡丅伀

棫偭偰傑偡偗偳傑偩曕偄偰傑偣傫丅丂嶐擔丄楙廗夛応偱儌乕僔儑儞嶌傠偆偲巚偭偰偨傫偩偗偳丄媡僉僱娭悢偑傗偭偲嶌傟偨偩偗偱偟偨丅偱傕丄巚偄偺傎偐岲昡偱偪傚偭偲傃偭偔傝偟傑偟偨丅丂傕偲傕偲丄拵椶偲偐偺懡懌偺惗暔傗僇儊傒偨偄側儊僇僯僇儖側惗偒暔偑岲偒偱丄儊僇儌偲偐梸偟偔偰巇曽側偐偭偨乮攦偭偰傕傜偭偨傜堄奜偵偟傚傏偔偰偑偭偐傝偟偨傝偟傑偟偨偑乯僋僠側偺偱丄偙偆偄偆僞僀僾偺儘儃僢僩岲偒偱偡丅

偱丄儔儉僟傪嶌偭偰丄儔儉僟偑傝偭傁側俀嵨帣偵側傞傑偱偼懠偺儘儃僢僩偼嶌傜側偄傛偆偵搘椡偟偰偄偨偺偩偗偳丄偮偄偵偲偆偲偆庤傪弌偟偰偟傑偄傑偟偨丅丂杮摉偼偙傟偵傕嫤椡側CPU傪嵹偣偰帺棩偵岦偐偄偨偄偲偙傠側傫偩偗偳丄偦傟偙偦廂廍偑偮偐側偔側傞偺偱偟偽傜偔偼儔僕僐儞偱偄偙偆偐偲巚偭偰傑偡丅

偙偄偮偺峴偔枛偼傢偐傜傫偺偱偡偑丄偲傝偁偊偢僥乕儅偼晄惍抧曕峴丅丂儘儃僇僢僾偵弌偰偔傞儗僗僉儏乕儘儃傛傝偼偄偄摦偒傪偝偣偨偄側偀偲巚偭偰傑偡丅傕偪傠傫偦傟偼偱偐偄CPU愊傫偱偐傜偺偙偲偱偟偽傜偔偼暯抧偩偗偱梀傇偮傕傝偱偡丅

嶶嵿偝傫偑彂偄偰偨俁杮偢偮懇偹偰俀懌偵偡傞丄偭偰偺偼杮婥偱偟偰丄娭愡偺僀儞僺乕僟儞僗惂屼偵嬤偄傕偺偑偱偒側偄偐傪幚尡偟偰傒傞偮傕傝偱偡丅丂傑偀偙傟偼嶌偭偨偐傜偮偄偱偵偭偰姶偠偑嫮偄偱偡偗偳偹丅

崱擔偙偦偼曕偒弌偡偐偲巚偭偨偺偩偗偳丄婣傞偺偑抶偔側偭偨偺偱傑偨偟偰傕帩偪墇偟丅丂巆擮偱偡丅丂傎傫偲偵丅丅

仭俇寧俀係擔仭

崱擔偙偦偼僔僌儅傪曕偐偣傞偨傔偵憗偔婣傠偆偲栚榑傫偱偄偨偺偩偑丄巇帠偑側傫偩偐戝曄側偙偲偵側偭偰偟傑偭偰抶偔側偭偰偟傑偭偨(>_<)

偩偑偟偐偟丄俇懌偼僶儔儞僗偲偐峫偊側偔偰傕儌乕僔儑儞傪婡夿揑偵嶌傟偽曕偗傞偺偱偟傖偐偟傖偐偟傖偐偭偲嶌偭偰慜恑偲屻戅偼偱偒傞傛偆偵側傝傑偟偨丅懌偺墲暅嫍棧傪亇30儈儕偵偟偰1廃婜偺帪娫偑0.4昩偵偟偰丄僈僣僈僣僈僣僈僣偲曕偔傛偆偵側傝傑偟偨丅丂曕暆偼傕偭偲峀偘傜傟偦偆偱偡偹丅

偦傟偵偟偰傕懪偪崬傒偱儌乕僔儑儞嶌傞偭偰戝曄(乕乕;)丂傗偭傁憗偔偱偐偄CPU愊傫偱寁嶼偱曕偐偣偨偄偱偡丅丂崱夞偼扨弮側曕梕側偺偱偳偆傕儅僔儞偭傐偄丅俁懌1僙僢僩偺僋儘乕儔曕梕偱傕摦偐偟偰傒偨偄偺偩偑丄懪偪崬傒偠傖丒丒丒柍棟偱偡丅傔傫偳偔偝偄丅丅丅

丂

偱丄傢傫偩傎乕偵弌偨偄側偀偲慜夞偐傜巚偭偰偨傫偩偗偳丄崱夞偙偄偮傪峏偵夵憿偟偰SIGMA-BIPER乮壖乯偲偟偰擇懌曕峴偱偒傞傛偆偵偟偰弌応偡傞偙偲傪峫偊偰偍傝傑偟偨丅側偺偵側偺偵崱擔偺擔帍偺朻摢偵彂偄偨傛偆偵巇帠偑戝曄側偙偲偵側偭偰偟傑偭偰丄丄丄丂俀俋擔偺俋帪偛傠偼拞崙偵弌挘拞(>_<)丂丒丒丒丂巇帠拞偐傕丅丂塣偑傛偗傟偽巇帠偑廔傢偭偰偄偰儂僥儖偐傜弌応怽偟崬傒偱偒傞偐傕偟傟側偄傫偩偗偳丄丄丄丂傆偅丅

柧屻擔憗挬偐傜惉揷傊岦偐偄傑偡丅丂崱廡偼儘儃僢僩偼懪偪巭傔偩側偀丅丅丂偟傚傏傫丅丅

仭俇寧俀俆擔仭

柧擔偺弌挘偺弨旛傪偝偭偝偲嵪傑偣偰僔僌儅偺儌乕僔儑儞嶌偭偰傑偟偨丅

嶐擔偲偍傫側偠挷巕偱墶曕偒偲慁夞傪嶌偭偰僐儞僩儘乕儔偵妱傝摉偰丅丂偱丄摦偐偟偰傒偨傫偩偗偳丄丄丄丄丂側傫偐丒丒柺敀偔側偄偱偡丅丂崱擔偼曕暆傪戝偒偔偟偰偪傚偭偲廃婜傪棊偲偟偰傒偨傫偩偗偳丄敆椡側偄偟丄丄摦偒傕扨挷偩偟乣丅丂僈僒僈僒偭偰憗偔摦偐偟偰偙偦偺僋儌宆側傫偩側乣丅

夋憸偺忋懁偵岦偐偭偰恑傫偱偄傑偡丅

憗偔忋敿恎嶌偭偰側傫偐偱偒傞傛偆偵偟側偒傖側乕丅

偱偼丄拞崙傊偄偭偰偒傑乣偡丅

仭俇寧俀俋擔仭

拞崙弌挘偐傜栠偭偰偒傑偟偨丅

怴偟偔嶌偭偨僔僌儅傪俀懌曕峴儘儃僢僩偵夵憿偟偰傢傫偩傎乣偵弌傞偮傕傝偩偭偨偺偱偡偑丄偳偆傗傜嬤偄偆偪偵傑偨拞崙偵峴偒偦偆偩偟丄偦偆側傞偲儘儃僢僩偺恑捇傕婜懸偱偒偦偆偵側偄偺偱丄崱夞偼弌応傪掹傔傞偙偲偵偟傑偟偨丅丂傗偼傝摉弶偺栚揑偳偍傝儔儉僟偱帺棩偱弌応傪栚巜偟偨曽偑偄偄偺偐側乣丅

拞崙偱偼庢堷愭偱偺巇帠偩偭偨偺偱偡偑丄梉怘偼僠儍僀僯乕僘儗僗僩儔儞偱怘帠偵楢傟偰峴偭偰傕傜偄傑偟偨丅丂擔杮偱怘傋傞拞壺偲偼挷枴椏偑堘偆偺偱惓捈偪傚偭偲嬯庤側偺偱偡偑丄傑偀嫿偵擖傜偽嫿偵廬偊偲偄偆偙偲偱偍偄偟偔偄偨偩偒傑偟偨丅

拞崙偺儗僗僩儔儞偼惗偗馀偑抲偄偰偁偭偰丄怘嵽偑慖傋傞傛偆偵側偭偰傑偡丅僄價偲偐偼傑偩偄偄傫偱偡偗偳僔儍僐偲偐偼寢峔僌儘偄傫偱偡傛偹丅乮儅儗乕僔傾偵峴偭偨帪偼僇僽僩僈僯偑偆傛偆傛偲惗偗馀偵偄偨側偀丅丅乯丂偦傫側拞丄寢峔捒偟偄怘嵽偑暲傋偰偁傝傑偟偨丅

丂僗僢億儞偱偡偹乣丅丂擔杮偱傕惗偗馀偱塲偄偱傑偡丅

丂摨偠僇儊偱傕嫢朶側儚僯僈儊丅丂姎傑傟傞偲巜偑旘傃傑偡丅丂偙傟傕怘嵽偱偡丅

丂偪傚偭偲敾傝偵偔偄偗偳丄僿價丅丂傆偭偲偄乣丅丂怘嵽偱偡丅

丂奜偺惗偗馀偵偼僒儊偑丅丅丅丂怘嵽偱偡丅

丂偊偊偲丄丄丄丂怘嵽偱偡丅丂(>_<)

僋僠偼價僯乕儖僥乕僾偱偖傞偖傞姫偒偵側偭偰傑偟偨丅丂

摨峴偟偨崄峘挀嵼俁擭偺宱尡傪帩偮恖偺榖偩偲傕偭偲偄傠傫側偊偖偄怘嵽傪尒偨偦偆偱偡偑丄丂偝偡偑4偮懌側傜偽僀僗埲奜偼怘傋傞偲尵傢傟偨偍崙暱丅丅丂偙傟偔傜偄偼彉偺岥偺傛偆偱偡丅(^_^;)

仭俇寧俁侽擔仭

偙偙傫偲偙怓傫側壽戣傪嶶傜偐偟曻戣偩偭偨偺偱丄媣偟傇傝偵儘儃傟傞忬懺偵側偭偨偵傕娭傢傜偢丄壗偐傜庤傪偮偗偰偄偄傗傜敾傜傫忬懺偵側偭偰偟傑偄傑偟偨丅

幚偼儔儉僟偺僒乕儃傪偤乕傫傇僼僞僶偝傫偵憲偭偰僼傽乕儉傾僢僾偟偰傕傜偆梊掕側傫偱偡偗偳丄僆僽僕僃僋僩傪僩儔僢僉儞僌偟偰傾僾儘乕僠偟偰庤偱僞僢僠偡傞偭偰偲偙傠偑壚嫬側傕傫偩偐傜屻夞偟偵偟偰偄傞偺偱偡丅丂偱丄偄偄姶偠偵僇僞偑拝偄偨僞僀儈儞僌偱僒乕儃傪憲偭偰僼傽乕儉傾僢僾偟偰傕傜偭偰傞娫偵僔僌儅傪巇忋偘傞偲丄偦偆偄偆墦戝(^_^;)丂側寁夋偩偭偨偺偩偗傟偳丄偳偆偵傕傾僾儘乕僠偑偆傑偔峴偐側偄丅丂擔帍傪撉傒曉偡偲俇寧侾俉擔偐傜楙廗夛偵僔僌儅傪帩偭偰偄偔偨傔偵晜婥偟偰丄偦偺傑傑儌乕僔儑儞嶌惉偵擖偭偪傖偭偰丄偝傜偵媫偵拞崙弌挘偵側偭偰崱擔偵摓傝傑偡丅丂峏偵偼儅僯僺儏儗乕僞傕傾儖儈偺愗傝敳偒傑偱弌棃偰偄傞偺偵曻抲忬懺丅

偱丄婥傪庢傝捈偟偰傗偭傁傝侾俉擔偺懕偒偭偰偙偲偱傾僾儘乕僠偺夵椙偵庢傝慻傫偱偄傑偟偨丅

偟偐偟丄偳偆傕偆傑偔峴偐側偄丅丂儘僌傪庢偭偰僨僶僢僌偟傛偆偵傕忣曬偑懡偡偓偰側偵偑偳偆側偭偰傞偺偐偝偭傁傝夝愅偱偒側偄忬懺偵側偭偰偟傑偭偨丅

晛捠偵曕偐偣傞偲傂傚偙傂傚偙偲偁傞掱搙偼埨掕偟偰曕偔傫偩偗偳丄傾僾儘乕僠傪偝偣偰曕偐偣傞偲敾抐偑擖傞偣偄傜偟偄偺偩偑丄搑抂偵曕峴偑晄埨掕偵側傞丅丂1曕曕偔偛偲偵僇乕僽曕峴偺曕峴敿宎傪愝掕偟側偍偟偰偄傞偺偑傛偔側偄偺偐丠丂張棟帺懱偑廳偔偰僒乕儃傊偺僐儅儞僪僞僀儈儞僌偑嫸偭偰偟傑偭偰傞偺偐丠丂崻杮揑偵側偵偐娫堘偊偰偄傞偺偐傕偟傟側偄側偀乣丅(>_<)

丂僔僌儅偵廝傢傟偨儔儉僟丅丂拠娫偠傖側偐偭偨傜偟偄丅丅

仭俈寧侾擔仭

偲傝偁偊偢僔僌儅傪傗偭偮偗偪傑偍偆丄偲偄偆偙偲偱丄崱擔偼僔僌儅偺儌乕僔儑儞傪嵞嶌惉丅

偙側偄偩嶌偭偨帪傛傝憗偄摦偒偱慜恑屻戅嵍塃堏摦慁夞丂傪偱偒傞傛偆偵偟傑偟偨丅丂偱傕丄傗偭傁傝俇杮懌偩偲埨掕偟偰摦偔偺偱柺敀偔側偄丅丂寢峔岆嶼偩側乣丅丂偙偄偮偼埆楬曕峴偝偣傞偟偐妝偟傒曽偑側偄偐傕偟傟側偄側偀丅丂懌偑6杮傕偁傞偺偱懌偺摦偒偱怓傫側億乕僘傗巔惃傪庢傟傞偺偩偑丄儌乕僔儑儞嶌惉偭偰戝曄偱偡偹乕丅丂摲懱偺埵抲傪曄偊偨曕峴傪嶌傠偆偲巚偭偨傜偦偺儌乕僔儑儞傪嶌傝捈偝側偒傖側傜側偄傢偗偱丄丄丂6杮懌曕峴偙偦媡僉僱偱傗傞傋偒傕偺偩側偲巚偄傑偟偨丅

僔僌儅傪俀懌儘儃偵偡傞偲偒偼伀偙傫側姶偠偵偟偰懌棤偱俁杮偺懌傪偮側偖丅

丂僔僌儅傪棫偨偣偨偲偙傠

傎傏媴宍側偺偱丄丄

丂揮偑偭偨偲偙傠

揮偑傝傑偡丅

廳怱偑曃偭偰傞偺偱尦偵栠傟側偄偱偡偑丅(^_^;)

丂

儔儉僟偱帺棩宯偺僾儘僌儔儉偺専摙偟偰偄傞偲偒偼偡偖偙偗偨傝旼偑擬偱僟儊偵側偭偰偟傑偆偺偑暊偩偨偟偐偭偨傝偡傞偺偩偑丄僔僌儅傪摦偐偟偰偄傞偲丄晄埨掕姶偑柍偄偺偱僴儔僴儔姶偑柍偄丅偙傟偼偙傟偱暔懌傝側偄丅丂偆偅乣傫丅丅丂柍偄傕偺偹偩傝偩側丅

RPU-10偵儌乕僔儑儞傪巇崬傫偱僐儞僩儘乕儔偱摦偐偡偭偰偺傪巒傔偰傗偭偰傒偨偺偩偑丄RPU-10偺昗弨僾儘僌儔儉偭偰旕椡夁偓傑偣傫偐偹丅丂懠偺傪偟傜側偄偺偱側傫偲傕尵偊側偄傫偩偗偳丄巇崬傔傞儌乕僔儑儞偑彮側偡偓傞丅僐儞僩儘乕儔偺慻傒崌傢偣偱儌乕僔儑儞敪摦偲偐偑偱偒側偄丠丂R偲偐L偲偐傪墴偟側偑傜堏摦偝偣傞偲崅懍偱曕偔儌乕僔儑儞偑婲摦偡傞偲偐丄丂傾僫儘僌僗僥傿僢僋傪搢偡妏搙偱儌乕僔儑儞偺嵞惗懍搙偑曄傢傞偲偐偭偰偱偒側偄偺偑晛捠側偺偐側丠丂帪娫儕儞僋偲偐偭偰偺偑偦傟偐丠丂儅僯儏傾儖撉傫偱傕僀儅僀僠僀儊乕僕偑捦傔側偄丅

丂

丒丒丒柧擔偙偦偼儔儉僟偺傾僾儘乕僠偺僨僶僢僌傪丅丅丅

仭俈寧俆擔仭

擔帍偼彂偄偰側偐偭偨偗偳丄偪傚偙偪傚偙偲儔儉僟偺僨僶僢僌偼恑傔偰傑偡丅恑捇偼偐偽偐偟偔側偄偗偳丅

崱擔偼搚梛擔丅丂僨僶僢僌偺懕偒傪偟傛偆偐側偲巚偭偰傒偨偑丄偢偭偲婥偵側偭偰偄傞儅僯僺儏儗乕僞偺慻傒棫偰傪傗傞偙偲偵丅丂儂儞僩偼偙傟丄僒乕儃傪僼傽乕儉傾僢僾偵弌偟偰偄傞娫偵傗傠偆偲巚偭偰偄偨傫偩偗偳丄岺嶌偼媥擔偺屵屻偺偄偄偍戣偱偡丅僨僶僢僌傗傞偺偑僀儎偱偮偄傗偭偰偟傑偄傑偟偨丅

丂僇僯庤偺儅僯僺儏儗乕僞丅丂寢峔婃忎偵偱偒傑偟偨丅

傕偆椉庤偲傕偱偒偨偗偳丄夋憸偼嵍庤偩偗弌棃偨偲偒偺傕偺丅丂攚宨偵塃庤偺晹昳偑幨偭偰傞丅(^_^;)

僣儊偺奐暵偼RS302CD偵斀懳幉儃僩儉働乕僗傪偮偗偰傑偡丅丂傑偩攝慄偱偒偰側偄偐傜摦偐側偄偗偳丅丂庤愭偵晅偗偨儅乕僋偑側偔側偭偰偟傑偭偨偺偱儅乕僋傕偮偗側偒傖丅丂儅乕僋傪偮偗傞偵偼搒崌偺埆偄宍偵側偭偰偟傑偭偨丅

RS302CD偵斀懳幉儃僩儉働乕僗傪偮偗傞偵偼僐僱僋僞偺僴僂僕儞僌偐傜堦搙慄傪庢傝奜偝側偄偲働乕僗偺寠傪捠偡偙偲偑偱偒傑偣傫丅丂偙偺僔儕乕僘偭偰RS485側偺偱4慄偁傞傫偩偗偳丄崟2杮偲奃怓2杮丅丂偒偭偲摨偠崟偱傕儅乕僋偑堘偆偲偐偱敾傞傛偆偵側偭偰偄傞傫偩傠偆偲巚偭偰丄僒僋僢偲奜偟偰偟傑偭偨傫偩偗偳丄傕偆堦偮偺僒乕儃偺働乕僽儖偲斾傋偰傕慄偺儅乕僋偑摑堦偝傟偰偄側偄(>_<)丂側傫偩偙傟偼偀丠丠丂寢嬊儃僩儉働乕僗傪奜偟偰攝慄偺崻尦偐傜妋擣偟偰僴僂僕儞僌偵廂傔傑偟偨丅丂僥僗僞乕偱偁偨傜側偔偰傕敾傞傛偆偵偟偰梸偟偄側偀丅

柧擔偺儘儃儚儞僒僢僇乕偺寛彑偼丄塅拡戝夛梊慖栚摉偰偱峴偙偆偐側乣偲巚偭偰偄傞傫偩偗偳丄傑偩柪偄拞丅丂塅拡戝夛梊慖偼2帪敿偐傜偐偀乣丄偱傕峴偔側傜挬偐傜偩傛側偀丅丅

仭俈寧俇擔仭

儘儃儚儞僒僢僇乕娤偵峴偭偰偒傑偟偨丅丂杮摉偺栚揑偼塅拡戝夛梊慖偺尒妛偩偭偨偺偱丄拫斞傪怘傋偰偐傜弌敪丅丂搑拞丄庣岇楈偑幾杺傪偡傞偐偺傛偆偵丄嫗昹搶杒慄偐傜傝傫偐偄慄偵忔傝姺偊傞偺偵昳愳傑偱峴偭偰偟傑偭偨傝乮昳愳忔姺偊偩偲巚偭偰偨乯丂傝傫偐偄慄偱実懷僎乕儉偟偰偨傜壗傪巚偭偨偐搶嫗僥儗億乕僩偱崀傝偰偟傑偭偨傝丄傏偗傏偗偱偟偨丅

塅拡戝夛梊慖丄儗僊儏儗乕僔儑儞偑側傫偩偐尩偟偡偓傞姶偠偑偡傞傫偱偡偗偳丄KAZZ偝傫偺儘儃僢僩偑戞堦搳偱惉岟両丂傃傃傝傑偟偨丅丂妋偐偵壓敿恎偑屌掕偱忋敿恎偑俋侽搙夞揮偟偰乽儘儞僟乕僩乿晽偭偰偺偼傾儗偱偡偑丅丂塅拡戝夛偵偼偁傑傝嫽枴偑柍偔偭偰丄廳偝偲偐戝偒偝偺儗僊儏儗乕僔儑儞偑幾杺偱僩儔僀偡傞婥偑婲偒側偄偺偩偑丄搳偘儘儃帺懱偵偼嫽枴偑偁傞丅丂儗僊儏儗乕僔儑儞柍帇偟偰搳偘偰傕拝抧偡傞儘儃僢僩偭偰偺傪峫偊偰傒偨偄側偲巚偄傑偟偨丅丂僔僌儅偵張棟擻椡偑偱偐傔偺CPU傪嵹偣偰傗偭偰傒傛偆偐側丅

僒僢僇乕尒偰偰巚偭偨偺偼僀僈傽偝傫偺僒傾僈偺婡摦椡丅丂揮偑傞儃乕儖傛傝偼憗偔摦偗偰傑偟偨丅偡偽傜偟偄偱偡丅丂偦傟偵僋儘儉僉僢僪丅丂偡偽傗偄摦偒偺忋偵僗儘乕僀儞偱偺墦搳傕偟偭偐傝弌棃偰傞偟丅丂偔傁傁偝傫偼堦懱偳傟偔傜偄偺帪娫傪儘儃僢僩偵旓傗偟偰偄傞傫偩傠偆丅

丂

婣偭偰儔儉僟偺僨僶僢僌傪傗傠偆偲偟偨傫偩偑丄偙側偄偩偐傜偪傚偭偲婥偵側傞偙偲偑丅丂側傫偩偐僙儞僒乕儃乕僪乮僕儍僀儘偲G僙儞僒乕乯偑斀墳偟偰偄側偄愡偑丅丂偄偮傕儌僯僞乕偟偰偄傞傢偗偠傖側偔丄僨僶僢僌懳徾偱傕側偐偭偨偺偱乽崱搙挷傋傛偆乿掱搙偵巚偭偰偄偨偺偩偑丄偪傚偭偲挷傋偰傒偨丅

儔儉僟偼僗僺乕僔乕僘儘儃僢僩偑尨宆側偺偱僙儞僒乕儃乕僪偼僗僺乕僔乕僘儘儃僢僩偺僙儞僒乕儃乕僪傪偦偺傑傑巊偭偰偄傞丅丂LED偺岝傝曽偑偄偮傕偲堘偆偺偱儅僯儏傾儖傪堷偭挘傝弌偟偰傒傞偲丄丄丂僼傽乕儉彂偒姺偊儌乕僪偵側偭偰偄傞丠丠丠丂側偤偩偀丠丂偮偄偙側偄偩傑偱惓忢偵摦偄偰偄偨偺偵側傫偐僲僀僘偑忔偭偰儌乕僪偑愗傝懼傢偭偨偺偐丠

岺応弶婜愝掕偵栠偡偭偰憖嶌傪傗偭偰傒偨偑傑偭偨偔曄壔側偟丅丂巇曽偑柍偄偺偱偙傟偼僗僺乕僔乕僘偵栤偄崌傢偣丅丂懡暘憲傝曉偟偰僼傽乕儉傪彂偒捈偡側偳偺張抲偑昁梫偵側傞傫偩傠偆側丅丂偙傟傪婡夛偵儔儉僟傪偽傜偟偰僒乕儃傪憃梩揹巕傊憲傞偙偲偵偟傛偆丅

儔儉僟偺傾僾儘乕僠婳摴寁嶼偼偳偆傗傜OK偺傛偆丅丂崱搙偼偙偺寁嶼寢壥傪敾掕偵棙梡偟偰傾僾儘乕僠偝偣傞丅丂偙傟偼僒乕儃偑栠偭偰偒偰偐傜偵側傞偐側乕丅

仭俈寧俈擔仭

崱栭偼嬶崌偺埆偄僙儞僒乕偲奿摤偟偰偟傑偄惉壥側偟丅(>_<)

儃乕僪偑攋懝偟偰偄傞傢偗偠傖側偝偦偆側偺偱丄僼傽乕儉傪擖傟傟偽捈傞偼偢丅丂僙儞僒乕僨乕僞偺庢摼廃婜傪忋偘偨偄側偲偐峫偊偰偄偨偺偱偙傟傪婡夛偵僙儞僒乕儃乕僪傪嶌傠偆偐側偲偐峫偊偨偑丄傑偨婑傝摴偑堦偮憹偊偰偟傑偆偺偱帺弆丅丂慺捈偵儊乕僇乕偵憲偭偰捈偟偰傕傜偆偙偲偵偟傑偡丅

傕偆傕偆偡偖偵偱傕儔儉僟傪暘夝偟偰僒乕儃傪憲傝偨偄偺偱丄嵟屻偵傾僾儘乕僠偺摦嶌妋擣傪偡傞丅

寢壥偼傑偀傑偀椙岲丅丂奣偹偍偐偟側摦嶌偼偟側偔側偭偨傛偆偵姶偠傞丅丂偦傟傛傝栤戣偼旼僒乕儃偑偡偖偵擬偱棊偪傞偙偲偲丄傾僾儘乕僠張棟傪捛壛偡傞偲張棟偑捛偄偮偐側偔側傞偙偲丅

偙傟偼抳柦揑丅丂崱偼僨僶僢僌拞偱丄telnet偵張棟忬嫷偺僨乕僞傪偽傫偽傫憲傝懕偗偰偄傞偐傜偦偺偨傔偵張棟僆僠偟偰偄傞偲巚傢傟傞丅

僒乕儃偑栠偭偰偒偨傜偦偺曈傕崌傢偣偰専徹偟偰峴偙偆丅丂偳偪傜偵偟偰傕NetBSD偐傜儕傾儖偵僒乕儃僨乕僞傪憲傞偺偼尷奅偭傐偄丅丂僒僽CPU傪愊傫偱僶僢僼傽傪宍惉偡傞寁夋傪恑峴偝偣偹偽側傜側偄偩傠偆丅

偝偰丄柧擔偼偲偆偲偆儔儉僟傪暘夝丅丂偙傟偑偄偮傕備偆偆偮側傫偩傛偹偉乣丅丂偪傖傫偲慻傒棫偰傜傟傞偺偐側(>_<)

仭俈寧俉擔仭

俈寧俇擔偺擔帍偵岆傝偑偁傝傑偟偨丅丂KAZZ偝傫偺塅拡戝夛梊慖偱偺巔惃惂屼側偺偱偡偑丄忋敿恎偑夞揮偟偰偄傞偺偱偼側偔丄壓敿恎傪俋侽搙傂偹偭偰拝抧偟偰偄傞偺偱偟偨丅丂夛応偱儕傾儖偵尒偨偲偒偼壗偑偳偆側偭偨偺偐惓捈敾傜側偐偭偨偺偱偡偑丄價僢僌儃僗偑乽偁傟偼偪傚偭偲側傫偩偗偳丄丄乿揑側昞尰傪偟偰偄傑偟偰偺偱丄峫偊偨枛偵忋敿恎偑夞揮偟偨傫偩傠偆側偀偲巚偭偰彂偄偰偟傑偄傑偟偨丅掶惓偟偰偍榣傃偄偨偟傑偡丅

偱傕丄偡傞偲丄丄丂旕偺懪偪強柍偔婯掕墘媄偩偭偨偺偱偼側偄偐偲巚偆偺偱偡偑壗偑婥偵擖傜側偐偭偨偺偱偟傚偆偐丠丂ROBOTWATCH偺崅懍搙嶣塭摦夋傪尒側偑傜峫偊偨偺偱偡偑丄傕偟偐偟偰丄庤偑棧傟傞慜偐傜壓敿恎偺摦嶌偑巒傑偭偰偄偨偲敾掕偟偨偺偐丠丠丂偄傗丄摦夋傪尒傞尷傝偱偼庤偑棧傟傞傑偱儘儃僢僩偼摦偄偰偄側偄傛偆偵偟偐尒偊傑偣傫丅丂傫乣丄傢偐傜傫側丅

丂

儔儉僟傪暘夝偡傞慜偵嵟屻偺僨僶僢僌嶌嬈丅丂偱傕丄嶐擔偼偆傑偔峴偭偨偲巚偭偰偄偨傾僾儘乕僠摦嶌偼傑偩専摙晄廫暘丅丂婄傪愻偭偰弌捈偟偰偒傑偡丅(>_<)

丂庤懌偺奜憰傪奜偟偰摲懱偲婄偩偗奜憰丅丂偙偭偪尒偰傞傢偗偠傖側偔僇儊儔曈傝偵偁傞僺儞僋儃乕儖傪尒偰傞丅(^丅^)

僶僉儏乕儉偱嶌偭偨奜憰偼偁偪偙偪傏傠傏傠偵側偭偰傑偡丅丂嶌傝曽偲偐傕偆偪傚偭偲峫偊側偒傖側丅

丂僒乕儃傪奜偟偨偲偙傠丅丂婄偼RS301偲偐302側偺偱崱夞偼懳徾奜丅

偙偭偐傜壓偼帺暘梡偺儊儌丅

丂丂

丂丂偆偅丄丄偙偭偪傕僺儞儃働偩丅

榬偺僒乕儃妏搙僛儘偺巔惃偼偙傫側偺丅丂丂丂丂丂懌庱偼偙偺忬懺傪嶌偭偰偐傜師偺慻傒棫偰偵恑傓偙偲丅丂僒乕儃屌掕僱僕傪嵎偟崬傫偱偍偔偙偲傪朰傟側偄傛偆偵両

仭俈寧侾侾擔仭

僒乕儃偑憲傝曉偝傟傞傑偱偵僔僌儅傪RPU-100偱摦偐偟偰傒傛偆両丂側傫偰巚偭偰偄偨傜偡偖偵僒乕儃偑憲傝曉偝傟偰偒偨丅丂偄傗丄憃梩揹巕揳丄恦懍側懳墳傪偁傝偑偲偆偛偞偄傑偡丅<(_ _)>

憗懍慻傒棫偰丅丂僒乕儃偼岺応弌壸忬懺偵側偭偰偄傞偺偱捠怣懍搙偼115200bps ID偼慡晹1丅丂偦傟偧傟偵ID偲捠怣懍搙傪愝掕偟偰丄

丂榬丄懌丄摲懱偑偦傟偧傟姰惉両

丂崌懱両

偙傟傪婡偵働乕僽儖傪嶌傝捈偦偆偲巚偭偰偄傞偺偱崱擔偼攝慄側偟丅

偝偰丄僒乕儃偺僼傽乕儉傾僢僾偺惉壥偼偳偆傗偭偰妋擣偟傛偆偐側乕丅

仭俈寧侾係擔仭

偙偺搚擔偼儘儃僢僩偺恑捇偼傑偭偨偔側偟丅

偲偄偆偺傕丄侾俀擔偺栭偐傜晉巑嶳搊嶳偵弌敪丅丂侾俁擔偺偛棃岝傪攓傒偵峴偭偰偒傑偟偨丅

幚偼搊嶳偺椶偼傑偭偨偔偺弶怱幰偱嶳偵搊傞偭偰偄偆偺偼拞妛惗偺崰偵嬤偔偺敨暁嶳乮恄屗巗恵杹嬫乯偵柍慄婡傪攚晧偭偰徃偭偰埲棃偺偙偲丅丂傑偀惗偒偰偄傞偆偪偵堦搙晉巑嶳偵偼搊偭偰偍偒偨偄側偀偲巚偭偰偄偨偲偙傠丄夛幮偺桳巙偱晉巑搊嶳偑婇夋偝傟偰偄偨偺傪嬼慠偵抦偭偨偺偱悓偭偨惃偄偱嶲壛昞柧偟偪傖偄傑偟偨丅

側傫偲偐帺暘偺懌偱搊偭偰婣偭偰偒傑偟偨偗偳丄晉巑搊嶳偭偰側偐側偐僴乕僪偱偡偹乕丅丂偳偆傗傜搊偭偨恖偼偨偔偝傫偄傞傛偆偱丄夛幮偱乽崱搙晉巑嶳偵搊傞乿偭偰尵偭偨傜寢峔側妋棪偱懱尡択傗拲堄帠崁傪揱庼偝傟傑偟偨丅

嬃偄偨偺偼搊嶳摴偺戝廰懾丅丂栭捠偟偐偗偰搊偭偰嶳捀偱挬擔傪攓傓偭偰朶嫇偵側偤偵偙傫側偵偨偔偝傫偺恖偑廤傑偭偰偄傞偺偐丠丂廰懾偵姫偒崬傑傟偨偣偄傕偁傝偛棃岝偼嬨崌栚夁偓偨曈傝偱攓傓偙偲偵側偭偰偟傑偄傑偟偨偑丄揤婥偵偼宐傑傟偰偡偽傜偟偄岝宨傪尒傞偙偲偑偱偒傑偟偨丅

偁偲丄搊嶳搑拞偵尒偨枮揤偺惎嬻丅丂偒傟偄偩偭偨側乣丅姶摦偟傑偟偨丅

偙偺宨怓傪尒傞偨傔側傜傕偆堦搙搊偭偰傕偄偄偐側偀丒丒偭偰帺暘偵栤偄偐偗偨偗偳枹偩曉帠側偟丅(^_^;)

仭俈寧侾俈擔仭

侾俆擔偼嶳棞傊弌挘丅丂侾俇丄侾俈擔偼嬨廈傊弌挘丅丂崱擔偼嵅悽曐偐傜婣偭偨偺偩偑丄偁偪傜傪弌敪偟偨偺偑3帪敿偱丄壠偵偮偄偨偺偑10帪丅丂6帪娫敿傕偐偐傞傫偩偀乣丅

婣偭偰儊乕儖僠僃僢僋偡傞偲僗僺乕僔乕僘偐傜僙儞僒乕儃乕僪偺恌抐寢壥偑棃偰偄偨丅丂側傫偐怓乆彂偄偰偁偭偨偑棟夝晄擻偩偭偨偺偩偗偳丄梫偼夡傟偰偄傞偺偱桳彏廋棟乮偲偄偆偐儃乕僪傪怴婯峸擖偟偰偔傟乯偲偄偆偙偲傜偟偄丅

偦傟偵偟偰傕偁傫側傕偺偑僴乕僪揑偵夡傟傞傕傫側偺偐側偀丠丂愨懳夡傟側偄傢偗偼側偄偑丄夡傟傞傛偆側僗僩儗僗傪偐偗偨妎偊偼側偄偺偩偑丅丅丂栠偭偰偒偨傜儅僀僐儞儃乕僪偲偟偰傾僋僙僗偟偰傒傛偆丅

怓乆晄枮偑偁傞儃乕僪傪傑偨攦偆傢偗偵傕偄偐側偄偺偱丄傗偼傝僙儞僒乕儃乕僪傪嶌傞偙偲偵側傝偦偆偩丅偮偄偱偲偄偭偰偼側傫偩偑丄僙儞僒乕儃乕僪偲側傞儅僀僐儞儃乕僪偵僒乕儃偺帪暘妱僨乕僞偺僶僢僼傽傪嶌傝丄儕傾儖僞僀儉惈傪妋曐偡傞偭偰偺傕傗傠偆偐偲巚偆丅

嶐擔丄堸傫偱婣偭偨傜乮屵慜俀帪偛傠乯側偤偐晹壆偺揹摂偑偮偐側偄丅嶐栭偼PC婘偵偮偄偰偄傞僗億僢僩儔僀僩偱梡傪嵪傑偣偨偺偩偑崱栭傑偱偵壗偲偐偣偹偽側傜側偄丅丂偲偄偆偐拫娫傕晹壆偑埫偄偺偼偄傗側偺偱揹摂傪偮偗傞偐傜揹摂偑揰偐側偄偲崲傞丅丂寀岝摂偑愗傟偨傢偗偠傖側偔偰揹摂帺懱偑夡傟偨傛偆側偺偱屵慜拞偵儎儅僟揹婡偵怴偟偄揹摂傪攦偄偵峴偭偨丅丂揹摂偼偡偖偵攦偭偨偺偩偑丄偦偆偄傗僨僕僇儊丅丅丅丂僨僕僇儊偺僗僀僢僠偑庻柦偺傛偆偱側偐側偐僗僀僢僠偑擖傜側偄偺偩丅堦搙擖傞偲崱搙偼愗傟側偄偟丅丂傑丄娙扨偵尵偆偲夡傟偰偄傞丅戙傢傝偺僨僕僇儊傪攦傢側偒傖側偀丄丄偲偟偽傜偔僨僕僇儊攧傝応偱暔怓丅丂偁丄偦偆偄傗偙側偄偩偺搳偘儘儃偱妶桇偟偰偨崅懍嶣塭偱偒傞僨僕僇儊丄僇僔僆偺乽EX-F1乿惓捈偙傟丄梸偟偄偱偡丅丂僐儗傪巊偆偨傔偵搳偘儘儃巒傔傛偆偐側乕偲偐巚偆偔傜偄丅

杮婥偱梸偟偄偗偳丄偙傟偼偍傕偪傖偩側乕丄幚梡揑偵偼実懷偵曋棙側僐儞僷僋僩僨僕僇儊偑乮壠懓梡偲偟偰乯昁梫丅丂偱傕丄僨僕僇儊偺巊偄曽偑廤崌幨恀傪嶣傞傛傝傕摦偒偺偁傞夋柺傪嶣傞応崌偑懡偄偺偱僐儞僷僋僩僨僕僇儊偠傖偆傑偔側偄偙偲偑懡偄偺偩丅丂偡傞偲僨僕僞儖堦娽儗僼丅丂偙傟傕偢偭偲梸偟偄傫偩傛偹丅僇儊儔庯枴偠傖側偄偗偳幚梡偱堦娽儗僼攦偍偆偐側乕丄偱傕僐儞僷僋僩僨僕僇儊傕梫傞偟丄堦娽儗僼偲僐儞僷僋僩攦偭偨忋偵EX-F1偼攦偊側偄傛側偀乣偝偡偑偵丅丅丂剔绿蘼丅丅

偲偄偆偙偲偱崱擔偺屵慜拞偑廔傢偭偰偟傑偄傑偟偨丅寢嬊僨僕僇儊偼儁儞僨傿儞僌偱丅(^_^;)

丂

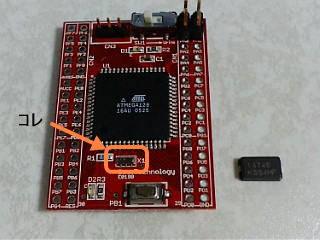

崱擔偙偦偼儘儃僢僩偺恑捇傪丄偲偄偆偙偲偱傗傝偨偄儊僯儏乕偼偨偔偝傫偁傞傫偩偗偳丄僙儞僒乕儃乕僪偑夡傟偨偙偲偑婲場偟偰ATMEGA128儅僀僐儞儃乕僪傪RPU-100偵偮側偘傞偭偰偺傪恑傔傛偆偐側丅

偱丄攦偭偰偍偄偨儀僗僥僋偺ATMEGA128儃乕僪傪庢傝弌偟偰傒傞偲丄丄丂偑偀乣傫乢(仢o仢)乛両丂敪怳婍偑傓偪傖彫偝偔側偭偰傞両

攦偭偰偁偭偨敪怣婍偼丄偪傚偭偲僨僇傔偩偗偳ATMEGA32偺帪偼搵嵹偱偒偨偺偩偗偳丄丄丂偙傟偩偲偝偡偑偵戝偒偡偓傞丅僕儍儞僷乕挘傜側偄偲偄偐傫丅丂傓偅偅丄丄丄

偲偄偆偙偲偱傕偭偲彫偝偄敪怳巕傪RS僐儞億乕僱儞僣偱拲暥偡傞偼傔偵丅1屄500墌傕偟偨丅(>_<)丂乮偦傟偱傕偙傟傛傝戝偒偄乯

偠傖偦傟偼偍偄偲偄偰丄GDL偺僀儞僗僩乕儖偟偰儃乕僪偺摦嶌妋擣傗傜側傫傗傜傪傗傝傑偟傚偆乣丅丂偲偄偆偙偲偱丄僟僂儞儘乕僪偟偰僀儞僗僩乕儖偡傞偲丄丄丂RPU-10梡偑僞乕僎僢僩偐傜徚偊偰傞両丂側偤偩丠丠僼僞僶偐傜僋儗乕儉偑棃偨偺偐丠丂側傫偲偐媽僶乕僕儑儞傪擖庤偱偒側偄偺偐丠丠

扵偟夞偭偨偑媽僶乕僕儑儞偺僟僂儞儘乕僪偼弌棃側偝偦偆丅丂偑偭偔傝偟偰傞偲帺暘偺僟僂儞儘乕僪僼僅儖僟乕偵GDL1.7偔傜偄偺傗偮偑巆偭偰偄傞丅帋偟偵僀儞僗僩乕儖偟偰傒傞偲丄偙傟偵偼RPU-10愝掕偑擖偭偰傞丅偳偆傗傜弶婜僶乕僕儑儞傪嬼慠僟僂儞儘乕僪偟偰偄偨傜偟偄丅

偟偐偟丄偄傑偝傜GDL1.7傪巊偄偨偔側偄偺偱GDL嵟怴斉偵GDL1.7偺僞乕僎僢僩僼傽僀儖偲偐儔僀僽儔儕傪曻傝崬傫偱傒偨偺偩偑丄丂埬偺掕儕儞僋僄儔乕丅丅丅

RPU-10梡偺僐儞僷僀儖偼GDL1.7偱傗傞偟偐側偄偺偐側偀乣(>_<)丂

丂

側傫偩偐丄傕偆偡偖儔儉僟偑帺棩乮偲偼尵偊側偄偑乯偟偦偆側偲偙傠偱怓乆側幾杺偑擖偭偰偒偨姶偠丅丂偼偭両丂傕偟偐偟偰偁傟偐丠傾僩儉崱愄暔岅偺僷儔僪僢僋僗両丂偳偙偐偱媭偪壥偰偰偄傞傕偆堦戜偺儔儉僟傪攋夡偟側偔偪傖偄偐傫偺偐側丅

偦偆偄傗僾儖乕僩僁偺嵟怴姧偑弌偰傑偟偨丅丂憗偔捠忢斉偑弌側偄偐側丅丂偦傟偵偟偰傕嵟嬤儔儉僟傕僔僌儅傕慡慠恑傑側偄側偀乣丅帺暘偺儌僠儀乕僔儑儞偑偖偭偨傝偟偰偄傞偺偑杮摉偺尨場側傫偩傠偆側偀乣(乕乕;)

柧擔偼乽傢傫偩傎乣乿偱偡丅丂崱夞傕弌応偟側偄偗偳娤偵峴偙偆偲巚偭偰傑偡丅丂偁傢傛偔偽懪偪忋偘偵傕嶲壛偡傞偮傕傝偱丅丂