�J�������C���f�b�N�X��

�O�̃y�[�W��

���R���P�U����

�֓��g���K��ɍs���Ă��܂����B

���{�������O�Ƃ������Ƃ������āA����͎Q���҂����Ȃ������悤�ł��B�@����̃��{�����̓X���[�v���̃����_�[�g���̂������āA���̒������o���郍�{�X�|�ȂɏW�܂��Ă�낤�ȁ[�A�A�Ƃ������Ƃł����BK����̃u���O��������肻�̒ʂ肾�����悤�ł��ˁB

�����_�͊O�������āi���G�v����������(^_^;)�@�j���߂Ă̊O�o�B�@�F����̕]���́A�A���Ă����A(^_^;)�@�ꉞ�͐l�ڂɂ��点��悤�ɂȂ�������ł��B

�c��̊O���ƃ}�j�s�����[�^���͂ڂ��ڂ��i�߂�Ƃ��āA����v���O�����̕��ɖ߂��Ă����܂��傤�B

�@

�����̓����_�����߂āi�������߂āj�����O�̏�ŕ������܂����B�Ƃ̃J�[�y�b�g�ƈ���ăO���b�v���Ȃ��̂łȂ��Ȃ��i�܂Ȃ��B�@����������ƃO���b�v���������ȁB�X���b�v����Ɠ|���U�q�ɂȂ�Ȃ�����F�X�_���Ȃ͂��B

���ƁA�G�̃T�[�{�������ւȂւȂɂȂ��āA��������̗����オ�胂�[�V�������o���Ȃ��Ȃ�܂��B�@����͕G�̕��M����K�v�����ǁA�����オ������H�v����K�v������Ȃ��B

���K���͐H�������Ȃ���z�r�[���{�b�g�E�̍���ɂ��ĔM���c�_�����킵�܂����B�@���C�g�ȃ��[�U�[�������Ɗy���߂������Ȃ���Ȃ�Ȃ��B�@�w�Z��c�t���ŃC�x���g���J�Â���̂͂ǂ����낤�B�B�@�ȂǂȂǁB�B�@�����A���C�g�ȃ��[�U�[�̂��Ƃ��C�ɂ�����]�T�̓I���ɂ͖����Ȃ��ƁA�����̍�肽�����{�b�g�������̔]�݂������C�Ȃ����ɂł���̂��ǂ����A�������̕������S�z�ŐS�z�ŁB(^_^;)�@�ΐ삳��̓z���g�ɂ������l���Ǝv���܂����B�@�ł��A����ȃI���ɂ������Ƌ��͂ł���Ƃ���͂��邩�Ǝv���܂��B

�����͒�������֏o���B�@�A��̐V�����͐��������ĐQ�Ă邩�Ǝv���̂����A�s���̐V�����́A�A�A�@���������Ă͂��Ȃ����ǂ���ς�Q�Ă邩�Ȃ��B�@�ꉞ���{�b�g������i�߂�p�ӂ͂��čs�����B

���R���P�V����

�����͒�����V�����ő��ցB�@�\�z�ʂ�ƂɋA�����̂͐[��ɂȂ��Ă��܂����B�@

����1�����͊O�����ɂǂ��Ղ肾�����̂����ǁA�O����8�����I������̂ł�����ŃA�N�V�����A�C�e�������Ă������Ǝv���܂��B

1.�w�ʑ��O���̐���

8�����I������ƌ����Ă���둤�ɉ����Ƒf�����Ȃ̂Ŕw�ʑ��̊O�������X�Ɋ��������Ă��܂������Ǝv���Ă܂��B���͑O���̃J�o�[�ƌ�둤�̃J�o�[�̐ڍ����@���m�����Ă��Ȃ��̂ł��̂�����̖�肪�ςݎc���ɂȂ��Ă܂��B

����ł͑����Ə�r�͑O��̃J�o�[������Ă���̂ł����A�e�[�v�œ\�荇�킹�Ă����Ԃł��B������ŏI�I�ȑg�ݗ��ĕ��@�Ƃ��ׂ����ǂ������܂߂Č������K�v�ł��B

���F�̃e�[�v�Őڍ������J�o�[������Y��ɑg�ݗ��̂ł����A�J�o�[���͂������тɃe�[�v�����Ղ�����Ă̂͂������Ȃ��̂��ƁB�B

2.��������̗����オ�胂�[�V�����̉��P

�G�T�[�{�������ɔM�_�����N�����̂ŁA��������̗����オ�肪�ł��Ȃ��Ȃ�܂��B

�M�_�����̂̑K�v�Ȃ̂͂������Ȃ̂����A�G�ɗ���Ȃ������͍�����K�v������܂��B

����������̗����オ��ł͌Ҋ߂��g�����ƂŕG�ɗ���Ȃ�����ƂȂ��Ă���̂ŁA���������̂��N�����đ̈����ɂȂ�A�������牺�����́i���������ɂ���j�l����Ɉڍs����ׂ����ȁA�ƍl���Ă��܂��B���[�V���������̊ϓ_����͒P�����̂��߂ɂЂ˂�p�������Ȃ��ŗ����オ�肽���Ƃ����̂������ł��B

3.���x�x�[�X�̎p���ڍs�ł̑�`�����̃C���v��

���[�`���O����Ȃǂ̂��߂̏㔼�g�Ɖ����g�̘A������ŁA���x�x�[�X�ł̎p���ڍs��g�ݍ����A�킸���Ȏp���ڍs���s���ۂ��w�葬�x�Ńh���Ɠ����ăh���Ǝ~�܂�A�Ƃ������Ƃ��N����܂��B����͕s���肳���ĂыN�����Ă��܂��̂ŁA��`������������K�v������܂��B

�����Ƃ�肽�������̂����ǁA�O���D��ɂ��Ă��̂Őςݎc����Ԃł��B�@�������Ƃ�������Ⴂ�����B

4.�����̃O���b�v���P

����̗��K��Ń����O�œ����������̃X���b�v�̑�ł��B

�Ƃœ������͈͂ł͖��Ȃ��̂ł����A�O�œ������ꍇ�͊�{�����O��ł��傤�B�����Ń��{�r�����[�h����邱�Ƃ��l���Ă��X���b�v�K�v�ł��B

�����̃S���V�[�g���������邾���ŃO���b�v����悤�ɂȂ邩�ȁH

5.�����R���g���[���̐ڑ�

7���̂�ف[�ɂ͏o�Ă݂����ȁA�Ǝv���Ă܂��B���̂��߂ɂ�PS2�R���g���[���ƒ��ڒʐM�ł���悤�ɂ��Ă����K�v�������Ă܂��B

�R���g���[���ƃC���^�[�t�F�[�X��1��5��~���炢����炵���B������ƍ������ǁA����ł܂�1�����������Ă̂����₾����Ȃ��A�A�APIC�g���ĊȒP�ɂł��Ȃ����Ȃ��B�B

���s�̉��P�Ƃ������̂��߂̂��낢��Ƃ����{�I�ȃe�[�}�͂������̂����A��U�́u�d�������ē����o���v�A�Ƃ�����{�I�ȕ������`�ɂ��āA���̌�e�v�f�̋@�\�g��A���x������s�����Ǝv���܂��B

���R���P�W����

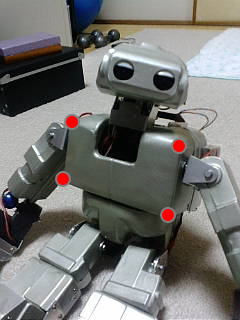

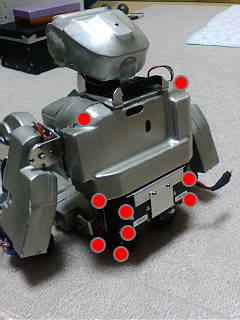

���K��ł̃����_�̗l�q���U������Ƃ��ŏЉ��Ă܂����B�@�U������A���肪�Ƃ��������܂��B�@�O�������ƃ��{�b�g�炵���Ȃ�Ȃ��A�悩�����[�B

�@

������������������A�N�V�����A�C�e����ׂ��Ă������ƁA�d���̋A��Ƀn���Y�ɍs���Ċ���~�ߑf�ނ�T���Ă��܂����B

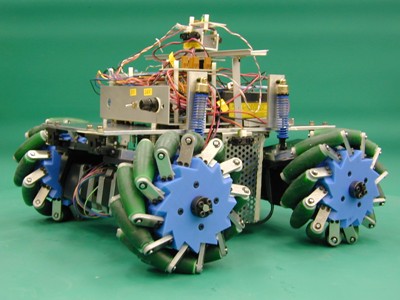

�C�̗��̂悤�ȃg���b�h�p�^�[�����ł��Ȃ����ȁ[�Ƃ��l���Ă��܂������A����~�ߋ���ׂĂ݂ăG���X�g�}�V�[�g�Ɍ���B�S���V�[�g���S��C�����邵�A�y���B

�@�g���b�h�Ȃ��̃X���b�N

�y���܂�������͈̂��g����Ȃ��āA�����Ȓi���Ȃǂɂ������Ă��܂����ꍇ�ł��A�ܐ�Ƃ����ƂŐڒn����悤�ɁB�@�ǂ�قnj��ʂ�����̂��킩��܂��B�B�@�ܐ�͂܂Â��h�~�̂��߁A�t�b�f�e�[�v��ڒn�ʂɏ�����������x�\���Ă܂��B�@���̃G���X�g�}�V�[�g�A�S���ނ��܂������t���Ȃ��B�@�S���e�[�v��������Ă��܂��̂Ńe�[�v�𑫕��̕\���܂Ŋ������܂��ĂȂ�Ƃ��Œ肵�Ă��܂��B

�䂪�Ƃɂ̓����_���������قǂ̃����~�������̃f�R���{�[�h�͂Ȃ��̂łǂ�قnj��ʂ�����̂��m���߂邱�Ƃ��ł��܂���B�@�Ă��A����A�J�[�y�b�g�̏��1����������������z�R�����z�����ĔS��C���Ȃ��Ȃ�悤�ȋC������B�@���Ύ��邩�ȁB

�Ƃ������ƂŁA�ꉞ�A�N�V�����A�C�e���S�����B(^�B^)�@��ڂƂ܂ŕ�������̂��y���݂ł��B

�@

�����_�A�Ƃ�����������RPU-100�ɂ�Gtalk(google talk����Ȃ��j�𓋍ڂ��Ă��ăe�L�X�g���������邱�Ƃ��ł���̂ł����A���K��ŏ�������������@�����܂����B

����Gtalk�ƈꏏ�ɔz�z����Ă���j���̐��ł��B�@���ꂪ���\�쑾�����ł��킢���Ȃ��B�@�C�K�A����Ɂu�����_�Ȃ班�N�̐��ł���B�v�ƌ���ꂽ�̂ł����A�����Ƃ��ł��B�����ł����N�̉��f�f�[�^���~�����Ȃ��Ǝv���Ă����̂����A�������͎̂d���Ȃ��B���{�b�g�����A������Ȓj���̐����Ă̂��A�����ȂƖ��Ȕ[�������Ă���܂����B

��������������ɁA�����Ɖ��f�f�[�^�̐������@������Ă���͂����Ȃ��Ǝv���ĒT���Ă݂��炷��������܂����B

�Ƃ��낪�A���ꂪ�Ȃ��Ȃ��~���������B�@500�`1000���͂̉����f�[�^�����߂ɋ�����f�[�^�ƁA�ǂݏグ�����͂̉��C�f�[�^���K�v�ŁA�����HMM�f�[�^�x�[�X�Ɋw�K�����č��炵���B�i�����K���Ȑ����Ȃ̂ʼnL�ۂ݂ɂ��Ȃ��悤�Ɂj�@���Ȃ݂ɔz�z����Ă���j���Ə����̉��f�f�[�^��1000���͂��������f�[�^�������ł��B

�P�ɓǂݏグ����������Ȃ��A���͂����C���g�l�[�V�����𐳂����������Ȃ���Ȃ�Ȃ��Ƃ��������܂ł��Ă܂��B�i�܂��͉��C�f�[�^�̃C���g�l�[�V���������ɂ��킹�Ă��ǂ����j

�������ށB�����_�̐��̃C���[�W�́i�����Ɓj�����ɍŒ�ł�500���͂𑤉���������ԂŘ^�����Ă��炤�A�A�Ȃ�Ăł��Ȃ��Ȃ��B�@�{�[�J���C�h�̉��f�f�[�^������Ȃӂ��ɍ���Ă��ł��傤�ˁB���D����Ȃ���ł��Ȃ��d�����Ȃ��B�@�m�荇���ɉ̎�Ȃ��l�قǂ�����ǐ��D�͂��Ȃ��B�@��x����ł݂悤���ȁB

�Ƃ肠�����A�����_��2�����ǖ쑾���j���̐����Ă��Ƃ�(^^�U

�����Ȃ݂�2���Ă̂͐ݒ�Ƃ�����Ȃ��āA2�̐l�Ԃ̒m�\�Ɖ^����ڎw���Ă���Ƃ������Ƃł��B

���R���Q�O����

����͂���ӂ�����ŋA�����̂ŁA�����͂�����蒩�Q�B�@����͎������ړ����������������A�����ɂ�(>_<)�B

�����̑f�ނ�ύX�����̂ɁA�܂��������Ă݂Ă��Ȃ������B�@�����������Ă݂��������s���s����H�X���b�v�����Ă�킯����Ȃ����ǂȂ��H�@�O���b�v�͂��オ������A������������J1Z�����ł̓��삪���܂��s���Ȃ���������Ȃ��B�B�ƐS�z���Ă݂����A���v�݂����B�@�����ύX�̉e���͂��������l�q�����Ă݂悤�B

�����͔w���̊O�����肪�����������̂����A�C�ɂȂ��Ďd����������������̋N���オ�胂�[�V�����̉��ǂ��܂�������邱�ƂɁB

���𑫕��̏�ɏ�����邱�Ƃ��ł�����A��̂��N�����Ă��Ⴊ�ݎp���ɂȂ�B�@���ɂ��̂܂܂����������Ɨ����オ��̂ł͂Ȃ��āA��̂͑O�ɕ�����悤�ɂȂ�Ȃ��獘�͎����グ�Ă����B�@�����\���Ɏ����オ������ɏ�̂��N�����B�@�Ƃ����ӂ��ɍ���Ă݂��B�@�G�ɕ��S��������Ȃ��āA�M�_�������G�ɂ��D�������[�V�����ł���B(^�B^)

���[�V����������Ă���ƁA�v���O������̂����ȕs������o���āA�f�o�b�O���Ȃ���̍�ƂɂȂ��Ă��܂����B�@���[�V��������邾���������̂ɂ���₱����1���I����Ă��܂����B�܂�������������Ƃ��낪��R����̂����A����܂��ꉞ�A�N�V�����A�C�e���Q�������B

�@

�����_�̐��ɂ��āA�����̐����{�C�X�`�F���W���[�ŕς��Ă݂ẮH�Ɛl�`��������̏�����������āA�����c�[���uMorph VOX�v���_�E�����[�h���Ă݂��B�@�t���[�̃c�[���͐��̂����肩����ҏW������Ă��Ƃ͏o���Ȃ��݂����B�@Pro�̕��͗L��������܂������Ă܂���B�@�Ƃ肠�����A�j���̐��������ɂ��邱�Ƃ͂ł���B����������ۂ��B�@�ł��A���N�̐��A�A���Ă������_�̐����Ăǂ�Ȃ����̂��H�C���[�W�����Ȃ�(^_^;)�@��������̐��Ŋ��ꂿ����Ă邩�炠�ꂪ�����_�̐����Ċ������B�B�B�@���ƁA�����������������f�[�^�������F���\�t�g�ʼn��f�����ł��邩�ǂ��������B�@���A���ƃc�[���ꎮ���_�E�����[�h�ł��邩�ǂ������m�F�ł��ĂȂ��BHTK�̃��[�U�[�o�^�����̂Ƀp�X���[�h�����Ă��Ȃ��Ȃ��`�A�����ԈႦ�����ȁH�H�H

���R���Q�Q����

�����̓��{�����̗\�I�B�@�ςɍs�����肾�����̂����ǁA�����Ė����āA�\�I�̓p�X�B�@�A�N�V�����A�C�e���@������Ă܂����B

���������̂����ǁA�o�L���[���܂łł���ƁB�@���Ԃ�����Ȃ��`(>_<)

�@�w�ʃJ�o�[�̉��g�݁B�@�w�ʒ������ɂ�RPU-100�̃X�C�b�`�Ƃ�LED�Ƃ��r�C���Ƃ�������̂ʼn��H���K�v�B

�^��납�猩��Ƃ����Ƃł��Ă�悤�Ɍ�����̂����A���ʂ��_���ł��B�@���̃T�C�Y���Ɛ[���o�L���[���͂ł��Ȃ��̂ŁA���ʂ̗����オ��̓v����ڒ�����B�@�O���J�o�[�Ƃ̊����͍l���ĂȂ��̂ŁA���Ԃ��ł��Ă݂��Ƃ��Ȃ��B(�[�[;)�@�ł��A���̕ӂ����E���Ă������A����ȏ�̐��x���o���ɂ̓v���o�L���[�����Ⴟ����Ƃ˂��B�@

�@���������A�������Y��ɍ����@�i�菇�H�@�\���H�j���l���Č��܂��B

�@���̌�둤�J�o�[�e��

���̌�둤�J�o�[���o�L���[�����܂����B���Ȃӂ���݂̓P�[�u���_�N�g�ɂȂ��Ă���B�܂��܂��[���l�����ɍ�����̂ŁA�ǂ����Ŋ����������邩���B

�܂��d�グ���h�����c���Ă邯�ǁA����ŊO���Ŏc��͂��K�ƃ}�j�s�����[�^���B�@�w���⑫�̓P�[�u����������������B�������������ǁA���K�̓T�[�{�ނ��o���ł��������Ȃ��B

�����̓��{���������B�@�t�����Ɗςɍs���܂��B�@�g���Ă�悤�Ȃ�ΐ삳���Â̑ł��グ�ɂ��Q���������ȁ[�B�@�����X��ˁH�������킳��B

���R���Q�R����

���{���������A�ςɍs���Ă��܂����B�@�����đł��グ�ɍs���Ĉ���ł��܂����B

�ϐ킵�������Ȃ��ǁA�y���������ł���B�@���܂܂��D�����߂łƂ��������܂��B�e�R��V�ɕ����͂������ǁA����ς��܂܂���̑��c�͏�肢�I�@�ł��A�A�ł��グ�ł��ςς���Ƀ_���o������Ă܂�������(^_^;)

�J��O�ɕ���ł���ΐ삳��ɑ����B�@�Ȃ�ł�����̍��e��ł�ONO-ONE�\���Ń����_���������S�ʂŕ\������Ă��Ƃ��I�@���[�����[�A�\�����Ă��ꂽ�B�����đł��グ�̐ȂŃL�m�s�[�Ɂi����A�L�m�s�[����(^�B^)�@�j�\�����Ă��������܂����B

�@������Ď�҂��Ƃɑ䎌���p�ӂ���Ă����ł��ˁ[�B�������I���ꂵ���I

�ł��グ�ł�SISO����ɂ����ł��ڂɂ�����܂��āA�������{�p�̋@�̂������Ă��炢�܂����B�ό`���{��SISO����̐^�����B�����x�����ł��ˁ[�B�@�������{����������3�x������3�x�����{�b�g���o�Ă������ȕ��͋C�B�@���S�Ɏ����̗\�z���Ă܂��B�@�����̎ړx�ŕ����l������_�����ƒɊ����܂����B�@�w�͂�����Ȃ��ȁA���낢��ƁB�B

���̌�AJinSato����ƖԖ삳��ƃ��{�b�g�̐���Ə����ɂ��Ċ��X态X�Ƙb���܂����B�@�����A�����Ƃ����˂B�@�@�O��̃J���t�@�����X�̎��ɂ��v�������ǁA�Ԗ삳��͂������ł��B�@���������̂ǂ����낤���Ďv���Ă�A�C�f�B�A�����Ɏ������đg�ݍ���ł��܂��Ă邱�Ƒ����B�@��������z�������ł��B�@�����ƃN�[���ɂ����ƃN���o�[�ɁB�����͎����v�f�ȊO�͕s�����Ȃ̂ŁA�ł��邾���r�����āA���ʂ��q�ϓI�ɕ��͂���B�@��b���Ă���ƁA������������b���v���o������܂��B

�悵���A��������܂�����낤�I

���R���Q�S����

�ŋ߂̓�����ǂݕԂ��Ă݂�ƁA�e�N�j�J���J���t�@�����X�ŗN���オ�������`�x�[�V�����͂قƂ�NJO�����Ŕ�₵������(^^�U�@�܂��O�����厖�����炢�����ǁ`�A�A�A�z���g�Ƀz���g�ɊO���͂����قڏI��肾���玟�ɐi�܂˂B

���ꂱ��H���U�炩���Ă����ԂȂ̂����A�Ƃ肠�����̖ڕW�͎����Ń��{�r�����[�h����邱�ƁB�@����͎����s�����s����b���\�z������Ă��ƂŁA�r�����[�h����点�邽�߂̃r�w�C�r�A���Ă̂��s���K�͂��Ă̂��A�s�����[�����Ă̂��A���������͓̂�����̂ł͂Ȃ��B������Ƃ����X�N���v�g�I�Ȃ��̂ŏ\���ł���͂��B

�s�����[���������w�̍s���̎��s�Ƃ��̌��ԏ����݂����Ȃ̂����\��ςł߂�ǂ������B�@�߂�ǂ��������ǂ��Ȃ���d���Ȃ��̂ł��炭�͂�����Ƃ��̐�����i�߂���Ă��ƂɂȂ�낤�ȁ[�B�@�O���ɑ����Ă܂�����܂�ʔ����Ȃ���ƂȂ̂ł������Ƃ�������܂������Ƃ���B�@���{������̗N���オ�������`�x�[�V����������Ȃ̂ɔ�₵�Ă����̂��낤�����`�B�@����A�߂�ǂ��������Ėʔ����Ȃ���Ƃ����炱�����`�x�[�V���������������ɂ�������܂��ׂ��Ȃ̂��H�@�J���t�@��ɊO��������̂��������������B(^�B^)

���̉��w�����̐����ŁA���荞�ݏ����̉��P������������Ǝv���Ă���B�@���܁A�����_��25ms�����ɃT�[�{�̏����ƃZ���T�[����̃f�[�^�擾���s���Ă���̂����A���̏����̓V�O�i���ŌĂяo���Ă���B�@�V�O�i�������͌��\CPU���g���݂����Łi������Ƃ��͂悭�m��Ȃ��j�A�@�v���Z�X���ă��[�v�ʼn����������I�Ƀ��_���Ȃ������B�T�[�{�̐��䂾���Ȃ獡�̂܂܂ł����Ȃ��̂����A�摜�����≹���F�����ɏ����������Ǝv���Ă���̂ł��̕ӂ�̏����̌��������������Ȃ��Ƃ����Ǝv���Ă����̂��B�@���w�����̐����ƃC���^�[�o�������̌������łǂꂭ�炢���Ԃ����邩�ȁ[�B�@�܂����1�������ĂƂ��납�H�@

�@

�O������̂ł��Ċ��`�F�b�N�̂��߂ɗ����オ�胂�[�V�����Ȃ����Ă݂���A���܂��s���Ȃ����Ƃ����X�����āA���[�V�����̌������������肵�Ă����B�@�ǂ����A��悪�J�[�y�b�g�̖ѕ��݂ɂЂ��������Ă��܂����Ƃ����s����ꍇ�̌����炵���B�@�Ƃ̒��œ������̂��O��̃����_�ł���͂����Ƃł��B�������炷����͂ł��邾�����Ȃ��悤�ɍl���Ă͂���̂����A�O��I�ɂ������Ă͂��Ȃ��̂ł�����Ƃ�����ł��B�@�ł��A�ǂ��炩�Ƃ����ƁA��悪�Ђ��������ď�肭�����ĂȂ����Ƃ����m�ł���悤�ɂ������Ƃ���B�����L�[�t���[�����̂���ׂ����p���p�x�����[�V�����ɑg�ݍ���ŁA�ُ�l��������烊�g���C����悤�Ȏ�i���K�v���H

�Ă��A��悪�����������ė����オ������s����Ƃ����č����ɂЂ�����Ԃ�܂��B�����������S�c�[���ƁB(^_^;)�@���܂������ĂȂ����Ƃ��_�C�i�~�b�N�ɃZ���X���Ȃ���Ȃ��킯��������Ȃ��`(>_<)

���R���Q�U����

�n���ȃv���O�����������X�^�[�g�B

�����͕��s���̕��s�p���Z�b�g�̐����B�@���s�̊�{�p�����A�O�i�A��ށA����Ƃ�����ʂŃp�����[�^�����ĊO���t�@�C���ɂ��ĕێ����Ă���̂����A���̕��s�p�̊�{�p�����[�^�t�@�C���ɏ㔼�g�̎p����lj������B

���������ĕ����A�ȂǂƂ������͕ʂɂ��āA���̕s����ȕ��s�̏��l����ƁA�㔼�g�̎p�������s��ʖ��Ɏ����Ă������ق����悳�����ȋC�z�������̂Œlj������B

�㔼�g�p���̃f�[�^��lj������Ƃ���A�w�b�_�[�t�@�C���ɕs����o�āA�R���p�C�����o���Ȃ��悤�ɂȂ��Ă��܂����B�@���ׂ�Ɗ���̐錾�ő��݂ɌĂяo���`�ɂȂ��Ă��܂��Ă����B�@�lj��lj��ŏ��������čs�����̂ł����錾���������Ⴎ����Ȃ̂��B(�[�[;)

���ǁA�X�ɃC���N���[�h�t�@�C�������āA���Ăяo��������B�ꉞ�v���O�����������o�����Ƃ���Ń^�C���I�[�o�[�ł���B

�@

���́A���얽�߂̃X�^�b�N�����B

����́A�u�������v�Ƃ����Ƃ��A�܂��́u�����v�Ƃ������߂����Ƃ��A�ł������B�@���s�̊�{�p���ɂȂ��Ă��Ȃ������ꍇ�A�܂��͕��s�̊�{�p���Ɉڍs���Ȃ���Ȃ�Ȃ��B�@���̎��A�u�����v�Ƃ����R�}���h�̎��s�̑O�Ɂu�p�����ڍs����v�Ƃ����R�}���h�����āA���s����B�u�����v�R�}���h�͏��ł���̂ł͂Ȃ��X�^�b�N�Ɋi�[����āA�p���̈ڍs������������ɎQ�Ƃ���ĕ����o���A�Ƃ����X���|�[���B�@���̃v���O�����̑g�ݗ��Ăɂ����g�ݍ��ނ̂�������Ɩʓ|�B�@������������啝�����ɂȂ邩������Ȃ��B�₾�Ȃ��`�B�@�@�@�ł��A���Ȃ���d���Ȃ��B�@�����ł��邩�ȁB

���R���Q�V����

�����͎c�ƂŁA�A��̂����傢�ƒx�������̂������߃X�^�b�N�����̂͂���Ȃɓ���Ȃ��A�ƃ^�J���������č������ɃR�[�f�B���O�����ł������Ⴈ���Ǝv���Ă����B

�����A���߃X�^�b�N�����̂��ȒP�ł��A�X�^�b�N���閽�߂����镔���͊ȒP����Ȃ��A�Ƃ������ȒP�����ǂ����ȏꍇ�̏��������ׂĂׂ�����Ə����o���Ȃ���Ȃ�Ȃ��B�@���͂��ׂ̂����菑���o���Ƃ����̂���̕s���ӂŁA����������ƃ��[�V��������鍪�C���Ȃ��̂Ɗ֘A���Ă���悤�ȋC������B

�����Ă��鎞�Ȃ���s�p���ֈڍs���Ă�������������A�@������s���Ȃ��x�~�܂��ď㔼�g�p�����ւ��Ă���A�@�X�ɂ͍����Ă����ԂȂ�܂������オ���āA�����Ďp�����ڍs���Ă�������A�Ƃ�����ɗl�X�ȏ̂��ׂĂ��R�[�f�B���O���邱�ƂɂȂ�B�l���Ă���Ɩ����̑g�ݍ��킹�����肻���ȋC���ɂȂ��ăQ���i������B

�Ȃɂ��A���[���̂悤�Ȃ��̂���������̂����A�A�@�ׂ����菑���o���������ȒP�Ȃ̂�������Ȃ��Ȃ��B

�@

�����͈��݉�B�@�Ȃ̂ŁA�����͓y�j���Ƃ������ƂɂȂ�B�y�j���͊O���̎c���Ƃ��D��Ȃ̂ŁA�O���H�삪�I������炱�̑������B

���R���Q�X����

����������DVD�쐬�����Ȃ���A�O���̎��t����ƁB

�O���͂ƂĂ��ƂĂ��^�C�g�ɍ���Ă��邵�A�����I�ɂ͓����������Ȃ��Ă��đg�ݗ��Ă����s����ƃN�V�����ƍs���Ă��܂��B�O���ƌ�둤�����킹�邽�߂ɒ[��肻�낦��̂����A��߂��Ă��܂��Ƃ�����̂ŁA�T�d�Ɂ`�A�Ƃ���Ă���Ǝ��Ԃ̂����邱�Ƃ����邱�ƁB��ڕ����̌㑤�����t���邾���Ŕ������炢������܂����B�@DVD�쐬���Ȃ��炾���ǂˁB

��ɂȂ�������H�͂�߂āA�v���O������Ƃɐ�ւ��ā`�A�A�Ǝv���Ă����̂����A��ڃ��[�����T�[�{�̌�둤�J�o�[�̎��t��������Ă�����[��ɂȂ��Ă��܂����B

�������ɂ͊������邩�ȁ`�B

�@��ڃ��[���̃J�o�[�͖��h���B

��ڃJ�o�[���ł����Ƃ���œh���܂ł���Ă݂��B�@�d�˓h�肷�����Ōy�������Ċ������Ă��Ċ����ŐT�d�ɓh�������̂ŁA�����̓h���͐����B�@��둤�Ȃ��ǂˁB(^^�U

�@����������DVD�������B

���R���R�O����

�_���_����AM11�����炢����O���̑������ĊJ�B�@�G�߂̃P�[�u�����[�e�B���O�Œv���I�ȃ`�����{�����o���ă��`�x�[�V�����������肩�������ǁA�Ƃ肠������������ؒf�����肵�Ȃ���Ȃ�Ƃ��g�݂��������B�@�F�X�s��𒊏o���Ă����蒼�����B

��������[�A���Ƃ͓h�������犮���I�@���Ă��Ƃœh���̏��������ăx�����_�ł��Ƃ���ʼnJ���ۂ�ۂ�ƁB�B�@orz �B�B�B�@�J�̒��h���͂ł��܂ւ�B

����R�ƉJ�����߂郉���_

�@�w���̃J�o�[�������Ƃ��B�@���J�o�[�Ɣw���J�o�[�̂Ȃ��������ނ���J�o�[�B

���T�܂ł܂��J�o�[����Ȃ��̂��Ȃ�Ȃ̂ŁA�h�����ĂȂ����ǁA���g�ݗ��āB

�@�G�������̃J�o�[�v���{���{���B

�@

�O���W�͂قڂ�邱�Ƃ��Ȃ��Ȃ����̂ŁA�R�}���h�X�^�b�N����̃v���O���~���O���J�n�B

�����_�̖��ߌn���́A�l�b�g�ڑ�����̖��߁A�@�R���\�[������̖��߁A�@���Ƃ̓o�b�e���[��Ƃ��]�|���Ȃǂɑ��锽�˓��삪����B�@����ɃR�}���h�X�^�b�N�ɂ�閽�ߎ��s�������B�܂������n�ɂ�閽�ߎ��s���Ȃ��̂��߂����Ƃ���B

�R�}���h�X�^�b�N�͎�Ƀl�b�g�ڑ�����̖��ߎ��s�̍ۂ̓���̂Ȃ����s�����߂̎d�g�݂ɂȂ�B�����I�ɂ͎����n�̖��ߎ��s�́i�����w����ʃ��C���[���Ƃ��āj���ԃ��C���[�ƂȂ�B

�R���\�[������̖��߂͎�����}�j���A������n�ɂȂ�̂Ŋ�{�I�ɂǂ̂悤�ȏ�Ԃɂ����Ă����ߎ��s����i���Ƃ����s���ĕs����������悤�Ƃ��}�j���A���Ȃ̂Ŋ֗^���Ȃ��j

����ɑ��ăR�}���h�X�^�b�N�̓��{�b�g�������Ă��Ȃ���Ԃł����N�����Ȃ��B�@�܂��~���߂̓X�^�b�N���Ȃ��B�@������O������(^_^;)

�l�b�g����̖��ߌn�̓R�}���h�ɂ���ĐU�镑�����ς��B

�l�b�g����̖��ߌn�ł̓R�}���h�ׂČ��݂̃��{�b�g�̏ɂ���Ď��s���邩���Ȃ������d������B�@�܂��́A�ɂ���ăR�}���h�X�^�b�N�����A�p���Ȃǂ̕s����������Ă�����s����悤�ɂ���B

���������킯�Ńl�b�g����̖��ߌn�����C���̖��ߌn�Ƃ������ƂɂȂ�B

���̃����_�̎��s�R�}���h�͕�����ł��Ƃ�����Ă��܂��B�@�����_�̓l�b�g���當�����������炻�����͂��Ď��s���܂��B�@�R�}���h�X�^�b�N��������������̃��X�g�ł��B�@���ׂĂ̗L���ȒP�ꖈ�ɏ������L�q���Ă���̂ŁA������𐮐��Ȃǂɕϊ����Ċi�[����f�[�^�ʂ��������Ȃ�̂ł����A�V�����P���g�ݍ��ނ��тɕϊ��e�[�u�����X�V���ĂȂ��炩���炷��̂͌��\�߂�ǂ������B�@�Ȃ̂ŁA�������[�̘Q��ł͂���̂����ǁA������̂܂������Ă��܂��B�܂��Q��ƌ����Ă����������Ă�邵�B

���̓N�C�b�N���[�V�����̃f�[�^�́A�t�@�C����ł̓e�L�X�g�t�@�C�������ǂ��A�v���O�����̓ǂݍ��܂ꂽ���ɐ����l�ɒu���������Ċi�[���Ă��܂��B���̂��߁A�R�}���h�̕ϊ��e�[�u���̊Ǘ������˂Ȃ�Ȃ��Ă߂�ǂ������v�������Ă܂��B�@��������������̂܂܊i�[����悤�ɂ��悤���ȁB(^_^;)

���������A�����œ��������悤�ɂȂ�����A���̂悤�ȁu���ߎ��s�v�Ƃ����悤�Ȃ͂����肵���L�q�͂Ȃ��Ȃ�͂��ł��B��Ԏq�i�Ɖ��ɌĂԁj���m�̏��̂��Ƃ�ł����Ԃ����܂�A����ɂ������炳�����Ԏq�̓��͂ƂȂ�B�@���̃��[�v�Łu�s���v�����������A�@�Ƃ����������ɂȂ�̂��Ȃƍl���Ă܂��B

��������ȃv���O���������������Ȃ��B

�@

�����ƁA�A�A�R�}���h�X�^�b�N�͏o���āA���Ƃ̓R�}���h�X�^�b�N�������������������Ă���������Ԃɂ͂Ȃ�܂����B�@�Ƃ肠�����͕��s�p���ւ̈ڍs�Ƃ��E�F�C�g�Ƃ��̋L�q��lj����Ă������B

���S���P����

�v���O�������n�߂�S�̃X�C�b�`������Ȃ������̂ŁA���������p���f�f�[�^�쐬�̑����ׂĂ����B

���f�f�[�^����邽�߂̕��͓ǂݏグ�f�[�^���K�v�Ȃ̂�����ǁA���f�o�����X����ꂽ���̓f�[�^�łȂ���u�ǂ����f�f�[�^�v�����Ȃ��B

���f���Ă͕̂ꉹ�Ǝq���̃f�[�^����������킯����Ȃ��āA���f�Ԃ̂Ȃ��肪�X���[�Y�ɂȂ����f�[�^����Ȃ��Ƃ��������̍����������o���Ȃ��B�@�ׂ��������f���m�̂Ȃ�����l���������f�f�[�^���u�Q���f�A���v�A�O��̂Ȃ�����l���������f�f�[�^���u�R���f�A���v�̉��f�f�[�^���Ă����āA�Q���f�̏ꍇ�͉��f���̓��A�R���f�̏ꍇ�͉��f���̂R��̑g�ݍ��킹������B�@�������A���ʂɂ���ׂ����ꍇ�ɂ͔����s�\�ȑg�ݍ��킹��قڎg��Ȃ��g�ݍ��킹������̂Ō����ɂ͂���������Ə��Ȃ����̑g�ݍ��킹�ɂȂ�B

���f�o�����X���Ƃꂽ���̓f�[�^���g���ƁA���́u���f�A���v�̃f�[�^�����悭�o�����Ă悢���f�f�[�^���o���オ��Ƃ����X���|�[���B

���Ȃ݂ɉ����F���������l���̉��f�f�[�^�������Ă��āi�������͂����Ȑ��̕��ς��Ƃ����f�[�^�j�A�R���f�A���̕����F�����������B�i���A���Ԃ�������j

�������������͓ǂݏグ�f�[�^��CDROM�ȂɂȂ��Ĕ����Ă�炵���āA���������≹���F���̌����Ɏg���Ă�炵���B

�����_�̐������O�Œ��B����Ƃ�����A���̉��f�o�����X�����~�����Ƃ���B�@������l�b�g�ŒT�������ǁA���蕨�Ȃ̂Ń_�E�����[�h�Ȃ͂ł��Ȃ��炵���B�@�uATR���f�o�����X���T�O�R���v���Ă̂��L���ǂ���݂����ŁAgtalk�ɓY�t���Ă���f�[�^�����̃o�����X���������Ă���݂������B

�ŁA����CDROM�A�@�����ƁA367000�~�B�B�B�B�@�����[�I�@��������B�@�܁A�����p�����炻��Ȃ���Ȃȁ[�B�@�o�����X�������ł����������ĂȂ����ȁB

�o�����X�����������Ƃ��Ă����̓f�[�^�Ȃ͍��Ȃ���Ȃ�Ȃ����Ȃ̂ŁA����قǘJ�͂�����킯�ł��Ȃ������B�@�Ȃ�A�K���ȕ������P�O�O���͂��炢�W�߂č���Ă݂Ă������̂�������Ȃ��B�@���f�f�[�^�\�z�̊����ł��������Ă݂܂��傤���˂��B�@���̂����B�B�B�@(^^�U�@�@����܂ł͂��������Ă��ƂŁB

���[�N�i���C�g�������́A�ˁB�j�̑䎌���W�߂Ėx�k�^��̐��i���Ă��A���[�N�̐��ˁj�������ĈĂ��o�����ǁA������ďё����̐N�Q�ɂȂ��˂��@(^_^;)

���A�Q���f�A�����A�R���f�A�����͕ʂɂ��āA�K�v�ȉ��f���o�����镶�͂��W�߂Ȃ��Ⴂ���Ȃ����Ă̂�Y��Ă��B�@�e�L�g�[�ȕ������Ⴞ�߂��`�B

�����̎q�Ȃ�f�R�X�y�`�����̂����̐����ȁ[�B�@�����f�[�^���Ȃ����A���̂����������肾����_�������B

���S���T����

�d���Ƃ����݉�Ƃ����ʉ�Ƃ��ŁA�E�B�[�N�f�[�͂قƂ�Ǎ�Ƃł����ɏT���ɓ˓��B

�����͂Ƃ��Ƃ��Ō�̊O�����i�̓h�����������܂����B�@�h���͐����Ə��ɂȂ��āA���ƂȂ��Ă͑O���ɓh���������i�͌���̂��C���ɂȂ�o���Ȃ̂ō�蒼�������C���B�i��蒼���Ȃ����ǁj

�J�o�[�̌Œ�̓l�W�~�߂ł���Ƃ���Ƃł��Ȃ��Ƃ��낪����̂ł��炭�̓e�[�v�Œ�ŗl�q���B��{�I�ɂ̓J�b�e�B���O�V�[�g���Œ�Ɏg���Ă���̂����ǁA�Z���n���e�[�v�œ\���Ă邾���ł��\���Ȏ��t�����o���Ă�B�������ȁB

�@�@

�@�@

�}�j�s�����[�^����������܂ł͂��̏�Ԃőł��~�߁B�@���A�C���������炨�K�̊O������邩������Ȃ����ǁB�@�ꉞ�̊����ƂȂ������_�Ŋ��ɂ��������̓h���������ꂩ�����Ă�B�ł��A�Ō�̊O�����i��h�������Ƃ���ŃX�v���[���J���ɂȂ��Ă��܂����̂ŕ�C���ł��Ȃ��B(>_<)�@���Ȃ݂Ƀp���c�����Ɣw�������͂Ђ������Ă��邾���ŌŒ肵�Ă��Ȃ��B�Ȃ����܂��Ђ��������Ď��t���Ă�B�@�w���ɂ��Ă̓l�W�Œ肷���i���p�ӂ��Ă���̂ŕK�v�ɉ����ăl�W�Œ�ɂ������B

���ǁA�J���[�����O�͂Ȃ��B�@���Ƃ��ƃ��m�g�[�����D�������A�����_�̈ʒu�Â��I�ɂ��J���t���ȃJ���[�����O�͗L�蓾�Ȃ��̂ł���ł������ȂƁB

�@

�R�}���h�X�^�b�N�͓���̈ꕔ���ɂ��Ă����X�^�b�N�����̋L�q�����Ă݂āA����ɓ������Ƃ��m�F�����B

����R�}���h�����s����ۂɃ`�F�b�N���ׂ���ԕϐ��́A�@�����g�̓����ԁ@�A�㔼�g�̓����ԁ@�B���[�V�����̎��s��ԁ@�C�p���@�Ƃ���B�@���̏�A���ꂼ��̕ϐ��̂Ƃ�l�ɂ���Ă��Ή����ς���Ă���P�[�X������̂ŁA�S�ẴR�}���h�ɑ��ċL�q���s���Ɩc��ȗʂɂȂ��Ă��܂��B

�Ȃ̂ŁA��͂�r�w�C�r���ł͂Ȃ����A���샋�[���̂悤�ȋL�q��p�ӂ��ăR�}���h�����s����ۂɂ͂��̓��샋�[�����X�g�ɏ]���ăR�}���h�X�^�b�N������Ƃ����d�g�݂ɂ��ׂ����ƍl���Ă���B

�Ⴆ�A�u�O�i���s�v�̃R�}���h�����s���邽�߂ɂ́@�@�����Ă���@�A�~�܂��Ă���@�B���s�p���ł���@�܂��́@�C�O�i���s�����Ă���@�Ƃ�������������B�@�@�`�B��AND�����ŁA�C��OR�����B�@�@AND�AAND�BOR�C�@�Ƃ����W���ȁB

�Q�]�����Ă����ԂŁu�O�i���s�v�̃R�}���h������Ƈ@�ɔ�����̂ŁA������������邽�߂ɗ����オ������s����R�}���h�s����B�@�����オ������ɕ����o�����߂Ɂu�O�i���s�v�R�}���h�̓R�}���h�X�^�b�N�Ɏ��߂Ă����B

�����オ�胂�[�V��������������ƁA�R�}���h�X�^�b�N����u�O�i���s�v�R�}���h�����o����āA�Ăю��s���������Ă��邩�ǂ����ׂ�B�@���x�͇@���A�����藧���Ă���̂ŁA�B�����藧���Ă��邩�ǂ����ׂ�B

�ŁA�����Ă����炢���̂����A���藧���Ă��Ȃ��ꍇ�͎p���ڍs�̃R�}���h�s���A�u�O�i���s�v�R�}���h�̓R�}���h�X�^�b�N�ɍĂю��߂���B

�ŁA�p���ڍs���I�������A���x�������������Łu�O�i���s�v�����s�����B

���ƁA�u�~�܂��Ă���v�Ƃ����Ă��A������I�����Ă������Ƃ܂��������c���Ă��āA���̂܂ܓ�����J�n����ƃE�}�N�����ꍇ���l������̂Łu�~�܂��Ă���v��������������ɂ��Ă��l������K�v�����邾�낤�B

�����͂��̎d�g�݂�����ē����������Ȃ��B�@���܂�����ƃN�C�b�N���[�V�����̎��s���[�`���ƃ}�[�W�ł��邩������Ȃ��B�@��������ǂ��Ȃ��Ęb�ł͂��邪(^_^;)

�@

�Ƃ���ŁA�����̍ޗ���ς������ƂŃO���b�v�̌��ʂ͂���݂����B�@������ς��Ă��炷���ɓ]�Ԃ悤�ɂȂ����B(^_^;)�@���܂܂ł̓J�[�y�b�g�̏�ł̓X���b�v���Ă��Ȃ��悤�Ɍ����Ă����̂����ǁA���͔����ɃX���b�v���Ă��ȁ[�ƁA�v���Ă�B�@�^�U�̂قǂ͂킩��܂��B�B�B�@���s���艻�̑�������Ȃ��Ƃ����Ȃ��悤�ł��B

���S���U����

������v���O�����A���X�H��B

�O���͍���őł��~�߂��Č��������ǁA���ʃe�[�v�ʼn��ǂ߂��Ă���㓪���J�o�[�������Ƀy�����Ɣ�����ċC�ɂȂ�̂ŁA�Œ�p�̃l�W�����J�����肵�Ă����B���łɑ��̃J�o�[�Œ�p�̃l�W�����J�����肵�āA���\�ȍ�ƂɂȂ����B�@�ȂA���̃J�o�[�͂��ׂĎ��O���A�����i�����O���Ȃ���Ȃ�Ȃ������̂ő����قڕ�����ԁB

�v���O�����̍��Ԃɂ������������肪�[�ь�܂ł������Ă��܂����B�@�ł��A�܂��Ƃ肠�����A�Œ�ł��镔���̓l�W�Œ�ł����̂ŋC���I�ɂ͂������肵���B

���샋�[���̃C���v���ɂ��ẮA����ς�O���t�@�C���Ƀ��[�����L�q���Ă���ɏ]���āA���f����悤�ɂ����B�v���O�����ɒ��ڃC���v������ƃR���p�C�������������ƏC���ł��Ȃ����Ă̂͂�͂�s���B�@���ƁA�f�[�^�\���ɂ��Ă����_�C�i�~�b�N�ɏC�����邱�Ƃ��\�����B

�ǂ̒��x�̋L�q���e���K�v���l�����̂����A���\���G�ɂȂ��Ă��܂����B

��{�I�ɂ́u���s�����R�}���h�v�@�u�������ϐ��Ȃǁv�@�u��֓���v�@�Ƃ����L�q�B�@������L�q���邱�Ƃŕ��G�ȏ�����\������B

�������ϐ����Ă̂̓O���[�o���ȕϐ��͂��ׂė��p�ł���̂����A������Ƃ��̓v���O�������K�v�Ȃ̂ŁA�l���Ă��Ȃ������ϐ����R���p�C�������ŏo�������邱�Ƃ͂ł��Ȃ��B

�ϐ����m�̉��Z���K�v�ŁA�@�C�R�[���i���j�@�m�b�g�C�R�[���i�I���j�@��Ȃ�i���j�@���Ȃ�i���j�@���炢�͗p�ӂ����B�@�����̏����債�Ă�AND��OR��\���ł���B�@OR�͕����s������������K�v�Ȃ����������B

���[���̋L�q�͂���Ȋ����B�@�L�ڂ̖����Ȃ�R�}���h�͂��̂܂��s����B

WALK lb_walk&fb_now!fb_cmd'WALKOFF�@�@���@���A���ɕ����Ă��āA�i�s�������t�Ȃ�~�܂�B

WALK lb_turn'WALKOFF�@�@�@�@�@�@�@�@�@���@���A�^�[�����Ă���Ȃ�~�܂�B

WALK qm_on'CLEAR�@�@�@�@�@�@�@�@�@�@�@���@���܁A���[�V�����Đ����Ȃ�R�}���h�͖����B

WALK poschk,walk'POSSET,walk,fb_cmd�@�@���@���s�p������Ȃ���A���s�p���ɂȂ�B

TURN lb_turn&rl_now=rl_cmd'WALKOFF

TURN lb_walk'WALKOFF

TURN qm_on'CLEAR

TURN poschk,walk'POSSET,turn,rl_cmd

�����ĂȂ������痧���オ����Ă̂������Ȃ��B

�\����͕���������Ȃ蓮�����̂ŁA�x�e���čH�삵�Ă������ɂȂ��Ă��܂����B�@poschk ����POSSET�̂�������ǂ�����ăC���v�����邩�Y�ݒ��ō������ɂ̓R�[�f�B���O�ł����B�ŋߖZ�������ăE�B�[�N�f�[�̓R�[�f�B���O�ł��Ȃ������Ȃ̂Ŋ����܂ł͂�������������낤�ȁ[�B

���S���V����

�\�z�ʂ�Ɏc�ƂŋA��̂��x���Ȃ����̂����A�v���O������i�߂鎞�Ԃ͎�ꂽ�B�@���샋�[����͎��s�����̃R�[�f�B���O�����Ə����Ŋ����B�@����A������B���샋�[�������̓R�[�f�B���O�I���B�@���Ƃ͓��샋�[���̎��s�p�ɃR�}���h��lj����Ȃ���Ȃ�Ȃ����̂����������邾���B

���[���̋L�q�������ς�����B�@�����܂łɂ͂܂������ς�肻�����B

WALK lb_walk&fb_now!fb_cmd'WALKOFF

WALK lb_turn'WALKOFF

WALK qm_on'CLEAR

WALK poschk,data[0],data[2]'POSSET,1000,data[0],data[2]

TURN lb_turn&rl_now=rl_cmd'WALKOFF

TURN lb_walk'WALKOFF

TURN qm_on'CLEAR

TURN poschk,data[0]'POSSET,1000,data[0],data[2]

�����Ă����R�}���h��K�v�ȃf�[�^��W�J���p�ł���悤�ɂ����B

�����͖����B

���S���W����

�������c�ƂŒx���A��B�@�ŋߖZ�����̂����A�܂����ăw�g�w�g�Ƃ����Ƃ���܂ł͍s���ĂȂ��B�@�ǂ��炩�Ƃ����Ɣ]�����������Ă��āA�x���A���Ă��v���O���~���O�Ɏ��|����郂�`�x�[�V�������o��B�@�������g���B�@�ƁA�ۋC�Ȃ��Ƃ������Ă�����̂����̂�����������Ȃ����ǁB�B(�[�[;)

����m�F�����邽�߂ɍŒ���K�v�ȃv���O�����L�q�͊��������B�@���āA����m�F�ƃf�o�b�O�Ȃ̂����A�f�o�b�O�������Ă͂܂��Ă��܂��Ɩ���Ȃ��Ȃ��Ă��܂��̂Œ��Ӑ[������m�F���s���Ă������Ƃɂ���B

�e��������̃����N�������o�g�����Z���̑��݂�m��B�@�ف[�A�������ȁ[�B�@�����_�ɂł��邩�ȁH�@�����_�̕��̔F���͎�ɐF�̃J�^�}���ŔF�����邩��ł������ɂ��v�����ǁA�ǂ�Ȃ��̂��H�@����ɂ��Ă��A���������Ă�����ς�o�g���Ȃ�ł��ˁ[�B(^_^;)�@���W�R�����{�b�g�Ƃ��čl����ƃo�g����T�b�J�[�ŐV�������W�R���̐��E���L�������ƍl���邱�Ƃ��ł��邯�ǁA���{�b�g�Ƃ��Ď��������Ă���͂蓬���̐��E�ɕ��荞�Ⴄ��ł��ˁ[�B�@�������⑊�o���{�b�g�����탍�{���o�g�����B�B�B�@����������čU�����邾�����čl����ƒP���ȓ��삾����������₷���̂��H���������ߑ����čU������̂��Ă���ȂɊȒP�Ƃ��v���Ȃ����B�@�G���^���I�ɂ͂킩��₷�����Đ���オ����Ă������̒ʂ肾�Ǝv�����B�@��͂�l�Ԃ͐퓬�������Ă��ƂȂ̂��ȁB

�������瓮��m�F�ƃf�o�b�O�ɒ���B�@�_�����Z���Ƃ��\����́i���Ăقǂ���Ȃ����j������̂ŁA����m�F�͐T�d�ɐi�߂܂��傤�B

���S���X����

������Ƒ����A�ꂽ�̂ŁA������ăf�o�b�O���J�n�B�@��{�I�ȕ����͓��������܂����B�@���Ƃ̓��[���t�@�C�����[�������Ă����Ηǂ����Ă��Ƃł��B�@�܁A�㔼�g�̔�r�������܂������Ȃ��Ƃ��A�܂��܂������s�R�ȓ_�����X����܂��̂Ŋ��������킯����[����܂���B

����ł�����Ƃ��������ɋ߂Â��܂����B�@�����A�A�@�ŋ߂̃����_�͂߂�����]�т₷���Ȃ��āA�������삳���Ă��]��ł���ɂȂ肻���ł��B�@���J�I�ȃI�[�o�[�z�[�����K�v�Ȃ̂��A���s���艻�̂��߂̎d�g�݂��K�v�Ȃ̂��A���炭�͗����Ȃ̂��낤���ǁA�������������肵�Ȃ���Ύ�������ǂ��낶��Ȃ��ł��B

�]�|��g���痧���オ�胂�[�V�����N���A�@�o�b�e���[�Ď��ƃo�b�e���[��̏ꍇ�̃��[�V�����N�������肪�o������摜�F���Ɉڂ낤�Ƃ������肾�����̂����ǁA���s���艻����Ȃ̂��Ȃ��B�@��������������Ή摜�F���Ƃ̘A�g���s���āA���{�r�����[�h�����s�ł���悤�ɂ������Ƃ���ł��B

���S���P�Q����

�Ȃ��Ȃ����܂��s���Ȃ�����ł��B

���샋�[���ɂ��Ă͏������o�O�����Ă͍s���Ă���̂����A�ׂ��ȂƂ��낪�Ȃ��Ȃ����܂������Ȃ��B

�]�|��Ԃŕ��s�R�}���h�𑗂�ƁA�p���ɏ]���ė����オ�胂�[�V�������N�����Ă�������o���̂����A�p���̔��肪�_���B�@�p���̔���ɂ��Ă͐����ƑO�ɃR�[�f�B���O�����̂����A�v���O�����ǂ�ł��C�}�C�`�킩���B�@���܂��s���ĂȂ����牽���ԈႦ�Ă���낤�ȁB�@������Ƃ��͂�����Ɛ^���Ɍ������Ȃ��Ƃ����Ȃ��݂������B

���ƁA���s���_���B�@�����Ȃ����߂��B�@�O���b�v����悤�ɂ�����S�R�_���ɂȂ�܂����B�@���܂ŃO���b�v�����Ă��āA�������������Ă���Ǝv���Ă������猋�\�����ڂ�ł��B�@�Ƃ肠������ɐi�ނɂ́A���������ɖ߂��Ȃ�A���ǂ��ăO���b�v���߂��Ȃ��悤�ɂ���悳�����Ȃ̂����A�@�u�����[������ƈႤ����[�B�v�Ǝv�����������Ď肪�~�܂��Ă��܂��Ă���B�@�]�|��g��L���ɂ��āA�����Ă������オ���ĕ����悤�ɂ�������̂����A����܂�ɂ����肵�Ă��Ȃ��̂ɁA������Ȃ��Ȃ��`�B�B

���s���艻�̂��߂̍�͊�������āA�����Ă݂�������������̂����A����͂���ł���������g�݂����C�����B�@�����摜�F���ƘA�������ĕ����������C�����ƕ��s���艻�Ɏ��g�݂����C�����������āA������₵�ċ���̉ʂĂɃe���V����������������Ă�B�@������Ȃ��[�B

���S���P�R����

����̓��`�x�[�V����������ڂ��������ǁA�u�����͂�����߂��`�B�����͖��������B�v�ƌ��߂ĕЕt�����r�[�ɖ����A����낤�R����낤�ƂȂ��u���Ȃ���v���ċ`�����ɂ���������o�Ă����B(^_^;)�@�@�ł��������ɐ[��Q�������Ƃ��ĊJ����킯�ɂ��s�����A�u��邱�ƃ��X�g�v�������ďA�Q�B�@��邱�ƃ��X�g�iTODO���X�g�ˁj�����Ƃ��ꂾ���ň��S�����Ⴄ��ˁB�@�d���Ő؉H�l���Ė���Ȃ��Ȃ�Ƃ�邱�ƃ��X�g�������肵�Ă��ȁA�̂́B

�Ȃ����`�x�[�V���������߂����̂ō����͑��N���B�@������葁�N���������肷��B�@������萇�����ԏ��Ȃ������Ȃ��B

����A�������˂��o�O���C�����āA�����Ďp���l�̔��胋�[�`���̌������B�@���傱���傱�����đ�͎̂g����悤�ɂȂ����̂����ǁA������������������ꍇ������B�@��`�A�u�����v�ŐQ�Ă��鎞�A���̗����^��������Ă�Ɓu�������v����ɂȂ��Ă��܂��ȁB�@�ڒn�_����̎�i���Â����Ă̂��킩�����B�@���ςς��ƒ���Ȃ�������u�B

�@������u�������v�Ɣ��肵�Ă��܂��B

�����x�Z���T�[�Ŕ��f����Ⴂ������[��A���Č���Ȃ��ł��������ˁB�����E���p���Ȃ��Ɠ��̂͐�������������������ԂɂȂ��Ă�B����ł������Ă��������x�Z���T�[�̒l�������ᔻ�f�ł��Ȃ���ł��B

���ɓ]�|��g���[�V�����̌������B�@�R�����O�ɂ���Ă��̂̑����Ȃ̂����A�O���ɓ]�|�������̎�g�������ł��ĂȂ��B�������Ⴍ�āA���s����Ɗ�ʂ��猃�˂���̂Ŏ��p�ɂȂ�Ȃ��B�@�]�|��g������ړI�͊�ʂ����Ȃ��悤�ɂ��邽�߁B�@�Ȃ̂ŁA�r��O�ɏo���āA�炪�n�ʂɌ��˂��Ȃ��悤�ɂ��Ȃ���Ȃ�Ȃ��B�@�ŏ��͕G�𗎂Ƃ��]�|����͂��z�����Ď��Ԃ��҂��A���̂����ɘr��O�ɏo���Ƃ������@�������̂����A���ꂾ�ƁA�r���O�ɏo�Ă��A�����͋z���ł����A�ނ������ǂɂȂ��Ă��܂��B�@�Ȃ�ƁA�������̂��Ǝ�͉��ɐ��ꂳ���Đ��������Ȃ��A�r�͐L���đ̂��x����B�@���ꂾ�Ǝ�͐܂�Ȃ��̂����ǁA����o���̂��Ԃɍ���Ȃ��B���s����Ɗ�ʂŎ�g�Ȃ̂ōň��ł���B�@�@�ǂ��������̂��Ǝv���Ă����̂����A�ǂ��l����Ɛ������z������̂ɕG�𗎂Ƃ��Ă��Ă͂�����̂��B�@����L���ďd�S����ɂ��Ȃ���Ȃ�Ȃ��B��]���a���傫���Ȃ�Ƒ��x�͒x���Ȃ�B����L���������ᑫ��Ȃ��̂łܐ旧���ɂȂ��Đ������E���āA���̂����ɘr��L���B�@����͂Ȃ��Ȃ������B�@���ۂɕ������Ă����Ă��A�����Ƙr���o�܂��B�܁[100%�Ƃ͌����Ȃ����ǁA�܂��̂��̓}�V���ĂƂ����ȁ[�B

�@�ܐ旧���Ŏ��Ԃ��҂������ƁA�G�𒅂��ĒE�́B��ʌ��˂�j�~���������_

�]�|���Ă����Ԃŕ��s�R�}���h�𑗂�Ɨ����オ���ĕ����o���͂��Ȃ��ǁA�����オ�����r�[�ɑ��|���Ă܂������オ�胂�[�V�������n�߂��Ⴄ�B�@����͗����オ�������_�Ŏp���l�����āA�i�����Ă���̂Ɂj�]�|�p�����Ɣ��f���Ă��܂��ė����オ�胂�[�V�������N�����Ă��܂��P�[�X�B�@�����x�Z���T�[�̃m�C�Y�̖��Ȃ̂��A�p���l�̌v�Z�̖��Ȃ̂��܂��������Ă��Ȃ����ǁA���̃P�[�X���Ɠ]�|��g�������Ȃ��̂ł�낵���Ȃ��̂��B�@������Ȃ�Ƃ����Ȃ��Ǝg���Ȃ��Ȃ��B�@�i����H�Ȃ�œ]�|��g���N�����Ȃ���H�H�@�ǂ��l����Ƃ��������ȁH�j

����̓E�F�C�g�����ăZ���T�[������悤�ɂ��������x�͈��肷��Ǝv���̂����ǁA���ꂾ�ƂȂ��ʔ����Ȃ��B����������ƃ_�C�i�~�b�N�ȕ��@�őŊJ�������̂����A���܂�Ƃ��A�C�f�B�A���`�ɂȂ��ĂȂ��B�@�����x�Z���T�[���g���Ă��܂��Ď�����Ε��s�̈��艻�Ƃ��A���[�V�����Đ����̓���̐��퐫�̊Ď��Ƃ��A���{�b�g�ɂ�����g�̊��o��^��������@�����肻���ȋC�����Ă���B

���s�̕��͐����ƃ}�V�ɂȂ�܂����B�@�l�W����߂Ȃ����āA���s�p�����[�^��������Ƃ��������肵�āB�@�����O���Ƃǂ����ȁ[�B���T�������Ċm�F���Ă݂悤�B

�������Ă������āA���������肱�������藧���オ�点���肵�Ă�ƁA�h���͔�����́A�J�o�[�͊����͂ŁA���\�{�����Ȃ��Ă��܂��܂����B�ł��A���炭�͂��̂܂܂��ȁB�C���ł���Ƃ���͏C�����āA����鎞�ɂ͉��ǂ��Ċ������炵�܂��傤�B

�F�X�ƈ��肵�Ă��Ȃ��̂ŃX�g���b�v�����ē������Ă܂��B�ŁA���������ɂȂ�����X�g���b�v�ł������ƂЂ��ς�����B�@�����ɍ����ď���������Ă���ǁA�������ɍs�������{�b�g���X�g���b�v�łЂ������Ă�����B�@����Ȃ��Ƃ��Ă���Ƃ��Ƃ��n���h�����Œ肵�Ă���l�W�̃^�b�v�����ł��܂��܂����B�@�����B�B�@��ԃx�[�X�̕��i�Ȃ̂ɂȁB�i�b�g���Ƃ�����Ɠs���������ʒu�Ȃ̂ŁA�i�b�g�v���[�g�Œ肷��悤�ɉ������Ȃ���Ȃ�Ȃ��B�ӂ��B

���S���P�T����

�p������̉��ǁB�@�����x�Z���T�[�Ŕ��铷�̂̊p�x�Ɗߊp�x���g���Ăǂ�Ȏp���ɂȂ��Ă���̂����v�Z���܂��B�@�ŁA���̂̃`�F�b�N�|�C���g���ǂ̈ʒu�ɂ���̂��œ]�|���Ă���̂��ǂ����肵�܂��B

���܂ł͑������ɐG��Ă���O��Ōv�Z���Ă����̂ł����A���������Ă���ꍇ������̂ł��̃P�[�X���܂߂Ĕ���ł���悤�ɂ��܂����B�@���łɁA���܂ł͑O��Ə㉺�̂Q�����̍��W�Ōv�Z���Ă����̂��R�����̍��W�Ōv�Z����悤�ɂ��܂����B���]���ĂĂ�����ł���悤�ɂȂ�܂����B

�@�@

�@�@ �@�����Ȃ��������܂߂ĂP�U�|�C���g

�@�����Ȃ��������܂߂ĂP�U�|�C���g

�ڒn�_�ɂȂ肻���ȂP�U�|�C���g�ɂ��Ďp���p�x������W�����߂܂��B

����Łu�����v���u�������v�Ɣ��肷��P�[�X�͌������܂����B�@�E�E�E�܂����܁[�ɊԈႦ��B�@�~�܂��Ă����Ԃ���ԈႦ�Ȃ��̂����ǁA�����Ă�ƃ_�����ۂ��ł��ˁB�@�g���Ă���Z���T�[�������x�Z���T�[�Ȃ̂ŁA���쎞�͏d�͈ȊO�̉����x�����m���Ă��܂��܂��B���̃f�[�^�Ŏp���p�x�肷��Ǝ��s�����Ȃ����Ǝv���Ă��ł����A�����Ă����Ԃł̂ł����ƂȂ̂łȂ��Ȃ��K�������߂܂���B�@�@���A�����Ƃ��������ԈႦ�Ă�킯����Ȃ��āA�����A�]�|��ԁi�O�j�Ɠ]�|��ԁi��j���ԈႦ��Ǝv���܂��B�@�]�|��ԂƂ����̂͗����Ă�����ǁA�d�S���x�����p�`�ɓ����Ă��Ȃ��ė����Ă����Ȃ��p���ł��B�@��𒅂��Ă��邱�Ƃ肷��ΐÓI�Ɉ��肵�Ă���̂��ǂ�����ł���͂������ǁA�����܂ł͂܂�����Ă܂���B

���ƁA�����オ������̎p������ŁA�����Ă���̂ɓ]�|��Ԃƌ딻�肷��P�[�X�ŁA�����x�Z���T�[���ӂ���Ă���̂��Ǝv�����̂����ǁA�ǂ���炻��͈Ⴄ�炵���B�@�]�|����̔������������Čv�Z��A1�~���ł��x�����p�`����o�Ă���Γ]�|�p���Ɣ��肵�Ă��܂��B�@�����x�Z���T�[���瓾���f�[�^�ł̎p���Ȃ̂ł���Ȃɐ��x�Ȃ����炿����ƌ���������悤�ł��B�@�����͔����������ƊÂ����Ă����܂����B

���̑��A���i����J�[�u���s�ւ̐�ւ����ɂ͎p����������Ȃ��Ƃ��������������������Ă���������������悤�ɂȂ�܂����B

�U�X���艻�d���Ńf�o�b�O���삳������Ƀo�b�e���[�œ������Ă݂���A������s���S�R�ł��Ȃ��B�@�����A�G���M�_���N�����Ă邹�����Ǝv�����ǁA�M�_���Ŏp��������Ă���̂��t�B�[�h�o�b�N�ł���悤�ɂ��Ȃ���Ȃ��ł��ˁB

������Ɨ�܂��Ă��瓮�����Ă݂���A������s�͂�����ƃ}�V�ɂȂ�܂����B�@�����ǁA�O���]�|��g���܂��_���B�@�_�����Ă̂̓��[�V��������Ȃ��ē]�|���肪�_���B�@���[�V�����̔������x���ĊԂɍ���Ȃ��B�����Ɋ�ʂŎ�g�ł���B�@�v���Ԃ�Ɏ�̃l�W�q���[�Y����Ⴂ�܂����B(�[�[;)�@�T�[�{�����^���M�A�ɂ��Ă���̓M�A����Ȃ��Ȃ����̂ŁA�v���l�W���Q�{����S�{�ɑ��₵�Ă����̂łȂ��Ȃ���܂�ɂȂ�Ȃ��������ǁA�������ɓx�d�Ȃ��ʎ�g�͑ς����Ȃ������炵���B

�]�|����������ƃ_�C�i�~�b�N�Ȏ�i���Ƃ�Ȃ���ˁ[�B�@�܂��߂ɍl���悤�B

����Ȃ���Ȃł܂���������^�����\�ƂȂ����킯����Ȃ��̂����ǁA���낻���ʃ��C���[�̎������������悤���ȁ[�Ǝv���Ă܂��B

���S���P�V����

����͖����܂ŏo���B�@�A��ɏ��������H�t���ɂ���Ă��ł̔��������������B�@���j�������A�����V���߂��Ă����A�ړ��Ă̓X�̊���͕܂��Ă����̂����Œ���̔������͂ł����B

���̌�A���܂ŋA�蒅�����Ƃ���ň��݂̗U���B�@���������X�ɏo�Ă��Ĉ���ł܂����B�@�Ȃ�������d�Ԃɏ���Ă��C���B

�@

�����ċA�������i��RPU-100��AC�A�_�v�^�[�œ�������悤�ɂ��܂����B�@�Ƃ��낪�A�o�b�e���[�R�l�N�^���܂�����s�Ǖi�B�@(�[�[;)�@����̓n�E�W���O������Ă����Č����������Ă݂܂����B

����ƁA�R���^�N�g�̏�Ƀn�E�W���O����̃o������������Ă��āA���ꂪ�R���^�N�g�̐ڐG��j�Q���Ă����炵���B�@�o�����J�b�^�[�ł���������A�����ƂȂ���悤�ɂȂ�܂����B�@�������A�n�E�W���O���������Ă��܂����̂ŁA�ςȕ����ɗ͂�������Ɠd�����������Ⴂ�܂����B(^_^;)�@���S���Ă����ˁ[�ȁB

�X�ɂ�AC�A�_�v�^�[�͂S�`���m�Ȃ̂ŁA�T�[�{��������d�����������ă��Z�b�g��������܂��B�@�܂�����͗\�z�ǂ���B�@�T�[�{�����Ƃ��̓��|���Ȃ������킯�ŁA�ݒ���Ȃ�������Ƃ���AC�A�_�v�^�[�œ������o�b�e���[�����_�ɏ��Ղ��Ȃ��Ă��ށB�@�{���͓d���̂Q�n������g�ݍ��߂ΐݒ莞��AC�A�_�v�^�[�ōs���A�������Ƃ��Ƀo�b�e���[�ɑ����ɐ�ւ���B�Ȃ�Ă��Ƃ��o����̂����B�ŁA���ꂪ����Η��K��ɂ͈��艻�d�������čs���Ȃ��ōςނ��ȁ[�Ǝv�����̂����A�Â����B�@�������ɂȂ��ł邤���̓o�b�e���[�̏[�d���o���Ȃ����A������Ɛ����炸�Ȋ������ȁB�@�܂�������g�����Ƃ����邩������Ȃ����炨���Ƃ����B

���S���P�W����

�����͗��̒��A�R���֏o���B�@���}��������1���Ԃ��x��Ă��Ďw��Ȃ�����Ă��̂ɖ��ʂɂȂ��Ă��܂����B�@���삩����}�������ɏ�낤�Ƃ����炿�傤�ǂP���ԑO�̃J�C�W�����ďo����ւ͎��Ԓʂ�ɍs�������ǁA���̐l�������W�܂炸��c�͎��ԕύX�B�@�A��̎��ԂɂȂ��Ă��܂�������ƒx��Ă܂����B�@���ς炸�앐�������������V��Ɏア�Ȃ��Ƃ��v���Ă�����{���ɑ�ςȗ��������炵���e�n�ł̍ЊQ�͑����Ȃ��̂������݂����ł��B�@�`���C�x�ꂭ�炢�ōς�ł悩�����[�B

�����̓h���}������A�V���}���K�ǂ肵�Ă��������̂Ń������͋x�Ə�ԁB�@�]�|���肪�C�}�C�`�Ȃ̂��ǂ����邩���Ă̂ƕ��s���艻�̂��߂̎d�g�݂��ǂ��ɂ��������ȂƎv�Ē��B�@�]�|�̒��������ɂ߂�Ƃ����l�������A���s�𑱂����邩�ǂ����肵������������Ȃ����Ǝv���n�߂Ă�B�@���s���̂��A�����^�C�~���O�œ��������ŕ���������̂ł͂Ȃ��A������t�B�[�h�o�b�N����悤�Ɏ��̈�����o���悤�ɂ������B�@�ŁA���̈�����o���Ȃ���Ԃ��Ă͓̂]�|�Ɣ��f���Ă悢�̂ł́H�@�Ƃ��������B

�����̃A�C�f�B�A�͂���������̂ő�����b�f�[�^������Ă݂悤���Ǝv���Ă������ǁA�����͋x�Ə�Ԃ������̂ŁA��̓I�Ȑi���͖����B�@���������K��ł����������ݓ�������Ƃ��ł�����ȁ[�B

���{����HP�ł���`�����{�b�g�v���W�F�N�g�̐������\�����������Ƃ��̂ނނ���Ƃ��Œm��B�@���Ă݂͂����ǁA������ƈႤ���ȁ[�B���{�J�b�v�z�[���̕��������ł��镔���������B�������͂Q�����s����Ȃ��Ă��������ǁA�V���Ƃ��W���[�X���Ƃ��Ă���Ƃ��A�t���ė���Ƃ��A�w���ɏ]���Ƃ��Ȃu�����v�����������邨��Ȃ̂ŋ����ł���B����σG���^�������Ȃ̂��Ȃ��`�B

�����̗��K��B�@��ڂƂ܂͔���ɂ����ꏊ�炵�����Ė����s���������ǂ����S�z�B�@�������s�ɂ����͎��M������̂ŁB�B(^^�U

���S���Q�O����

����͊֓��g���K��ɍs���Ă��܂����B�@��ڂƂ܂ɂ͂ł��������O����݂��Ă����āA���ł��o�g�����J�n�ł���悤�ɂȂ��Ă��ł����A�����_�N�i2�j�ɂ͂܂������B�@�������ɂ����Ă���X���[�v���X�e�b�v���̃G���A�œ��������肵�Ă܂����B

�����̃O���b�v�̓����O�f�ނł��\���B�@���܂������Ȃ��Ȃ�قǂ̈З͂ł��B�G���X�g�}�A���炢�B�@�O���b�v���\�����ƕ��s�̂������������I�悷��B�@���ɐ��삪�s����ɂȂ�܂����B�@���Ȃ����܂ł͒��i�����肵�Ă��̂ɁB(�[�[;)

����͂����ɂ��܂��Č��w�҂̕���ŎQ�����Ă���܂����B�@�����O��ڂ̑O�ɂ��������Ȃɐw����Ă݂�Ȃ̗��K�̗l�q�߂A���s�̃��O��������肵�Ă��܂����B

���A�ł�������O�i�������Ƃ�����܂����B�����Ȗ�]�Ȃ̂ł����ł͏����Ȃ��̂����ǁA1���O�i�ł��B(^�B^)�@��]�B���̂��߂���邼�[�B

�@

�����͍���̃��O������s�̈��艻�ɂ��Ă̍l�@�����悤�Ǝv���܂��āA�l������������Ă݂���B

�����ꂪ���K��Ŏ�������s���O�B

1����0.3�b�ŕ������Ă���̂ł����A�u���[�̔g�`�����̂����E�ɗh�炵�Ă���l�q�B�@����ɑ��ăs���N��Y���ެ�ۂ̒l�ł��B�ϕ����Ă���̂ʼn�]�p�x�ɂȂ��Ă܂��B�@�����ƈʑ�������Ă���̂�����Ǝv���܂����A���ׂ��Ƃ��듯�����ĂȂ��킯����Ȃ��A�ʑ��Y���������Ă�炵���B

�����Ė��͉��F�̃��C���B�����Z���ެ�ۂ̐ϕ��l�Ȃ̂ł����A���̂������ƃ��[�����Ă��܂��Ă���̂��킩��܂��B�@������X����]��Y����]�����ʑ��B�@���ꂪ���ۂ��ł��ˁB

����A���̃��[�����������Ƃ��l���悤�B�@���̂܂��ɃT�[�{�͂����ƒǐ����Ă���̂����m�F�B

�ӂށB�B�B�@����Ă͂��邯�ǒv���I�ɂ���Ă���킯����Ȃ��B���2�R�}�x��Ă���̂�50ms�Ƃ����Ƃ���B�@���m�ɂ�25ms�ȏ�50ms�����Ƃ����Ƃ���ł��傤���B�@�}�s�ȕω��ɑ��Ă��قڂ��Ă��Ă���悤�Ɍ�����̂ŃT�[�{�̔������x��Ă��邽�߂Ɉʑ������o�Ă���킯����Ȃ������ł��B

���Ȃ݂�J1�`J6���w���l��A2�`A6�Ă̂����ۊp�x�ł��BJ1���J3���͕ω����Ȃ��̂Ŏ��ۊp�x�̃f�[�^�͖����B

�ŁA���������͐F�X�Ǝ��������肵�ă��[�����������Ƃ͂ł��Ȃ��������Ă݂��̂ł����A���ʂƂ��Ă͂��܂̂Ƃ�������Ă܂���B

���[���̌����͂ǂ����d�S�_�ɑ��ė͂�^���鎞�ɐc���O���Ă��܂��Ă���̂������̂悤�ł��B�X�C�[�g�X�|�b�g�͂����đł�����������Ċ����B�@��̓I�ɂ́A�������߂ɏd�S�_���ߑO�ɉ����o���̂����ǁA���̈ʒu�̊W���炿����Ƃ��ꂽ�ʒu���牟�����ƂɂȂ�A�d�S�_�Ƀ��[�����g���������Ă��܂��悤�ł��B

���ꂪ�A�ł��邾���X�C�[�g�X�|�b�g�������悤�ɂ������s�B���E����̈ʑ��Y���͎�����0.4�b�ɂ���Ȃ��Ȃ�܂��B�@���F��Z���ެ�ےl���s���N�ɓ��������ɂӂ�ӂ炵�Ă���̂��킩��Ǝv���܂��B�@�ł��A�����͂�������15�~���B���ꂶ��悿�悿�ɂ���������B�@���Ȃ݂�20�~���ɂ����烍�[�����������܂����B

��Ƃ��ẮA�������Ă��܂����[�����g��ł��������[�����g��������Ƃ����̂��L�͂��낤�B���ɂ�Z���܂��̊������[�����g���ł��邾���傫�����āA��]���ɂ���������Ď�����邩�ȁB

���E����̈ʑ��x��ɂ��Ă͎�����0.4�b�ɂ���Ί�{�I�ɂ͉����B�ł��A�ł���Ύ���0.3�b�ł��ʑ��x����N�����Ȃ��悤�ɐ��䂵�����B�@�@�B�I�ȍ������グ��Ƃ����̂��������̂�������Ȃ����A����������ȁ[�B�@�����_�T�C�Y�ɂȂ����獄���łȂ�Ƃ��Ȃ���̂���Ȃ��C�����邵�B

��ԊȒP�Ȃ̂͑������X���b�v�^�C�v�ɂ��邱�ƁB������������[�����ɘa����Ǝv���܂��B�@�ł��A�A�A�@�̂̂��炢�l���u������������ǂ����悤������܂���B�i����ł��܂���j�v�ƌ����Ă܂����B�@���ׂ�ʂ��Z���X�ł��Ȃ��̂ł��B

���ł��A�`�������e�̑����͂�������ȁB�B(^_^;)

�������B�����Œm�������J�i���z�C�[���B�@����~�����B�@�I���j�z�C�[������_���Ȃ�ł��B�@�����ĂȂ����Ȃ��B1��1���~���炢�Ȃ甃�����ǁB���Ȃ��Ⴞ�߁H��������ȁB

���S���Q�R����

����A�����ƈ��݉���B�@���͖���������������݉�Ȃ̂ŃE�B�[�N�f�[�ʼnƂŗ[�т�H�ׂ�͍̂�������(^_^;)

�ƂɋA��ƒ������Ă���G-ROBOTS�p�̃R���g���[���Ǝ�M�@���͂��Ă܂����B���킹��12000�~��B�@�����_�Ƀ����R�����邱�Ƃ��l���Ă͂������ǁA���W�N�[����PS2�R���g���[���ƂȂłȂ����Ă̂��퓅���ȂƎv���Ă܂����B���ǁARPU-10���g���ā`�A�Ƃ������Ƃ��l���Ă���̂ł������ɂ����p�ł��邱�����ɂ��܂����B�@

�ł��ARPU-10���Ȃ������M�@�̓d���d�������킩��Ȃ��B�o�b�e���[�d���̂V�D�S�u������H����Ƃ�RPU-11�̒��ō����5V�Ƃ�3.3V�Ƃ��œ����̂��ȁH�@�������M���ڑ����s���B�ǂ�ȐM���ő���M���Ă��B�@�R���g���[���Ƀo�C�u�̃X�C�b�`��������Ă��Ƃ͑o�����ʐM���ł����ˁA����B�@�l�b�g��T���Ă݂����ǁA����̉�͂���Ă�l�͌�������Ȃ������BSISO����A�m���Ă��狳���ā`�B

�f����RPU-11�������̂����ǁAATMEGA128�Ȃ�x�X�e�N��ATMEGA128�{�[�h��RS485�Ƃ������x�Z���T�[���Ȃ������킯�����炻�����̕����������ȂƂ��l���Ă��܂��B�@�E�E�E��������A���Ԃ����Ŕ��������������͂��Ȃ̂����A�A�B

�R�l�N�^�͂U�s���B�����Q�{�͓d���ƃA�[�X���Ƃ���ƐM���ڑ��ɂS�{�g���Ă�B�@���肪ATMEGA�����ARPU-11�̓V���A���|�[�g���Q�|�[�g�����Ă邯�ǁARS232C��RS485�ɂ��ꂼ�ꊄ�蓖�ĂĂ���ƍl����ƁA������I2C��SPI�i�������H�j������̃V���A���ʐM�ڑ����ȁHI2C���ƐM�����͂R�{�Ŕ���d�ʐM�ł���B�P�{�]��ȁB�B�B�@���ׂ��SPI���R�{�炵���B

�����I2C�Ƃ�SPI�Ƃ��悭�m��Ȃ���ˁB

�@

���T�B��̃��{�b�g�������������̂����A����Ȃ���Ȃł�����������Ă��玞�Ԃ��Ȃ��Ȃ��Ă��܂����B���[���̗}����̌����͏T���܂Ŏ����z���B�@�f�v�˓���[��B(>_<)

���S���Q�V����

����͓�������ň���ڂ��`���Ƃ��Ă���܂����B���������̋x�������ʂɁB�B�B�@���j���̈��݂݂͂�Ȓ�������Ⴄ�̂ł����y�[�X�Ɉ������܂�Ă��܂��B���d���˂B

���[����}�����i���l���邽�߂ɕ��s���̃��O�߂ċC�����܂����B���[���̔����͑����グ��^�C�~���O�Ƀ����N���Ă���炵���B�d�S�̃Y�����匴�����ƍl���Ă����������グ����Ԃł͏d�S�̂���i���̏ꍇ�͏d�S�_�ɓ��������x���e������̂����j���V�r�A�ɂȂ��ɑ����グ��Ƃ�������̔������������߂��낤�B

���オ�����グ�Ȃ��ō��E�ɂ���炳���������B�@���̂�20�~���قǑ����グ�đ�����

���F�̃��C�����y����]�p�x�������B�@�����グ��ƑO�i���Ȃ��Ă���]���삪�������Ă��܂��B

�ŁA�����}�����i�����A�����^�C�~���O�ŋt�����ւ̃��[������������悤�ȓ���������Ă݂�A�Ƃ������ƂŘr�̐U�������Ă݂��B

�s���R���Ə㉺�ɏo�Ă�̂��r�̐U��Ŕ����������[���B�����𒅂�����ԂȂ̂ŁA�p���X��ɂȂ��Ă��܂��Ă���B

��������̂͌��\��J�ŁA�P�ɑO��ɘr��U�����������Ⴑ��ȕ��ɂȂ炸�Ɏ~�܂������̔��������[���ɂȂ��Ă��܂��B�Ȃ̂ŁA�u�����ƐU���āA�ӂ���Ǝ~�߂�Ƃ������Ƃ����Ă���B�@�n�߂͂����Ȃ�悤�ȃJ�[�u���Č��������̂����A�������ł��Ă��܂��Ȃ��B�@���ǂ̓u���ƐU���āA���̌�Ƀg���N���Ĕ������������Ȃ��悤�ɂ����B

���ʂ̂o�v�l�T�[�{��PWM�̎��g���������邾���œ������Ƃ��ł��邩�ǂ����͂킩��Ȃ��B

�ŁA���ꂪ���グ10�~���̃f�[�^�ɘr�U��f�[�^���d�˂Ă݂��Ƃ���B����ȎG�Ȋ����ő��E�ł���̂��ǂ����͂킩��ǁA����Ă݂邩�[�B

�E�E�E�E�E

�Ƃ肠��������Ă݂����ǁB�B

�L�����Z���ǂ��납�Ђǂ��Ȃ��Ă�B�B�@�ׂ�ڂ��Ȓ��������������Ƃ̓}�V�ɂȂ邩�ȁH�@

���Ƃ��Ƃ́A�����Ă��鎞�̃��O�ł͂���Ȃɖ���ł��������͂��Ă��Ȃ��B�@�قڎO�p�g�ɂȂ��Ă����B�܂�̓K�c���Ƃ����Ռ��ł͂Ȃ��A�����[���Ɖ�]���Ă���킯���B�@������ƃA�v���[�`��ς������������̂�������Ȃ��B

���S���Q�X����

���낢�낢�낢��ȃp�����[�^�����ă��[�������}�����悤�Ƃ���������Ȃ�Ƃ͗}���ł��Ȃ��B�@�����A�r�̐U������܂��g�����Ƃŕ����o���̏d�S�_�̉����Ɉ�����Ƃ��킩�����B�@�d�S�_�̉������ł���A�V�r�̗��n�^�C�~���O�𑁂����邱�Ƃ��ł��āA����͂܂������傫���o���邱�ƂɂȂ���B�@���̃v���O�����͕����o���̘r�̐U�肪���܂��Ȃ��Ă���������ƃv���O�����̍�肱�݂��K�v�B

���ꂱ�ꂢ��������A�ł��Ȃ������͈��肵�����s�p�����[�^�������邱�Ƃ��ł����炵���B�@���̓��ɓ����p�����[�^�œ���������S�R�_�����Ă��Ƃ����X����̂ł����́u�炵���v���Ă��ƂŁB

�@

���s�͌ߑO���̂���ŁA�ߌ�̓v���O�����S�̂̃v���Z�X�Ǘ����������邱�Ƃɂ��Ă����̂ł���Ɏ��|����B

�C���^�[�o���^�C�}�[���g�����V�O�i���n���h�����g���ăT�[�{�Ɏw�����o���Ă����̂����ǁA�v���Z�X�Ǘ��I�ɂ͂ǂ��Ȃ̂��H���Ă̂������ƋC�ɂȂ��Ă����̂ł��̌��ƌ����B

�܂���25ms�������Ă̂������ƒZ���ł��Ȃ����̂��Ƃ������ƂŃV�O�i���n���h���̏������Ԃ𑪒�B�@���Ȃ݂Ɋߊp�x�̎擾����؍s��Ȃ����15ms���炢�ł͉�B

25ms�i25000�j�̃��C�����ȒP�ɏ����Ă�I�@�ǂ��������̂��B����͉摜�������[�`���̏������[�v��usleep(0)���������[����ꂽ�o�[�W�����B����������ꂷ���ĂP�t���[���̉摜������0.2�b����0.5�b���炢�������Ă�B�@��w�����v���O���������ڌ����Ȃ̂��Ǝv���Ĕ�r�����肵�����A�摜�����v���O���������Ȃ��Ă�����܂�ς��Ȃ��B

�ŁA����̓����_�̃v���O�������ŗD��œ����������B�摜�����͖����B�@���ꂾ��25ms�Ɏ��܂�B20ms�ł����v���ۂ��B

���낢�뒲�ׂ����ʁA�q�v���Z�X�͐e�v���Z�X�Ɠ����D��x�Ƃ������Ƃ��킩�����B�Ȃ̂ŁA�ő��ɂ��Ă��摜�����v���O�����������ƊԂɍ����ĂȂ��t���[������������o�Ă���B

�����̍Ō�̃f�[�^������B�@�T�[�{����͍ŗD��(-20)�ŁA�摜�����͕���(0)����ł������Ђ����o�Ă��܂��B�@�ł��A��������́A�T�[�{�͉e���Ȃ������Ă��銴�����B

�ŏ��̂�舫���Ȃ��Ă���悤�Ɍ����邪�A�摜�����v���O�����ɂ��قǂقǂɂb�o�t�^�C�����Ă��邽�߂��Ǝv���B�@�{�[����ǂ������_�̎�̓������ȑO���y�₩�ɂȂ����悤�ł悢�����B

�ł��ł��A���̏�ɉ��������Ɖ����F�������̂͂b�o�t�p���[�I�ɂ̓������ۂ����A����ȃS�c�C�b�o�t��������l�߂�͂��������A�����̓��\�[�X�����܂��z�����Ă�肭�肷��悤�ɂ��邵���Ȃ��ł��傤�ˁB�@�@�T�[�{�@�A�摜�@�B���������@�C�����F���@���̒��Ŋ��S�ɓ����ɓ������˂Ȃ�Ȃ��̂́@�@�T�[�{�ƇA�摜�A�@�����F���������ɂ�肽���Ƃ��낾��������Ɩ������ۂ��B�@���������A�摜�D�悾�낤�ȁ[�B�@���Ƃ̓V�`���G�[�V�����Ő�ւ��ă��\�[�X�g�����ƂɂȂ邩�ȁB

����͂����ƁA�������݁A�T���T���̗��K����ĎQ���\���҂�������Ȃ���ł����ǁA����͌��s������ł��傤���B�@���{�J�b�v�W���p���I�[�v���̃q���[�}�m�C�h���[�O�̌����g�[�i�����g�Əd�Ȃ��Ă�̂łǂ��������̂��Ǝv���Ă��̂����ǁB�B

���{�J�b�v�Ƃ����A�q���[�}�m�C�h�T�b�J�[�͎��͂���܂茩�����Ȃ��B�Ȃ̂łǂ����ςɍs���Ȃ獡���ڌ����̃z�[�����[�O���ςɍs���������������ȁB�z�[�����[�O���ƂS���ƂT���B���Â܂Œʂ��̂͂���Ƃ���ǂ��̂łǂ��炩��������ɂȂ�ł��傤�B�@�S�����{�b�g���[�O�����邯�ǁA����̓A�C�{�H�A�C�{�͋��N�ŏI��肩�Ǝv���Ă��̂����ǁA�ǂ��Ȃ����H

���S���R�O����

���āA�Ƃ��Ƃ���������̐v�ɓ���Ȃ���Ȃ�Ȃ��Ƃ������܂����B�@������肽���Ǝv���A���͂ǂ�����Ⴂ���̂��킩��Ȃ��܂܂Ȃ̂Ő�ɐ�ɑ����Ă����߂��Ȃ��ł͂Ȃ��Ƃ������ł��B

�����_�Ƀ��{�r�����[�h��������ɂ̓��{�r�����[�h�̃��[�����������ޕK�v�������ł����ǁA�ǂ�����ĕ\�����ׂ��Ȃ̂��H�H�H�@�o���邾���n�[�h�R�[�f�B���O�͔��������̂ŔY�݂ǂ���ł��B

�܂��́A�g���b�L���O�i�ڕW���𑨂���j�A�@�A�v���[�`�i�ڕW���ɋ߂Â��j�A�@���[�`���O�i�ڕW���Ɏ��͂�����j�@�Ƃ�������{�s����g�ݍ��݂A�����̏�����ǂ��\�����ׂ����A�Ƃ��A�u�ڕW����|���v�Ƃ�����ʃ��C���[�̖ڕW�s�����ǂ��\�����邩�A�Ȃǂ��������Ă��������Ǝv���Ă܂��B�@��������ȁ[�B

���T���Q����

�g���b�L���O�ƃA�v���[�`�̎����ɂ��Č������B

�u<�ڕW��>��<�|��>�v�Ƃ����w�߂̎������@��F�X�ƍl���Ă���̂ł����A������Ɣ��U�C���B

������̍l����������ƁA�u�ڕW���Ɏ��L�������͂��Ȃ��v�̂Łu�ڕW���ɋ߂Â��v�@�Ƃ��������ŁA���[�`���O����A�v���[�`���N�����āA�A�Ƃ����`���l���Ă����̂����A���ꂾ�Ɣėp�����Ȃ��B���铮����s�����тɃn�[�h�R�[�f�B���O���邩�A�R���t�B�O�̂悤�Ȑݒ���X�V���ă����N��悤�Ȏd�g�݂��K�v�B�@����������ƞB���Ƃ������_��ȃV�X�e�����C���[�W���Ă���̂ōX�Ɍ������K�v�B

���ɂ��A�v���[�`���Ă��āA�A�v���[�`���߂���艺����ꂽ�ꍇ�A�A�v���[�`�����������s��~���߂��o���Ă������̂��B�@�C���[�W�Ƃ��Ắu�A�v���[�`����Ƃ��Ă͕��s�̕K�v�����Ȃ��Ȃ����̂ŕ��s���Ă��炤�K�v�͂Ȃ��Ȃ�܂����B�v�Ƃ����A�������邾���Ŏ��ۂɒ�~���邩�ǂ����͕��s����Ō��߂Ă��炨���Ƃ����ӂ��ɂ��ׂ����ƍl���Ă���B�@�܂�A���s�̊J�n��~�ɑ��Ă��t�����g���K�v�ŁA�t�����g��ʂ��Ĉ˗�����ƁB�B

�A�v���[�`�w�߂��������ǁA���݃g���b�L���O���Ă��镨�͖̂����B�@����ǂ�����H�g���b�L���O�w�߂��o�������̂��Ƃ����Ɖ����g���b�L���O���ׂ������A�v���[�`���͒m��Ȃ��킯������A�A�@���[��B�B�B�@����͂����Ə�ʃ��C���[�̎d�����B�@�A�v���[�`�w�߂����Ă��g���b�L���O���ĂȂ���L�����Z�����ȁB

�S�̓I�ɂ͌���������̌`�����A������̐����㉺�W�@�ɂȂ�Ȃ��悤�ȋ����V�X�e���ɂ��Ȃ���Ȃ�Ȃ��B�@�E�E�E�����ށB�B�@�E�E�E�@�H�t���s���Ă��܂��B

���T���R����

����͏H�t���s���Ă��炻�̂܂܈��݂ɁB�B�B�@�����̓��͌ߑO���̓w���w���Ȃ̂�����ǁA���������̂f�v�ʂɂ������Ȃ������̂łȂ�Ƃ�11������ɂ͎��������č���̑����ɂƂ�������܂����B

�����RT��RPU-11���Ă��܂����B�C���[�W�������������ł��ˁ[�B�@�l����ƁARPU-11�̃v���O�������������RPU-100�ƂȂ��Ń����_�ɃR���g���[�����Ȃ������B

�H���ł���Ȃ݂̂��܂����B�n�[�t�s�b�`�̃��j�o�[�T����B�@��������肽����SMD���i�ʼn�H��g�ގ��A���M�����[�s�b�`�̃��j�o�[�T����ō��Ƃ���܂菬�����Ȃ�Ȃ��ł���ˁB�@��N�����قǂ���Ȃ������J���Ă܂����B�@�n�[�t�s�b�`�R�l�N�^�ƃZ�b�g�Ŕ����Ă܂����B

���āA����̑����Ńg���b�L���O�ƃA�v���[�`�̎�����i�߂܂����B

���̂Ƃ���̓��{�b�g�������o������������<�A�v���[�`>�����Ȃ��̂�����ǁA���̐�͂ǂ�ǂ�Ƒ����Ă���͂��B�@�����o����������Ȃ��A�Ȃɂ��̓�����s���̂͑���x�ɕ����̂��Ƃ͂ł��Ȃ�����i���m�������Ȃ�������Ƃ��A�����v�f���ȁj�����o����������Ȃ��A�Ⴆ�g���b�L���O�̉����ŁA���Œǂ������ɑ̂̌�����ς�����Ă̂�����ɂȂ�B���̗v�����͈����Ȃ����ǐ������͈�B�@�����ŁA�v�����o���āA�ᖡ�̌��ʁA�ǂ�����s���܂����ď������s�킹�܂��B

�A�v���[�`�͕K�v�ɉ����ĕ��s�̗v�����o������ǁA�^�[�Q�b�g�ɏ\���߂Â��ƕ��s��~�̗v�����o���B�@�ŁA��t���͗v���ɏ]���čs�������肷��̂����ǁA���Ƃ��A�v���[�`�������s��Ȃ��Ȃ��Ă��܂�����A���s��~���߂����Ȃ��̂ŕ��s���~���邫���������Ȃ��Ȃ��Ă��܂��̂��B

�Ȃ̂ŁA���s�̗v���͏�ɍs��������B�@�����ĕ��s�v����������������s���~����Ƃ��������ɂ��邱�Ƃɂ����B

����Ə��������G�ɂȂ��Ă��āA�Ȃ��Ȃ��o�O�����Ȃ������̂����A�i�Ȃ�������~���߂����s����Ȃ��Ƃ����o�O���Ȃ��Ȃ����Ȃ������B�j����Ɛ�قǃ{�[���ɏ\���ɋ߂Â��ƕ��s��~���ł���悤�ɂȂ����B�@(^�B^)

�܂��A�ڕW���Ɍ������J�[�u�̏������Â����A�J�[�u���s�����邩�̔�����Â��B�@���܂͎�̌����Ă�������ŕ������������߂Ă��邪�A�Ⴆ�ΖڕW������ɂ����āA������ɋȂ��Ęe������`������ł���悤�ȏꍇ�͐����������ɕ����Ȃ��B�@����σL�`���ƖڕW���̈ʒu�����W�ŕ\���āA�������������߂�悤�ɂ��Ȃ����_���ł��ˁB

�ł��܂��A�Ȃ�ƂȂ������̏����̌`���o���Ă����B�@�܂���Ȃ�ɂ��������������ŕs�s�����łĂ����B�@���s�v�����Ȃ��ƒ�~���߂s����悤�ɂ����̂ŁA�}�j���A������ŕ������悤�Ƃ��Ă��~�܂��Ă��܂��B(^^�U�@�������[�h�ƃ����R�����[�h���Ă�����ւ����Ȃ����痝�R���Ȃ��������Ȃ��Ȃ��Ă��܂����̂��B�@�����R�����[�h���������A�R�}���h�ɂ���ē���v�����o���悤�ɂ��������ȒP�������ȁB

�Ƃ����Ƃ���ő����͖����B�@�����̓��{�J�b�v�����ɏ��Â܂ōs���Ă��܂��B�@���N������ڂ����ςɍs�����Ȃ��B�@�q���[�}�m�C�h�T�b�J�[�̃��x�����オ���Ă���Ζʔ����̂����B�@���Ɓ��z�[�����[�O���ǂ�Ȃ��������B�@�T�b�J�[��苻�����邵�B

���T���S����

���{�J�b�v�W���p���I�[�v���Q�O�O�W�ɍs���Ă��܂����B

�i�摜���e���̂͌g�тŃn�C���]�ŎB�����̂��o�������߁B����ς肿���ƃf�W�J�������čs���Ȃ���_�����ȁj

���Âł̊J�ÂȂ̂ŋ��N�̑������X�ɋ߂���ł����A�V�����ōs�����Ⴄ�ƕГ�5000�~���炢�������ɍŊ�w���炾��1���Ԕ��͂�����B�Ȃ��Ȃ����Ă��ƂŒ��ׂ����ʁA�o�˂��珬�c�}�ŐV���c�܂ōs���āA���������a����ŏ��Â܂ŁB���v���Ԃ�2����10�����炢�ɂȂ邯�ǁA��ʔ��1500�~���炢�ōςށB���Ă��ƂŁA���c�}�{��a����ŏ��ÂɌ������܂����B

�S�[���f���E�B�[�N�����Ă��Ƃ������Č�a����͑卬�G�B�V���c�̓X�C�J���K�p�O�Ȃ̂ōs�y�q���吨���̋@�Ƒ����ɌQ���錋�ʂɁB�X�ɂ͌�a��̎�O�܂ł͍���Ȃ����炢�̍��݂悤�ł����B�B�@�n���̍��Z�����u���ł���Ȃɍ���ł�́I�v�ƍ��f���Ă���܂����B(^_^;)

�����o���Œ������ŎR���ɍs���Ă�̂ŕx�m�R�����Ă�̂����ǁA��a�������̕x�m�R�͖{���ɐ��삩�猩�グ�銴���ŗY��ɂ��т������Ă��܂����B��a����ōs���Ă悩�����[�B

���{�J�b�v���̓L�����b�Z�ʂ܂ÂƏ��Îs���̈�قɕʂ�Ă܂��āA�ړ��Ă̏o�����̂����A�q���[�}�m�C�h���[�O��4�����[�O�̓L�����b�Z�A���z�[�����[�O�͑̈�قƕ�����Ă��܂��Ă܂��B�@���\���������肻�������A�܂������ȁB

�܂��͉w�ɋ߂��L�����b�Z�Ɍ������܂�����q���[�}�m�C�h���[�O�ɂ��ς��ܕv�Ȃ��B(^_^)�@�傫�ȉו������Ă܂������ǃK���[�ƃN�����L�b�h�������Ă��̂��ȁH

�@�`�[�����̃e�B�[���T�C�Y���{�b�g�B�@�ǂ�ǂ�Ƒ傫���������Ă܂��B

�@������͂͂��߃��{�b�g�̃e�B�[���T�C�Y�B�@���N���₹�����H

�t�B�[���h�̓`�[���I���G���g���b�h�s�u���C���X�Ɉ��|�I�ɕ����Ă����ԂŌ㔼�킪�n�܂���ĂƂ��ł������A�`�[���I���G���g�̒������I��炸�ɑ���`�[�������l�̃S�[���ɃV���[�g��������Ƃ�����ԁB�@�@�@�E�E�E�@�q���[�}�m�C�h���[�O�̖閾���͂܂��̂悤�ł��B

����ɂ��Ă��`�[���I���G���g�͋��N�͊m���x�m�ʂ�HOPE�ŁA�قƂ�Ǔ����Ȃ��ŎS�s���Ă܂������A���N��ZMP�ɋ@�̂��ς���Ă̏o��B�����������ˁB500���~�̃��{�b�g���g���̂Ăł����B�@�����蔃��������Ȃ���я\���̂͂��߃��{�b�g��VISION�ɂ�������̂ɂȂɂ��ژ_���ł�����̂��ȁH

�@�q���[�}�m�C�h���[�O�̎����̗l�q�B�@�����Ȃ͂܂������Ƃ��āA�o��҂��ז��Ŋϋq�Ȃ��猩���Ȃ��B�@���ꗿ����Ă���炿���Ƃ����I�ƌ��������B�@���Ȃ݂Ƀ`�[����オ�o�鎎���͂��������Ƃ���̓L�b�`���������Ă܂����B�@�Ȃ��A���̉摜�̓`�[���I���G���g��CIT�u���C���Y�ł͂Ȃ��̂ł����ӂ��B

�S�����[�O�͂���ς�A�C�{���G�L�W�r�V�����}�b�`������Ă���Ă��ƂŁA�܂��A�C�{�͌����̂悤�ł��B�@�@������͔��ɐ�������Ă܂��āA�X�s�[�h�������邵�A�ʔ����B�^�C���œ������^�@�⒆�^�@���������g���ē����Ă��镪�������������Ă����ł��ˁB���N��ɂ͂S�����[�O�͓���@�̂��g����2�����s���[�O�Ɉڍs����炵�����ǁA�����܂ň����4�����[�O�����ł�����͔̂E�тȂ��ł��ˁB�̗p�����܂����q���[�}�m�C�h�����肵�Ă���Ƃ͌�����悤�Ɍ��������B

�@�J�j�{�i�A�C�{�`�[���j���߂Ă݂܂����B�ł������₷���B�@�ԃA�C�{�̕��������������Ă��ȁB�@�i�摜����킩��ɂ����ł��ˁB�X�C�}�Z���j

���X�L���[���[�O�������ƌ��܂������A�ł����N���[�������{�b�g���������Ɠ����Ă܂����B���������܂��܂����Ȃ��B�ЊQ�n���đz��̕s���n���������Ȃ�N���^�Ō��܂肶��Ȃ��̂��ȁB���ʒT���@�̓N���[���[�����^�C�������ǁA��Вn���Č��ʂ��s���n�x�������v���̂����ǁA�N���[���ő��v�Ȃ̂��ȁB

�@���X�L���[���{�b�g�𑀏c����q�g�B�@�������ƌ����J�����Ⴄ���ĐM���Ă����ǁA���̃q�g�̌��͊J���ĂȂ������B�@�����s�R���������ǁB(^�B^)

�Ƃ���ς���ď��Îs���̈�فB�@������͏����ڌ����́��z�[�����[�O������̂Ō��ɗ��܂����B

�����̌ߑO���̓I�[�v���`�������W�Ōߌォ�炪�{�Ԃ̃X�P�W���[���������Ǝv�����̂ɌߑO���ɍ����̋��Z�͏I����Ă��܂����炵���B�@���傤��12�����炢�Ɍ��ɍs���ƒ������̃h�����ʂ݂����ȃ��{�b�g���X�^�b�t�Ɉ͂܂�Ă܂����B�@����̋��Z���ăq���[�}�m�C�h�ł��ׂ�����ȁ[�B�q���[�}�m�C�h�̖{�̔�������Ȃ����Ǝv���̂����B�E�E�E�{�̂��Ă̂������������B�@���������Ă������A�������������B

�P�����炢����G�L�W�r�V�����Ƃ������ƂŌߑO���ɂ�������Z��������x����Ă܂����B���炩���߃J�����Ɖ����ŋ��������m���Ƃ̒�����T���Ƃ������Z�B����������ꂩ����Ċ����ł����B

�@�t���[�`���[���{�I�ȁ��z�[�����{�B���g�̓m�[�g�p�\�R���ł����B(^_^;)

��ʂ茩������̂ŁA�L�����b�Z�ɖ߂��ăA�C�{���[�O�ƃq���[�}�m�C�h���[�O���s�����藈���肵�Ă܂����B�q���[�}�m�C�h���[�O�͎��͂ɑ傫�ȍ����ł��Ă��܂����悤�Ő��`�[���̓_������`�[���ƁA�c��͓_�����Ȃ��`�[���B�e�����̃X�R�A�͂O�|�H�Ƃ��H�|�O�Ƃ��O�|�O�Ƃ��A�_����ꂽ���������B�@�X�ɂ͓_������`�[���������g�[�i�����g�`�[�����̂S�`�[���ɖ����Ȃ��̂ŁA���_���i�����_���ł͂Ȃ��j�Ō����o�ꂪ���܂�Ƃ�����Ԃł����B

�����̎�����S�������킯�ł͂Ȃ��̂����ǁA����̃`�[�����͏����s���Ƃ������������܂����B�@�O�����Ԃɍ����ĂȂ����A�V���[�g�����s�������B�@����RON�R�ɂȂ����̂����ǁA�t�B�[���h�v���C���[�̂Q��̘A�g���Ă̂��F���ł��݂��ɋ�����荇���ċ��|��ł����Ă��܂�����B�@�O�����Ԃɍ���Ȃ������ȏ�Ɏd�オ���Ă��Ȃ��l�q�ł����B

�����̌����܂łɂ͒������Ă����ł��傤���ˁB�@���ɂ͂����Ȃ����ǁB�B�B

�g���Ƃ����`�[�����w�Z�ł��Ȃ��A��Ƃł��Ȃ��t���[�̏W�c����̏o��ł����B�@KHR-1���x�[�X�ɂ����@�̂ł܂��܂����Ċ������������ǁA�t���[�ŏo����Ă������ł��ˁB4�l�����u��������Ă����܂����ł��B

���N�̍����͎������u���N�͏o�ꂷ�邼�B�v���Ďv���Ă��̂ł����A���u�����Ȃ��̂ƂRON�R�ɂȂ������Ă��Ƃ��ł����āA�����܂ł��ďo�ꂷ��ړI�����o�����ɏo���ڎw�����Ƃ���߂Ă��܂��܂����B���N�����Ƃ��ɂ́u���N�̃��x���Ȃ�Ȃ�Ƃ��Ȃ肻�������ǁA���N�̓��x�����������Ă����ǂ����Ȃ������v���Ďv���܂������A���N�̂����Ă�����ς�ǂ������������Ǝv���Ă��܂����̂�������ƃA���ł��ˁB(^^�U

�����_�͂Ƃ����ƁA���̂P�N�Ői�������悤�Ȃ��ĂȂ��悤�ȁB�@�Ƃ��Ă����{�J�b�v�ɏo����قǂ̎d�オ��ɂ͂Ȃ��Ă��܂���B�@�ł����́A����������蓹���������ɂ͐i���������ȂƂ�����Ƃ������掩�^���Ă�͔̂閧�ł��B

�Ō�̃q���[�}�m�C�h���[�O�̎������I������Ƃ���ʼn�����ɂ��A�A�H�ɂ��܂����B�@���ς��ܕv�Ȃ͂��̂܂܃A�C�{�̏W��ɎQ������Ƃ̂��ƁB�����̉ו��̓A�C�{�������̂��I

���T���U����

�A�v���[�`�̓��P���B�@(^_^;)

�g���b�L���O�ŃJ�����͖ڕW���̕��������Ă���̂ŁA�J�����̎p���𗊂�ɕ������Ă����̂����ǁA�ڋ߂̏��������܂������Ȃ��̂Ń_���B

����ς�A�蔲�����Ⴄ�܂������Ȃ��B�@�����g�p���̏�ɃJ�����p����������������f���Ōv�Z���āA���{�b�g�̈ʒu����ڕW���̈ʒu���v�Z���Ă݂܂����B�@�g���Ă���l�͊e�T�[�{�ɑ���w���l�Ȃ̂Ŏ��ۂƂ̓Y��������B�@���̂��߁A�����̖ڕW���̈ʒu�͑傫�������̂����ǁA�߂��̂��̂͂���Ȃ�ɐ��x�ǂ��v�Z�ł���悤�Ȃ̂ł܂������ł��傤�B

�����������~�܂�������͂Ȃ�ƂȂ����܂������o�����悤���B�@������ς���̂��P���P�ʂ��ŏ��P�ʁB�@�Ȃ̂ŖڕW���ɋ߂Â����߂̕��s���a�̌v�Z���A����1���̌v�Z�����钼�O�Ɍv�Z����悤�ɂ�����A����Ȃ�ɕ����悤�ɂȂ��Ă����B

�܂����߂Ȃ͖̂ڕW�������ɂ��鎞�B�@������s�����ĖڕW�������ʂɂȂ�悤�ɓ����̂����A�Ȃ������s�R�B�@���Ă̓J�[�u���s�A�܂�����Ƃ����ӂ��ɕςȋ�ɂȂ��Ă�݂����B���O�������ƒ��ׂĂȂ��̂ł킩��Ȃ����ǁB

�@�߂Â��Ď~�܂����Ƃ��B�@����������ƈ��肵���瓮��ɎB���Ă݂܂��B

�J�����p���̌v�Z�Ȃ̂����A�����_�̓����\���̓`���g�i�㉺�j�̏�Ƀp���i���E�j������������\���ɂȂ��Ă���B���ꂾ�ƁA�`���g������Ԃʼn�������ƃJ�������X���ă��[������������B�@�p���Ƀ`���g������������\���ɂ�����[�����������Ȃ��̂����A�_�u���`���g�ɂ����������̂ł��̍\���ɂ����B

���傢�ƌv�Z����ςނ���ǂ����ł��������Č����������ǁA�{���̓��[�����������Ȃ��\���ɂ��ׂ����ȁ[�B

�g���b�L���O�̕s��ŁA�J���������E�Ƀu����邱�Ƃ�������ǁA���̂����ŃJ�����̃Y�[���R���g���[���̃R�l�N�^�������Ă��܂����B�@����ŋC�t�����̂����A����Ȋ����B

�@������̓Y�[���摜�B����Ō������Ă���B

�@�����ꂪ���L�p�摜�B�قƂ�ǐ^���܂Ō�����B

�@�����ꂪ��ʊO����������Ԃł̒��L�p�摜�B�@���������̍L�p���O���Ŗ��܂�������Ă���B

�O���̕s������X�ɒ����Ă����Ȃ���ȁ[�B

���T���X����

�A�v���[�`�̓��P��i�߂�O�Ƀg���b�L���O�̕s��A�A�A�Ƃ������A�J�����p���̊Ǘ��̂������ɖ�肪�o�Ă��܂����B

�܁A���Ƃ�����茟���s�����I�悵���Ƃ����Ƃ���Ȃ̂ő債�����Ƃ͂Ȃ���ł����B�B

�����_�̃J������������������w�����鐔�l�Ƃ��āA���͓��e�p�x���g���Ă܂��B���e�p�x�Ƃ����̂̓J�����������Ă�������������������l�������A���̖���X-Y���ʂɓ��e�������̊p�x��Y-Z���ʂɓ��e�����Ƃ��̊p�x�ŕ�����\�����̂ł��B�X�N���[�����ʂ�\���@���x�N�g�����p�x�ŕ\�������̂Ƃقړ����ł��B

�J�����̕��ʂ��w������̂̓g���b�L���O�������C���ƍl�����̂ŁA��ʏ�̒ǔ����̃Y�������̂܂w����������킯�ŁA�ȒP���Ǝv�����킯�ł��B

�ߊp�x�ł͂Ȃ��܂������Ƃ����ƁA�Ⴆ�Ή��̉摜�̂悤�ȏ�ԂɂȂ������A�J�������[�����������܂��B�@CDT��ʂȂ̂ł悭����ɂ������ǁA�ΐF��������m���������Ȃ̂�90�x�ȏネ�[�����Ă��邱�ƂɂȂ�܂��B�@���̏�Ԃł��A�{�[�����i��ʏ�́j���E�ɂ���Ă�����i�{�[���������_�̕����߂Â����艓�̂����肵�����ʏ�͍��E�ɂ���邱�ƂɂȂ�܂��B�j�p���߂����̕����������������̂ł����A�㉺�ɂ��ꂽ����Ƃ����ă`���g�߂����Ă��v���ʂ�ɂ̓J�����������Ă���܂���B

�Ȃ̂œ��e�p�x�ɕϊ����Ďw�����s���A������ߊp�x�ɕ������ăJ���������K�v���o�Ă��܂��B�@���������Ӗ��ł̓��[�����������Ȃ��J�����p���Ŏw�����Ă��������p������܂��B

�@�@

�ł����A���e�p�x�\���������ꍇ�A�v�Z�Ƀ^���W�F���g���g�����߁A90�x�����Ԃł͂��܂��\���ł��܂���B�@90�x�����ꍇ�ɂ͍X�Ɋ��Z�����肷�鏈�����K�v�ł��B

���������킯�ŁA�����Ȃ��Ƃ��J�����p���̊Ǘ���pan-tilt-roll�^�C�v�̉�]���W�p�x�ŊǗ�����悤�ɕύX���ׂ����ȂƁB

����ɂ́A���̉摜�̂悤�ȏ�ԂɂȂ����ꍇ�ɂ͓��̂̎p�����摜�̃��[���ɉe�����A�Ƃ��Ƃ��t���܂ɂȂ��Ă��܂��܂��B�����߂����Ńg���b�L���O���邾���Ȃ獡�܂łƓ�����������������̂ł����A�g���b�L���O�s�\�ɂȂ����ꍇ�ɑ̂����ׂ�������m��ɂ̓��{�b�g�S�̂ł̃J�����p���A�J�������[����m��K�v���o�Ă��܂��B

�@�@

����Ȃ킯�ŁA�����̊Ǘ��ϐ��ƊǗ����ɕύX�������邱�Ƃɂ��܂����B�@�����͂����x�����疾���̌ߑO���̍�Ƃ��ȁ[�B

���T���P�O����

����̏h�肾�����J�����̎p���\���ϐ��͑S�ĕύX���ē��e�p�x����p���p�x�ɂ��܂����B�@�g���b�L���O���ɂ̓J�������[�������f���ăA�v���[�`�ɂ��Ă��傫�ȃo�O�͎�ꂽ�悤�ł��B�@�܂��S�̓I�ɓ��삪�s����ŁA�R�A�_���v���N��������A�t���[�Y������A�z��O�̓��������邱�Ƃ�����̂ł��������Ƀo�O������ł���낤�Ȃ��`�B

�܁A���x���グ����f�o�b�O�����肷��̂͂����������Ƃ��āA���͖ڕW����G����Ă̂�����Ă݂����Ǝv���܂��B���{�r�����[�h�̓I��|���̂̓L�b�N�ł��\��Ȃ��̂�����ǁA����������������L���ăv�C���Ƃ͂�����������ȂƎv���Ă܂��B�@�Ƃ��낪�A�����_�͎��͒P��Ȃ̂ŕ��̂܂ł̋�����m�邱�Ƃ��ł��܂���B���ɂ����Ă�����̂͑�̂̋������킩��̂����ǁA���L���ĐG��Ƃ������x�͊��҂ł��܂���B

����Ȃ���ȂŁA����͎��L���Ď����̎��ڕW���ɏd�˂�Ƃ������Ƃ�����Ă݂����Ǝv���܂��B�@�����𑪂�ԈႤ�Ƌ�U�肵���Ⴄ���ǁA�ڕW���͑傫���ŋ����̖ڎZ�����悤�Ǝv���܂��B�@�܂�A���̂������Ă�����̂��ΏۂƂ������Ƃł��B

������ȕ��ɑΏە��Ɏ�������L�ׂđΏە��Ǝ���߂Â��Ă����܂��B

�@�{�[����G��ɍs�������_�̃C���[�W�}

���F�����邽�߂Ɏ��ɂ킩��₷���F�����t���܂��B

�����_�̃J�������猩��Ƃ���Ȋ����B��

�@CDT�{���x�����O�ŕ��̂�F�����Ă��܂��B

�@CDT�摜�B�̎l�p���̂������_�̎��B

���ꂾ���ԋ߂ɂȂ�ƃY�[����Ԃ��Ɖ�ʂ��{�[�����炯�ɂȂ��Ă��܂����߁A���L�p�摜�ɂ��Ă��܂��B

�g���b�L���O�ƃA�v���[�`�ɂ��Ă͖ڕW���̒ǔ���CDT���g���Ă��܂����B�@�Ȃ̂ŕ��̂�ǂ������Ă���킯����Ȃ��A�s���N���ۂ������Ɉ�������Ƃ��������ɂȂ��Ă܂����B�@�ł����A���낻�땨�̂�Ώۂɂ������̂�CDT�{���x�����O�����̃f�[�^���g���悤�ɂ������Ǝv���܂��B�@���x�����O�f�[�^���g���ƁA�g���b�L���O�Ȃǂ�����Ȃ�܂��B�ȂJ�����������̂ő��ΓI�ɕ��̂��������ƂɂȂ�܂��B����ƁA�������Ɠ������m��ǔ����Ă���̂��ǂ������킩��Ȃ��̂ł��B

���T���P�P����

�����͌ߑO������摜���������̌������B

�摜�����v���O������CDT�G�f�B�^�Ƃ��č��������]�p���Ďg���Ă����̂����A���̖��c�ŁAIPSOCK�ڑ����������Ȃ��Ɖ摜�擾���s��Ȃ����ɂȂ��Ă����B

IP�ڑ����������߂����ɂȂ��Ă��āA�N���C�A���g����̐ڑ��v���������Ƒ҂��Ă���B�@�Ȃ̂ŁA�N���C�A���g���Ȃ�炩�̌����ŏI�����Ă��܂��ƁA�摜�������X�V���ꂸ�A���O�̉摜����������Ƃ����B�B

���̂����������������Ɣėp���̂���悤�ɉ��������肵�Ă܂����B

�ŁA���ꂪ�I����āA���āA���x�����O�����f�[�^�ł̃g���b�L���O�ɂƂ肩���낤�Ƃ����Ƃ���A�����_�̘r���B�B

�O������Ă邩��t���[�����܂�Ă���̂ɋC�����Ȃ������B��̕��i�łȂ����Ă����̂ɗ����Ƃ�������Ă�B�����C�t���Ă���ǂ��炩����͂�����Ȃ��čς̂ɂȁB

���łɗ[���������̂ō����͏C���ł��Ȃ��ȁ[�Ǝv�����̂����A���T���܂ł��̂܂܂��ƕs�ւĂ������A�����_�����Ȃ��B�@�Q���i����������ƁA��}���Ńt���[�����Đ��삵�܂����B

�������Ń��x�����O�f�[�^���g�����g���b�L���O�͊������܂���ł���(>_<)�@�܁A���ꂪ�Ȃ��Ă��������ĂȂ������ł����B�B(^^�U

���x�����O�����摜�f�[�^�ł̃g���b�L���O�ƃA�v���[�`���Ă̂̓A�C�{�ł�������Ƃ�����܂��B�@�A�C�{�̂n�r�͂悭�ł��Ă��āA�摜�����鎞�Ԃ��T�[�{�������Ԃ�������������肵�Ă܂��B�@����ł�������J���ē��������̂ŁA�����_�ł͂�����Ɠ�������Ă��Ƃō\�z���Ȃ��炵�荞�݂��Ă܂����B

�����CDT�f�[�^�����x�����O������Ă��ƂŁA�ʏ��CDT�摜�̏d�S�ƃ��x�����O�f�[�^�p���ăg���b�L���O���Ă݂邱�Ƃɂ��܂��B�@������Ƃǂ��Ȃ�̂��킩��Ȃ����ǁA�Ȃ�ƂȂ������A�C�f�B�A�ł���C�����Ă܂��āA���܂������̂��y���݂ł��B

���ꂪ�ł�����A���x�͉摜�Ɏʂ鎩���̎�����]�̏ꏊ�ɓ������Ƃ����̂�����Ă݂�\��ł��B�@�ڕW�����g���b�L���O�����܂܁A����ڕW���ɋ߂Â��Ȃ���Ȃ�Ȃ����Ă��ƂŁB

�l���Ă�Ƃ��̓��N���N���Ċy�������ǂȁ[�B�R�[�f�B���O���n�߂�܂ł���ςȂ�ł����B�B�B

�@

MARU Family�@��AKino�����@�ŁA����`���v���W�F�N�g�̗l�q��m��܂����B�@���{�������͎������{�b�g�l�^�Ȃ̂��ȂƎv���Ă�����ł����A���肪�w�r�[�Ȃ̂ł���܂苻���Ȃ�������ł��B�@5��7���܂Ő\�����݂ł����݂����Ȃ�ŁA���w�����ł��s���悩�������ȂƁA������ƌ�����Ă܂����A�߂��Ȃ̂ɁB�B�B�@�ł��A����ς胊���R���Ȃ�ł��ˁB�@�q�m�L�I�i�������j�݂����Ȋ����ł����ˁ[�B

���T���P�R����

���x�����O�f�[�^���g�����g���b�L���O�B�@�������R�[�f�B���O���č�������ƃf�o�b�O�B

�ꉞ�͓����悤�ɂȂ�܂����B�@�܂�����������Ɨ��肱�݂��K�v�����ǁA�d�g�݂Ƃ��Ă͂��܂��s���Ă�����ȁ[�B

![]() �@���x�����O�f�[�^�ł̃g���b�L���O

�@���x�����O�f�[�^�ł̃g���b�L���O

�Ȃ��Ȃ��܂��܂����܂��s���Ȃ����ǁA�����Ƃ��Ă͊Ԉ���ĂȂ����ȁ[�ƁB�@����̍Ō�ŏ�̕��Ɏ�����D���Ă��܂��܂����A�����̐�́B�B�B�B

�@�@���ꂩ���`�@

�@�@����A�A�A���������Ă��ꂩ�H�H�@�炪���Ă邵�B(^_^;)

�摜�̃t���[�����[�g���Ⴂ��ɕs����Ȃ̂ŁA�ړ��ʗ\���Ȃǂ����܂������Ȃ��Ǝv���A�͂Ȃ�����ړ��ʗ\���͑g�ݍ���ł��܂���B�@�����CDT�d�S����̈ʒu������L�^���Ă����A���̃t���[���ł����̊W���ۂ���Ă��邱�Ƃ����҂��Ă܂��B

�����A���x�����O���P�t���[���ł����s�����ꍇ�A�e�͂Ȃ��A�Ⴄ���x�����O�f�[�^�ɒ������ڍs���Ă��܂��v���O�����ɂȂ��Ă���̂Ŕ����ȐF�����▾�邳�ł͕s����ȓ���ɂȂ��Ă��܂��炵���B�@���t���[�����炢�͑҂��Ă݂�Ƃ��A�\�����W���炩�����ꂽ�烍�X�g�����ɂ���Ƃ��̏������K�v�Ȃ悤�ł��B

���āA���̉��ǂ����Ȃ���A���̂���͌��܂����傫���ɂȂ�܂ŋ߂Â����Ă̂�����Ă݂悤�B�肪�͂��Ƃ���܂ŋ߂Â��Ƃ������Ƃł��B

����A��ʂɉf��������w���ʂ�ɓ��������Ă̂��悩�ȁ[�B�@

���ɂ�邱�Ƃ̌����B

�܂��A�傫�����킩���Ă��郂�m�̋�������ʂɉf�����傫���Œm��ɂ́A�A�A��p�ƃ��m�̑傫�����킩���Ă���ΊȒP�Ȍv�Z�ŏo��B�@�����_�̃J���������Y�͒��L�p�łЂ��݂��傫�����ߌv�Z���x�͒Ⴂ�͂������A�g�����ɂȂ邩�H�H

![]()

��́����X�N���[���B�@���̎O�p�͎���p��\���Ă���B

�����ƁA�A

X��L�����m���B�A�A�A��ʂ̕��ɑ��ă��m�̕�����߂銄�����@�� = W/X �Ƃ����ƁA�@L= 2W / r tan���Ȃ̂Ł@r = 2W / L tan��

��ʂɉf�郂�m�̉�ʏ�̃T�C�Y��������m�܂ł̋���������B�@���m�����ɂ���O��ŁA���������ŋ������o���̂Ƃǂ��炪���m���ȁB�@���������ŎZ�o����ꍇ�̓J�����̍������v�Z�l�ǂ���łȂ���Ό덷���o��̂ʼn�ʏ�̃��m�傫���̕������x�������͂��B�@���m�̖{���̑傫���������ĂȂ��Ƃ����Ȃ��Ƃ������������邩��A�g���Ȃ������B�B(^_^;)

�ŁA��ʂɉf������ʏ�̂�����W�Ɉړ���������ĕ��́A�A�@����������@���x�N�g���Ɏ��A�����W��ʉ߂��镽�ʂ��Z�o���āA�ړI���W�����̕��ʂɓ��e�������̋�ԍ��W�֎����ړ�����A�A���Ă�낤���ȁ[�Ƃ��v�������A�Ȃ�����ƈႤ�C�����ă{�c�B�@�v�Z�߂�ǂ��������B

�����r�����̂ɂ��Ă���킯�ŁA���̂���Ƃ������������͂킩��B���̍��W�͂킩��B����ƁA��ʂɉf����ƃJ�����̋������킩��B�܂�A�ړ���̋�ԍ��W���킩��킯�����炳�����݂�����3�������g��Ȃ��Ă����W�ϊ��ł킩��͂��B�@�������̕����߂̏��^���w��t�^���w�v�Z�Ŋ���Ă邩��ȒP�����B

����2�F�̃J���[�̃J�b�e�B���O�V�[�g�Ń}�[�N���悤�ƍl���Ă���B�@�f�U�C���I�ɂ̓A�������ǁA�܂����̍ێd���Ȃ��B�@�@�@�����_�͊�{�I�ɍŒ�S�F�̐F���ʂ��ł���悤�ɂ��Ă����āA���̂�����2�F�̑g�ݍ��킹�Ń}�[�N����������悤�ɂ������B�@4�~3=12�@�̑g�ݍ��킹�̃}�[�N�����ʉ\�B

���̂�����2��ނ�����ƉE��Ɋ��蓖�Ă�B�@�ǂ̂悤�ȏꍇ�ł����̃}�[�N����������A����͎����i�����_�j�̎�悾�ƔF������B�@�����̑̂��J������ʂ��ċq�ϓI�ɔF�����邱�Ƃ��đ�Ȃ��Ƃ��Ǝv����ł��B

�@

������Ƃ��Q��̂��x���������A�����͌���ɖ����B�@�����͂����܂łɂ��đ��߂ɐQ�悤�B(-_-)zzz