�J�������C���f�b�N�X��

�O�̃y�[�W��

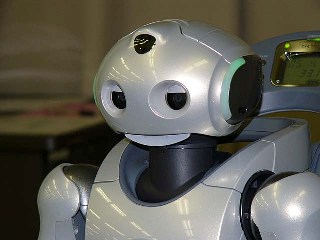

���P���R����

�����܂��Ă��߂łƂ��������܂��B�@�l�b�g�̖����Ƃ��납��l�b�g������Ƃ���֖߂��Ă��܂����B�ł��A�܂��A�Ȑ�ł��B

�������ł͒�����ӂ܂Ŏ��т���A���y���U�߂ŕ�������ɂ�����܂���B�����݂����������Ȃ��Ă܂��B(>_<)

�܂����������킯�ł��������i�W�͂Ȃ��̂ł����A�e�ނ�����O�ƋA������̎��Ԃ͉ɂȂ̂ŃQ�[����������p�\�R���Ɍ���������B�B�B

�摜�����ɂ��Ă̓A�C�{�̕��̒ǐՏ����̂��߂ɊJ���������̔F���v���O�������������邽�߂ɁA���N�O�ɏ������R�[�h����ǂ��Ă܂����B�����ŏ������v���O�����ł����N���o�Ă����ς蔻��܂���B(^^�U�@���x�������ǂ݂��Ēi�X�C���[�W������v���O�����̍��q�������ɏ����o���Ȃ���Ȃ�Ƃ���ǂ��ł��܂����B�i�Ƃ������v���o���Ă����j

����́A�J���[�摜�p�ɍ�������̕��̔F���v���O������CDT�p�ɏ��������ēK�p�������ł��B�@�ł��A�ǂ����\���̂�������ƕς��邾����CDT�摜�f�[�^�ɂ��J���[�摜�f�[�^�ɂ��K�p�ł������ȋC�����Ă����̂�C++�̃e���v���[�g�@�\���g���ăN���X�����������Ƃ����L�q���ȑf�������肵�Ȃ����Ȃ��Ǝv���n�߂Ă܂��B

���̔F���́A����摜�t���[�����畨�̂��o�����o���ƁA�A�������摜�t���[���œ������̂��֘A�t���镨�̒ǐՕ�������B����̃��{�r�����[�h�ł͒��o���݂̂��ڐA�������B�@���̒ǐՕ��͓����`�̂��̂���������ꍇ�ł����ꂼ������ʂ��邽�߂ɍ�����̂����A�����_�ł͉摜�t���[�������܂��������ɓ����Ȃ���ԂȂ̂ŐM���x�����҂ł��Ȃ��̂Ŏg���Ȃ����낤�B���Ƃ��Ƃ���قLj��肵�Ă��Ȃ����B�B

�E�E�E�E�E�E�E

���ƁA�Ƃ���߂�ǂ������ĂȂ��Ȃ����Ȃ��������ʖ��̏d�S�̎Z�o�Ȃ�����Ă܂����B�d�S�v�Z��A�o�b�e���[���P���ʂƂ��Čv�Z����悤�ɂ����̂ŁA�o�b�e���[�̏d�ʂ��ς���������o�b�e���[�̃f�[�^��ς��邾���ŏd�S�v�Z�ɔ��f�ł���悤�ɂ��܂��B

�@�@

����͈ړ��ʼnƂɖ߂�܂��B�c��̋x�݂̊ԂɐF���̒��o���������Ǝv���܂��B

���P���S����

�����A�A�Ȑ悩��߂��Ă����̂ŁA�����������{�b�g�J���J�n�B

�ł́A���̒��o���B�B�@�Ǝv�����̂����A�܂��͏d�S�v�Z�p�f�[�^�̑g�ݍ��݂����Ă��܂����Ǝ��|�������B�@���A�������̃f�[�^�̎������ԈႦ�Ă���̂ɋC�t���ăf�[�^����蒼���B�����Ď�����f�[�^�������肵�Ă܂����B

�܁A����͂��Ȃ����Ȃ̂Œ��Ȃ��I���A���x�������̒��o���B�B�@�Ǝv�����Ƃ���łӂ��Ɏv���o�����B���̒��o�̂��߂̗̈�̐�o�����Ă͉̂摜�����ł̓��x�����O�Ƃ����̂ł��B�u�摜�����@���x�����O�v�Ō�������ƐF�X�łĂ��܂��B

�ŁA�ȒP�ȃA���S���Y���͂Ȃ����Ȃ��Ǝv�����̂����A�A���S���Y���̐������������肷��̂͂���݂Ԃ��̃^�C�v����ŁA�H�v���Ă���炵���A���S���Y���͔閧�݂����ł��B�@���ǁA�����ō�������@�̕�������݂Ԃ����͂悳�����i���\�Ƃ�������̖�肾���j�Ȃ̂ŁA���j�ύX�͖����ŁB

�A�C�{�p�̕��̒��o�v���O�����������_�ɈڐA����ہAYUV�摜�p��CDT�摜�p�ɂ��Ȃ���Ȃ�Ȃ��̂����A�Ƃ肠������YUV�摜�p�̂܂܈ڐA�����Ⴄ���Ƃɂ��܂����B�ǂ������̂������Ȃ���Ȃ�Ȃ��킯�����B�ǂ��������Ă�����CDT�p�̕����X�|�b�g�g�p�ɂȂ肻�������B

CDT�摜�����x�����O����ꍇ�A�Q�l�f�[�^�Ȃ̂�臒l���ǂ����邩�Ƃ������Ƃ͍l���Ȃ��ėǂ��B���āA�J���[�摜�Ń��x�����O���鎞�̈�Ԃ̖���臒l�ł��B

YUV�摜���畨�̒��o���邽�߂ɁA�܂���臒l�ݒ�����鏈���������܂��B�܂��R���g���X�g��������G�b�W���O�����肷����ǁA�ŏI�I�Ɂu�F�̍��v�����āA���̂̋��ڂf���܂��B

�@�܂��͕��ʂ̃J���[�摜

�@���ɋ��E�������{�����摜

�@�Ō��CDT�����摜�B�̃{�[���͌����ĂȂ��B

�^�̉摜�ŁA�ɂȂ��Ă����f�͐F�̋��E�����Ɣ��f�����Ƃ���B�J���[�摜���c���Ă����f�ׂ͗̉�f�ƐF���߂��Ɣ��f�����Ƃ���B

����ŁA�F�̃J�^�}���Ɣ��f�ł����f�������c�������ƂɂȂ�B���ɂ��̉摜�f�[�^�ɑ��ă��x�����O�������s���̂��B

����CDT�摜���Ɓu�s���N�v�����Ă���̂Ő^�̉摜���{���̕��̂��n�b�L���Ɣ��f�ł��Ă���̂����A����̌��_�͖��\���������Ƃ������ƁB���ʂ������u�F�v�͈̔͂����O�ɖ��m�ɋK�肷��K�v������B�@�F�̋��ڂ�����������ƁA���O�Ƀf�[�^��p�ӂ��邱�ƂȂ��A���m���u����v���Ƃ��ł���Ƃ����X���|�[���B�@�����Ƃ������̗Ⴞ�ƃ��X�O���[���̃{�[���̓J�[�y�b�g�̐F�Ƃ̍��������܂��ŁA�͂�����u�����āv�����̂����B�����͈��g���Ă��Ƃ�(^_^;)

�A�C�{�ƃ����_���ƃn�[�h�̍\���������ƈႤ�̂ł����܂ł̈ڐA�ɈӊO�ƂĂ�����܂����B�ł͑����ă��x�����O�����̈ڐA�ւƐi�݂܂��B�������̓f�[�^��������������ȒP�Ȃ͂��B�@�@�ȒP���Ďv���Ă���Ȃ�s�����������Ȃ����ǂˁ[�B(^^�U�@���ƁA���x�����O�������ʂ�\������v���O���������Ȃ���Ȃ�Ȃ��B�������̕����߂�ǂ��������Ȋ����ł��B

���P���V����

���������ǂ���ŃK�[���H�т��Ă��������B

�������ׂ͕@������Ђ��đS�g���܂���čA�ɋ������ł����A����͕@�����Ŏ��܂肻���ȋC�z�B�B�B���Ƃ������ǁB�����܂��X�V���~�܂����畗�ׂ��Ԃ�Ԃ����Ǝv���Ă��������B

�T���̌ߑO���ɂ͕��̒��o�̃��[�`�������������āA���Ƃ͉�ʂɕ\�����邾���Ƃ����Ƃ���ŁA���ׂŃ_�E���B�T���̖邩�炸���ƕz�c�ɓ����Ă܂����B

�ŁA�����͓�����悤�ɂȂ����̂ŕ��̒��o�̉�ʕ\���������������Ă݂܂����B�蔲���ł����ǁB�i���摜�f�[�^�ɒ��ڃ}�[�N���Ă���j

����Ȋ����ŁA�ӂ��܂Ƃ��A�S�~PC�P�[�X�Ƃ������̂Ƃ��Č����Ă��܂��܂��B������������̂Ȃ̂Ō����ē��R�B���̌�͖ړI�ɉ����ĕK�v�ȃ��m����������悤�ɂ�������킯�����B

���F�̃N�}�������Ă͂��邯�ǁA���ʂ�����̂ŁA�畔���Ƒ������̍��v�R�Ɍ����Ă܂��B������������A����ȕ��G�Ȍ`����������̂���̃��m���Ȃ�Ēm�����Ȃ���킩��͂��͂Ȃ��̂ł���ł����̂ł��B�{���͎O�Ɍ��������̂���̃��m�ł��邱�Ƃ͍���킩���Ă���i�\��j�̂ł��B

���Ȃ݂ɉ��ɖڂ������Ė{�I�����Ă݂�ƁB�B

����Ȋ����B�Ȃɂ��Ȃ��킩��܂���B�܂�����������������Ȃ��ł��傤�B���̐��͎h���ŃC�b�p�C�Ȃ̂ł��B���̂����A�����_�̂��߂ɐ^�����ȂȂɂ�����������p�ӂ��Ȃ���Ȃ�Ȃ���������܂���B(^_^;)�@���Ȃ݂Ƀ����_�̓����͂R���R�x�������Ă��܂����A�`���g�ɂQ���g���Ă��邽�߁A���E������Ƃ��̂悤�Ƀ`���g�p�Ƃ̌��ˍ����Ń��[�����������܂��B���̃��[���̊p�x�͌v�Z�ŎZ�o�ł���̂ʼn摜����]�����邱�Ƃŏ㉺�𐳂�������邱�Ƃ��\�ł��B�������A���{�b�g�ɂƂ��Ă͂��̃��[���͂���قǖ��ɂȂ�Ȃ��̂ŋ��炭��]��͍s��Ȃ��Ǝv���܂����B�i�������p�^�[���F�����s���Ƃ��ɂ͓K�X�����I�ɉ�]�������K�v�ƂȂ�����͂��܂��B�j

�����A�J���[�摜����̕��̒��o�̓����_�ɂׂ͉��d���A�m�C�Y�ɂ��キ�A�����I�ɂ͂��̏����𒆐S�ɉ摜���������ԔF���ւƐi��ōs�������Ǝv���Ă���̂ł����A�Ƃ肠�����͖ړI�̃��m���������邱�Ƃ��ł���CDT�摜�Ƀ��x�����O�������{�����f�[�^���g���Ă��������Ǝv���܂��B

�����I�ɂ͋t�̊���������܂����A���͕��̒��o���[�`���i���x�����O�����j��CDT�摜�ɓK�p�������Ǝv���܂��B

���P���X����

���̒��o���[�`����CDT�摜�֓K�p���Ă݂܂����B

CDT�͂W����ق���̂ŁA���̒��o���W��s��Ȃ���Ȃ�Ȃ��Ȃ邩�炿����Ƃ��`�E�E�E�B�ƍl���Ă������A������ƍl���āA�����̐F����̃I�u�W�F�N�g���X�g�Ɋi�[�ł���悤�ɂ��܂����B�@���ƁA�K�v������ِ��������X�L��������悤�ɂ����̂Ŗ��ʂȃ��[�v����������̂͋ɗ͗}����悤�ɂ����肵�܂����B

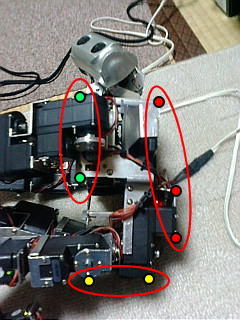

�@�����̃s���N�{�[���Ɖ��F���N�}

�@����Ȋ����ɁB�͂��̐F�����o�F�ƍ����ĂȂ��ł����A�C�ɂ��Ȃ��B

�@���ꂪ�������{�r�����[�h�p�̎��R�b�v�B��ʂɓ\�����F�̑g�ݍ��킹�Ő�����\���B���������B(^_^;)

���̎��R�b�v��CDT�ŕ��̒��o�Ō���ƁA

�@����Ȋ����ɁB

�J�b�v���ɓ�̃}�[�L���O���\������Ă���̂�����Ǝv���܂��B�}�[�N�̐F�ƒ��o�F�͂���ς��v���Ă܂���B�蔲���ł��ˁB(^^�U

�@����ȕ��Ɍ����Ƃ���ƁA

�@�����_�ɂ͂���ȕ��Ɍ�����B

���ꂾ���ԋ߂ɋ߂Â��Ă���Ƃ��̃T�C�Y�Ɍ�����B���L�p�����Y�̒����������ɃY�[�����Ă݂Ă����Ԃł��ꂾ����t�B�[���h�̒[�������甽�Α��̎��R�b�v�����Ă��A�F�f���邱�Ƃ͓�����B�@���ƂP�i�K�Y�[�����邱�Ƃ��ł��邪�A��p�Ƃ̊W�ŁA�^�[�Q�b�g�𐳊m�ɑ������邩�ǂ����������Ƃ���B�@���R�b�v�̓��̂ɂ����ʃ}�[�N�����Ȃ���Ȃ�Ȃ��̂��Ȃ��`�B����͔��������Ȃ��B

���́A���o�����F�I�u�W�F�N�g�̑g�ݍ��킹���玆�R�b�v�̔ԍ��ɕϊ����ā`�A�A�@�Ɛi�ނ��ǁA�L���������Ƃ���Ȃ�ł��낻��N���˓��O�ɂ���Ă����p������ɖ߂낤���Ǝv���܂��B

�E�E�E�E�E�E�E�E�E�E�E�E�E�E

ONO-ONE���I����Ă��܂��܂����B(^_^;)

ONO�̓d�]�ǐV���Ɍf�ڂ��Ă��炤�����ŋ����������̂ɁA�ӊO�ƃ|�C���g���L�т�ONO-ONE�ł͏�ʂɐH�����肵�Ċ����������ł��B�iONO���肪�Ƃ��������܂����B�j�@����A�܂��낳��̃u���O��ǂ�ł���ƁA�s�ӂɂ����̂��Ƃ������Ă����Ăт����肵�܂������A���̓����ɏ����Ă��邱�Ƃ��A�{���Ɏ���������Ă邱�Ƃ̋L�^�����Ȃ̂ŏ��̔Z�x���Ă��������x���Ă��������������̂ł����Ƃǂ��Ȃ̂��ȁ[�Ǝv���Ă܂��B

�����������ɂ͓����������ăA�b�v����悤�ɂ��Ă����ł����A�����������̂ɐS�����Ă�̂́A��{�́u�L�^�v�A�����Ȃ̂ł��̖��̒ʂ�B���ƁA���ʂ�������Ȃ��l���Ă邱�Ɓi���{�b�g�Ɋւ���\�z�◝�_�Ƃ����Ӗ��j�Ȃ��ł��邾�������悤�ɂ��Ă܂��B���ʂƂ����_�ł͐����������Ƃ�������Ȃ��A���s�������Ƃ������x���ŏ����悤�ɂ��Ă܂��B���s�̏����ďd�v���Ǝv����ł���ˁB�@���s�����Ă����ׂ��ɏ����͈̂ނ���̂ŁA�����O�̍\�z�i�K���珑�����Ă̂͐�����������Ȃ��ȁB�����Ă�Ƃ��͂��܂��s�����ĐM���Ă���킯�����B

���ƁA�S�����ĂȂ����Ă������A�C�ɂ��Ȃ��悤�ɂ��Ă���̂́A�l�ɔ���Ղ������Ƃ����_�ł͂��܂�C�ɂ��Ȃ��悤�ɂ��Ă��܂��B�킩�������Ƃ𐳂����A���������Ղ��������Ƃ���Ƃ��̂��������Ԃ��������Ă��܂��āA�₪�ē����������Ȃ��Ȃ�悤�ȋC�����Ă܂��B�ł��̂ŁA�܂��ȒP�ɂ����Ɖ��菑���ł��B�i����₷�����͂��Ă�����SISO����̃u���O�͒��J�ȕ��͂ł킩��Ղ������Ă����Ă��炵���ȂƂ������S���Ă��܂��B�j

�ł��ŋ߂̓J�E���^�[���オ��̂����������āA�ȑO���͔���₷�����͂��������Ƃɂ��C���Ă邩�ȁ[�B�i�ȑO���́A�ł����ǁB�j

�ł��̂ŁA�������������Ă��������Ă���Łu�������Ă�̂��킩���v�Ƃ��A�Ԉ�������Ə����Ă�A�Ƃ������Ƃ�����܂����烁�[���Ȃ�f���Ȃ�ŋ����Ă�����������肪�����ł��B��낵�����肢���܂��B

���P���P�P����

����Ȃ̔����B�m��Ȃ������[�B

�܂Ԃ��ƌ��������L�����I�B�@�\��̌����p�炵���B�@�C���e���W�F���X�E�_�C�i�~�N�X�i���������Ɛ̘̂b�����ǁj�ɏo�Ă���L�����I�̓I���W�i������F�X�Ǝ���������Ă郂�m�����������B���̎��R�x�����������c�Ƃ��A�J�������L�p�ɂ����̂Ƃ��B�@�ǂ���I���W�i���ɔ�ׂ�ƃf�U�C��������ĂĂ������Ȃӂ��ɂȂ��Ă���B���̂܂Ԃ��t���L�����I���Ȃς��ȁ[�B�@

���P���P�Q����

�p������ƁA�p���ڍs�̌����Ǝ�����i�߂�B

���͍��ʂ̔���A�Ƃ����Ƃ���ŔN���N�n���}���Ă��܂����̂ŁA���ʂ̔��肩��J�n�B

���ʂ̔���́A�����Ƃ������̃`�F�b�N�|�C���g�ɁA���ʂ̃`�F�b�N�|�C���g�������ď��ʂƂ̐ڐG���`�F�b�N����B�Γ_�O���[�v���ڒn���Ă����炤�����A�ԓ_�O���[�v���ڒn���Ă���������A���_�O���[�v���ڒn���Ă�������ʁA�Ƃ����ӂ��ɔ��f����B���_�̌㑤�Ɛԓ_�̉����͓����ɐڒn����P�[�X�����邪�A���̏ꍇ�͋������D��B

����œ��̐ڒn�n�̎p���͂������ȁ[�ƁB�@���Ƃ͗��ʌn�B�@���̐ڒn���Ȃ���Ή��炩�̌`�ŗ��ʌn�Ƃ������ƂɂȂ�B���t���Ȃ���Η����Ă����Ȃ��Ƃ��������ʂ͎肪�n�ʂɓ͂��K�v������B�d�S�_���x�����p�`�ɓ����Ă��炸�A�肪�t���Ȃ��قǏd�S�_�������ʒu�ɂ���ꍇ�́u�]�|���v�Ƃ������ƂɂȂ�B�Î~��ԂȂ�Ή����Ɏx�����Ă���Ƃ������ƁB

����ł܂��ꉞ�͎p�����肪�ł����B���E�����̌X���ɂ��Ă͂قƂ�Ǎl�����Ă��Ȃ������A�^�p�Ŗ�肪����悤�Ȃ炻����l�����Ȃ���Ȃ�Ȃ����낤�B

�p������́A�T�[�{����̊p�x���Ɖ����x�Z���T�[����̃f�[�^�ō\�z�����p���l���g���Ă���B�Ȃ̂ŁA�T�[�{���E�͂��Ă��Ȃ����ł��A�������n�ʂɑ��ĕ��s����Ȃ�������A���̍�������v���Ă��Ȃ�������ƁA������Ƃ炯�����l�ɂȂ��Ă���B�@�E�͏�Ԃ���g���N����ꂽ�ꍇ��A�]�|��g����������Ȃǂ��ƁA�T�[�{�ւ̎x���p�x�Ǝ��ۂ̊ߊp�x����v���Ă��Ȃ������肷��ꍇ������B�@������Y��Ȑ��l�ɐ����K�v������B�܂��A�K�{�ł͂Ȃ����A��������������₷���B

���́A���p���ŁA�ǂ��܂Ŏp���l�������邩�Ȃ̂����A���̃��[���Ȃǂ��w�^�ɂ�����Ƃ܂�J2�߂��s����ɂȂ����肵�Ă��܂��̂ŁA�Ƃ肠������J1Z���������ĕs���肳����菜���BJ1Z�������s�\�ȏꍇ�͂��̂܂܂ŁB

���Ɏp���̈ڍs�ɐi�ނ̂����A����͂ǂ��i�߂Ă����̂���������Ȃ��B�@�ł��A�A�Y��ł��Ă������������ɂȂ��̂ŁA���Ԃ��Ă������Ƃɂ����B

�܂��͋����p��������ʎp���ւ̈ڍs�B�@�P���ɓ��̂̃`���g�p��0�t�߂ɂ����čs�������̂����A���̂��N���オ��̂ɂ��킹�ĕG���グ�Ă����K�v������B�܂�A�����̐ڒn���͂ł��邾�������Ȃ��悤�Ȉڍs�v����쐬�������B

�{���͑����̃X���b�v���Z���X���āA�X���b�v���Ȃ��悤�ɑ���E�G�E�Ҋ߂����A�Ƃ������Ƃ����ׂ��Ȃ̂����A�����_�ɂ̓X���b�v�Z���T�[���Ȃ��̂ŁA�v�Z�ł�邵���Ȃ��B

���̌v�Z���A�p������Ɏg�����`�F�b�N�|�C���g�𗘗p����B�菇�͈ȉ��̂悤�ɍl���Ă���B

�����̎p�����X�^�[�g�p���Ƃ��A���ʂɐڐG���Ă���_���ǂ̓_���ׂ�B���̂��N�����Ă����ƁA�ڒn�_���ǂ�ǂ�ƈړ����Ă��āA���ʂɂȂ������ɂ͏�̉摜�Ō����ƍ����̉��_���ڒn�_�ƂȂ�B���̈ړ��̊Ԃ̌Ҋߍ��W�̋O�Ղ��ڍs�v��ɐ܂荞��ł��Ηǂ��B

�O�����ׂ����ǂ��͖̂ʓ|�ŁA����قLjӖ��������B�Ȃ̂ŁA�O�Ղ�ǂ����Ƃ͂����A�X�^�[�g�_�ł̎p���i�����Q�j�ƏI���_�ł̎p���i���ʁj�ő������������Ȃ��悤�Ȏp���l�ɂ���������ȂƁA�v���Ă���B

�S�g�̎p����\���p���l�͉����g�̎p�����吨�����߂Ă���̂ŁA�㔼�g�ɂ��Ă͍l�����s���C���B�㔼�g�����ƁA���̓���ɂ��d�S�_�̈ړ������邽�߂ɉ����g�������̂����A���̎��̎p�������ʂ��ƁAJ2���s����Ȏp���Ȃ̂ŃK�V���K�V���������Ƃ������B�@���̕ӂ���������āAJ1Z�����Ȃǂ�܂荞�ޕK�v������悤���B

�ӂ��B�B�����ĕ������邭�炢���ƁA�t�^���w�v�Z�͊ȒP�����A��������Q�]��ƁA���G�ȓ��삪����ƂȂ��Ȃ�������Ƃ������B���C�ǂ��������Ă��������Ȃ��̂��낤���A��ς����B

���P���P�S����

����͂�ف[���{�b�g�J�[�j�o���̌��w�ɍs���Ă��܂����B�@�H�t���Ŕ��������������̂ŁA���������Ă���ςɍs�����̂ł����A�\�I�Q��ڂ߂̃{�g���g���N�V���������������I���Ƃ���ł����B�@���ǍŌ�܂ł��āA���w�҂Ȃ̂ɍ��e��ɂ܂ŎQ�����Ă��܂����B�@�D���������܂܂���A���D���̃C�K�@���߂łƂ��������܂��B������̔��M���������̓z���g�ɂ��炵�������ł��I

�O��̂�ف[�͑䕗�������̂ōs���Ȃ������̂ł����A���߂Ċςɍs���āA�v�����Ƃ���a�C���������Ƃ����y�����C�x���g�ŁA����͂��ЎQ���������Ȃ��Ǝv���܂��B�����A������ڎw���Ă��郉���_�Ɏd���݂��������Ȃ��̂łǂ��������̂��B�B�@����܂łɎd���݂Ȃ��ŃQ�[���ɎQ���Ȃ�Ăł���̂��H���Ȃ��Ƃ��L���[�u�͎������႟�ƂĂ������ȋ��Z�����B�B�@�ƁA�v���Ă���ł����A�l�`��������Ƙb�����Ă��鎞�A�u�����R������Ȃ��āA������^������čl����B�B�v���Ă����āA�ӂށA���������l���������邩�ȁ[�Ǝv���܂��āA������ƍl���Ă݂邱�Ƃɂ��܂����B�����u���͂܂��A�܂��A����ł����B(^^�U

�E�E�E�E�E�E�E�E�E�E�E�E�E�E

�����͎p���ڍs�̑����A�����p��������ʎp���i�̈����j�ւ̈ڍs������������Ă݂悤�Ǝv���܂��B

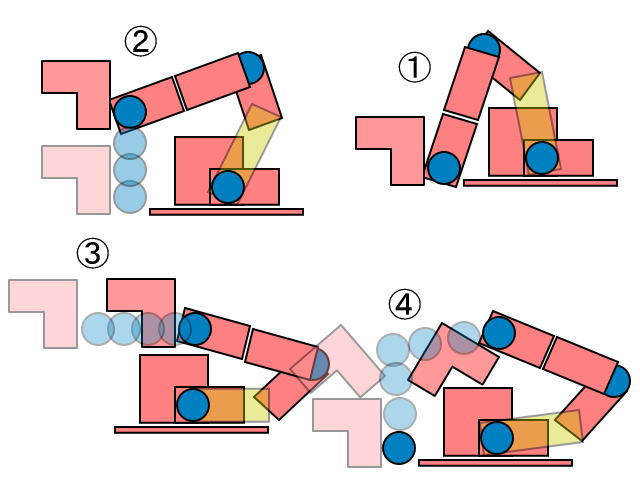

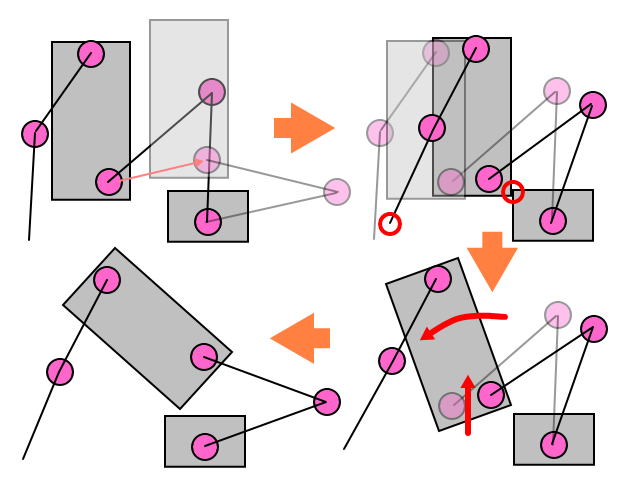

�}�́A�����_�̑��ʂ𗪂��ď����Ă��܂��B�Ԃ��_�͎p��������s�����̃`�F�b�N�|�C���g�������Ă��܂��B

�����p��������ʎp���ֈڍs����ۂɁA���������Ȃ��悤�ɍl����ƁA�Ҋ߂̋O���͐����̂悤�ɂȂ�܂��B����𒉎��Ɍv�Z�ŏo�����Ƃ��܂��ł���̂ł����A���ɂႮ�ɂ�̋Ȑ����႟�Ȃ��̂Œ����ŋߎ����Ă��������ȁ[�ƌ����Ƃ���B�Ƃ������ƂŎn�_�ƏI�_�̍��W���v�Z���āA�ڍs��̎p���l�ɉ������܂��B

���ۂɓ������Ă݂�ƁA�Ȃ�Ă������A�A���܂������͈͂������A�J�n�p���̏������������Ƃ����̂��ȁB���R�Ȏp�����炢�������̎p���ֈڍs�������̂����ǁA�Ȃ��Ȃ��������~�ɂȂ��Ă���܂���B�@�����ƍ�肱�݂��K�v�Ȃ悤�ł��B�@�̈������ӂ͂Ȃ��Ȃ��������ł��B

�E�E�E�E�E�E�E�E�E�E�E�E�E�E

�����ł͎p���ڍs�ɂ��Čv�Z�����ł��Ȃ����Ƃ��Ă��܂����A�{���͎p���ڍs�̍ۂ̑��̓������Ȃǂ͊e�߂̕��ׂƂ������̃X���b�v����A�S�̂̓���ړI�ɊO��Ȃ��悤�Ɋ߂�Ǐ]������悤�ɓ����A�X�ɂ͂��̓������w�K���āA�w�K�f�[�^����t�B�[�h�o�b�N�ʂ����Ȃ��Ȃ�悤�Ȋ߂̐���J�[�u�i�p�x�ƃg���N�ƃC���s�[�_���X�j���o�͂���悤�ɂ��ׂ��Ȃ̂����A�����������Ƃ���ɂ͍��̃����_�ł͂�����Ɠ�����B�w�K�V�X�e�����K�v�����A�܂��܂��悩�Ȃ��ƍl���Ă��܂��B�@������ƌ����ĂȂɂ����Ȃ��̂�����Ȃ̂ŁA���l�I�ɂǂ̂悤�ȗv�f���K�v�Ȃ̂����l���邽�߂ɂ��ł���Ƃ��납���낤�Ƃ��Ă���A�Ƃ������Ƃ���ł��B

�v���ƁA�����ƑO����A���[�V�����̐����ɂ��Ă͍l���Ă���̂����A����Ƃ����������t�����ł��Ȃ��܂܍����Ɏ����Ă���B������i�����͂��������Ȃ��낤�ȁB

�����ĕ����������l����ƁA�e�߂̈ړ��͈͂�K�v�Ȏp���͈͂͂�����x�͈̔͂ɂ܂Ƃ܂��Ă��邽�߁A�v�Z�ȂǂŎZ�o���������W���Đ����邾���ł悩�����B�@���ꂪ�A�����オ���A���Ⴊ�ݍ��݂Ȃǂ̓�����l����ƁA�r�[�ɉ\���Ɛ����������Ă���B�@�e���ʂ̊���A�߂̉��͈͂�d�S�Ȃǂ�����A�X�ɂ͓��쑬�x�����s�\�Ȕ͈͂Ȃ̂��A����ɂ���Đ����銵���͂ǂ������̂��ȂǁA�ȒP�Ȗ�肩�畡�G�Ȗ��܂ŕ��L�����݂���B

����͕����I�Ȗ��Ƃ��đ�����A���͊w�V���~���[�V�����Ȃǂ��s���āA�K�ȓ���O���Ɠ��쑬�x�i�Ɠ�������x�j���Z�o����A�A�Ƃ������ƂɂȂ�B�@�ł��A����͂�肽���Ȃ��Ȃ��Ǝv���Ă���B�@������A���Ԃ����邵�A���͊w�͂悭����Ȃ����B�B(>_<)�@�Ȃɂ��l�Ԃ͌J��Ԃ��w�K�ɂ���čœK�ȃ��[�V�����������o���ċL�����āA��������s���Ă���Ǝv����B�@����Ɠ������ƂƂ͖����Ƃ��Ă��T�˓����l�����œ�����\�z�ł��Ȃ����Ȃ��`�A�Ƃ����̂��l���Ă���̂��B

�F�X�Ȗ��̂����A���[������������J1Z�����Ȃǂ͊ߍH�w�̔��e�ɓ���̂��낤���A���R�x�����ōl����Ɖ\�Ȏp���ł������ԏ����ł͕s�\�Ȏp���Ȃǂ�����A���^�p�ł͔r�����čl���Ȃ���Ȃ�Ȃ��p��������Ƃ������Ƃ��B�����͕�������͈̔͂ł͔������ɂ������ł��B

���[�V���������G���W���̗��z�I�ȃC���[�W�Ƃ����̂͂��ڂ낰�ɂ͗L��܂��āA�Ȃ�Ă����̂��A�A�Љ�V�X�e���̂悤�ȓ����œ�������������B�@�e���ʂł͖ړI�ɑ��čœK�ȓ����Ƃ����̂�����̂����A���̕��ʂ̗v���ƍj���������āA���ʓI�ɑS�̂̃o�����X���d�����āA�e���ʂƂ��Ă͕s���������Ȃ�����S�̂Ƃ��Ă͗L���ɓ����A�Ƃ����V�X�e���ł��B

�q�ϓI�ɂ͍œK��������Ȃ����ǁA������o�����V�X�e���͍œK�Ƃ͔��f�����Ɍ��_�t����悤�ȁA�����Ƃ����ƌ��ʓI�ɍœK�ł͂Ȃ��Ă��\��Ȃ��悤�Ȍ��_���o���V�X�e�����l�������̂ł��B

�܁[�A���܂�Ƃ��u���킲�Ɓv�ł����B(^^�U

���P���P�T����

�܂��͋����Q������ʂւ̈ڍs���ł���悤�ɂȂ����悤�ł��B�㔼�g�̓������Ƃ邽�߂Ɉړ����̎p���l���L�`���Ɛ������Ă����Ȃ���Ȃ�Ȃ������̂����ǁA�㔼�g�Ɖ����g�̋������Ă̂�������̂͐����O�ŁA�F�X�Y��Ă܂����B

�@����Ȃӂ��ɓK���ɐQ�]�����Ă�Ƃ���ŁA

�@�܂��͎p���̐����B�����n�ʂɖʂ���悤�ɂȂ��āA�G���t�߂ɂȂ��Ă��̂����߂ɂȂ��Ă܂��B

�@�ŁA��̂��N�������ɁA���K�̐ڒn�ʒu�ɂ��킹�ĕG���Ȃ���B�@J1Z����������Ă���̂ʼnE���͂�����Ɖ�]���Ă銴���B

�r�͉����g�̓����ɍ��킹�ĕI���Ȃ����Ă��܂����A����͉����g�Ə㔼�g���������삷��悤�ɂ��Ă��邽�߂ŁA�㔼�g�ւ͖����I�Ȏw���͏o���Ă܂���B�E�E�E�ł��A�ڒn���Ă��鑫�ɑ�������W���Œ肵�Ă���͂��Ȃ̂ɁA���������͌Ҋ߂ɑ�����W���Œ肳��Ă���悤�Ɍ�����B�o�O���Ȃ��`�B������ƒ��ׂĂ݂Ȃ���B

�p���̐����̒i�K�ł͏㔼�g�͎�t������ԁB�@���ʎp���̐����Ɋւ��Ă��G���[�������s���Ă��Ȃ��̂ŁA�g���ł��Ȃ��Q�p���ƁA�����ƍ���܂���B���̂����肪���ꂩ��̍�ƂɂȂ�̂��ȁB�B

�ۑ���c���A���ʂ��珀���ʂւ̈ڍs�ւƐ�ɐi�߂Ă݂����Ǝv���܂��B

���P���P�U����

����͋����Q������ʂւ̈ڍs�̈ڍs�p���̐���������Ă݂�����ǁA�ڍs�p���̓K���`�F�b�N�Ȃǂ͂܂�����Ă܂���ł����B�@���̕ӂ�ɂ��āA�ǂ̂悤�ȃA�v���[�`�ōl���Ă����ׂ�����فX�ƍl���Ă܂����B

����̗�ł����ƁA�����Q�ƍ��ʂ̎p���̑傫�ȍ��͓��̂̃`���g�p�ɂ���܂��B�Ƃɂ��������Q�̎p���l����`���g�p���O�x�ɂ���̂����A���̓���̍ۂɔ�������ڒn�_�̓����ɍ��킹�ĕG�𗧂ĂĂ����Ƃ����p���̓��������܂����B�ł����A�����Q�̏�ԂŊ��ɗ��ĕG�ł�������A��̎��̎p���ŐQ�Ă����肷��ƁA���̕ϊ����[���͒ʗp���܂���B�O�q�̕ϊ����[�������V�Ƃ����Ƃ��ɐ����������ʎp���ɏC����^�������̂����A�ǂ̂悤�ȍl���̌��ɏC����������̂��H���z�p��������̂Ȃ�A���̎p���Ɉڍs����Ⴂ�������Ƃ������ƂɂȂ��Ă��܂��܂��B���̂悤�ɘb��i�߂Ă����ƁA���ǂ͍��ʂɈڍs����O�̋����Q�́u���̂悤�ȁv�p���ł��Ȃ���Ȃ�Ȃ��A�Ƃ��������ƂɂȂ�A�܂�͏]���̃��[�V�����Đ��ɂȂ��Ă��܂��܂��B

�Ԃ����Ⴏ�A�����オ�蓮��������邾���Ȃ畁�ʂ̃��[�V�����Đ��ł܂��������͂Ȃ��̂ł����A���[�V�����̐����Ƃ����̂́A�����I�ɂ́f����ɂ�����u�g���Ȃ��v�������I�ɐ������s����f�Ƃ�������ȖڕW�Ɍ��������߂̌����̈ꕔ�Ȃ̂ł��B

�����̓��̒��ł͂������̃L�[���[�h������A����炪���܂����т��悤�ȃA�v���[�`�͂Ȃ����̂��ƍl���Ă��܂����B

���̃L�[���[�h�Ƃ����̂́u�����I�v�Ƃ������̂Ɓu�v��I�v�Ƃ������̂ł��B�i���̂悤�ȒP����L�[���[�h�Ƃ��Ă���̂ł͂Ȃ��A�C���[�W�Ȃ�ł����ǁA�����ĒP��ɂ���Ƃ��̂悤�Ȃ��́B�{�L���u�����[���R�����̂ł����ƓK�ȒP�ꂪ���邩������Ȃ��B�j

�u�����I�v�Ƃ����̂͒P������̃J�^�}���Ƃ����̂����{�b�g�̐���ɂ͕K�v�ȍl�������Ƃ������ƂŁA�u�v��I�v�Ƃ����̂͂R������Ԃ⎞�ԋ�Ԃɑ��݂��郍�{�b�g�Ƃ����͎̂��Ԃ̊T�O�i�\���Ƃ��\���ƌ����Ă������̂��ȁj���K�v���Ƃ������ƁB

�����͂Ȃ��肪�a�ȍl�����̂悤�Ɏv���āA���܂��Ȃ���Ȃ������̂����ǁA�����A�ӂ��ɂȂ�ƂȂ��Ȃ������C�����܂����B���̓�̃L�[���[�h���Ȃ��̂́u�w�K�v�Ƃ����t�@�N�^�[�ł��B�u�����I�v�ȍs���œ���ꂽ���ʂ��u�w�K�v�ɖ𗧂Ă邱�ƂŁA�u�v��I�v�ȍs�����o����悤�ɂȂ�A�Ƃ�������ł��B�@�u�w�K�v�����{�b�g�ɂƂ��ďd�v�ȃt�@�N�^�[�Ȃ̂ł��̗v�f�łȂ������Ƃ������Ƃ͂ƂĂ��C�����������̂ł��B�L��I�ȕ����ł͗\���v�f�������A����ł͎��s����I����ŕK�v�\���i�œK�ł͂Ȃ��j�̔����_��T���B

������x�͋�̓I�Ȏ����̕����������Ă��Ă���̂ł����A�������炭�͂��́u�ӂ�ӂ킵���v���o�̂܂܂Œg�߂Ă݂����Ǝv���܂��B���n�ȃA�C�f�B�A�͑����������}����Ƃ����̂��I�`�Ȃ̂ŁB

�E�E�E�E�E�E�E�E�E�E

���āA��g�̕����������������Ă����̂ŁA�茳�̖���Еt���čs�������Ǝv���܂��B

����A���������ȁH�Ǝv�����̂̓o�O�Ƃ������l���s���ŁA�d�S�I�t�Z�b�g�p�����[�^���㔼�g�Ɖ����g�̘A������ɉ������Ă��Ȃ��������߂̃Y���ł����B�@�l������̎��͕s�v�ȗv�f�������̂Ŗ��z���������̂ł��B

�����͂��̕ӂ���C�����A�V�����A�C�f�B�A�̎������@�̍��q�������E�������Ă��������Ǝv���܂��B

���P���P�V����

�p���ڍs�̑����B

�d�S�I�t�Z�b�g�̍l���������āA�㔼�g���v���ʂ�̓���������悤�ɂȂ��Ă��܂����B�@�r���A�d�S��̃p�����[�^�̎�舵�����ԈႦ�Ă��āA�v���ʂ�̓����ƂȂ炸�����ƔY�܂���܂����B�����オ��܂ł͏d�S��̓I�t�̂܂܂ł������Ă��Ƃł��B�@�����A�d�S��̂���������傫�������荶�E�ɂԂꂽ�肵�Ĕ[�������Ȃ��̂Ō�����Nj����Ă����K�v�����邩���B�@���݃o�O�͑��߂ɒ@���Ă����ׂ��ł��B

�F�X�Ɩ����c���A���͍��ʂ��珀���ʂւ̈ڍs���������܂��B�����ʂƂ����ʒu�t���́u�l���v�Ƃ����Ă��܂��Ă������̂����ǁA���́u�����ŗ����Ă��邯�ǁA������Ȃ��ƈێ��ł��Ȃ��v��Ԃł��B�@�ł��A���͂���������̗����オ��ł͕G���g�����u�����ʁv���`���˂Ȃ�Ȃ��̂Ő�̕\���͋�������̗����オ��ߒ��ł́u�����ʁv�Ɍ��������̂ƂȂ�̂ł��傤�B

�u�����ʁv��Ԃ���d�S���x�����p�`�ɓ���邱�ƂŁu���ʁv�ւƈڍs���܂��B

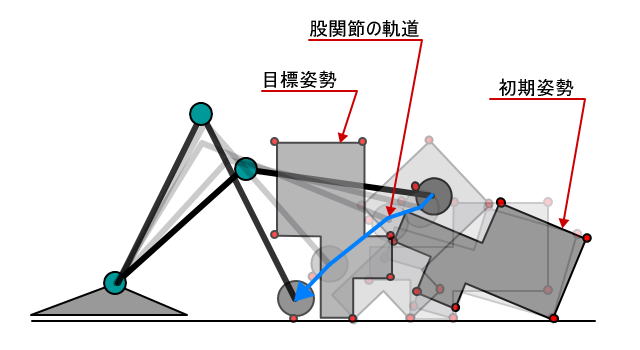

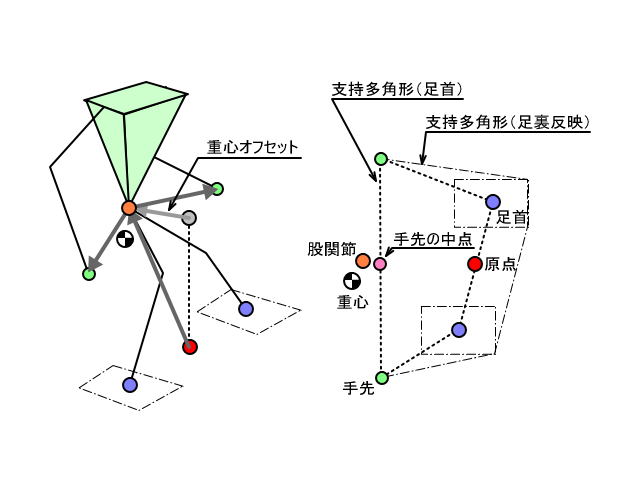

���̐}�̓����_�̉����g�𗪂��ĕ`�������̂ł��B�@�����_���E���ʂ��猩�Ă���}�ł��B�@�@�����ʂ�\���Ă��܂��B

���A���ʂ��珀���ʂɂȂ�Ƃ������Ƃ͗���̐��n�ʂɂ�����ԂŁA�A�̂悤�ɍ��������グ����ԂƂȂ�܂��B�@���̌�A�d�S�_�����炵�čs���A�B�̏�Ԃ܂ł����Ă����u���ʁv�ւ̈ڍs���ł���Ƃ������Ƃł��B

�����A�����_�̎�̒����́A�^���ɐL�������ɇA�̎p���ɃM���M���Ȃ�邭�炢�Ȃ̂ŁA��𒅂��ʒu�ɂ���Ă͒n�ʂɎ肪�͂��Ȃ��ꍇ���o�Ă������ł��B����ƁA�C�̂悤�ɏ�̂���ɂ��炵�Ȃ���A����n�ʂɂ��ďd�S�_���V�t�g�����Ȃ���Ȃ�Ȃ���������܂���B

�@���A���B�@�̃P�[�X�łł���ΊȒP�Ȃ̂ł����A�C�̃P�[�X���l�����Ȃ��킯�ɂ͂����܂���B�@�l���Ȃ���Ȃ�Ȃ����Ƃ��������ł��B

�܂��͊ȒP�ɇA�B�̃P�[�X�ł̗����オ��ڍs�܂ō���Ă݂悤�Ǝv���܂��B

�E�E�E�E�E�E�E�E�E�E

�C�̃P�[�X�ɂȂ�ƁA�e���ʊԂł̊������ɂȂ��Ă��܂��B����A���ɂ��Ă����ڍs�p���̓K���`�F�b�N�ɂ��Ă����̔����͊��ł��B���ɂ��ăP�[�X���Ɍ�������̂��ʓ|���Ă��������{�b�g�I�ł͂Ȃ��̂ŁA��X�I�Ɋ��`�F�b�N�̂����݂��\�z���Ȃ���Ȃ�Ȃ��ȂƎv���Ă��܂��B

����͏㔼�g�̓��쐶���ɂ͌������Ȃ��Ǝv���Ă��āA�r�̋O���������s���i�K�Ŏ������悤�Ǝv���Ă����̂ł����A�����g�ɂ��Ă��K�v�Ȃ悤�ł��B

���{�b�g�̐g�̃f�[�^���ȒP�ȃ|���S���W�������āA�ߊp�x��K�p������ԂŊ����`�F�b�N���܂��B�d�S�v�Z�ŋ߂��v�Z���s���Ă���̂ł��Ό��\�����ɂł����Ȃ����Ǝv���Ă����ł����A�A�A�����ł���Ɏ���o�����B�@�����͍Œ���̋@�\�̎����ŏI��点�āA���{�r�����[�h�̑���������ڎw�����A�����Ƃ���ł��B

���͍���l���Ă�����g�̕������̌����A���`�F�b�N�̎d�g�݂��K�{�ŁA�t���[�����Ɋ��`�F�b�N�����Ȃ���Ȃ�܂���B�Ȃ̂ŁA�S�Ă̑g�ݍ��킹�̊����`�F�b�N����̂ł͂Ȃ��A����ɉ������Œ���̃`�F�b�N���ł���悤�ȕ��@���l����K�v������܂��B

���P���P�W����

�����A�����_���{�b�g�������̃A�N�Z�X�J�E���^�[���P�O�O�O�O���܂����B�@�K���l���܂�Ȃ��̂g�o�A�P�O�O�O�O�܂ōs���̂ɂ��傤�ǂP�N������܂����B�J�E���^�[��ݒu�����̂̓T�[�o�[��ς��Ă���B���ׂĂ݂�ƁA�T�[�o�[���ړ]�����̂͋��N�̂P���Q�Q���ł����B�Q�O�O�O�O�ɂȂ�̂͂܂��P�N���炢������̂��ȁ[�B(^_^;)

�����́A����̑�������낤�Ǝv���Ă����ǁA���͂��̏T���Ɋ�̊O�������������悤�Ƃ����Ђ����Ȗ�]������܂��āA�،^�����傢�Ƃ������Ă܂����B�C�����Ƃ���Ȏ��ԁi���ԂɃQ�[��������肵�Ă�����������̂����A���ߑO�R����(^_^;)�@�j�@���ƌ��Ԃ��p�e���߂����肵�Ȃ���Ȃ�Ȃ����ǁA�㓪�̖،^�Ɗ畔���̖،^�̏C�����I���܂����B�@�p���ڍs�͂܂�����������ɂȂ��Ă��܂������B

�@�������č����㓪�A�E����̖،^�ł�

�p���ڍs�͖�����낤�B�@

���P���P�X����

������x�̌��߂����ł̎p���ڍs�Ȃ�ȒP���낤�ȁA�@�Ǝv���Ă����̂͊ԈႢ�ł������B����������풆�B

�����_�̑��̘r�̒����͂Q�Q�O�~���A�Ҋ߂��猨�߂܂ł̐��@�͂P�P�O�~���Ȃ̂ŁA�Ҋ߂��牺���ɘr���P�P�O�~���L�����Ƃ��ł���B�@�Ȃ̂ŁA��̂P�O�O�~�����x�A�������邱�Ƃ��ł���B��𒅂��ʒu�������Ƃ��̐��@������������Ɩڌ��肷��B�@����ɁA�����Q�̎p���̎��̘r�̈ʒu�����̉摜�̂悤�Ȏp���Ȃ�A�i��悪�Ҋ߂̕ӂ����Ȃ�j�@����Ȃӂ��ɍ��������グ�邱�Ƃ��ł���B�@������ɉ��낵����Ԃňڍs���Ă����ƁA���K���肪�O�ɂȂ��Ă��܂��A��ɓ]��ł��܂��B

�@

�r�̒����ɂ����E������̂ŁA�������鐡�@�����߂�K�v������B���@�����߂�ɂ́A��𒅂��ʒu����t�Z��������킯�����A����́A���̐�́u�p����͍�����v���߂̎d�g�݂��l���āA�g���C���Ă��߂Ȃ琡�@��ς��čăg���C�A�Ƃ����ӂ��Ƀ��[�v���č������鐡�@��T���悤�ɂ��Ă݂��B

���̂��߂ɂ͌���������d�g�݂��K�v�ŁA������������邽�߂̃v���O�����̉����ʂ��傫���Ȃ��Ă��܂����B�@���̂��߂Ȃ̂��ǂ�������Ȃ����A���ȃo�O���������ł��܂����悤���B�@�r�̈ʒu��������Ƃł��ǂ��ɂ��Ȃ�Ɓi�X�����܂��킩��Ȃ��j�A�������Q������ʂւ̈ڍs�̍ۂɃj���[�[�[�[�[���ƉE�����ւ���Ă��܂��B�܂������A������Ȃ��o�O�Ȃ낤�Ȃ��`(>_<)�@���܂̂Ƃ��댴���s���B

����͂���Ƃ��āA�����Q�̎��̘r�̈ʒu�����肷��킯�ɂ͂����Ȃ��̂ŁA���ʂɂȂ��Ă����𒅂��v���Z�X�ŁA���K�������グ�鎞�̏d�S�ʒu�Ƃ̊W���l���Ď�𒅂��ʒu�����߂�v�Z���K�v�B

�����̓o�O���ƁA���̕������@�̌����ƃR�[�f�B���O���ȁB

���̎��ɂ͂��ɗ��ʁi�ŁA���Ⴊ��ł����ԁj�ւ̈ڍs�ƂȂ�̂����A�d�S�𗼑��̏�Ɏ����Ă����O���̓��o��������Ȃ�Ȃ��`�A���������A���̃��[�g�ŗ����オ�邱�Ƃ��Ăł���ȁ[(^_^;)�@�G�r�����āA�G������ԂɂȂ��āA���ꂩ�痧���オ������������H�@�v�����B

���P���Q�O����

�����͗\��ʂ蓪�̊O����肩����|����܂����B

�㓪���̐��^�e�X�g������Ă݂܂������A��C�R�ꂪ����̂��A���s�B�@��C�R�����{���čă`�������W���܂������A������Ƃ܂��ɂȂ������x�B�@���s�ł��B�@�����Ƒ���l���˂Ȃ�Ȃ��̂ŊO�����͂����ŏI���B�@��C�R�����J���y�L�ɂ���Ή��P����̂��ȁA�|���@�̃p���[������Ȃ��̂��B�@�p���[�s�����Ƃ�����ƍ���ȁB

�@

���s��������_�Ɏ��t���Ă݂܂����B

�@�@

�@�U�����s���Ċ���グ�߂��݂����ɂȂ��Ƃ�܂��B

�F���h���Ė�������C�}�C�`�����ǁA�J���W�͂łĂ܂��B�@���������B�@��ʕ����㓪�����܂��ŏI�łł͂Ȃ��̂����ǁA�A�������̒���������Ȃ��Č��Ԃ��J��������Ă܂��B�@�����_�͂܂��Ԃ�V�Ȃ̂ŁA���W�����Ȃ����ĂȂ���ł��ˁB���ꂩ�珙�X�ɐL�тčŌ�ɂ͂�������A�����Ă����̂ł��傤�B(^^�U

�E�E�E�E�E�E�E�E�E�E�E�E�E�E�E

���āA�p���ڍs�̕��ł����A����̃o�O�͖������܂����B�܂���͂艺��Ȃ��~�X�ł����B

��𒅂��ʒu���ǂ����邩���Ęb�ł������A������Ɛ}�ɂ��Ă݂܂����B���̐}�̍������e�|�C���g�̈ʒu�������Ă܂��āA�����n�ʂɓ��e�����̂��E�̐}�ł��B

�d�S�_���Ă̂��Ҋ߂̋߂��ɂ���܂��āA���ꂪ�A���藼���ō��x�����p�`�Ɋ܂܂�邩�ǂ������������āA�����Ȃ�悤�ɒ������܂��B

�{���͏d�S�_���x�����p�`�Ɋ܂܂�邩�ǂ�������������ׂ��Ȃ̂����ǁA����̃P�[�X���ƁA����̎����W�̒��_���Ƃ��āA���̓_�Ɣ�ׂďd�S�_����ɂ���_���ŁA�O�ɂ����OK���Ĕ���ŏ\���ł��傤�B

�������̂ł��Ă��܂����B����������ƍ�肱�݂��K�v���Ȃ��Ċ����ł��B�@�������Ɨ��ʂւ̈ڍs�ɐi�܂˂B�@�����Q����̗����オ����ɂ���Ă���̂͊ȒP������Ȃ̂ɂĂ������Ă܂��B�@���̌���A����������̗����オ��͕G�����̔���Ȃǂ����˂Ȃ�Ȃ��̂ł����Ƒ�ςɂȂ肻���Ȃ̂ɁB�B�@

���P���Q�P����

�����͋A��̂��x�������̂ō�Ƃ͖����B

�ł����A�����͂��܂����B�@�����ʂ��痧�ʂւ̎p���ڍs�̈ڍs�O���������@�ɂ��āB

�����ʂ��痧�ʂւ̈ڍs�O���̐����͐���v�������u�����I�v�Ɓu�v��I�v�]�X�̍\�z���I�Ɏ�����܂��B��͓I�ɎZ�o������@�����邩�Ƃ͎v���܂����A�\�z�̎������Ɍ����Ă̎������܂߂Ă��������Ǝv���܂��B

�����ʂ́A��𒅂��ė����Ă����Ԃł��B�@���ʂ͗����ŗ����Ă����Ԃł��B�@�P�X���̉摜�ɂ���悤�ȏ����ʏ�Ԃ��痧�ʂɎ����Ă���ɂ͏d�S�𗼑��̏�Ɉړ�������Ƃ������Ƃł��B�@�����_�̘_���d�S�_�͗��Ҋ߂̒��_�ł��B�@���ۂɂ͎p���ɂ���ďd�S�ʒu�͕ς��̂ŁA���̈ʒu���d�S��l�Ƃ��Ď����Ă��܂��B

���̐}�̍���̏�Ԃ������ʂŁA�����`�����p���ֈڍs�������Ǝv���܂��B���������Ă���̂����z�ڕW�p���ł��B

�����āA�����O���ňړ���i�߂Ă����ƁA�r���Ŋ�������A�̂��x���Ă����悪�����Ă��܂����肵�܂��B�@�����̃G���[���o�͐���t���[�����ɁA�ړ������s����O�Ɍ������s���܂��B

�G���[�����o���ꂽ�t���[���͏C���������܂��B���ɂ��Ă͈ړ��������㑤�ɉ�]�����Ă����A�����N����Ȃ��ړ������������܂��B�@���ɂ��Ă̓`���g�p�����A����n�ʂɋ߂Â���悤�ɂ��܂��B���̓�̃p�����[�^�����X�ɕύX���A���E�r�����̏������������܂ŒT�����܂��B

���̓���𗝑z�d�S�_���ڕW�ʒu�ɓ�������܂ŌJ��Ԃ��܂��B�@���z�d�S�_�̖ڕW�ʒu�Ƃ́u�����̐^��v�Ȃ̂ŁA�����͏ɂ���ĕς�邩������܂���B

���ʂƂ��āA�����̂悤�Ȏp���ɂȂ����肵�܂��B�@���x�͂��̎p���ł̏d�͕�l���Q�Ƃ��A�^�̏d�S�_���u�����̐^��v�Ɉړ������Ă����܂��B

���̈ʒu�Ǝ肪�����Ă���ʒu�͌Œ�Ƃ���������������܂܂ňڍs�ł���̂��H�@���̏������������āA�������点�Ȃ���d�S���ړ�����Ƃ�����i�������I�Ɏ������ׂ����B�@�T���̌��ʁA�P����t���[���ł̈ړ��ʂ��傫���Ȃ��Ă��܂����肵�Ȃ����H�@�ȂǁA�������Ȃ���Ȃ�Ȃ��_�͂܂���R�c���Ă܂��B�@���ƁA�܂����������ĐÓI�ȓ��삵�������Ă��炸�A�����x�⊵�����[�����g�Ȃǂ̕����ʂ͍l���Ă��܂���B�@�������������ʂ��l���ł���������낢���삪���܂ꂻ���ȋC������̂ł����B�B

���܂��O���������ł���悤�Ȃ�O���̍œK���i�w�K�j���l���Ă݂����ł��B

���P���Q�Q����

���Ȃ������s�����㓪���̃o�L���[���ɍĒ���B�@�܂��e�X�g�Ȃ̂ŁA���N�O�ɔ����ĕ��u���Ă����v���o���i����ł�j���g���ăe�X�g�B

��C�R�ꂪ���ƒf�肵�āA�O��I�ɖ������A�v���o���������t����ʂɃX�|���W�Ńp�b�L���܂ł��ăg���C�B�@���̐��ʂ������āA�������z���͂Ńv���o�����z�����܂�܂��B�@�ŁA�z�����܂ꂷ���ĝ���ł��܂��Ă܂���C�R��H�@���^��͑��O���͂悭�Ȃ������ǂ�͂莸�s�ł��B�@���Ɍ㑤�����s�B�@�����낾���ł����܂��������܂������̂ɂȂ��B

�@

�㓪���̃g�����蕔���͂��̂܂܂ł����B(�[�[;)�@����������Ȃ��B�@�ǂ����|���@�̋z���͂͏\���Ȃ悤�ł��B�،^�̌`��v���o���̔M�������e�����Ă��邾�낤������������������Ȃ����Ȃ�Ȃ��悤�ł��B�@���̊O���������o�L���[�����g������Ȃ̂Ő��i���˂B

���ƁA�P�~���̃v���o���Ŋ畔���𐬌^���Ă݂܂����B�@���x�͐����オ���āA�����̂����ǁA���킪�����Ă��܂��Ď��s�B�@�O�D�T�~���f�ނ��P�D�O�~���f�ނ̕����M������Ƃ낯�����ɂȂ��Đ��^������I�@����Ă݂Ȃ���킩��Ȃ����Ƃ����ł��B

�c��̉��݃v���o���́A���Ă��܂��ăo�L�o�L�Ɋ���Ă��܂��܂����B�@���A�ɒu���ĂĂ��_���Ȃ̂ˁB(T_T)

�E�E�E�E�E�E�E�E�E

����̓�����ONO������d�]�ǐV���Ɂu�����ʂ��痧�ʂւ̋O�������v���Ă��ƂŌf�ڂ���܂����B�@�������ɂ���˂��������˂̃��{�b�g�O�����O�������B�@�����O�������ł����x�����Ⴂ�߂�(^_^;)�@�R���Z�v�g�͈Ⴄ�ɂ��Ă�������ƒp���������B�B�B�@

���́u�����ʂ��痧�ʂւ̋O�������v�����Ȃ���Ȃ��E�E�E�A���܂Ōo���Ă����{�r�����[�h�Ƀg���C�ł��Ȃ��B

���P���Q�R����

�u�����ʂ��痧�ʂւ̋O�������v�̃v���O�����R�[�f�B���O���J�n���Ă���̂����A���܂܂ł̓���̎d�g�݂Ɛ����ƈႤ���߁A��q���B�@��������������u�����ʂ��痧�ʂւ́E�E�v�Ɍ��炸��ʉ������v���O�����ɂ��悤�ƍl���Ă���̂����A��ʉ��ł���T�O�Ȃ̂��ǂ����H

�������̈ړ��A�Ҋ߂̈ړ��ƍl����ƃp�^�[���Ƃ��Ă͊����������u�I��v�Ƃ��A�����钼�O�܂œ��삷��u���E�ړ��v���炢�̃p�^�[�����ȁH�Ǝv���Ă���̂����A�Ҋ߂̈ړ����đ���̈ړ��i�����������j�Ɠ�������ȁH�Ƃ��A�`���g���ڍs����Ƃ��ɂ́u�I��v�Ȃ�Ăł��Ȃ���ȁH�Ƃ��A��ʉ�����ɂ̓p�^�[�����������Ĕ��U���Ă��܂������B

���ƁA���̌������킹�čl����Ǝ����̕��@�������ƕς�����Ⴄ�Ȃ��`�Ƃ��A�܂��܂������������B

���̎d�g�݂���ʉ��ł���ƁA���ɂ�����̂������グ�铮��Ȃ��A�قڎ����I�ɐ����ł��邱�ƂɂȂ�܂��B�Ώە��̍��W��^���邱�ƂɂȂ�̂ŁA�ʒu���킹�̂��߂ɂ��܂��ܓ������肷��K�v�͂���܂���B�@�X�ɂ͎����グ�郂�m�̏d��������A�����グ�鎞�ɏd�S��v�Z�Ƀ��m�̏d���������邱�Ƃŏd�����̂������Ă��d�S������Ă������肵�Ȃ��悤�ɁA�Ȃ�Ă��Ƃ��\�ł��B�@���ʂ̓��{�r�����[�h�œI���|�R���Ɠ|������Ɋ��������ȂƁB�@�E�E�E�y���݂��Ȃ��`�B�@�s���N�{�[���ɋ߂Â��āA�{�[���������グ�郉���_�@(*^_^*)�@�A�C�{�ł��{�[�������邱�Ƃ͂ł��Ă��{�[���������グ�邱�Ƃ͏o���Ȃ���������A���ꂪ�ł����烉���_�̓A�C�{���邱�ƂɂȂ�I�i�z�l���������Ă̂͂ł������ǂˁB�j

�E�E�E�E�E�E�E�E�E�E

�����������{�����̃e�N�j�J���J���t�@�����X�B�@�����̂���u��������̂ŕ����ɍs�����Ǝv���Ă���B���e��ɂ��Q���������Ȃ��ǁA�ΐ삳��̘b���Ɓu�����̃��{�b�g�����������v�����ā@(^_^;)�@�@�����_�����čs���Ă��������̂Ȃ낤���H�@�d��������b�ɂȂ�Ȃ�����y�����œ�������悤�ɂ�����Ă̂��O���ǁB

���P���Q�S����

���������u�����ʂ��痧�ʂւ̋O�������v�ɂ��āB

�p���l���g�������[�V�������A�ߊp�x����g�����p�����[�^���A��̎p���������p�����[�^�̍������k�߂Ă����Ƃ������Ƃɂ͈Ⴂ���Ȃ��̂����A�����I��O����T�����Ȃ���ڍs����Ƃ�������̃P�[�X�͈ꖡ�Ⴄ�B

����͎p���̈ڍs���u����ړI�ɂ����v�ڍs�Ȃ̂���m��K�v������A�Ƃ������Ƃ��B�@�X�^���X��ς��邱�ƂȂ̂��A�d�S�I�t�Z�b�g��ς��邱�ƂȂ̂��A���Ⴊ��ł����Ԃ��痧���オ�邽�߁A�܂��͗����Ă����Ԃ��炵�Ⴊ�ݍ��ނ��߂Ȃ̂��A�@���ꂪ�킩��Ȃ���Ί��ɑ��ĉI��ɗ��p����p�����[�^�͉��Ȃ̂��A�܂��I����������߂邱�Ƃ��o���Ȃ��B

�����ƌ��������Ƃ���A�ȉ��̂R�̃p�^�[�����L��

�@�Ҋߒ��S���W�̈ړ��i�d�S�_�̈ړ��j

�A�����̈ʒu�W�̈ړ��i�X�^���X�̈ړ��j

�B�Ҋߎp���̈ړ��i��̎p���̈ړ��j

�@�`�B�͗��p�p�x���̂���B�@���炭�B�̏�̎p���̈ړ��Ŏ��g�̊�������邽�߂ɉI����s���P�[�X�͖������낤�B�@�@�ƇA���ɍs���ꍇ���l�����Ȃ����Ƃ��Ȃ����A����͑����u���s�v�Ȃǂ̂悤�ɏ\���ɊǗ����ꂽ����Ǝv���̂ŁA�l���Ȃ��Ă悢���낤�B

�Ƃ����킯�ŁA�ړ��ڕW�p���Ƃ̎p���̔�r���s���A�@�̃P�[�X�Ȃ̂��A�̃P�[�X�Ȃ̂��A�͂��܂��B�̃P�[�X�Ȃ̂��f����B

���ɁA�ړ��ʂ���肷��B�R������ԏ�̈ړ��Ȃ̂ŁA���m�ɂ͎O������ԏ�̒������`���āA���̒����ȊO�̂��ׂĂ̋Ȑ����u�I��H�v�ƂȂ�̂����A����Ȃ͈̂Ӗ����Ȃ��̂ŁA�傾�����Q����I�яo���A�I��H�͂��̂Q���������ʏ�ł̋Ȑ��Ɍ��肷��B

�����g�̊��ɑ���I��H�͑�̌����Ă����B���ɁA���̍��W���ێ����邽�߂̉����g�̎p�������B

�����W���ێ����邽�߂ɒ������ׂ������g�p���̃p�����[�^�́A�`���g�ƍ����̂Q�p�����[�^�ƂȂ邾�낤�B���E�����ł̍��W�����ɂȂ邱�Ƃ͏��Ȃ����낤����A�܂��͑O������̍��W�ōl��������͂��B

�����ʂ��痧�ʂւ̈ڍs���ƃ`���g�����̒����ƂȂ邪�A���m���E�����삾�ƁA�`���g�ƍ����̗������g���B�ǂ̃P�[�X�̂ǂ̃^�C�~���O�Ń`���g�ƍ����̃p�����[�^���g��������̂��B�@������̉I��ŁA�u�����v���g�����Ƃ���ƁA�����W�ێ��̂��߂̒����Łu�����v���g���Ă��܂��Ƒł����������Ă��܂��Ȃ��B�����������ǂ�����Ď��ʂ���̂��H

�g�̂̓���Ƃ����̂͊߂̕����⓮���̍L���ȂǂŎ��R�ƗD�揇�����܂��Ă���̂��낤�Ǝv���B�����I�Ȑ�������D�揇�����܂�AJ1���s����ɂȂ�悤�Ȏp���͔����ē����̂����R�ȐU�镑���Ȃ̂��낤�B���{�b�g�̏ꍇ�͐l�Ԃ̂悤�ȑ@�ׂȊ߂̏�����Ȃ��̂Ń��������ɂł��v���ʂ�ɓ��������Ƃ��Ă��܂��B

�ނ��������Ȃ��`�A���w�v�Z�Ōv�Z�������Ȃ��Ă��܂��B

���P���Q�U����

����Ƌx�݂ɓ˓����܂����B�@�x�݂̂����ɂ���Ă�������������R������ǁA���āA�����ł��邩�B�B

�o�L���[���̉��P���ǂ���낤���H�p���`���O���^���ɂ�����x���オ���Ă悳���Ȃ��A�l�i���Ȃ��`�A���X����������̂��A�A�Ɩ����Ă����̂����A����̏o���̋A��ɏH�t���A�c�N���̃��{�b�g�����Ɋ������A�A���~�̃p���`���O���^���������Ă܂����B�������┄���Ă��Ȃ��B�A���~�Ȃ̂Ō��\�����B800�~������ƁB�@����ŁA�|���@�̋z���͂ɕ����Ăւ��Ⴐ�邱�Ƃ͖������낤�B�@�O�̂��ߑ��ʂɋ�C�������Ă������B�z���͒����p�A�K�X�e�[�v�Ȃōǂ��B�@�����̂͂��ꂩ��Ȃ̂Ō��ʂ̒��͂܂��s���ł��B

�@

�����_���Ƃ��玝���o���Ƃ��ɂł��邾���y���ɂ��������Ă��ƂŁA�o�b�e���[�[�d�p�̂P�QV��AC�A�_�v�^�[���Ă����B12V4A��800�~�B�����B�H���Ŕ����B���ʂ�4A����1600�~���炢���邩�甼�z���B�@1A���Ꮽ�Ȃ����A4A�͒l�i���������A2A���炢�̂͂Ȃ����Ȃ��`�ƒT���Ă��Ƃ��낾�����̂ł��ꂵ���B�������A�W���b�N�̃T�C�Y���`���[�W���[�ƍ���Ȃ��̂ŕt���ւ��Ă܂��B�@�d���𑪂��12.2V�AAC�A�_�v�^�[���ĈӊO�ƍ��߂̓d�����o���Ă��肷��̂ŗv���ӂł��B�@���̓d���Ȃ�RPU-100�ړ�������B�����_�ɓd���������邽�߂̃P�[�u��������Ă��������ȁB�@���Ƃ�PC�����A�o��ŃR���p�C�������Ȃ���Ꮼ���ȃm�[�gPC�ł��\���Ȃ̂ŁA�ו��͏������Ȃ����͂��B

�ŁA�����_�ɂ͎��������܂����B�@�L�����I�݂����Ɏ������f�U�C���ɑg�ݍ��݂����������ǁA���߂��B�@���������A����ς�~�ɔ����H�͂ł��Ȃ��ȁB�������ʂ��Ǝv�����B�@���������ɓ��肽�������̂ŎG�Ȏd���ɂȂ��Ă��܂����B(>_<)

�@

�ŁA�̐S�̎p���ڍs�̕��́A�x�N�g���x�[�X�ł̈ڍs�����܂ł͊����B�@�Ҋ߂̈ړ��A���̎p���̕ύX�A�����𒆐S�Ƃ�������̈ړ��A����p���̕ύX�i���E�j�Ƃ����T�̈ړ��x�N�g�����A�w��̑��x�ňړ�������悤�ɂ��܂����B���̎p���̕ύX�ɂ��ẮA���̎��ʂɂ�銵�����[�����g�̉e�����l�����āA�Ҋ߂����ɁA���ߕ������ړ����鑬�x���p���x�ɕϊ�����悤�ɂ��܂����B�@���͕K�v�ɉ����Ă��̃x�N�g������]�����ĉI��H���ł���悤�ɂ��܂��B��ɏ㔼�g�Ƃ̋����������낤���ȁ[�B���ꂪ�ł�����{�[�����E����悤�ɂȂ�B�B�@������Ƃ悱���܂ȋC�����ɂȂ��Ă܂��B�@�I��H�֘A�́A�x�N�g���̉�]�Ɗ��`�F�b�N�́A����́u�����ʂ��痧�ʂւ̈ڍs�v��p�ɍ��܂��B�ėp�����邢����i���v�������Ȃ��̂ƁA���ւ̓K�p�����炭�K�v�Ȃ����������Ă��Ƃŗe�ՂɎ����ł����i�ɂ��Ă����܂��B

���P���Q�V����

�Ƃ��Ƃ��x�݂��I���A�v�����قǗ\������Ȃ��Ȃ������B

�p���ڍs�́A�x�N�g���x�[�X�ł̈ڍs������J1Z�����������܂����B

J1Z�����͌Ҋ߂̍��E���iJ1�߁j��0�x�ɂ��āA����̃��[���p��ς��邱�Ƃő�����W�����K�����킹��Ƃ��������ŁAJ1�߂̊p�x��0�x�Ɍ��߂������邱�ƂŁAJ1�߂̕s����ȗ̈�����肳����Ƃ��������ł��B

����͌Ҋ߂̑O�㎲�iJ2�߁j�����̂ɑ��Đ����Ȋp�x�ɂȂ����ꍇ��J1�ߊp�x���}�s�ɕω�����������������̂ł��B�@�X�^���X���ҊߊԊu�ɑ��č������������AJ1�̕ω��͋}�s�ɂȂ�A���̊p�x�͈͂͋��܂�܂��B

�܂�A���m���E���Ƃ������ʂ��痧�ʂւ̎p���ڍs�Ƃ��͍����Ȃ������p���������̂�J1Z�����͕K�{�B�@�����AJ1���s����ɂȂ��Ă��珈������ꂽ�̂ł͒x���̂łǂ̂悤�ȃ^�C�~���O�ŏ�����}�����邩���l���˂Ȃ�܂���B

�I��Ƃ��A�����W�ւ̋����Ƃ��A�v��𗧂Ă��Ȃ����������̂��x�N�g���x�[�X�ł̈ڍs�����Ȃ̂ŁA�S�̂̓����̗�������Ăǂ̕ӂ��J1Z������}�����邩�A�Ƃ������R�g�͏o���Ȃ��B�@�X�ɁA�d�S����l������Ƃ����ƕ��G�Ȃ��ƂɂȂ��Ă��܂��B

J1Z������������ɏd�S���������ƁA���̍����̂�����J1���s����ɂȂ��Ă��܂��B�@�Ȃ̂ŁA�d�S����������p���ɑ���J1Z�������s��Ȃ���Ȃ�Ȃ��B�@�����A�p���ɏd�S��������Ă��܂��Ƃ�����Ƃ�������Ȃ��Ƃ��N�����Ă��܂��B���̎p���ڍs�����͈ڍs���[�g�����܂��Ă��Ȃ��̂ŁA�ڍs�̏I������́A�ړI�̎p���ɂȂ������ǂ����Ŕ��肵�Ă���B���̃^�[�Q�b�g�p���ɂ͏d�S��͓����Ă��Ȃ��̂ŁA�p���ڍs�̏I�����肪�ł��Ȃ��Ȃ��Ă��܂��̂��B

�ꉞ�͓����悤�ɂ����̂����A�ڕW�̎p���ɂ���Ă͂��܂������Ȃ���Ȃ����Ǝv���B������H�v���肻���Ȋ����B�@�ڕW�p���ɏd�͕�l����ꍞ��ł��܂������̂����A�d�͕�l�͐^�l�ł͂Ȃ��ߎ��l���v�Z����悤�ɂ��Ă���̂ŁA���O�Ɍv�Z���Ă����l������Ȃ��̂��B�@���̕ӂ��������K�v�����邩������Ȃ��B

���̋x�݂ŁA�����W�ւ̋������삩�A�I��܂ŃR�[�f�B���O������肾�����̂ɂł��Ȃ������B(>_<)�@���ƁA��������̗����オ�肪�ł����Ƃ��Ă�����������̗����オ��͂܂��܂������肻���Ȃ̂ŁA���[�V����������ė��K��Ƃ��Ńf�����悤�ɂ����������̂����A�����������B�@�Ȃ��Ȃ��Ȃ��v���ʂ�ɂ����Ȃ�����ł��B

J1Z�����̑}�����@�ɂ��Ă̓X�}�[�g�ȑ}�����@���l���Ď����Ă݂����A�C�}�C�`���܂��s���Ȃ��B�@����̉ۑ�Ƃ������ƂŐ�ɐi�ނ��Ƃɂ����B

J1Z�����̓K�p�͈͂�J2�ߊp�x���}0.2radian �Ɛݒ肵�Ă��邪�A���������L�߂��悳�����B����J1�s����͈͂̓X�^���X�������قNj����A�ω����}�s�ɂȂ�B�@������x�̑��x�œ������Ă��s�s�����N����Ȃ��͈͂����Ȃ���Ȃ�Ȃ��B

�����_����Z�b�g�̌y�����̈�ŁA�����_�̃v���O�����̊e��ݒ�l���O���ݒ�t�@�C���Őݒ�ł���悤�ɂ����B�@�ȒP�Ȑݒ�ύX�Ȃ�\�[�X�t�@�C���ƃR���p�C�����Ȃ��Ă��e�L�X�g�G�f�B�^��FTP������ΊȒP�ɐݒ�ύX�ł���悤�ɂ��܂����B�@����̐ݒ�p�����[�^�͏o���邾���O���̐ݒ�t�@�C������w�肷��悤�ɂ�������𗧂��Ƃ����邾�낤�B

�Ƃ肠�����̐ݒ�p�����[�^�Ƃ��ẮA�@�J������ONOFF�@�]�|��g��ONOFF�@�]�|����p�����[�^�e��@�]�|���̔������[�V�����ԍ��@�Ȃ�ݒ�ł���悤�ɂ��Ă������B

�e�N�j�J���J���t�@�����X�܂łɂ���������������悤�ɂ��āA�ꉞ�̓����_�������Ă��������ȁ`�ƁB�@����܂łɃ{�[���E����悤�ɂ������Ȃ��B