�J�������C���f�b�N�X��

�O�̃y�[�W��

���P�P���R����

�Ƃ��Ƃ��P�P���ɓ˓��B���ǁA�ؗj�������j�������݂ɍs���Ă��̂ō�Ƃǂ��납�����̍X�V���ł��܂���ł����B����A��Ƃ��ĂȂ�����J�������̍X�V�͖����̂��B�B

�����̓}���I�M�����N�V�[�����A�����ԂɍH��B�Ƃ��Ƃ��A�^�}���j�b�g�i�قځj�����I�@�{�̂Ɏ��t���܂����B

����̖ڋʂ́A����I�@�ڋʂ���Ȃ��āu�܂Ԃ��v�I�܂Ԃ��̓o�L���[���t�H�[���ō���Ă݂܂����B

�@�畔���̊g��B

���̓J�����͉E�ڂ����ŁA���ڂ̓_�~�[�B���ڂ̃����Y�̉���LED�������������Ǝv���Ă����ǁA�������Ă݂��炢�܂����Ȃ̂łǂ����悤���ȁB���Ȃ����܂ł͍��ڂ͕ʂ̌`�̃��C�g�ɂ��悤�Ǝv�����̂����ǁA�܂Ԃ�������f�U�C�����ƁA����ς�V�����g���[�ȕ����������ȂƎv���Ă��傢�Ǝ�`���Ȃ��ă_�~�[�ɂ��Ă��܂����B

�@�ڂ�����Ƃ���B

���͊O�����Ȃ��̂Ŗڂ��J���Ă���Ƃ܂Ԃ������т݂����Ɍ����邯�ǁA�O����������ڂ��J�����Ƃ��ɂ͂܂Ԃ��͊O���̗��ɉB���悤�ɂ���\��B�@�K�`���s���݂����ɂȂ銴���B�^���ڂ���Ȃ����ǁB

���Ƃ��Ƃ́A�A�����Y�L�p�ɂ���ƂԂ�ȓ��ɂȂ��āA�ڋʂ���яo���C���B����p���L�����炻���Ȃ���ǁA���������ɐ^����ɒn�ʂɌ��˂���̂������Y�ɂȂ鋰�ꂪ����B�ŁA���������ɂȂ�����ڂ��Ԃ��ă����Y��ی삷����Ă̂͂ǂ����ȁ[�Ǝv���Ă��Ă݂��B�ł��A��������^����ɉ���̂��܂Ԃ�����Ȃ����Ǝv���܂��B(^^�U�ی�ɂȂ邩�ǂ����͂͂Ȃ͂��������B

�܂Ԃ��̊J�̓~�j�T�[�{�ōs���܂��BRPU-100��2�`�����l����PWM�T�[�{�C���^�[�t�F�[�X�����Ă���̂ł���̂ЂƂ��g���B���Ȃ݂ɗ��ڂ��ЂƂ̃T�[�{�œ������Ă���̂ŃE�B���N�͂ł��܂���B

�����`���ď��������ǁA���͖������g�ݗ��ĂĂ�Ƃ��낪�����āA�܂����ǂ��K�v�B�\��������g��ł��đg�ݗ��Ă�̂����J�B�����炵�����Ȃ��C�������ǍŒ������x�炳�Ȃ���Ȃ�Ȃ��B�炢�ȁ[�B

�����͍Ō�̍H��Ɠd����H�A�����ăT�[�{�삳���悤�Ǝv���Ă܂��B

���P�P���S����

�u���̂��߂̃T�[�{�̃����N�ɑ���B����22�������ǁA�܂��d���̔z����������B�������A�A�^�}�̎��t���͊��S�Ɋ����B�d��������̂Ɏ��t������悤�ɂȂ�܂����B���Ƃ͂͂t���B

��킵���܂��������N��������ƕs�����c�銴�������ǁA�����B���������u�����J��Ԃ����[�r�[���ǂ����B��

�}�C�N���T�[�{�͎v������蓮�삪�x���B�܂����p�`�p�`���銴���͂łȂ������B�����Y�ی�̂��߂̋@�\������܂������̂�(^^�U

�F�X�s��������̂����A����ȏ�̉��ǂ͓���v���O�����œ������Ă݂Ă���ɂ��悤�B���肪�Ȃ��B

�������A�������j�b�g�A��������ꔭ�ʼn�ꂻ���B�F�X���������̂����A�����O�����ʓ|�ȍ\���ɂȂ��Ă��܂����B���i�𑝂₵�Ăł������O�����ȒP�ɂ��āA��ꂻ���Ȏ������s���Ƃ��̓X�g���X�����O���悤�ɂ��Ȃ��ƃC�J�����낤�Ȃ��B

�V���b�N�A�A�A�@�J�����t���܂Ɏ��t���Ă��܂��Ă�B�B�@���������A�A�����炷�̂₾�B�B�B

�㑤�i��ʂ��Ɖ����j�͂܂Ԃ��ł�����Ǝ��E���ǂ���Ă���B�v���Ɗ��S�ɂ܂Ԃ����J���̂����T�[�{�̃����N�̊W���A�H�쐸�x���A�J������Ȃ��B�������v�����Ȃ̂Ń��V�Ƃ������B

���P�P���T����

�d���z�������B

�@�@

�@�����Ɠ�T�[�{�Ȃ��\��Ȃ̂ł�����Ƃł������M�����[�^

�A�^�}���j�b�g�̃T�[�{��G-ROBOT�Ɠ���RS302CD�BRS601CR�Ƃ͓d���d�����Ⴄ�̂Œ��ڂȂ����Ƃ͏o���Ȃ��BRS601CR�p�̓d�������M�����[�^�ɓ����7.4V�ɗ��Ƃ��Ă��Ȃ���Ȃ�Ȃ��B

�ȒP�ȃ��M�����[�^�̉�H�Ȃ��ǁA�v���Ԃ�̂͂t���Ő����Ǝ�Ԏ�����B�o���オ����s�o���Ȃ���őS�R�������Ă��Ȃ����ǁA����������B�͂t���͖ʔ����Ȃ��B

300�n��600�n�ł͑����p�P�b�g���Ⴄ����u�߂�ǂ��������v�Ǝv���Ă����̂����A�A�h���X�}�b�v��������ƈႤ�����Ńv���g�R���͓����B���ׂ��Ƃ���A601�p�ɍ�����T�[�{�̊Ǘ��c�[���͂قڂ��̂܂g����B

�Ȃ��ł݂���Ȃ�̖����Ȃ��ʐM�ł��ăz�b�Ƃ����BID�̐ݒ�ƃ{�[���[�g�̐ݒ���s�����̂�601�Ɠ����ڑ��ł���悤�ɂȂ����B�����ڑ��̌��ʂ��e�X�g�v���O�������x���ł͖��Ȃ��B

�悭�m�F���Ă��Ȃ����ǁA�������[�}�b�v����ʌ݊��ɂȂ��Ă�̂��H�@601�̕�����ʂ��Ďv���Ă��̂�601�ł͎�������Ă��Ȃ��p�����[�^�������ς݁B601���t�@�[���A�b�v���ė~�����ȁB

301/302�ɂ�����601�ɖ����̂́A���]�E�ԐM�x�����ԁE���݃X�s�[�h�E���ݓd��

601�ɂ�����301/302�ɖ����̂́A���������ԁELED�EPID�����l

���]���~�����ȁ[�B���]����������A������Ƃ����v���O�������ȒP�ɂȂ�B�܁A�ق�̂�����Ƃ����ǁB���܂�Joint�N���X���Ă̂�����āA�����Ŕ��]������ݒ肵�Ă���̂ŋC�ɂ��Ȃ��Ă����悤�ɂ͂��Ă���B�@�@�E�E�E������v��Ȃ����B

�����͂����x���̂ŃT�[�{�Ƀg���N������͖̂����B�@�T�[�{�������ɓ��������Ȃ̂ŃJ�����̐���͂����ɏo�������B���K��܂łɌ`�ɂł�������̂����B

�E�E�E�E

���āA���̓}�j�s�����[�^���O�����B�@�H����������Ă�킯�ɂ��s���Ȃ�����v���O�������i�߂Ȃ��ƃ��{�b�g����Ȃ��Đl�`�̂܂܂��B���̓v���O�����ɖ߂�Ƃ��悤���ȁB�J�����܂Ŏ����ł������玩���œ����悤�ɂ���Œ�����͑������B�i�o�b�e���[�ς�łȂ����ǁj

���O�����ė��N�̔N���ɍڂ����������̂����A���N���������ۂ�(^_^;)

���P�P���U����

�����j�b�g�̃T�[�{�Ƀg���N�����Ă݂܂����B�T�[�{�̏����l�ȊO��601�Ƌ��p�ł������ł��B�����l��601�Ɠ����ɂ�����n���`���O���N�����đ�ςȂ��ƂɁB�����u���u�����Ă܂����B���ƁA�g���N���䂪601�Ƃ͈قȂ�݂����B�����悤�ɐ��l��ύX���Ă��g���N�͕ς��Ȃ��悤�Ɋ������B���̕ӂ�͂��������m�F���K�v�Ȃ悤�ł���B

�O�̓��������Ƃ��̓C���[�W���X�R�[�v�h�b�O���ۂ��������ǁi�炪�V�����g���[����Ȃ��������A��������Z�����j���x�͉����H�Ƃ肠�����L�����I�ɂ͎��Ă�ȁB�炾���́u�V���[�g�T�[�L�b�g�v�̃i���o�[�T�Ɏ��Ă�ƌ���ꂽ�B�܁A���Ă���ā[�������`�ɖڂ������炠�̊�ɂȂ邵�B

���Ƀg���N�����������Ƃ����A�K���ɗ������ċL�O�B�e�B�@�����_�̃y�[�W�̉摜���V�����@�̂ł̉摜�ɕύX���܂����B

�����������̃T�[�{�̐�����@�ɂ��čl���Ă݂܂��B

�����̂R�̃A�N�`���G�[�^�̓���̓J�����̎p���𐧌䂷�邽�߂ɓ��삳����̂ł����āA�葫�̂悤�ɐ�[���W�A���̏ꍇ�̓J�����̍��W��ړI�̈ʒu�Ɉړ�������A�Ƃ����K�v�͂Ȃ��B�@�Ȃ̂ŁA�������j�b�g�̋t�^���w�v�Z�͒��s���W�ł͂Ȃ��A�J�����p���̐���ɗp������B

�p���͂R�̊p�x�ł���킷���ƂɂȂ邪�A�������j�b�g�̓��[���p�iZ����]�j�ƃ`���g�p�iX����]�j�����Ȃ����߁A�`���g�p�ƃ��[���p�����^���鎖���ł��Ȃ��B�p���p�͂��̎p������������̌��ʂƂ��ė^������B�������͌v�Z�ŋ��߂邱�Ƃ��\�B

�����j�b�g�̎p���Ƃ��Ă͊�{�I�ɃJ�����p�����w��������j�ōs�����B�����A�`���g�p�{���[���p�ł͒����I�ł͂Ȃ��̂ŃJ�����ڐ��̃x�N�g�������������Ɨ�������̊p�x�i�W���C�X�e�B�b�N��X���p�x��Y���p�x�̂悤�ȁj���w�����邱�Ƃɂ��悤�B

�����A�������j�b�g�ɂ͎�������A�`���g�p�A�N�`���G�[�^�͓������B�X�Ƀ��[�����ƃJ�����̈ʒu�Ɋւ��Ă̓I�t�Z�b�g������B���̂��߁A�^�����p���̑��ɐ��䂷�ׂ����Ƃ������킯�ł͂Ȃ��B

���Ƃ��A�Q�]��ł����ԂőO�����鎞��A�����Ă��鎞�ɐ^�������鎞�ȂǁA��̃`���g����g���Ȃ���Ȃ�Ȃ��B

��̃`���g���ǂ̂悤�Ɏg�������邩�Ƃ����̂���̉ۑ�ɂȂ�B�ȒP�Ȃ͕̂G�̃_�u���T�[�{�̂悤�ɓ����ɓ��������Ƃő��x���҂��悤�ȕ��@�B��������͂��܂��Ȃ��B���`���g�i��̕t�����̕��j�͑O���ɂ�90�x���炢��]�ł��邪�A��둤�ɂ͂قƂ�Ǔ���悪�Ȃ��B����ăJ����������������ɂ͐�ɖO�a���Ă��܂��B���m��ڂŒǂ��悤�ȏꍇ�ł��A���`���g�͉d���傫�����߁A�Ǐ]���x��������͂��B���`���g��D��I�Ɏg���A����悪����Ȃ����ɂ͑��`���g���g���Ƃ����P�[�X�ƑO�o�̓��ʂȎp���̓��ʂȎ���������Ɏg���Ƃ����Q�{���Ăōl���Ă������B�@����̍����̃`���g����`���g�Ƃ��邱�Ƃɂ����̂ŏC��

����Ȃ���Ȃœ����j�b�g�̃T�[�{�̃R���g���[�����@�ɂ��Ă��Ȃɂ��w�j���K�v�B

�J�����̎p���𐧌䂷��ȊO�ɂ������̃T�[�{�������Ƃŕ\��L���ɂȂ�B�܂Ԃ������킹��Α����ȕ\���͂���������悤�ɂ��v���̂����A���������̂̓��[�V�����Ŏd���܂Ȃ��ƂȂ�Ȃ����߁A�Ƃ肠�����͕ۗ��B�u�����ςݏd�˂邱�Ƃŕ\��o�Ă�����ʔ����̂ɂȁv�Ƃ������}���`�X�g�ȋC����������̂ł��B

���P�P���V����

������p�̃N���XHead���쐬�B

����̌����ŁA�J�����̌����Ă�������ŊǗ�����悤�ɍl���Ă������A�����Əڍׂ��l����ƁA�J�����������Ă�������Ƒ��`���g�̊p�x�ŕ\�����邱�ƂƂ����B

����������鎲�iY����]�j�������Ă��Ȃ����߁A���E����������ŋp�����ƁA�J�����͎߂������B�J�������[���p�ƌĂ�ł��邪�A���̒l���Ǘ�����K�v������B�I�Ȓl�Ȃ̂ŁA���������v�Z���Ȃ��ŌĂяo���ۂɌv�Z����悢�B

�T�[�{���������̂܂g�����̂ŃR�[�f�B���O�͐�قNJ��������B��������f�o�b�O�B

�E�E�E�E�E�E�E�E�E�E�E�E

�����j�b�g�̊�{�N���X�̍쐬��i�߂A�����̂��߂ɉ�����������̂����l���Ă���B

�E�܂��͗����オ�肪�ł��Ȃ���Ȃ�Ȃ��̂ŁA����ł̓��[�V�����Đ����K�v�B

�E���ɕ��s�B����͑O�i�A��ށA�J�[�u�A���̏��]���ł��Ȃ���Ȃ�Ȃ��B�p�����[�^�����̋@�\�̓i�V�B

�E�]�|�ɂ��Ă͓]�|���m���Ďg�p���A�g���N�𗎂Ƃ��ďՌ��z��������B

�E�J�����ɂ��Ă͂܂���CDT�ŐF�ɔ�������悤�ɂ��悤�B�����ĐF�̂������̂Ɏ������g���b�L���O������B�@�摜�擾�i����щ摜�����j�v���O�����Ɠ��쐧��v���O���������L���������ȂŒʐM������悤�ɂ���B���łɉ����������������Ă݂悤���ȁB

�E���Ƃ͎����s�������A�܂��͔F�m���Ă��镨�̂ɋ߂Â��Ƃ����Ƃ��납��B���X�ɂ���������Ă������Ǝv���B�����Ƃ��A�F����Ȃ����m��F�m�ł���悤�ɂ������B

�����v���O�������l����Ƃ����v�l�̗��ɏo�Ă��܂��B�������g�݂����̂����A�܂��͊�{�I�Ȑg�̐��䂪�ł��Ȃ��Ǝn�܂�Ȃ������̂��B�ق��̂͏��m�̂����łƂɂ��������ɂ��Ă������Ǝv���B

���P�P���W����

�F�X�蒼���B

�܂Ԃ������S�ɊJ������Ȃ����Ƃ�A�܂Ԃ���������Ƙc��ł��邱�Ƃ�A�J�����Ƃ��������j�b�g�T�[�{�̔z���P�[�u�����������邱�Ƃ��C�ɂȂ��Ă����̂ň�C�ɏC�������B�܂Ԃ��͂قڊ��S�ɊJ���悤�ɂȂ����B�܂Ԃ��̂䂪�݂��܂�������͈͂Ɏ��܂����B�����A�ڂ��J���Ƃ��u�J�`�b�v���ĉ�������悤�ɂȂ��Ă��܂����B�C�ɂȂ�B

�N���XHead�������B�x�N�g�����w�����邱�Ƃł��̕����Ɋ�������A���̎��̃J�������[�����v�Z�ł���悤�ɂȂ����B�i���́A�Ȃ��Ȃ������B�@�J�����ŕ��̂��g���b�L���O�ł���悤�ɂȂ�̂͂���������Ɛ�ɂȂ肻���Ȃ̂ŁAPS2�̃W���C�X�e�B�b�N�œ�������悤�ɂ��Ă݂����A�v���g�R�����蔲���i�l�Ԃ̑���ł̒ʐM��O��Ƃ��Ă���̂ŁB�B�j�Ȃ̂ŁA�Z�������ł̘A���R�}���h��M���Ƃ��܂������Ȃ��B�@�܂������͂����Ƃ��낶��Ȃ��̂ŁA�����������ȁB

���āA�����i�J�����j�̃��J�v�֘A�͊��������̂ł܂����[�����������ւ̑Ή��ɕ��A���B�����܂ł��������C���v�������g���Ďp���x�[�X�ł̃��[�V�����Đ��ɂ��Ă��܂������B

�ŁA����������̕��̘b�肾���A�AJ1=0�ł�IK�ϊ��ŁA��ɂ��Ă����Ζʂւ̑Ή������A�@���x�N�g���ɂ���ΊȒP�ɕϊ��ł��邱�ƂɋC�t�����i���Ă��C�t�����ă��x������[�Ȃ��̂����j�̂ł�����������Ă��܂����Ǝv���B�����A�����ł���͂��B�@�J�����̎��������Ƃقړ���������B�B

�E�E�E�E�E�E�E

����A�V�����������Ă̎B�e���������A�킴�ƕG���Ȃ����p���ł̃|�[�Y�ɂ����̂����A�����_�͎����Ȃ��Ă��܂����̂łȂ��Z���ɂȂ��Ă��܂����B�����ł��邾���L���ĎB�e���Ȃ����B

�i�����B�e�j�@�@�@

�i���Ȃ����B�e�j

����ׂ�Ɩڂ������ƊJ���悤�ɂȂ����̂�����B�@�g�b�v�y�[�W�̉摜���A���̉摜�ɍ����ւ��悤���ȁ`�B�@��A��肽���ȁ`�B

���P�P���P�O����

J1=0�ł�IK�ϊ��ɂĎΖʂ�ۑ����邱�Ƃ��ł����B

�Ζʌv�Z�ɂē���ȏi90�x�̐�ǂƂ��A�I�[�o�[�n���O�ȕǂƂ��j�̓t�H���[���Ă��Ȃ����A���{�b�g�������Ă����Ԃ̎ΖʂȂ���Ȃ����x���ɂ͂Ȃ��Ă���悤���B

J1=0�ł�IK�ϊ����Ă����̂́A���[�����������̉����Ƃ��āAJ2=-90�x�̏�J1���傫���ω����邱�Ƃ�����邽�߁A���̋ߕӂł�J1=0��O��Ƃ������p�����v�Z����IK�ϊ��̂��ƂŁA������W�Ɠ��̂̎p���͕ۑ����邪�A����̌�����J=0�Ƃ��邽�߂Ɏ��R�ɂ����v�Z�̂��ƁB

���̎��A���{�b�g�������Ă���ʂ��Ζʂ̏ꍇ�͎Ζʂ��ۑ����Ȃ���Ȃ�Ȃ��B����̌��������R�ƌ������Ƃ͑���̎p���p�x��ۑ�����̂ł͂Ȃ��A���悪�ڂ���Ζʂ�ۑ����Ȃ���Ȃ�Ȃ��B

���ʁA�����_���Ζʂ���s���邱�Ƃ�Ζʂɗ����Ƃ��������\��Ȃ̂ŁA���ʂ͕��u����͂��������B�����A�Q�]��ő��������グ��悤�ȏꍇ���l����ƁA���Ȃ炸���ʂɗ��O��̌v�Z���Ǝg���Ȃ����ƂɋC�t�����B

����ɂ͎Ζʂ�@���x�N�g���ŕ\���ΊȒP�ɕϊ��ł��邱�ƂɋC�t�����̂ł��̍ہA�������Ă��܂����Ƃ������Ƃł�邱�Ƃɂ����̂��B

���̓I�[�o�[�n���O�̕ǂƂ����̂͐Q�]��ő��̗�����Ɍ����Ă���悤�ȏ�Ԃ������Ă��āA���̏�Ԃ��t�H���[�ł��Ă��Ȃ��̂Ȃ�܂����p�ɂ͑ς��Ȃ��Ƃ������ƁB�����A�`���g�p�ix����]�p�j�ɂ��Ă̓I�[�o�[�n���O�ł������ƌv�Z�ł���̂ő��͖��Ȃ��B���ƂȂ�̂̓p���iy����]�p�j��90�x�ȏ�̎������Ȃ̂Ń��{�b�g���^���ɓ|�ꂽ��Ԃ⑫�����E�ɑ�J�r�����ꍇ���Y������̂��ȁB

�ŁA��̓I�ɂ́�����Ȋ����ł��B�Ζʂɗ����đ������Ă���̂����A�Ζʂɍ��킹�đ�������Ă���̂œ��͓̂����Ȃ��Ƃ������Ƃł��B

���͂����Ɠ��̋O�������B���p�O���ɂ�������ł�����ǂȁB�B�B

���P�P���P�P����

���������̓��[�V������i�߂悤�Ǝv�������ǁA�����Ăق�̂�����҂�i�߂����ǁA���[�V�����͂ǂ��ɂ��C���i�܂Ȃ��Č��Ǖ��u�B

���T�̗��K��ɂ��Q���������ȂƎv���Ă���̂����A��͂�낭�ɓ����Ȃ��܂܃����_��A��čs�����ƂɂȂ肻���B

�����A�����ł������炿����Ƃ͌��h���͂��邩�ȁ`�ƁA�ŁA�����o�������Ƃłł��邱�Ƃ���肽���ȂƎv���āA�������ƃg���b�L���O�̃f���I�v���O����������Ă݂邱�Ƃɂ����B

�@�@

�v��ł̓T�[�{�𐧌䂷��v���O�����Ɖ摜����������v���O�����͕ʂ̃v���Z�X�ɂ��āA�����v���Z�X�ԒʐM�ł��Ƃ肷��Ƃ��������ōl���Ă����B

���ɊȒP�ȉ摜�����̃v���O�����͓����Ă����̂ł������������ΊȒP�ɂł��邩�Ǝv���ē�̃v���O�������ɓ�������悤�ɂ��Ă݂��B�A�����Ȃ��B

RPU-100�̃��{�b�g�֘A�f�o�C�X�̓v���O������ŃC�j�V�����C�Y���Ă���g���̂����A��̃v���O�����ł��ꂼ��C�j�V�����C�Y���Ȃ���Ύg���Ȃ��̂ɁA����v���O�����̕��Łi�r�f�I�֘A���������������[�h�ɂ��Ă��j�f�o�C�X���I�[�v������Ă��܂��āA�摜�����̕��ł̓f�[�^���擾�ł��Ȃ��Ƃ������ԂɁB

���炭���s���낵�����A�炿�������Ȃ��̂ł��̌��̓X�s�[�V�[�Y�ɖ₢���킹�邱�ƂɁB���������ĉ����������炢�Ԏ����邩�킩���̂����B

���x�������߂ă��[�V��������낤���Ƃ��v�������A���쐧��v���O�������ʼn摜�擾��������܂����ƁA����قǓ���Ȃ����A�Ƃ������Ƃł���ς�g���b�L���O�Ɏ��|�������B

�ł��A���̂Ƃ��낤�܂��s���Ȃ��B��͂�摜�擾�̎��ԂƊߊp�x�����m�ɂ킩��Ȃ��Ƃ��܂������Ȃ������B�A�C�{���Ƃ��ꂪ�\�Ȃ��ǂȁB

����͊ȒP�ɍς܂����������̂ʼnĂ����������CDT���g���Ẵg���b�L���O�Ȃ̂����A���̏ꍇ�A���̂�F�����Ă���킯�ł͂Ȃ��̂Œ��L�p�����Y���Ƃ��܂��Ȃ��B����̌i�F���S�������Ă��܂��̂ŕ��̂����ł��Ȃ��Ȃ��Ă��܂��̂��B�@�Ƃ������ƂŁA��̉摜�ł̓Y�[����Ԃɂ��ĉ�p�͍��E��80�x���炢�ɋ��߂Ă���B

������Ƃ���Ă݂����z�Ƃ��ẮA��͂蓯���v���Z�X���ʼn摜�������s���Ƃ����͖̂��������肻���B��̂ɂ���16fps���炢�����o�Ȃ��L���v�`���[�Ȃ̂ɁA25ms�����̊��荞�݃��[�`���������Ă��6fps���炢������荞�ݏo���ĂȂ��B�v���Z�X������ǂꂭ�炢���P����̂����Ă̂�����Ȃ����A������͂܂����낤�B���Ȃ݂ɃA�C�{����32ms����������31fps���炢�B

���́A���������ĕʃv���Z�X�Ńf�o�C�X���g���Ȃ����Ă����\��������ȂƎv���Ă��āA���̂Ƃ��͎�荞�݂����͓����v���O�����ōs���āA���L�������Ƀf�[�^����������ʼn摜�����͕ʃv���Z�X�ōs���Ƃ������Ƃ��l���Ă����B���A���̎�荞�ݎ���������Ƃ��̈Ă��ĂȂ��Ȃ��Ǝv���B

���P�P���P�R����

����͈��݂ɍs���Ă��̂ŊJ���͋x�݁B

���͍�����łɃX�s�[�V�[�Y����₢���킹�̉��������̂����A�����_���_���ȕԎ��ł���[�u���[�ȋC���ł��B�S���ɓd�b����ƁA�u�p�\�R��������ꂽ�̂Ńf�[�^���Ȃ��Ȃ����v�Ƃ��A�����̃v���O������RPU-100�̃f�o�C�X���Ɏg���iRS485������v���O�������g���A���̃v���O�����ʼn摜�L���v�`���[���s���Ƃ��������j���Ƃ͂ł��邩�ƕ����Ă���̂ɂ��̉��Ȃ����߁A����ɂ��ĕ����ƁA�u�����ł����Ƃ��������ǁA�킩��Ȃ��B�v�Ƃ����킯�̔���Ȃ��B

�c�Ƃ���킩��Ȃ����낤����G���W�j�A�ɕ����Ă���Ƃ����ƁA�u���̎d�����Z�����ĂƂĂ�����ɂ��Ă���Ȃ��B�v�Ƃ��B�B�@�₢���킹����O����w�^�����Ղ�͑z�������Ă����̂����A�i�ȑO����₢���킹���邽�тɂ���Ȋ���������j�܂��������ɗ����Ȃ��B����������RPU-100�Ƃ͉���肽���ȂƉ��߂Ďv���܂����B

�ł��A11���̏ł͐�ɐi�߂Ȃ��̂ŁA����ɂȂ�Ȃ��c�Ƃ̃Z���t�𗊂�ɂ����ЂƓ���肵�Ă݂邱�Ƃɂ��܂����B

RPU-100�ł͐�p�f�o�C�X�𗘗p����O��spsInitializeDevice( )�Ƃ����������s����̂����A��̃v���O�����ł��ꂼ�ꂱ������s����ƌォ����s�������ŁA

saa7113h:open: Device busy

�ƌ�����B�X�s�[�V�[�Y�̃G���W�j�A�͑o����spsInitializeDevice( )�����s����̂����������̂ł́H�Ƃ��Ă����ۂ��Ō����Ă��炵�����A��������s���Ȃ���f�o�C�X�֘A�̊������s�����r�[�ɃR�A�_���v����BspsInitializeDevice( )�ɂ͈����������āA�r�f�I���g��Ȃ��ꍇ�̐ݒ�Ƃ����̂�����̂����A���̈����͂����ς蓭���Ă���l�q�͂Ȃ��A��͂�f�o�C�X�r�W�[�ɂȂ�B�@������Ŕ���悤�ɃX�s�[�V�[�Y�̓T�|�[�g����C���܂������Ȃ������B������ςȂ��B���܂܂őΉ����Ă���Ă��T�[�{�̃t�@�[���C���͑o�t�d�q������Ȃ��B(>_<)

�܂��������������ł����ȃP�[�X�Ŏ��������_���B�ǂ��ɂ��f�o�C�X�֘A�̎d�g�݂��킩��Ȃ��̂Ŏ�̏o���悤�ɍ���̂����A/dev/�ɂ�saa7113h0�Ƃ����f�o�C�X�t�@�C�������邭�炢�Ȃ̂ł���قǂ������ȏ����͂����Ă��Ȃ��͂��B����ƁA�f�o�C�X���I�[�v�����ăt�@�C���f�B�X�N���v�^���ǂ����̃O���[�o���������ɓo�^���āA�f�o�C�X�֘A���͂������Q�Ƃ��邱�ƂŃt�@�C���f�B�X�N���v�^�Ȃǂ̈������g�킸�Ƀf�o�C�X�ɃA�N�Z�X�ł�����Ċ����̂����݂��Ȃ��Ƒz�����Ă݂�B�܁A���̂�����͏ڂ����Ȃ��̂ł��Ă����ۂ��ł��B

����ƁAfork����execve���Ă��Ԃł͂��̕ӂ�͌p������Ȃ������Ȃ̂ł��߂��ۂ��B�ł�execve����O�̎q�v���Z�X�Ȃ�p�����Ă���͂�������g����͂��B

�ŁA�����Ă݂��fork���������̏�ԂȂ��̃v���Z�X����f�o�C�X���g�����Ƃ͂ł��܂����B�Ƃ������ƂŁA�Ⴄ�v���O�������炻�ꂼ��f�o�C�X�𗘗p����͍̂��̂Ƃ��떳�������A�Ⴄ�v���Z�X���痘�p���邱�Ƃ͉\�A�Ƃ�����Ԃł��B�ł��A�A�A����͂��ꂾ�ȁA�₾�ȁB�ł������v���O�����������āA���ꂼ�ꔼ�������g��Ȃ��킯���B

�f�o�C�X���g��������1�{�̃v���O�����ɂ܂Ƃ߂āAfork���ē�ɕ����BRS485�S����saa7113�S���ɕ�����āA���ꂼ�ꂪ�X��fork���ĉ�͕���v�Z���̃v���O�������N���B�����ƒʐM���ăf�[�^������������T�[�{�ւ̎w�������肷����Ďd�g�݂ɂȂ�̂��ȁB�߂�ǂ������������ǁA�������������x�͌����I�Ƀf�o�C�X�ɃA�N�Z�X�ł������B

�f�o�C�X�Ǘ��̎d�g�݂��z���ʂ�Ȃ�f�o�C�X�Ǘ������Ă��郁�������e���n�b�N���ē������삷��ʂ̃v���O�������ɓ��e���ڐA����Ȃǂ���Γ�������悤�ɂȂ邩������Ȃ��B�ł��A���̈Ă͖����Ȃ��A��͂��鎞�ԂƘJ�͂����������Ȃ��B

��i���������Ă悩�����̂��A�v���ʂ�ɂ͂����Ȃ����Ƃ��قڔ������Ĕ߂��ނׂ��Ȃ̂��A���G�ȋC���B�@�����悩�����낤�Ȃ��B

�ǂȂ����A�I�[�v�����ꂽ�f�o�C�X�̃t�@�C���f�B�X�N���v�^�ׂ���@������܂����狳���Ă��������Ȃ��ł��傤���B�T���Ă݂����ǂ킩��Ȃ��B�B

���P�P���P�S����

�������o���̋A��Ɉ���ł��Ă��܂��܂����B�r�[�����Ē������C���@�R�[�X�ł�����ƋC���������B

�A��ƁA���K��p�ɔ���������LAN�A�_�v�^�iIO�f�[�^��WN-G54/AM�j�����Ă��̂ő����ݒ�B�@���Ȃ������_�Ƃ̐ڑ����������܂����B

�O��̗��K��ł͂ނ��[���ɔ������R���K�̖���LAN�A�_�v�^�������čs�����̂����A���������ɑς����Ȃ������̂��A�ڑ�����ɐؒf�B�g�����ɂȂ�Ȃ������B���̃A�_�v�^�ł͂ǂ����H����A11b/g�p�Ȃ��ǁAAP�ɂ��Ȃ邵�A�L��-�����R���o�[�^�ɂ��Ȃ邵�A�ŁA�O�o�ɂ͂Ȃ��Ȃ��悳���ȃA�_�v�^�ł��B

����ŁA�݂�Ȃ̖����R���g���[���̗��̒��ł��ڑ��ł���Ό������ƂȂ��̂����A�A���āB

�E�E�E�E�E�E

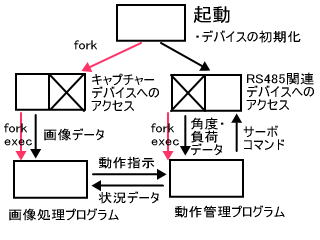

�o���̋A��͐��������Ă��̂����A�s���͐��������ĂȂ������̂ŁA�����_�̃v���O�����\���ȂǍl���Ă��܂����B���̐}���\���̊T���}�B

�܂��A�f�o�C�X�A�N�Z�X�v���O�������N���B�����RS485�֘A�A�L���v�`���[�f�o�C�X�֘A�̃A�N�Z�X���s���v���O�����B

���ꂪfork���āA�Б���RS485�A�N�Z�X�A�Б��̓L���v�`���[�f�o�C�X�A�N�Z�X���s���B��͓����v���O�����ŁA�Ⴄ�v���Z�X�B

���ɁA���ꂼ�ꂪfork���āA����Ǘ��v���O�����Ɖ摜�����v���O������exec����B

�����܂łłR�̃v���Z�X�ɕ�������B�e�v���Z�X�Ԃ͋��L�������[�ŒʐM���s���B

�����F���≹�������͉摜�����v���O��������Ăяo�����J�^�`�ɂȂ邩�Ǝv���B

�摜�����œ�������Ƃ���ɂ�锻�f����Ԕ�d�������̂ŁA�摜�����v���O������������̃��C���v���O�����ɂȂ邾�낤�B�����ARPU-100�̃L���v�`���[�͎��Ԃ�������悤�Ȃ̂ŁA�v�l���[�`���͍X�ɕʃv���Z�X�ɂ��������悢��������Ȃ��B������Ƃ��͍���̌����������B

����̃x�^�����v���O���������ׂ�Ɛ����ƕ��G�ȍ\���ɂȂ��Ă��܂��B�^�C�~���O�Ȃǂ̖����L�肻���Ȃ̂ŁA���߂ɂ��̌`�ɂ��ĊJ����i�߂������悢�̂ł͂Ȃ��낤���B

�܂��͐��`������ăg���b�L���O�A�v�������Ă݂�Ƃ��납�炾�낤���B����A���̑O�ɍ��̃v���O������CDT��ς�ŁAfork���ăv���Z�X�ԒʐM�������Ă݂�̂��悩�B

���P�P���P�T����

����̑����A���̃v���O������CDT��ς��fork���ăv���Z�X�ԒʐM�������Ă݂��B�����ɂł��āA�v���Z�X�ԒʐM������ɏo����B

�Ƃ��낪�A�����v���O������e�q�W�œ������ƁA�C���^�[�o���^�C�}�[���g�������荞�݃n���h���[�̓���Ɏx��𗈂����̂��B�Ȃ��A�L���v�`���[�S���̃v���Z�X��CPU�^�C��������Ă��܂��B�ǂ������킯�Ȃ낤�H

���荞�݃n���h���[��25ms�����ŁA�܂��E�F�C�g������Ă�10ms�`15ms���炢�ŏI����Ƃ����Ă���B���̒��ł�RS485�����Ă���̂�CPU���̂͑債����Ƃ͂��Ă��Ȃ��̂��B

�͂��߂̓L���v�`���[�R�}���h��CPU�^�C����D���Ă��܂��̂��Ǝv�������A�L���v�`���[�R�}���h���O���āA�J���f�[�^��CDT�����������Ă����荞�݃n���h���[�̓���s�S�͕ς��Ȃ��B

����fork������Aexecve���āA�Ⴄ�v���O�����ɕω������ăL���v�`���[�R�}���h��CDT�����������Ă݂��B����ƁA�킸���ɓ���s�S����������̂́A�قƂ�NJ��荞�݃n���h���[�ɂ͎x�Ⴊ�Ȃ��B�ǂ��������Ƃ��H

�m����execve����ƁA����ɃL���v�`���[�ł��Ȃ��Ȃ�̂Ŕ�r�ɂȂ邩�ǂ����͉������̂����ACDT���������ł��������Ȃ�fork�����^�C�v�Ƃ�CPU�����͕ς��Ȃ��͂��B

fork���������œ����v���O�����������Ă��邱�Ƃ�����ł���̂��H���ȏ���ǂ�ł��Afork����ƃ������[��Ԃ͕ʂɂȂ�Ə����Ă邵�A�v���Z�XID���������Ⴄ�B���荞�݃n���h���[�̐ݒ��fork��ɍs���Ă���̂ŁA�L���v�`���[�S�����͊��荞�ݓ���͍s���Ă��Ȃ��̂ɁB

���Ȃ݂ɈȑO�X�s�[�V�[�Y�����������T���v���v���O�����́i�����͂܂Ƃ��ȃG���W�j�A���Ή����Ă��ꂽ�j�A�C���^�[�o���^�C�}�[�͎g���Ă��炸�Awhile���[�v�ŏ������Ă����B���ԊǗ��͎��v���玞�Ԃ��擾���ĊǗ����Ă����B�Ȃ̂ŁA�}���`�v���Z�X�ł̏������O��B�����A�r�f�I�擾�͍s���Ă��炸�A���̏ɂ͂���܂�Q�l�ɂȂ�Ȃ��B

CPU�̕��דI�ɂ͗]�T������͂��Ȃ̂ŁA�Ȃ�Ƃ�����ŊJ�������B�ӂށ[�A�f�o�C�X�̖�肳���Еt���ΊȒP�Ȃ͂��Ȃ̂����B

���P�P���P�U����

����̑����Ō����𑱂���B

��������l�����錴�������Ă݂����S���n�Y���B

���s���Ē��ׂĂ����A�I�[�v�����Ă���f�o�C�X�̃t�@�C���f�B�X�N���v�^�ׂ���@���v�������̂Ŏ����Ă݂�B

�t�@�C�����ׂ��i�Ƃ��āAfstat( )�@�Ƃ������� stat( )�@�ƌ�����������Bfstat( ) �͈����Ƀt�@�C���f�B�X�N���v�^�����Astat( )�͈����Ƀp�X���܂ރt�@�C���������B�ŁA������g���A/dev/saa7113h0�Ƃ����f�o�C�X�̏����擾����B�t�@�C���f�B�X�N���v�^�͐��̐����Ȃ̂����A�g�p���Ă��Ȃ������Ȑ�����g�p���Ă����B�Ȃ̂ŁA�����Ȑ��̐��������Ԃɒ��ׂĂ����킩��͂��Bstat,fstat�œ�����t�@�C������struct stat�Ƃ����\���̂Ɏ��߂���̂����A���̒���st_rdev�Ƃ����v�f���f�o�C�XID���������ŁA�w�肵���t�@�C�����f�o�C�X�t�@�C���̏ꍇ�͂����ɗL���ȏ����͂����B

�t�@�C���f�B�X�N���v�^��0�`2�͕W�����́A�W���o�́A�W���G���[�o�͂Ȃ̂ŁA3�`10���炢�����Ԃɒ��ׂ�B����ƁA�f�o�C�X�̏������������i�K��3�̃t�@�C�����I�[�v������Ă���B��ԍŏ��i�܂�t�@�C���f�B�X�N���v�^3�j�͕W���I�ȃt�@�C���ŁA�����킩��Ȃ�����������������s�t�@�C���̂��Ƃ��H�����āA���̓�����ꂼ��RPU-100���L�̃f�o�C�X�ŁAsaa7113�ƁAbr_devmap0�Ƃ���mmap�f�o�C�X�炵���B

����ŁA�I�[�v�����Ă������f�o�C�X�̃t�@�C���f�B�X�N���v�^��m�邱�Ƃ��ł����B�����āA�N�������v���Z�X�ɂ�saa7113h0�f�o�C�X���N���[�Y���Afork����execve���A�摜�����p�v���O�������N���B������ł������悤�Ƀf�o�C�X�̏��������s���B

�����B�@����ł���Ɠ�̃v���O������RS485�֘A������saa7113�֘A�����i�摜�֘A�����j�s�ɓ��삳���邱�Ƃ��ł����B�@����ŁA���̌��ł̓X�s�[�V�[�Y�ƘA�����Ȃ��ōςށB

�ŁA���̃C���^�[�o���^�C�}�[�̕s�S�����A�ʂ̃v���O�����Ŏ��s����悤�ɂ�����A�����Ԍy�������B�X�ɁAbr_devmap0�f�o�C�X���N���[�Y������A�X�Ɍy�������B���́ubr_devmap0�v�Ƃ����̂͂Ȃɂ���邽�߂̂��̂��킩��Ȃ��̂����A���炭�̓L���v�`���[�`�b�v�̃�������Ԃ�CPU�̃�������ԂɃ}�b�s���O���邽�߂̃f�o�C�X�ł͂Ȃ��낤���Ǝv���B�L���v�`���[�f�o�C�X���g��Ȃ��v���Z�X�ł͕s�v�Ȃ̂ŃN���[�Y���Ă����v�Ȃ͂��B���v�ǂ��납�A�����]�v�Ȏd�������Ă����炵���B

�ŏ��A��������l�����錴���ł̒����̎��ɁA���荞�݃n���h���[�ɍX�Ɋ��荞�݂�������Ȃ��悤�ɃV�O�i��������NjL�����̂����A�V�O�i���������ĂƂĂ����Ԃ�������炵���B�����NjL���������ŁA���삪���������Ȃ��Ă��܂����B������폜���Ȃ��܂ܐF�X�����Ă������߁A�f�o�C�X�̃N���[�Y���ł����̂ɓ��삪�x���Ăт����肵�Ă��܂����B

���Ȃ݂Ɋ��荞�݃n���h���[�̋��ȏ��I�����ł̓n���h���[�̖`���Ŋ��荞�݂��X�ɂ�����Ȃ��悤�ɃV�O�i���������s���̂���{�B���������Ă��Ȃ��������܂ł̂��蔲���������̂����B�B�B�B

���������͂悭�Ȃ����̂����A�摜�����v���Z�X���̃��j�^�[�^�C�v��CDT�ɂ���ƁA���삪�s�S�ɂȂ�B����̓l�b�g���[�N������������̂������炵���B�o�b�t�@�T�C�Y��ύX�����肷��Ώ��ς�����肷��̂��ȁH

�Ȃ�Ƃ�����炵�������悤�ɂ͂Ȃ��Ă������A�V�O�i�������͂���قnjy�������ł͂Ȃ��A������̉e�����Ղ��炵���B�i���Ȃ��Ƃ�RPU-100�́B����Ƃ�PPC��NetBSD�����ȁH�j�X�s�[�V�[�Y�̃T���v���v���O�����̂悤�ȁA������RPU-100�ɂƂ��Ă͐������`�Ȃ̂�������Ȃ��B

��������CDT�ł̃g���b�L���O���o����悤�ɂȂ肻���ł��B

����E�E�E�E�E�E�E�E�E�E�E�E�E�E�E�E

��L�́A�J�����삳���Ȃ���A�T�[�{�����e�X�g���A�s�K�Ȏ��̂�����܂����B

�]�|�����Ƃ���ɂ��傤�ǃe�[�u���̑����B�@�s�K�ɂ��㓪�������ł��A�܂�Ă��܂��܂����B�`�`���B

�@�㓪�������Ł@�@

�@��������B�B�B

�ł��A���܂���Ƀq���[�Y�������āA�T�[�{�͉��܂���ł����B�����������e���������B���꒼���̂ɂ�CPU���j�b�g���O���Ȃ���Ȃ�Ȃ��B�B�B���ǂ��Ȃ���Ȃ��B�B

���P�P���P�V����

�{�i�I�Ƀg���b�L���O�̃f���쐬�Ɏ��|����B

�摜�������̃v���O������CDT�e�[�u���G�f�B�^�𗬗p�i�Ƃ������@�\��lj�����`�Łj����̂ŁA���j�^�[�A�v�����ɂ����������B�摜���j�^�[��ONOFF�{�^����A�g���b�L���O����CDT�`�����l���̎w��ȂǁB

�T�[�{���䑤�̃v���O�����Ƃ͋��L�������ŒʐM������B

���ꂱ��l���Ȃ����Ƃ����̂ŁA�i���͈��������̂����A�܂������Ƃ����������o�����B�ł��A�ǂ����n���`���O���傫���ē��������܂�Ȃ��B�悭����Ȃ����A�I�[�o�[�V���[�g���傫���̂Ōv�Z��̖ڕW���̈ʒu�p�x���ɂ��Ă݂����̂��܂��s���������B�v�Z���ǂ����ŊԈႦ�Ă���̂����B

�摜�擾�̔������x���x���āA������ƃn�e�i�Ȃ̂����A�A�C�{���͉�p���傫���A�ڕW�����������ɂ����B�y���������Ă݂����A�g���b�L���O�͂͂���Ȃ��B�����ˁB

�����A��������ɏ������A�l�b�g���[�N�ʐM���C���^�[�o���̎ז������Ă���Ƃ����̂͂ǂ������̂悤���B�摜�f�[�^�̓]�����~�߂āACDT�������s���Ƃ����Ƃ�����s�S�������ɂȂ����B�摜���擾�������CDT�������[�v�ɓ���Ɗ��荞�݃n���h���[�ɏ������ڂ�ɂ����悤���B������ă}���`�v���Z�X�Ȃ̂ɂȂɂ��l���Ȃ���Ȃ�Ȃ��̂��Ȃ��H�^��B

�f������̓���ł��B��

����͐F���W�����Ă�������������Ă��邾���ŁA�m�\���x�Ō����Β����x�B�@�u���m�v���F�����Ă��Ȃ��̂ł���ȏ�̎v�l���������o���Ȃ��B

�ŏI�I�ɂ�CDT�ł͂Ȃ��A���̂̔F���i���̂ł��邩�ǂ����͐F�W���Ŕ��f����͓̂����Ȃ̂����A�F�̕��z�ł͂Ȃ��A�W���Ŕ��f����j�����āA���ꂪ�u�����v��F�����������Ȃ̂œ���\���Ȃ������邱�Ƃ��o����i�\��������j�B����ɂ͒��L�p�摜���g������Ȃ̂Ō�����Ȃ��悤�ɖڂŒǂ��K�v�����Ȃ��Ȃ�B

�Ȃɂ͂Ƃ�����A�}���`�v���Z�X�Ή��ɂ��Ȃ���Ȃ��B

�E�E�E�E�E�E�E�E�E�E

�摜�����v���O�����̃��[�v�ɁA�K�x�� usleep(0) ����܂����琏���ƃ}�V�ɂȂ�܂����B�{�[�����Ȃ��畁�ʂɁi�����_���x���̈���x�ŁA�����ǁ@(^_^;)�@�j������B

����Ȃ�{�[���ɋ߂Â��Ă������Ƃ��ł��������B���͂��ꂩ�ȁ[�B�����j�b�g�̎p���Ɖ�ʏ�̏d�S�i�ړI���̈ʒu�j���畨�̂̕������v�Z�ł���悤�ɂ��Ȃ��ƁB

�C���^�[�o���^�C�}�[�ɂ��莞���荞�݂ł̃V�X�e�����X�s�[�V�[�Y���̎��ԊǗ��̃V�X�e���ɍ�蒼���̂͂�����Ƒ�ρB���̏�A���ʂ��킩��Ȃ��̂ň�C�ɐ�ւ���Ƃ����͖̂��d�B�e�X�g�v���O����������Ă݂āA���ʂ�����̂Ȃ��ւ�������Ō���������Ċ������ȁB

�ǂ����ɂ��Ă����[�v�����v���O�����ɂ̓v���Z�X��ւ��̃^�C�~���O��^����悤�Ȕz�����K�v�Ȃ͕̂ς��Ȃ����낤�B

���P�P���P�W����

�֓��g���K��s���ė��܂����B

��������_�͎��R�ɕ����Ȃ��̂ŗ��K�͂ł��Ȃ����ǁA����̓g���b�L���O�f�����o�����̂Ō��Ă��炦��l�^������B�݂�ȂɌ��Ă��炦�Ă悩�����B�T�ˍD�]�B���ɂR���R�x����������A���������������Ă̂̓o�g���n���{�b�g�ɂ͗L�蓾�Ȃ��̂ŐV�N�����������B�l�̓A�C�{���烍�{�b�g�ɓ����Ă�̂ł��̌`�����R�ł����B

�摜�����v���O������usleep()���ꂽ�肵����A���s�͂قږ��Ȃ��ɂȂ��Ă����悤���B�l�`��������Ƀv���Z�X���s�̃v���C�I���e�B�����̃R�}���h�������Ă���������炻���������Ǝ����Ă݂悤�B���܂��s���A���̂܂��̍�Ƃɐi�߂����Ȃ̂ł��肪�����B

�������ɗ��K���ł̓v���O���~���O�͂ł��Ȃ��̂ŁA�g���b�L���O�̒����Ȃ�����Ă܂����B���L�p�ɂ��Ẵg���b�L���O�����\�g����B���L�p�Œ��������g���b�L���O�̃p�����[�^���Y�[���Ŏg���ƃn���`���O�N�����Ă��܂����Ă̂��������B���̕ӂ�A�摜���[�h�ƘA�g�����Ȃ���Ȃ�Ȃ��炵���B

�������ŋg�c����Ƀz�[�U���̈����H��������Ă��炢�܂����B����̓C�C�B�R�l�N�^�̃R���^�N�g�̂͂t�������Ȃ��čςނ悤�ɂȂ邩���B���������Ă�Ƃ�����������Ē������܂����B

���ƁA������{�b�g���[�U�[�R�c����̍�������B�c��Ȑ��̃h�g�[���̃��b�t�������B�������イ�������܂����B���肪�Ƃ��������܂����R�c����B���̉摜�̓��b�t���ƃo�[���N�[�w���̈ꕔ�ł��B

�ΐ삳���SD���C�Y�i�[�̓��{�r�����[�h�������Ă܂����B

�V���ȖڕW�Ƃ��āA�����Ń��{�r�����[�h������������Ă̂��o�����B�ԍ��ǂނ͓̂�����ǁA�F�������ꂽ�猋�\�ł��邩������Ȃ��B�����A�����O�A�E�g����肾�B�����O�̂ӂ����������Ȃ��Ƃ����Ȃ��B���̂����肪���B

�Q�[������点��̂͂������ǁA���[�����v���O�������Ȃ���Ȃ�Ȃ��B�����́A�����_�Ƀ��[���������ĕ������Ď��s��������Ă̂��ł���悤�ɂ������ȁB���{�r�����[�h�ł�������͓̂���������ǁA�p�C����������ċA���Ă�����Ă����ʂ̋��Z�������炻��i���[���������ĕ�������j�ɒ��킵�����Ȃ��ȁ`�B

�@�X�P�[��������B�B�B�B�@����ϊO�������Ȃ��B�ł��O��700g�͏d�߂��B�����_���ƕ����Ȃ��Ȃ��Ă��܂��B

�A��̓C�K�A����Ƀ��[�V�����̍����̘b��ŋ߂̃��{����i3�_�h����Ă̂��ȁH�j�̘b���Ȃ���A���Ă��܂����B�Ɍ��܂œ˂��l�߂ă��[�V��������Ă�̂ŐF�X���߂ɂȂ�b���܂����B

���ɗ��K��ɎQ������Ƃ��ɂ͂܂��i�������Ă��������ł��ˁB�Ƃ肠�����o�b�e���[�ς�ŊO�����Ă��Ċ������H

���P�P���P�X����

����̗��K��ŗ[�����댩�w�ɗ����������炵���̂ł����A�����_�̎ʐ^���������B���Ă�������胉���_�̐����������肵�܂����B

�ŁA�ǂ���炻�̕����u�уz�r�[�H�쌤�����v�̗т������悤�ŁA�����_�̉摜���ڂ��Ă��������Ă܂��B�ł����`�A�u�V�O�}�v�ɂȂ��Ă܂��ˁB(^_^;)�@�M���V�������́u�����_�v�ł��A���Č�������ł����B�B�B�@�V�O�}���Ɠ������ĂS�{�����s�ɂ��Ȃ��ƁB�B�B�@�ł��ASD�o�����[�i���͂܂����ȁB�@�@�@�т��Ƃ킩���Ă���ΐF�X�Ƌ����Ă��炢�������Ƃ��L�����̂ł����`�B

�u�v�����������g���v�ɂ��o�ꂳ���Ă��炢�܂��āA���肪�Ƃ��������܂��B�@����HP�ɍڂ��Ă����������̂͏��߂Ăł��ˁ`�B���ꂵ���ł��B

�u�������{�b�g�������v�ɂ��o�ꂵ�Ă�IB�삳�肪�Ƃ��������܂��BCDT���Ă̂͐F�����Ă邾���Ȃ̂ŁA�����̃J�^�`�͊W����܂���B�����S���B

�E�E�E�E�E�E�E�E�E�E�E

�{�[����ڂŒǂ����������Ă������B�������킯�ł͂Ȃ��̂͂������B���낻��ڂŌ��ĕ����o�����Ȃ��Ƃ��܂ł����Ă��Ƃ藧�����Ȃ��B�Ƃ藧������ɂ���l�ŗ����オ��Ȃ��Ǝn�܂�Ȃ��̂ŁA�܂��߂ɋN���オ�蓮����ǂ�����č\�z���邩�l���˂i�����A���[�V�����Đ��ŗ����オ�点�����͎����Ă�j

�l���Ă���̂́A��{�I�Ɏp�����������ɕ��ނ��āA����̎p�����ǂ̕��ނɓ��邩�f���A���̎p�����痧���オ����s���Ƃ������Ƃ������悤���ƍl���Ă���B

�Ⴆ�Γ]�т����ɂȂ��Ď�𒅂����Ƃ��āA���̎p�������x�Q�]��ŗ����オ��̂ł͂Ȃ��A���̎p������ŒZ�̃��[�V�����ŗ����オ��悤�ɂ���B

�Ƃ肠�����A���܂����l��������Ȃ��Ƃ���点�Ă݂悤�Ǝv���܂��B

�@�Q�]�я�ԁ@�@

�@������

�@��𒅂��ė����Ă����ԁ@�@

�@����ł������Ă�����

�@��𒅂��ė����Ă����ԇA

�@�����D�ɂȂ�����ԁD�D�D

���͎�𒅂��ė����Ă����ԁi�����ʁj���痧���Ă����Ԃւ̈ڍs���[�V�������ǂ�����Đ��������邩�A�f�X�B

���P�P���Q�O����

����A�J���������A�b�v���ĕ��C�ɓ����āA�ŁA�v���Ƃ��날���Ă܂�PC�Ɍ������܂����B

�����āA�u�U���S���w���K�u�`200X�v���X�V����Ă���̂����܂����B�Ȃ�Ɖ摜�S�J�b�g���g���ďЉ�Ă�����Ă��܂��B���肪�Ƃ��������܂��B<(_ _)>�@�U������Ɏ��グ�Ă�����āA�Ȃ��A�ЂƂڕW��B�������悤�ȋC���ł��B(^�E^)

�ł��A�ΐ삳�����Ă�����悤�ɂ�����ăA�C�{������Ă邱�ƂȂ�ł��B�����āA�A�C�{�̕��������Ƃ��������ƃs���N�{�[���ɂ��Ă����ł��ˁB�܂��܂����Ȃ����Ďv���Ă���̂��z���g�̂Ƃ��낾���A�{���ɂ�肽�����Ƃ͐F��F�����邱�Ƃ���Ȃ��ă��m��F�����邱�ƁB�@�@��������̐l�ɒ��ڂ��Ă�����āA�u�����Ɛ��i���˂v�Ɖ��߂Ďv���܂����B�@�ł��A�A�C�{���{�[����ǂ������Ă���A�����_���i�l�^���{�b�g���j����Ă�ƂȂ�������Ɛe�ߊ�������悤�ȋC�����܂����B�Ȃ�Ă������A�l�^�ł��邱�ƂŐl�ɋ߂Â��Ă���Ă͖̂{���ɂ���Ȃ��Ďv����������܂����B

�E�E�E�E�E�E�E�E�E�E�E�E�E�E�E�E

����̑����ŁA�A�A�Ƃ藧������ɂ͓d���P�[�u�����ז��ł��B�Ȃ̂Ńo�b�e���[���ڂ��l���Ȃ���Ȃ�Ȃ��B

�o�b�e���[���������������Ȃ��ǁA�����_�̏ꍇ�̓o�b�e���[�������Ԃ��������ԂƂ����킯�ɍs���Ȃ��B

�����s���̌��ʂł���w�K�f�[�^���������������Ă��܂��Ă͊w�K�̂��悤�������B�����ŁA�d����ؒf���邱�ƂȂ��o�b�e���[���ւ���A�܂��͓d����ؒf���邱�ƂȂ����艻�d�������ɐ�ւ���i�܂��͂��̋t�j�Ƃ������Ƃ��ł���K�v������B�X�ɂ́A�o�b�e���[�̉ߕ��d��h�����߁A������x�̓d���̒ቺ�����m���ēd���̃V���b�g�_�E���i��ւ����܂ށj���o���Ȃ���Ȃ�Ȃ��B

�܂�d���̓�d�����������Ȃ���Ȃ�Ȃ��킯�Ȃ��ǁA���ꂪ���\��ςŁA���艻�d���̓�d���Ȃ�o�����V���O���s���Ƃ������Ƃ��l�����邪�A�o�b�e���[�ł͏o�͓d���̔��������ł��Ȃ��̂ł���������B

�d���̈Ⴄ�i�����ɈႤ�j�o�b�e���[�̏o�͂����ڑ�����Ɠd�����Ⴂ���̃o�b�e���[�ɓd�������ꍞ��ł��܂����߁A��d��������鎖�ɂȂ肩�˂Ȃ��B�@�����h�~���邽�߂ɂ̓_�C�I�[�h�I�A���g���̂��ȒP�����A�_�C�I�[�h�ł̓d���~���Ɣ��M���C���Ȃ̂ł��̑I���͖����B

�̗p���l���Ă���̂�FET�ŃX�C�b�`���\�����A�}�C�R���Ő�����s���Ƃ����\���B����̗��K��ŋg�c����̘b���Ă��Ƃ��͂Ӂ[��B�B���Ċ������������ǁA�o�b�e���[�悹�Ȃ�����čl�������ɁA�u���ꂾ�ȁv�Ǝv���܂����B���ꂾ�Ɩ����I�ɐ�ւ����邵�A�_�C�I�[�h���͓d���~�������Ȃ��B

������FET��OFF�ɂ���Γd���X�C�b�`�I�t���\�B���ӓ_�Ƃ��Ă͐�ւ����ɏu�f����댯������̂ŃX�[�p�[�L���p�V�^�[���K�v���B

�����A�����͓d����H�����̂悤�ȍ\���őg���Ƃ������̂Ń`�����{��ƍň����[�h���ɂȂ������m�����ׂĉ��Ă��܂���S�����l������B��[�������Ȃ��ƁB�B(-_-;)

�uFET�X�C�b�`�v�ŃO�O��ƃG�A�K���̐��E�ɓ������Ⴄ��ł��ˁB�ӊO�B���������̓��[�^�[�h���C�u��H�̕����Q�l�ɂȂ�܂��B���[�^�[�h���C�u��H����A�����X�C�b�`���O�Ɋ֘A����l�����Ȃ��邩�Ȃ����ĂƂ��ł��ˁB

���g�c���u�f���ĕs���肾���Č����Ă����܂������A����̓n�C�T�C�h�̃X�C�b�`��H��N�`�����l��FET���g���Ă邩��ł͂Ȃ��ł��傤���H�n�C�T�C�h��H��N�`�����l��FET���g����S�|G�d�����s����ɂȂ邽�߁A���삪�s����ɂȂ邻���ł��B�n�C�T�C�h�Ȃ�P�`�����l�����g���ׂ��炵���ł��B

���P�P���Q�P����

�ǂȂ����̂g�o��301CR��CAD�f�[�^�����[�J�[�����������Ƃ����b��ǂ݁A�����ɂ����炦�Ȃ����o�t�d�q�ɂ��肢���Ă݂邱�Ƃɂ��܂����B

�Ƃ����̂��A�����j�b�g�̃T�[�{�z�[���̐��@���悭�킩��Ȃ��̂ł��B������CAD�f�[�^������Ă���̂����A����Ă݂�ƌ�������Ȃ��B�d���Ȃ��̂Ō����L���Ď��t���Ă���̂����A���A�ŗV�т������A���܂肢���o���Ƃ͌����Ȃ��B

�@�@�������CAD�f�[�^�B�@���̃T�[�{�z�[���̌��ʒu�͉�3���B�L���̂������@�ɂ��ė~���������ȁ[�B���������ăC���`�H

�E�E�E�E�E�E�E�E�E�E

�����_�Ɏ����Ń��{�r�����[�h���N���A�����邽�߂̊�{�@�\��g�ݍ���ł����B

�����͊ȒP�ɂ��̏�ł̕����ϊ�����s���[�`���ɏ���������B�����_�͒��i�E�J�[�u���s�͂ł���̂����A���̏�ł̐���≡�����͂܂��ł��Ȃ��̂��B

�R�[�f�B���O�͂����ɏI������̂����A�ǂ����o�O������B1���ڂ��v���悤�ɂłȂ��̂��B���������Ȃ��B

������s�����������Ƀ����_�����x�������������̂����A���T�[�{�̃q���[�Y���r�V�r�V�Ƃ�ł��܂����B���܁A�����_�̓������͂����������������炮��ł��B�ł��A���̂܂�܂Œ����ĂȂ��B���������ACAD�f�[�^�����炦���̂ł�����Ƃ������@�̕��i������Ă���Ɏ��ւ��鎞�Ƀl�W���������܂��傤�B

���~�b�^�[�q���[�Y�͂����Ƌ@�\���āA�T�[�{�����Ȃ��悤�ɓ����Ă���̂����A������ƃv���l�W��т������Ċ������ȁB2�{����3�{�ɑ��₵�Ă݂悤���ȁB

����̗��K��ŋ����Ă�����������H��͂����̂ő���������������Ă݂邱�ƂɁB

�@�@

�E�̉摜�̍����������y���`�ŋȂ��Ă͂t���������́A�E�������H��ł����߂����́B

�X�g���C�������[�t���������܂��������A�����ߕ����͂��������B����ł͂t�����Ȃ��čςށB�@�����߂͐�p�H��ł��Ȃ���Ȃ�Ȃ��Ǝv���Ă����̂ł��ꂵ�[�B

����ɂ��Ă��A�g�тłƂ����摜���Ⴑ�ꂪ���E���ȁB�̂ɔ�ׂ���Y��ɂȂ����ȁ[�B

�E�E�E�E�E�E�E�E�E�E

�����_�̂��̏�ł̕����ϊ��͖����o�O�����܂����B�����_�̕��s�v���O�����̓e�X�g�v���O�������������č��̌`�ɂȂ����̂�����ǁA���̖��c�̕����ł������Ȃ��ƂɂȂ��Ă܂����B���̕ӂ�����Ĉꉞ�����B

�܂��A�����n�߂̎p���ɂ���Ă͈���ڂ����Ԃ݂ɂȂ��Ă��܂����肷�邩��蒼�����K�v�����ǁA����͂����Ȃɂ��ǂ��Ȃ��Ă��邩���킩���Ă��邩�璼�������B

������O��������Ȃ����ǁA�O�i�E��ށE���̏����̂��ꂼ��ň��肵���p�����Ă̂��Ⴄ�B���z�I�ɂ͎p���ɊW�Ȃ����s�ł���ׂ��Ȃ��ǁA������Ɩ����B

���ꂼ��ň��肵�Ă���p�����`���C�X���ĕ��s���[�h�ɂ��킹�ăZ�b�g����悤�ɂ��Ȃ���Ȃ�Ȃ��B���[�h���ς���Ă������ڂ͂��̎p���ڍs���s��Ȃ���Ȃ�Ȃ��킯���B

���́`�A�����ȁH�����オ�����肽���悤�ȋC���ł͂���̂����A���s���Z�b�g�����ĐF�Ɍ������ĕ����Ă������Ă̂�����Ă݂邩�H

�A�N�V�����A�C�e�����j���[�������ł̃��{�r�����[�h�����ւ̓���

���@���̏����

���@���s�Z�b�g��

���@���������̎g

���@�����オ��

���@�g���b�L���O���s

���@�F���낢��F���e�[�u���쐬���A���F���̔c��

���@���R�b�v�������グ��Ƃ��͂炤�Ƃ�����Ƃ�

���@�ǂ̃R�b�v���ǂ��ɂ��邩��̔c�����铪�]

���@�K�x�ȃ^�C�~���O�ł܂���

���@�o�b�e���[����

�r�����[�h���̂Ɂu�T�����[�}��������v�����Ȃ���Ȃ�Ȃ��̂��H�ƈ�u�i�ق�̈�u�ˁj�v�������Ⴄ�ȁB�ǂ̔ԍ����ǂ̍��W�ɂ���Ƃ����̂��o���Ă����ŒZ�����̈ړ����ł���B�@���A�ł��A�����̋O�����Ɠ|�����Ⴂ���Ȃ��R�b�v��|���Ă��܂������Q��������K�v���B

���@��Q������i�܂��̓��[�g�����j

���R�b�v�̔ԍ��̔F���́A�܂��͐F�ŁBCDT��8�`�����l�����邩��8�F�܂ŐF���������邱�Ƃ��\�B�����A�߂��F�i�Ԃƃs���N�Ȃǁj�͋�ʂ����ɂ����B��������ƂR���F�{�����炢�Ȃ̂ł��̐F�̑g�ݍ��킹�ŔF������̂��ȒP�B�@�Ⴆ���{�J�b�v�̃R�[�i�[�|�X�g�͂����Ȃ��Ă�B�@